この記事を読むと、AIの思考の進化と、それがもたらす科学的発見の最前線がわかり、未来の技術戦略立案に役立てられるようになります。

執筆者からひと言

こんにちは。30年以上にわたるITエンジニアとしての現場経験を基に、AIのような複雑なテーマについて「正確な情報を、誰にでも分かりやすく」解説することを信条としています。この記事が、皆さまのビジネスや学習における「次の一歩」のヒントになれば幸いです。

第1章 思考の基盤を再定義する

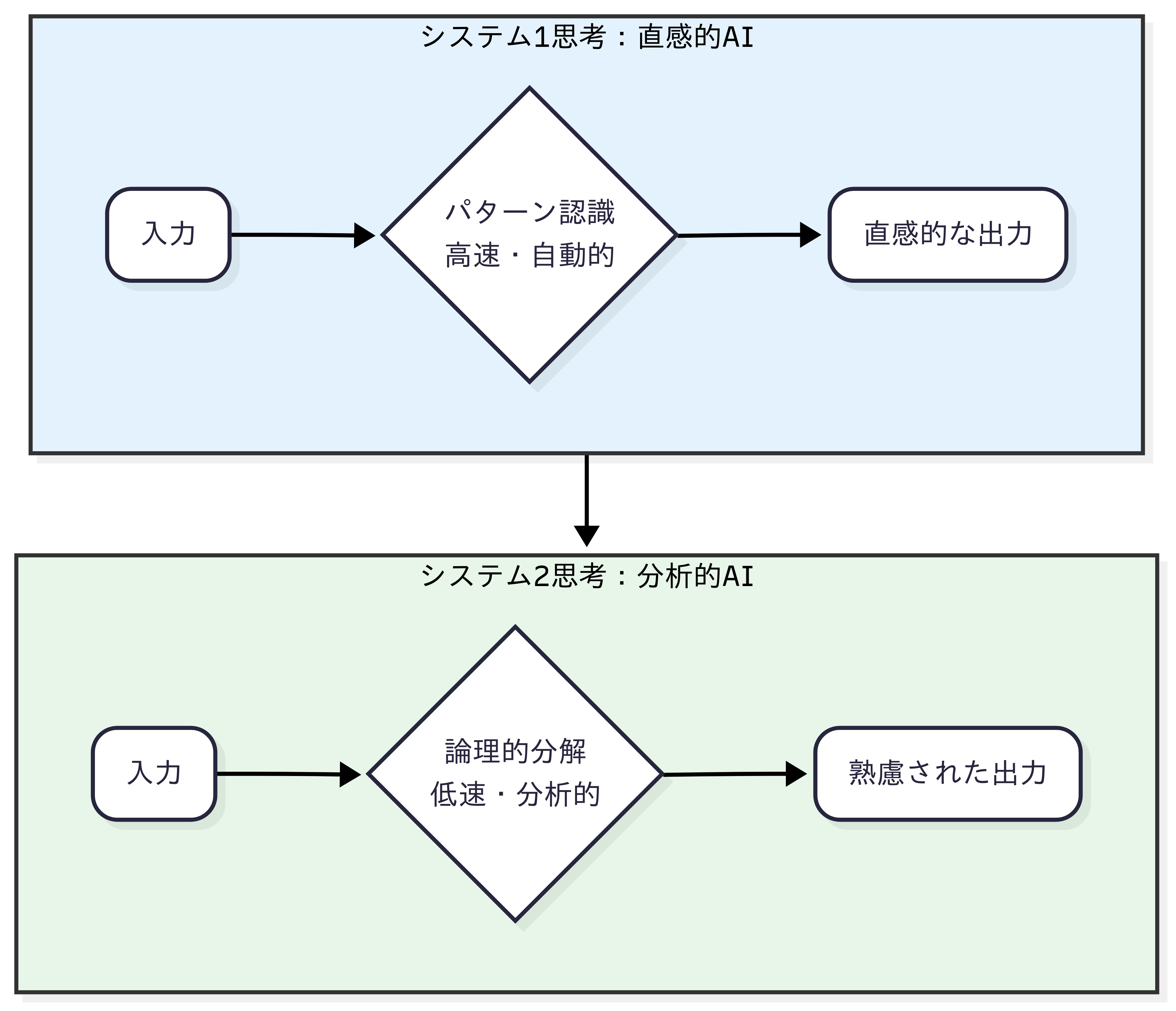

AIの思考様式が、従来の直感的・高速な「システム1」から、人間のように分析的・慎重な「システム2」へと質的に進化している現状を解説します。この変化が、AIを真のパートナーへと変貌させる原動力です。

AIの知性を語る上で、私たちは今、決定的な分岐点に立っています。その核心を理解する鍵が「Deep Research(知識の探索深度)」と「Reasoning(論理の構築能力)」という二つの力です。

- Deep Researchとは、単に情報を検索するのではなく、膨大な知識空間から、目的に応じて意味のある「点と点」を見つけ出す力です。これは、思考の「素材」そのものの質を決定します。

- Reasoningとは、その点と点を結びつけ、誰も見たことのない「線」や「構造」を論理的に編み上げる力です。これは、素材から革新的な価値を創造する「設計図」に他なりません。

これまでのAIは前者に偏っていましたが、今まさに後者の能力で革命が起きているのです。

✍️ かみ砕き解説:システム1・2とは?

この理論は、ノーベル経済学賞を受賞した心理学者ダニエル・カーネマンが提唱した思考モデルです。彼の世界的ベストセラー『ファスト&スロー』で有名になりました。人間の思考には、

●直感的で速い「システム1」と、

●じっくり論理的に考える「システム2」

の2種類があるという考え方で、行動経済学の基礎を築きました。AIの思考様式を人間と比較する上で、最適なものさしとして広く使われています。

AIの思考様式に起きている質的変化:

「システム1」から「システム2」へ

これまで広く普及してきた大規模言語モデル(LLM)は、その思考プロセスが人間の認知科学における「システム1」思考に類似しています(System 2 Survey)。

システム1とは、認知心理学者ダニエル・カーネマンが提唱した概念で、私たちが日常的に行う、高速で直感的、自動的な思考プロセスを指します。従来のLLMは、膨大なデータから学習したパターンに基づき、瞬時に応答を生成することに長けていますが、その速さと引き換えに、複雑で多段階の論理を要する課題では誤りを犯しやすいという側面も持っていました(Efficient Reasoning)。

今、AIの最前線で起きているのは、この直感的な思考から、より慎重で分析的な「システム2」思考への劇的な移行です(System 2 Survey)。

システム2は、低速で、意図的、そして論理的な思考プロセスであり、人間が難問に取り組む際に用いるものです。

この質的飛躍を体現するのが、「大規模推論モデル(Large Reasoning Models, LRM)」と呼ばれる新世代のAIです(System 2 Survey)。OpenAIの「o1」やDeepSeekの「R1」といったモデルがその代表例で、これらは最終的な回答を出す前に、中間的な思考のステップを明示的に生成することで、人間のような熟慮を模倣します(Efficient Reasoning)。

この「システム1」から「システム2」への進化こそが、AIを単なる情報処理ツールから、次章以降で詳述する「創造するパートナー」へと変貌させる、最も重要な原動力なのです。

| 属性 | 従来のLLM (システム1相当) |

大規模推論モデル(LRM) (システム2相当) |

|---|---|---|

| 認知アナロジー | 速く、直感的、パターン認識ベース | 遅く、慎重、分析的 |

| 思考プロセス | 線形的、一方向 | 探索的、自己評価と後戻りが可能 |

| 得意な領域 | コンテンツ生成、要約、チャット | 科学的発見、高度なコーディング、 複雑な計画立案 |

| 主な制約 | 推論エラー、ハルシネーション(幻覚) | 高い計算コスト、冗長な出力 |

Key Takeaways(持ち帰りポイント)

- AIの思考は、人間の直感に近い「システム1」から、熟慮に近い「システム2」へと進化しています。

- この進化を担うのが「大規模推論モデル(LRM)」であり、複雑な問題解決能力が飛躍的に向上しています。

- この質的変化が、AIを単なるツールから、科学的発見を担うパートナーへと変える基盤です。

第2章 論理の深化 – AIはいかにして「考える」ようになったか

AIが「熟慮」する能力をいかに獲得したか、その中核技術である「思考の木(ToT)」と「自己省察」のメカニズムを解説します。これによりAIは、より複雑で信頼性の高い推論が可能になりました。

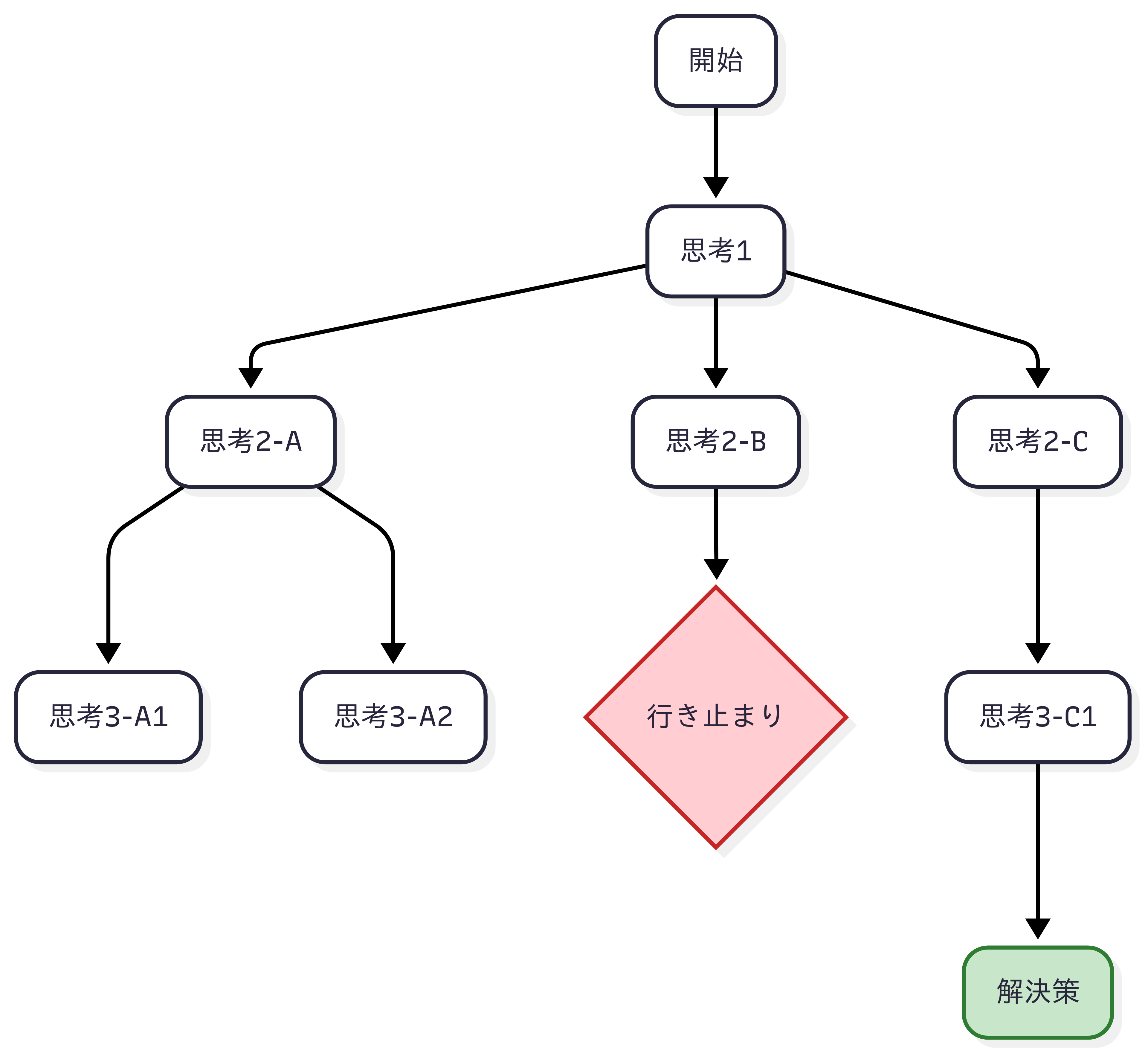

AIがシステム2のような熟慮能力を獲得した背景には、その思考メカニズム自体の劇的な進化があります。AIはもはや、一本の思考経路をたどるだけでなく、複数の可能性を探求し、自らの思考を評価・修正する能力を手に入れ始めています。これは、AIが単なる「計算」から、真の「思考」へと移行していることを示すものです。

思考の連鎖から思考の木へ

AIに複雑な問題を解かせる初期のブレークスルーは、「思考の連鎖(Chain-of-Thought, CoT)」という技術によってもたらされました。これは、AIに「ステップ・バイ・ステップで考えよう」と促すことで、結論に至るまでの中間的な思考プロセスを文章として生成させ、正答率を向上させる手法です。

しかし、CoTには本質的な限界がありました。それは、思考が線形的であるため、一度初期のステップで間違いを犯すと、その後の推論全体が誤った方向に進んでしまうという点です。人間であれば「待てよ、この前提は間違っているかもしれない」と立ち止まり、別の考え方を試すことができますが、CoTにはそれが困難でした。

👨🏫 かみ砕きポイント

「思考の木(ToT)」は、将棋のプロ棋士が「次の⼀手」を考える思考プロセスに似ています。一本の筋(CoT)だけを読むのではなく、「この手を指したら、相手はこう来るかもしれない。いや、こちらの可能性もある…」と、複数の未来を同時に予測・評価します。そして、最も有望な枝を伸ばしていくのです。ToTはこの「もしも」の思考をAIに与え、より賢明な判断を可能にしました。

この限界を克服するために登場したのが、「思考の木(Tree-of-Thoughts, ToT)」という、より洗練されたフレームワークです(ToT論文)。ToTは、問題解決のプロセスを、一本の鎖ではなく、枝分かれする「木」として捉えます。

- 分解: まず、問題を複数の思考ステップに分解します。

- 生成: 各ステップ(木のノード)で、AIは一つの思考経路だけでなく、複数の可能性のある次のステップ(枝)を同時に生成します。

- 評価: それぞれの思考の枝がどれほど有望かを、AI自身が評価します。「このアプローチは行き詰まりそうだ」「このアイデアは斬新だ」といった判断を下すのです。

- 探索: 評価に基づき、最も有望な枝を選択して思考を先に進めます。もしある経路が行き詰まった場合は、以前のノードに「後戻り(バックトラック)」し、別の有望な枝を探索することができます(ToT論文)。

このToTのアプローチは、人間が難問に取り組む際に、複数の選択肢を比較検討し、試行錯誤しながら戦略的に思考を進めるプロセスを、機械的に再現するものです。

ただし、Tree-of-Thoughtsは複数の選択肢を比較しながら探索することでChain-of-Thoughtの限界を克服しますが、まだ研究段階であり、計算負荷や適用範囲など課題も残ります。実用化には探索戦略や評価関数のチューニングが必要とされています。

自己省察:自らの誤りを正す能力

ToTが思考の「幅」を広げる技術だとすれば、思考の「深さ」を増すのが「自己省察(Self-reflection)」です(AIの自己修正(セルフリフレクション)論文)。

これは、AIが一度生成した答えや推論過程を、もう一度自分自身で批判的に見直し、誤りを修正させるプロセスです。

例えば、「この論理に飛躍はないか?」「もっと説得力のある説明は可能か?」といった内省的な問いかけをAIに投げかけることで、AIは自らの出力の質を向上させることができます。

研究によれば、この自己修正のプロセスを繰り返すことは、単に正答率を高めるだけでなく、AIが学習データから受け継いだ偏見(バイアス)を特定・軽減し、より安全で公平な応答を生成することにも貢献することが示されています(AIの自己修正(セルフリフレクション)論文)。

ToTによる探索的な思考と、自己省察による内省的な思考。この二つが組み合わさることで、AIの論理的能力は飛躍的に向上し、次章で紹介する「AIイノベーター」としての役割を果たすための認知的な基盤が築かれたのです。

Key Takeaways(持ち帰りポイント)

- AIは「思考の木(ToT)」により、一本道の思考から脱却し、複数の可能性を比較検討できるようになりました。

- 「自己省察」の能力は、AIが自らの回答を批判的に見直し、精度と信頼性を自律的に向上させることを可能にします。

- これらの技術の組み合わせが、AIの推論能力を人間らしい「熟慮」のレベルへと引き上げています。

第3章 創造するパートナー – AIイノベーターの実像

(経営戦略・技術企画担当者向け)

高度な推論能力を手にしたAIが、創薬や材料科学の分野で「AIイノベーター」として活躍する具体的な事例を紹介します。AlphaFold3やGNoMEなどのプロジェクトが、科学的発見をどう加速させているかがわかります。

高度な推論能力を手にしたAIは、もはや私たちが知る「道具」のカテゴリーには収まりません。人間に与えられた問題を解く従順な「問題解決者(Problem Solver)」の時代は終わりを告げました。

今、私たちの目の前に現れたのは、人間と共に新たな問いを立て、仮説を生成し、検証サイクルを自律的に回す「発見のエンジン(Discovery Engine)」です。

この、科学的探求のパートナーとも呼ぶべき新しい存在を、私たちは「AIイノベーター」と定義します。

AIイノベーターは、理論上の存在ではありません。すでに生命科学や材料科学といった基礎研究の最前線で、イノベーションの常識を塗り替える具体的な成果を出し始めています。

創薬革命の最前線:デジタル速度で生命を解読する

医薬品開発は、従来、莫大な時間とコスト、そして10%程度という低い成功確率に悩まされてきました(Isomorphicの挑戦)。しかし、AIが分子レベルでの生命現象の解読を支援し、新たな治療薬の設計に貢献する能力を獲得したことで、この長年の課題にブレークスルーが生まれつつあります。

【AI創薬】Isomorphic LabsとAlphaFold3:AI創薬支援が臨床試験へ

この革命の中心にいるのが、Google DeepMindからスピンオフしたIsomorphic Labs(アイソモーフィック・ラボ)です。

彼らが開発したAIモデル「AlphaFold」は、タンパク質の立体構造予測に革命をもたらしました。その最新版であるAlphaFold3は、単一のタンパク質だけでなく、病気に関連するタンパク質と薬候補(リガンド)の相互作用構造を高精度で予測できます(AlphaFold3論文)。

ただし、AlphaFold3単体は薬の候補分子そのものを設計する機能ではなく、創薬プロセスの構造解析・支援に非常に重要な役割を果たしています。

Isomorphic Labsはこの技術を武器に、製薬大手のイーライリリー社やノバルティス社と戦略的提携を締結。

2024年の発表によると、Isomorphic Labsはイーライリリー社とノバルティス社の2件合計で最大約30億ドル規模の戦略的提携を締結しています(製薬大手との提携)。

最も重要な進展は、AIによる計算上の予測が、現実の治療薬へと結実しつつあることです。Isomorphic LabsはAIによって設計された医薬品候補の臨床試験段階への進展を目指しており、CEOのデミス・ハサビス氏は、AI設計薬剤が2025年末までに臨床試験へ進むことを目指していると述べています(Isomorphicの挑戦)。

XtalPi:AIとロボットが融合する創薬プラットフォーム

もう一つの注目すべきAIイノベーターがXtalPi(クリスタルパイ)です。

同社は、量子物理学に基づく計算、AIによる予測、そしてロボットによる実験の自動化という三つの要素を緊密に統合した独自のプラットフォームを構築しています(XtalPiとPfizer)。

AIがデジタル空間で有望な分子を設計し、その設計図を基にロボットが物理空間で自動的に合成・実験を行う。その実験結果をAIが即座に学習し、次の設計をさらに洗練させる。このサイクルを高速で回すことで、創薬のプロセスを劇的に加速させています。

XtalPiもまた、ファイザー社やイーライリリー社といった大手製薬企業と提携しており(XtalPiとPfizer)、AIとロボティクスの融合が創薬の新たな標準になりつつあることを示しています。

材料科学のパラダイムシフト:未来の物質を設計する

AIイノベーターの影響力は、生命科学にとどまりません。

より高効率なバッテリー、次世代半導体、環境負荷の低い新素材など、現代社会が直面する多くの課題は、革新的な材料の発見にかかっています。

この分野においても、AIは発見と設計のプロセスを根本から変えつつあります。

【AI材料開発】Google GNoME:人類の知識を数週間で超える

Google DeepMindのプロジェクトGNoME(ノーム)は、AIによる網羅的な「発見」のスケールを象徴しています。GNoMEは、深層学習を用いて、理論的に安定して存在しうる未知の無機結晶構造の探索を大規模に実施しました。

その結果は驚異的で、220万種の新たな結晶構造を予測し、そのうち38万種以上が実験的に合成可能と見なされる安定した物質であることを突き止めました(GNoMEの成果)。

Google DeepMindの発表によると、これは人類がこれまでに蓄積してきた知識を大幅に上回る量であり、約800年分の人間による研究に匹敵する成果を、ごく短期間で達成したことに相当します(GNoMEの成果)。

さらに、ローレンス・バークレー国立研究所の自律型実験プラットフォーム「A-Lab」は、GNoMEが予測した候補の中から41種類の新物質を実際にロボットで作り出すことに成功しており(GNoMEの成果)、AIによる予測が物理的な現実に結びつくことを証明しました。

Microsoft MatterGen:要求に応じて物質を「生成」する

GNoMEが広大な未知の物質空間の「地図」を描き出すアプローチだとすれば、Microsoftが開発したMatterGen(マタージェン)は、特定の目的地を直接「設計」するアプローチです。

MatterGenは、既存の物質データベースを探索するのではなく、「硬度が高い」「導電性を持つ」といった要求(プロンプト)に基づき、全く新しい物質構造をゼロから生成することを目的としています(MatterGenの登場)。

画像生成AIがテキストから画像を生成するように、MatterGenは物理法則と設計要件に基づいて、原子の種類や配置を調整し、安定した結晶構造を創り出します。

この能力もまた、実験によって裏付けられており、MatterGenが設計した新物質が実際に合成されることに成功しています(MatterGenの登場)。

これは、科学が「発見」の時代から「設計」の時代へと、パラダイムシフトしていることを明確に示しています。

Key Takeaways(持ち帰りポイント)

- 創薬分野では、AlphaFold3のようなAIが構造解析を支援し、Isomorphic Labsなどが臨床試験を目指す段階に来ています。

- 材料科学では、GNoMEが人智を超える数の新物質候補を発見し、MatterGenは要求に応じて物質を「設計」する時代の到来を示唆しています。

- これらの「AIイノベーター」は、人間の研究者の監督のもと、発見のプロセスを劇的に加速させる「支援エンジン」として機能します。

第4章 共進化する未来 – 人間とAIの新たな関係

AIイノベーターの登場により、人間の役割がどう変わるのかを展望します。「指揮者」としてAIチームを率いる未来の働き方や、信頼とガバナンスの重要性など、人間とAIが共存する社会のルールを考えます。

AIが論理的に思考し、創造するパートナーとして現実世界に登場した今、私たちは新たな問いに直面しています。それは、「この強力な知性と、人間はどのように協働していくのか?」という問いです。これは、AIが人間の仕事を奪うという単純な「代替」の物語ではありません。人間とAIが互いの能力を高め合い、これまで不可能だった課題に共に挑む「共進化」の物語です。

AIチームとの協働:人間の役割は「指揮者」へ

未来の研究開発の現場は、一人の人間と一台の万能AIが対峙する姿ではないでしょう。むしろ、それぞれが専門性を持つ複数のAIエージェントから成る「チーム」と、一人の人間の専門家が協働する姿となります。

この新しい協働モデルの最先端が、Microsoftの「Discoveryプラットフォーム」です。このプラットフォームは、単一のAIではなく、「文献調査の専門家」「分子シミュレーションの専門家」「実験計画の専門家」といった、特定のタスクに特化した複数のAIエージェントの集合体として設計されています(Discovery解説)。

そして、人間(研究者)は、自然言語による指示を通じて、これらのAIエージェント群を指揮し、研究プロジェクト全体を推進します。

このようなマルチエージェント・システムは、人間の専門家の役割を根本的に変えます。

これまで研究者が多大な時間を費やしてきた個別のタスクは、AIエージェントチームによって自動化されます。その結果、人間の役割は、より高次の戦略的意思決定へとシフトします。

- 解くべき正しい問いは何か?

- AIが提示した複数の仮説のうち、どれが最も有望か?

- 予期せぬ実験結果は、画期的な発見の兆候か、それとも単なるエラーか?

- この研究は倫理的に許容されるか?

未来の科学者やエンジニアに求められるスキルは、個別の実験技術の習熟から、AIチームを率いて複雑なプロジェクトを成功に導く「指揮者(オーケストレーター)」としての能力へと移行していくのです。

信頼という不可欠な基盤

AIエージェントの自律性が高まるにつれて、「信頼」という問題が中心的な課題として浮かび上がります。特に、創薬や新素材開発のように、巨額の投資と人々の安全がかかる高リスクな環境において、内部の動作原理が不透明な「ブラックボックス」AIに重要な判断を委ねることはできません。

この信頼を構築するための第一の要件は、推論プロセスの透明性です。AIがなぜその結論に至ったのか、その論理的な道筋を人間が追跡し、監査できなければなりません。

第二の要件は、堅牢な「ヒューマン・イン・ザ・ループ(Human-in-the-Loop)」のメカニズムです。

AIの自律性は、全てを任せるか、全く任せないかの二者択一ではありません。重要なのは、人間がいつでもAIのプロセスに介入し、その決定を覆し、「ノー」と言う権利を保持することです。この人間による最終的な監督と責任が、技術の暴走を防ぎ、その恩恵を最大化するための最後の安全弁となります。

責任あるイノベーションのためのガバナンス

個々の組織内での信頼構築に加え、社会全体としてのガバナンス・フレームワークも不可欠です。効果的なガバナンスは、イノベーションの「ブレーキ」ではなく、むしろ大規模な投資や社会実装に必要不可欠な「信頼のインフラ」として機能します。

この課題に対する実践的な青写真として、米国国立標準技術研究所(NIST)のAIリスクマネジメントフレームワーク(AI RMF)や、世界的な先行指標となっているEU AI法などが挙げられます。これらのフレームワークは、リスクに基づいたアプローチを提唱し、特に医療や重要インフラなどで使用される「ハイリスクAI」に対して、高品質なデータの使用、人間の効果的な監督、高度なサイバーセキュリティの確保などを義務付けています。

このような責任あるイノベーションへの取り組みこそが、AIイノベーターの持つ革命的なポテンシャルを、持続可能かつ社会的に有益な形で開花させるための鍵となるのです。

※)詳細はこちらの記事にまとめてます

- EU発AI規制法の波紋:グローバル市場への影響と日本企業の備え

- 【2025年完全ガイド】AI規制とガバナンス:EU法と米国の違い、企業が知るべき戦略的対応法

- EU発AI規制法の波紋:グローバル市場への影響と日本企業の備え

Key Takeaways(持ち帰りポイント)

- AIとの協働が進むと、人間の役割は作業者からAIチームを率いる「指揮者」へと変わっていきます。

- AIの判断プロセスを透明化し、人間が常に介入できる「ヒューマン・イン・ザ・ループ」が信頼の基盤となります。

- NISTのAI RMFやEU AI法のような社会的なガバナンスが、AIイノベーションを安全に社会実装するためのルールを定めています。

まとめ

本記事では、AIが直感的な「システム1」思考から、熟慮する「システム2」思考へと進化し、科学的発見を支援する「AIイノベーター」として台頭する最前線を解説しました。

思考の木(ToT)のような新技術がAIの推論能力を深化させ、創薬や新素材開発の現場で具体的な成果を生み出しています。

この変化は、人間の役割をAIチームの「指揮者」へとシフトさせ、信頼性やガバナンスの構築を新たな課題として提示します。

AIとの共進化は始まったばかりであり、その可能性とリスクを理解し、賢明に未来を築いていくことが求められています。

専門用語まとめ

- LRM(大規模推論モデル)

- Large Reasoning Modelsの略。従来のLLMが持つ直感的な応答生成能力に加え、複雑な問題に対して慎重な思考ステップを生成する能力を持つ、新世代のAIモデル。(例: OpenAI o1, DeepSeek R1などが該当)

- ToT(思考の木)

- Tree-of-Thoughtsの略。問題解決の際に、一本道の思考ではなく、複数の可能性を樹木のように分岐させながら評価・探索するAIの推論フレームワーク。

- AlphaFold3

- Google DeepMindとIsomorphic Labsが開発したAIモデル。タンパク質だけでなく、DNAやリガンド(薬の候補)など、様々な分子間の相互作用を高精度で予測する。

- GNoME (ノーム)

- Graph Networks for Materials Explorationの略。Google DeepMindによるプロジェクトで、AIを用いて理論的に安定な未知の結晶構造を大規模に発見する。

- ヒューマン・イン・ザ・ループ

- AIシステムによる自動化されたプロセスの中に、人間が監視・介入・最終決定する機会を意図的に組み込む設計思想。AIの信頼性や安全性を確保する上で重要。

よくある質問(FAQ)

Q1. AIは本当に人間のように「思考」しているのですか?

A1. 現在のAIは、人間の脳の仕組みを完全に模倣しているわけではありません。しかし「思考の木(ToT)」のような技術は、人間が問題を解く際の「複数の選択肢を比較検討する」という思考プロセスを機能的に再現しています。結果として人間のような「熟慮」に近い振る舞いを示しますが、そのメカニズムは計算に基づいています。

Q2. AIイノベーターによって、科学者の仕事はなくなりますか?

A2. なくなるのではなく、役割が大きく変わると考えられます。本記事で解説したように、単純な実験やデータ解析はAIが担い、人間は「どの問題を解くべきか」という問いの設定、AIが提示する仮説の評価、倫理的な判断など、より高次の創造的な役割を担う「指揮者」になると予測されています。

Q3. この記事で紹介された技術は、いつ頃私たちの生活に影響しますか?

A3. 創薬や新素材開発は実用化まで長い時間がかかりますが、AIによる加速は確実に始まっています。Isomorphic Labsは2025年末の臨床試験開始を目指しており、これが成功すれば、数年後にはAIが設計に関わった新薬が登場する可能性があります。バッテリーや半導体などの新素材も、研究開発レベルでは既にAIによる発見が相次いでおり、今後5〜10年で製品への応用が現実味を帯びると専門家の間で予想されていますが、商用化までには追加の検証・規制対応といった課題も残ります。

Q4. AIが科学研究を進める上で、暴走したり悪用されたりするリスクはないのですか?

A4. リスクは存在します。だからこそ、本記事で触れた「ヒューマン・イン・ザ・ループ」や「ガバナンス」が極めて重要になります。危険な物質の設計や、研究成果の軍事転用などを防ぐため、AIの判断を人間が常に監督し、倫理的な歯止めをかける仕組みの構築が世界中で議論されています。

Q5. これからの時代、研究者やエンジニアを目指すにはどんなスキルが必要ですか?

A5. 専門知識に加え、AIを使いこなす能力が不可欠になります。具体的には、AIに的確な指示を与えるプロンプト能力、AIの提案を評価・選別する批判的思考力、そして複数のAIを組み合わせてプロジェクトを管理する「指揮者」としての能力が、これまで以上に重要になるでしょう。

更新履歴

- :テンプレートv5.0適合化、最新情報に基づき内容を全面改訂。

- :初版公開

主な参考サイト

- Accurate structure prediction of biomolecular interactions with AlphaFold 3 (Nature)

- Google DeepMind spinoff Isomorphic Labs in drug discovery deals worth nearly $3 bln (Reuters)

- Unlocking a new era of materials discovery with AI (Microsoft Research)

- Tree of Thoughts: Deliberate Problem Solving with Large Language Models (arXiv)

合わせて読みたい

以上