RAGデータパイプライン構築ガイド|精度を最大化するETLと前処理

この記事を読むと、RAGの精度を飛躍させるデータパイプラインの構築方法がわかり、高品質なAIシステムを設計できるようになります。

執筆者からひと言

こんにちは。30年以上にわたるITエンジニアとしての現場経験を基に、AIのような複雑なテーマについて「正確な情報を、誰にでも分かりやすく」解説することを信条としています。この記事が、皆さまのビジネスや学習における「次の一歩」のヒントになれば幸いです。

序論:RAGの成否は「データ準備」で9割決まる

RAGシステムの検索精度は、LLMの性能以上に、その入力となる「データの質」に大きく依存します。不適切なデータ準備は「Garbage In, Garbage Out」を招き、プロジェクト失敗の最大の原因となります。

多くの開発者は、RAGの性能向上というと、最新のLLMやベクトルデータベースに注目しがちです。しかし、真のボトルネックは、多くの場合、その前段階にあります。つまり、多種多様な社内文書(PDF, Word, Webページ等)から、いかにしてAIが理解しやすい「綺麗なデータ」を抽出し、整形するか。この一連のプロセス、すなわちデータパイプライン(ETL)の設計こそが、RAGプロジェクトの成功を左右するのです。本記事では、この最も重要でありながら見過ごされがちなデータパイプラインの構築について、具体的な技術要素とベストプラクティスを徹底解説します。

データパイプライン(ETL)とは?

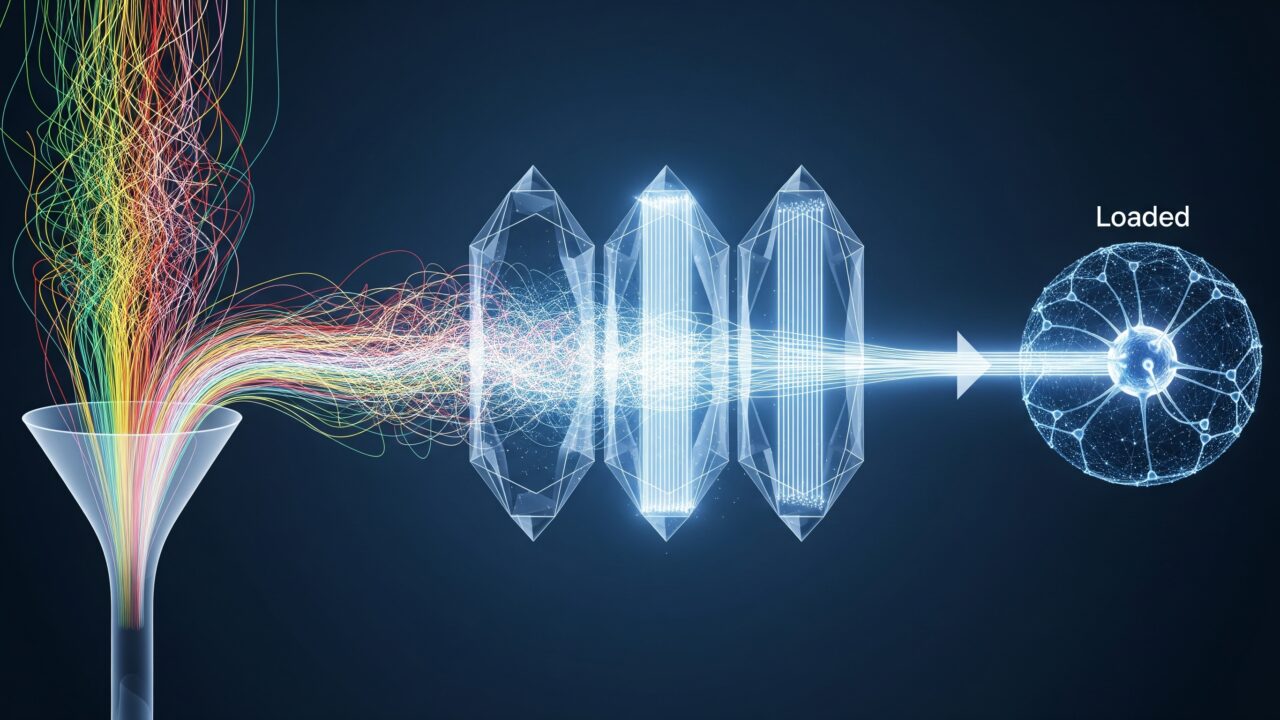

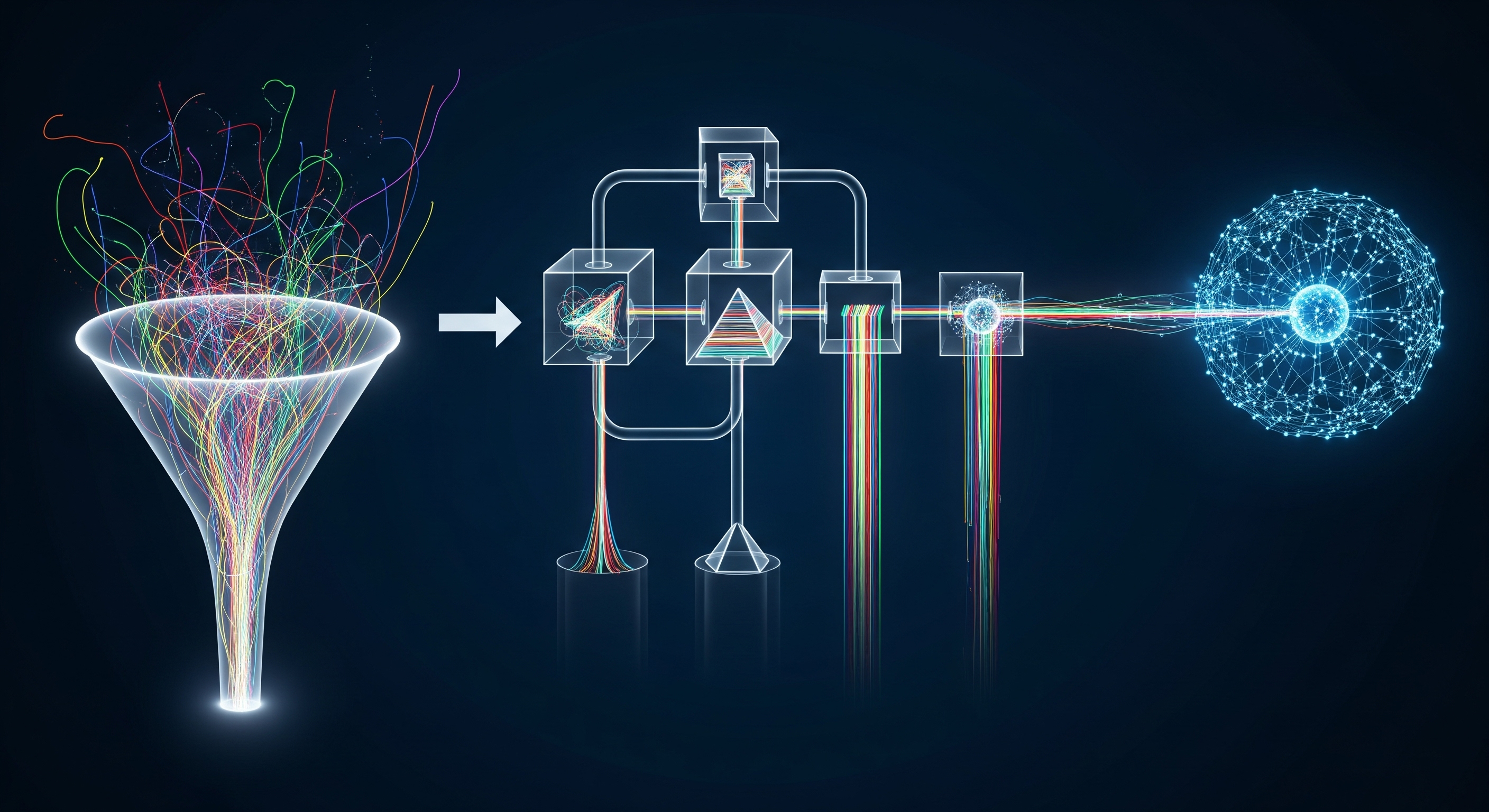

RAGにおけるデータパイプラインとは、様々な形式の元データ(ソース)を、ベクトルデータベースに格納できる最適な形式へと変換する一連の処理フローであり、一般的に「Extract(抽出)」「Transform(変換)」「Load(格納)」の3ステップで構成されます。

このパイプラインの目的は、AIが情報の意味を最もよく理解し、ユーザーの質問に対して最も関連性の高い情報を効率的に検索できるように、データを「下ごしらえ」することです。それぞれのステップを詳しく見ていきましょう。

Extract(抽出):情報の入り口

最初のステップは、PDF、Word、HTML、Markdownなど、様々な形式のファイルからテキスト情報を抜き出すことです。ファイル形式ごとに専用のライブラリ(例:PyMuPDF for PDF, BeautifulSoup for HTML)を使い、まずは純粋なテキストデータを取得します。

Transform(変換):パイプラインの心臓部

抽出されたテキストデータに対して、精度を最大化するための様々な加工を施します。このステップが最も重要です。主な処理には、不要な記号の除去(クリーニング)や、テキストを意味のある塊に分割する「チャンキング(Chunking)」があります。

Load(格納):情報の出口

最後に、変換されたデータの塊(チャンク)を、その意味内容を表す「ベクトル」に変換(埋め込み)し、ベクトルデータベースに格納します。これにより、高速な意味検索が可能になります。

最重要プロセス「チャンキング」の技術

チャンキングとは、長文のテキストを、AIが扱いやすい適切な長さの塊(チャンク)に分割する技術です。チャンクの質が検索結果の質に直結するため、RAGの精度チューニングにおける最重要項目です。

もしテキストを不適切な場所で分割してしまうと、重要な情報が複数のチャンクに分断され、検索時にヒットしなくなってしまいます。そのため、目的に応じた様々なチャンキング戦略が存在します。

👨🏫 かみ砕きポイント

チャンキングは、長い本を、後で調べやすいように「付箋」を貼りながら、いくつかの章に分ける作業に似ています。どこで区切るか、どのくらいの長さで区切るかによって、後で「あの情報どこだっけ?」と探すときの見つけやすさが全く変わってきます。この「区切り方」の工夫が、RAGを賢くする秘訣なのです。

主要なチャンキング戦略の比較

代表的なチャンキング手法には、それぞれメリットとデメリットがあります。プロジェクトの要件に応じて最適なものを選択する必要があります。

| 戦略名 | 特徴 | 長所・短所 |

|---|---|---|

| 固定サイズ | 単純に指定した文字数(例: 500字)で分割する。 | 長所: 実装が最も簡単。 短所: 文章の途中で切れる可能性が非常に高い。 |

| 再帰的文字分割 | 「\n\n」(段落)、「。」(文)、「、」(読点)など、優先順位の高い区切り文字で再帰的に分割する。 | 長所: 文書の構造を維持しやすく、意味が分断されにくい。 短所: 適切な区切り文字の選定が必要。 |

| セマンティック | AIモデルを使い、文章の意味的な類似度に基づいて分割点を決定する。 | 長所: 最も意味的に一貫したチャンクを作成できる。 短所: 計算コストが高く、処理に時間がかかる。 |

Key Takeaways(持ち帰りポイント)

- RAGのパイプラインは「抽出」「変換」「格納」の3ステップで構成される。

- パイプラインの心臓部は「変換」、特に「チャンキング」である。

- チャンキング戦略は複数あり、「再帰的文字分割」がバランスの取れた出発点となる。

- 最終的な検索精度は、これらの地道なデータ前処理の積み重ねによって決まる。

まとめ:データパイプラインは価値創造の源泉

RAGシステムの構築において、データパイプラインは単なる「準備作業」ではありません。それは、AIが最大限の能力を発揮するための土台であり、生成される情報の価値を決定づける、最も創造的なプロセスです。

本記事では、RAGの精度を左右するデータパイプラインの重要性と、その中核技術である「チャンキング」について解説しました。LLMやベクトルデータベースが注目されがちですが、最終的なアウトプットの質は、入力されるデータの質を超えることはありません。「Garbage In, Garbage Out」の原則を常に念頭に置き、自社のデータという「原石」を磨き上げるデータパイプラインへの投資こそが、プロジェクトの成否を分ける最も重要な要素であると言えるでしょう。

専門用語まとめ

- ETL (Extract, Transform, Load)

- データを様々なソースから「抽出し」、利用しやすい形式に「変換し」、データベースに「格納する」一連のプロセス。

- チャンキング

- RAGにおいて、長文のテキストをAIが処理しやすい意味のある塊(チャンク)に分割する、極めて重要な前処理技術。

- メタデータ

- データに関する付帯情報のこと。RAGでは、各チャンクに出典元ファイル名やページ番号などを付与することで、検索精度の向上や出典提示に役立つ。

よくある質問(FAQ)

Q1. データパイプライン構築で最も時間がかかるのはどの部分ですか?

A1. 多くのプロジェクトで「Transform(変換)」の工程、特に多様な文書フォーマットに対応するためのクリーニング処理と、最適なチャンキング戦略を見つけるための試行錯誤に最も時間がかかります。

Q2. どのようなツールが使われますか?

A2. Pythonのライブラリが多く使われます。データ抽出にはPyMuPDF (PDF)やBeautifulSoup (HTML)、チャンキングやベクトル化のプロセス全体はLangChainやLlamaIndexといったフレームワーク上で管理するのが一般的です。

Q3. 画像や表のデータはどうすれば良いですか?

A3. 高度なパイプラインでは、画像の内容を説明するテキスト(キャプション)を生成するマルチモーダルAIや、表形式のデータをテキストに変換する技術を組み込むことがあります。これにより、テキスト以外の情報も検索対象に含めることができます。

更新履歴

- 最新情報アップデート、FAQ、専門用語等読者支援強化

- 初版公開

主な参考サイト

- Chunking Strategies for LLM Applications – Pinecone – ベクトルデータベース企業Pineconeによる、様々なチャンキング戦略の技術的な比較解説です。

- LangChain Docs: Text splitters – LangChainフレームワークで利用可能な、多様なチャンキング手法(Text Splitters)に関する公式ドキュメントです。

合わせて読みたい

- RAG(検索拡張生成)とは?仕組み・重要性を図解で徹底解説【2025年版】

- RAGシステムに必須!ベクトルデータベースの基礎と最前線

- RAG vs ファインチューニング徹底比較|コスト・精度・運用で選ぶAI最適化手法

以上