【2026年版】AIプロジェクト失敗の構造学:死の谷を越える20の生存戦略

この記事を読むと、多くのAIプロジェクトがなぜ失敗するのか「3つの構造的要因」がわかり、失敗を予見して回避する「20のチェックリスト」を活用できるようになります。

AIプロジェクトの失敗は「技術・組織・経済」の不整合から生じる構造的な問題です。

成功のためには「100%の精度」を諦め、業務知識を持つドメインエキスパートを中心とした「人間とAIの分業体制」を再設計する必要があります。

超ざっくり言うと:AIは魔法の杖ではなく「ミスをする新人」です。彼らを使いこなすには、現場のベテラン(ドメインエキスパート)による教育と、失敗を許容する業務フローの設計が不可欠です。

この記事の構成:

- 失敗の全体像:調査が示す「30〜95%失敗」の現実

- 3つの失敗パターン(技術・組織・経済)の詳細分析

- プロジェクト生存のための「事前チェックリスト20」

なぜ「AIプロジェクト」の多くは「失敗」して成果を出せないのか

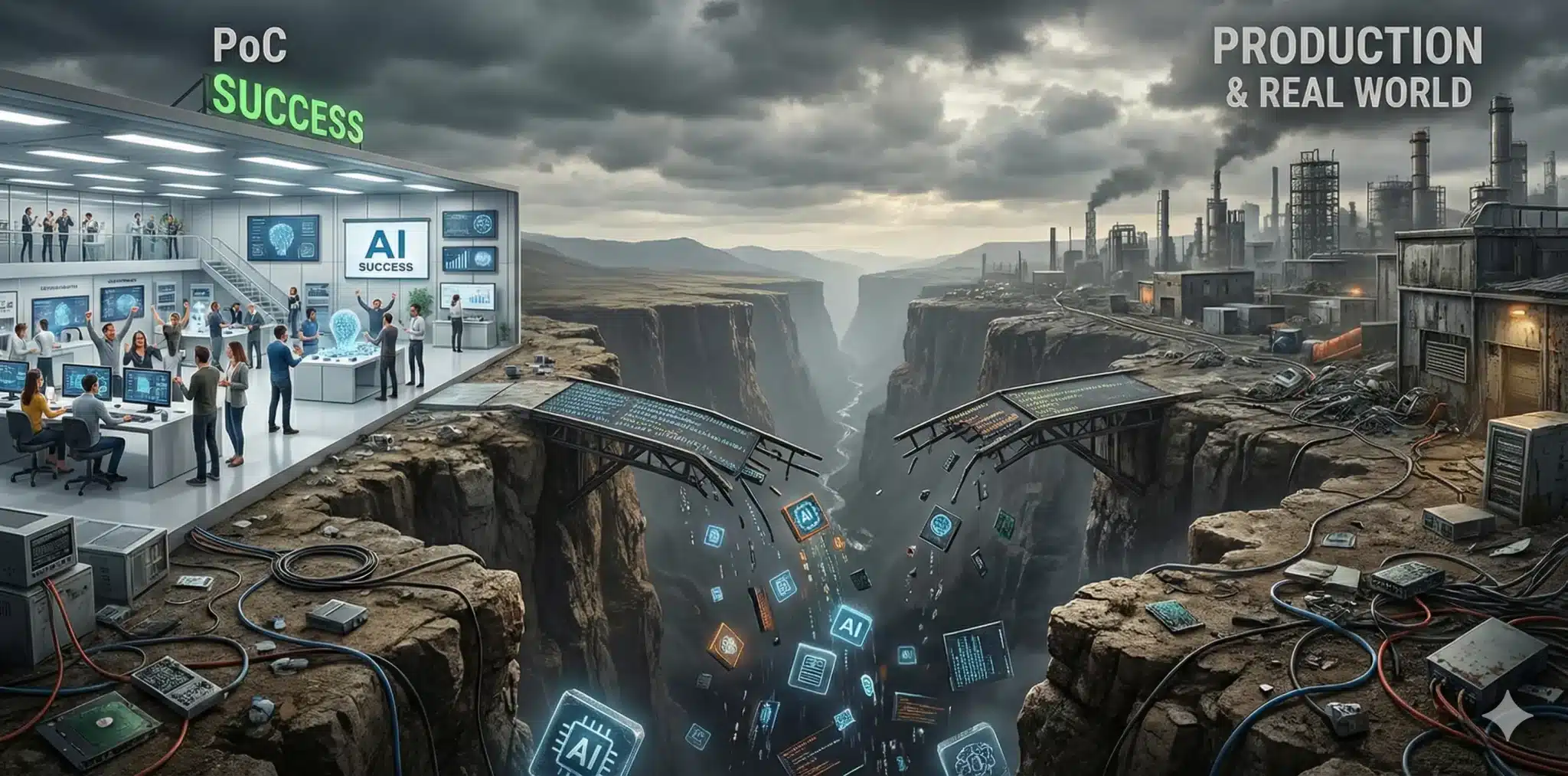

「PoCまでは順調だった。しかし、本番環境に乗せた途端、AIプロジェクトは失敗し、沈黙してしまった」――2025年末、「PoC地獄」「PoC疲れ」という言葉が囁かれる中、多くの企業でこのような会話が交わされています。

AIプロジェクトの失敗率は調査によって異なりますが、Gartnerは「30%がPoC後に放棄される」と予測し、MITの調査では「95%が成果を出せていない」と報告されています。RAND Corporationによる「AIプロジェクトの80%が失敗する」という指摘 も踏まえると、実用化に成功するのは全体の2〜3割程度というのが偽らざる現実です。

AIプロジェクトにおける「失敗」の定義とは?

本記事で扱うAIプロジェクトの失敗とは、単にエラーが出ることではありません。最も恐ろしいのは、「システムは完成したが、誰も使わない」「動いているが、投資対効果(ROI)が大赤字である」という状態です。これを回避するためには、以下の3つの構造的な要因を理解する必要があります。

AIプロジェクトの技術的失敗パターン:「90%の精度」という罠

デモ環境では完璧に見えたAIが、実務で使い物にならずプロジェクトが失敗する最大の原因は、コーナーケース(レアケース)への対応力不足です。

・「9割正しい」は「10回に1回嘘をつく」リスクと同義

・RAGの品質は「参照データの質」と「検索・プロンプト設計」に強く依存する(Garbage In, Garbage Out)

・プロンプトインジェクション等のセキュリティ対策不足が事故を招く

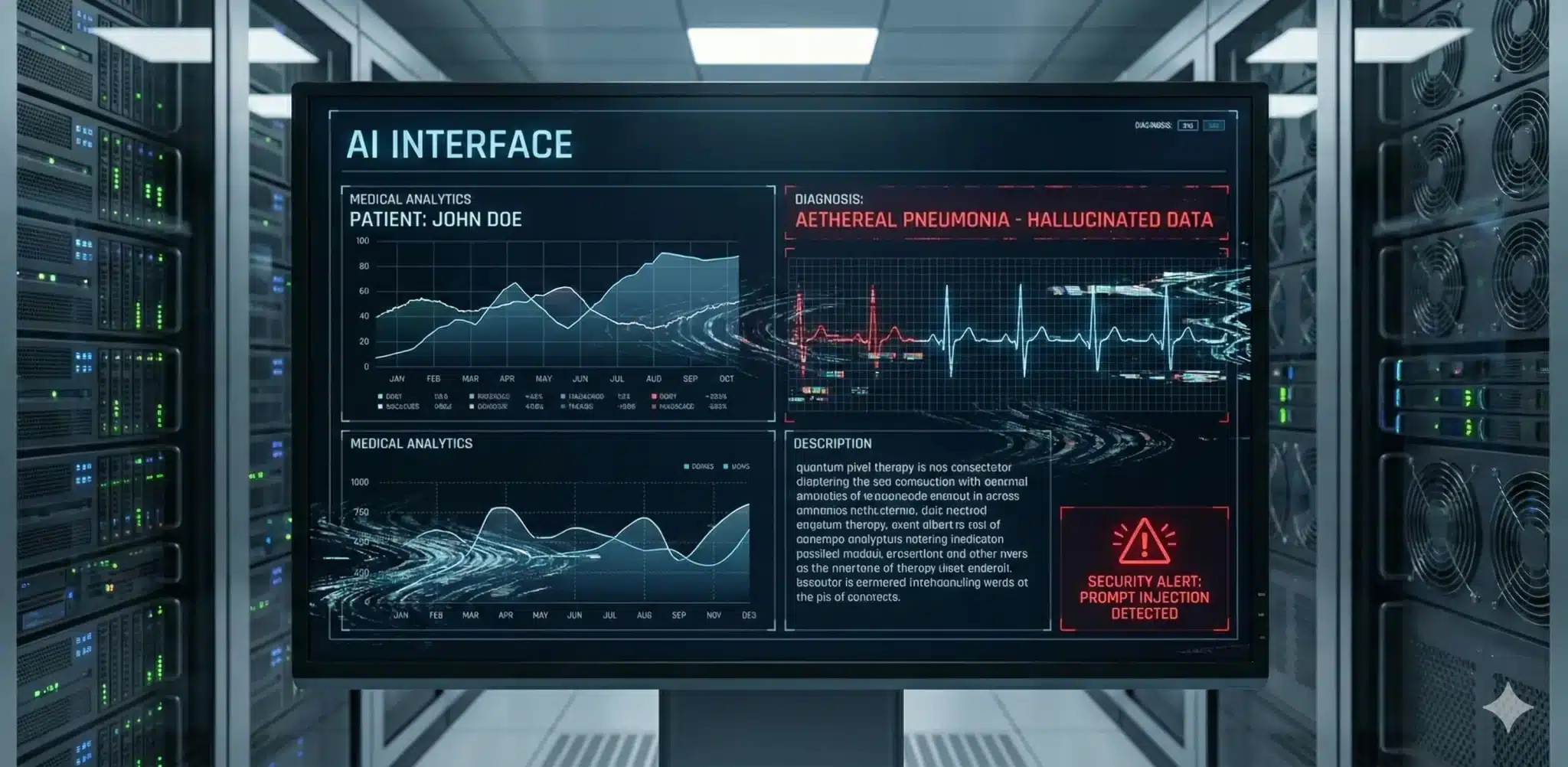

ハルシネーションとセキュリティの壁

金融や医療、法務といったミッションクリティカルな領域では、数パーセントの誤差が致命傷となり、AIプロジェクトは失敗します。AIは「もっともらしい嘘(ハルシネーション)」をつく確率的なシステムです。

また、2026年に向けて自律型エージェントの導入が進む中で、悪意ある入力でAIを操る「プロンプトインジェクション(Prompt Injection)」による情報漏洩など、セキュリティ設計が不十分なまま公開するリスクも高まっています。

AIプロジェクトの組織的失敗パターン:「魔法の杖」幻想と反乱

経営層はAIを「魔法の杖」だと思い込み、「AIを入れれば来月から人員を半分にできる」といった非現実的な期待を抱きがちです。これはいわゆる「AIウォッシング(AI-washing)」にも繋がりかねない危険な兆候です。

実態の伴わないAI活用をアピールするだけでなく、現場に無理な導入を強行すれば、従業員は「自分の仕事が奪われる」という恐怖や、「AIの尻拭い(修正作業)で逆に仕事が増えた」という徒労感を感じ、プロジェクトは頓挫(失敗)します。

ドメインエキスパートの不在

「プロンプトエンジニアリング」という言葉が流行しましたが、真に必要なのは「業務知識(ドメイン知識)」です。AIに何をさせるべきか、その出力が正しいかどうかを判断できるのは、エンジニアではなく、その業務に精通したベテラン社員だけです。

実際、専門家が関与したAIプロジェクトでは、開発サイクルの短縮や精度向上など、目に見える改善効果を報告する事例が多くあります。彼らの知見を「RLHF(人間からのフィードバックによる強化学習)」等の手法でモデルに反映させない限り、現場の実情に合わない「使えないツール」を生み出し、導入は失敗します。

| 評価軸 | トップダウン型(失敗) | 現場主導型(成功) | ハイブリッド型(理想) |

|---|---|---|---|

| 目的 | 人員削減・コストカット | 業務効率化・品質向上 | 付加価値の創出 |

| 主導者 | 経営層・IT部門 | 現場リーダー | ドメインエキスパート×IT |

| 現場の反応 | 反発・面従腹背 | 部分的利用 | 自律的改善 |

| 判定根拠 | 現場の業務知識を持つ人間が「AIの監督者」として機能する体制が最もROIが高い。 | ||

AIプロジェクトの経済的失敗パターン:ROI未達と「隠れコスト」

OpenAIの「o3-pro」やGoogleの「Gemini 3 Pro」など、推論能力(Reasoning)が高いモデルは、回答を出すまでに長く思考(Deep Think)するため、計算リソースを大量に消費します。

推論コスト(Inference Cost)の見落とし

2025年の価格改定で利用しやすくはなりましたが、GPT-4o miniなどの軽量モデルと比較すれば依然として高コストです。すべてのタスクに最高性能モデルを使うのではなく、難易度に応じてモデルを使い分ける「モデルルーティング」(例:簡単な分類タスクにはGPT-4o mini、複雑な推論にはo1-preview、という使い分け)の設計が、AIプロジェクトの経済的成功の鍵を握ります。

また、AIは導入して終わりではありません。モデルの性能変化やデータの傾向変化(データドリフト:例えば、訓練時には存在しなかった新しい商品名や業界用語が増えることで、AIの認識精度が低下する現象)を監視し続けるための運用基盤「LLMOps」のコストを予算化していないプロジェクトは失敗し、半年もすれば陳腐化し廃棄される運命にあります。

AIプロジェクトの失敗を予見する「事前チェックリスト20」

では、どうすればこれらの失敗を回避できるのでしょうか?AIプロジェクトを本格始動させる前(PoCの前後)に、以下のチェックリストを確認してください。これらに明確に答えられない場合、そのプロジェクトは「死の谷」へ向かっています。

【Why:目的と課題】

- 1. AIを使わなくても解決できる課題ではないか?

- 2. 解決したい課題の「ビジネス価値(金額)」は算出されているか?

- 3. 現場は「その課題を解決したい」と熱望しているか?

- 4. 「100%の精度」がなくても成立する業務フローか?

【What:データとモデル】

- 5. AIに食わせるデータは構造化・整備されているか?

- 6. データの著作権・プライバシーリスクはクリアか?

- 7. 使用するモデルの選定根拠(コストvs性能)は明確か?

- 8. ハルシネーションが発生した際のリスク許容度は定義されているか?

【Who:体制と組織】

- 9. 経営層は「AIは確率的である(ミスをする)」と理解しているか?

- 10. プロジェクト責任者は「撤退基準」を持っているか?

- 11. 開発チームに「ドメインエキスパート(業務のプロ)」はいるか?

- 12. 現場ユーザーへの教育・サポート計画はあるか?

【How:運用と経済性】

- 13. Human-in-the-Loop(人間による確認工程)は設計されているか?

- 14. 推論コストの試算は「最大負荷時」で行われているか?

- 15. 出力の品質を評価する「自動評価パイプライン」や、品質・コスト・安全性を監視するLLMOps基盤はあるか?

- 16. 予期せぬ挙動を防ぐ「ガードレール」は実装されているか?

【Future:拡張性】

- 17. 特定のベンダー/モデルに依存しすぎていないか?(ロックイン対策)

- 18. 法規制(2024年施行のEU AI Actなど)が2026〜2027年にかけて本格適用されるタイムラインに対応できるか?

- 19. 成功した場合、全社展開するためのスケーラビリティはあるか?

- 20. 「失敗」から学び、ピボット(方向転換)する文化はあるか?

まとめ:失敗を「学習」に変える組織だけが生き残る

2026年に向けてAIが社会インフラ化する過程で、「死の谷」に直面するのは避けて通れない道です。本記事で解説した通り、プロジェクトの頓挫は誰かのミスではなく、技術的限界・組織の壁・経済性の不一致という構造的な要因から発生します。

しかし、失敗を恐れて立ち止まることこそが、変化の激しいAI時代における最大のリスクです。重要なのは、最初から完璧な正解を求めることではありません。「AIは間違える」という前提に立ち、致命傷を負わない範囲で小さく失敗し、高速にピボット(方向転換)し続ける「学習する組織」へと変わることです。

AI導入の成否を分けるのは、最終的にはツールではなく「人」の知恵です。次回の記事では、この不確実な航海における羅針盤となる「ドメインエキスパート(業務のプロ)」の役割について、さらに深く掘り下げていきます。

※)興味のある方はこちらの記事を参照してください。

AI時代の覇者は「ドメインエキスパート」|2026年キャリア戦略

専門用語まとめ

- 死の谷(Valley of Death)

- 研究開発やPoC(概念実証)までは成功したものの、資金不足や事業化の壁に阻まれ、実用化・商用化に至らずプロジェクトが消滅してしまう期間のこと。

- AIガバナンス(AI Governance)

- AIシステムの開発・運用において、倫理的、法的、社会的なリスクを管理し、説明責任を果たすための組織的な枠組みやルールのこと。

- ハルシネーション(Hallucination)

- AIが事実に基づかない情報を、あたかも事実であるかのように自信満々に生成してしまう現象。「幻覚」とも呼ばれる。

- プロンプトインジェクション(Prompt Injection)

- AIに対する入力(プロンプト)に悪意のある命令を紛れ込ませ、開発者が意図しない挙動や情報漏洩を引き起こさせる攻撃手法。

- ドメインエキスパート(Domain Expert)

- 特定の業務領域(ドメイン)について深い知識と経験を持つ専門家のこと。AI開発においては、出力結果の正誤判断や、AIへの指示出しを行う重要な役割を担う。

- RLHF(Reinforcement Learning from Human Feedback)

- 人間からのフィードバック(評価)を報酬として用い、AIモデルを強化学習させる手法。人間の意図や価値観に沿った出力をさせるために重要。

- AIウォッシング(AI-washing)

- 実態としてはAI技術をほとんど使用していないにもかかわらず、マーケティング効果を狙って「AI搭載」などを過剰にアピールする行為。

よくある質問(FAQ)

Q1. PoCで失敗した場合、すぐに撤退すべきですか?

A1. 失敗の原因によります。技術的な限界であれば撤退も視野に入りますが、使い方の問題であればUI改善で解決する可能性があります。 「小さく失敗し、早く学ぶ」ことが重要です。

Q2. RAGを導入すればハルシネーションはなくなりますか?

A2. 完全にはなくなりません。 最新の研究でも、RAG導入後も相当数のハルシネーションが残存することが報告されています。RAGの品質は「参照データの質」と「検索・プロンプト設計」に強く依存し、最終的には人間の確認プロセス(Human-in-the-Loop)とセットで運用することが前提になります。

Q3. 失敗しないためのコスト管理のコツはありますか?

A3. 推論コスト(トークン課金)を甘く見ないことです。 高性能なモデル(GPT-4oやo1等)は高額なため、簡単なタスクには安価なモデルを使い分ける「モデルルーティング」の設計が重要です。

今日のお持ち帰り3ポイント

- AIプロジェクトの失敗は「技術・組織・経済」の3つの不整合から起きる

- 「100%の精度」を目指さず、人間が補完する運用フローを設計する

- 成功の鍵はプログラミングスキルよりも「業務知識(ドメイン知識)」にある

主な参考サイト

- Gartner Predicts 30% of Generative AI Projects Will Be Abandoned After Proof of Concept by End of 2025(2024)

- Gartner Predicts Over 40% of Agentic AI Projects Will Be Canceled by End of 2027(2025)

- AI project failure rates are on the rise: report – S&P Global(2025)

- The Root Causes of Failure for Artificial Intelligence Projects – RAND(2024)

- Why do 87% of data science projects never make it into production? – VentureBeat(2019)

合わせて読みたい

更新履歴

※本記事は、最新のAI技術動向や市場調査データを反映し、定期的に内容を更新しています。

- 初版公開