※本記事は継続的に「最新情報にアップデート、読者支援機能の強化」を実施しています(履歴は末尾参照)。

※コードは学習ループのロジック理解が目的の疑似コードです(実行前提ではありません)。

Vera Rubin時代のロボット開発手法:OpenUSD×Omniverseで「Sim→学習→運用」を止めずに回す実務テンプレ

Physical AI 2026:仮想と現実が溶け合う「双方向循環」が産業を支配する

この記事の結論:

Vera Rubin世代の勝負は「個別ツール」ではなく、Sim→学習→運用を“止めずに回す”接続(ループ設計)です。

- 最重要は契約(Contract):OpenUSDで「センサー/ログ/評価」を仕様として固定し、Sim・学習・運用で同じ言葉を使う。

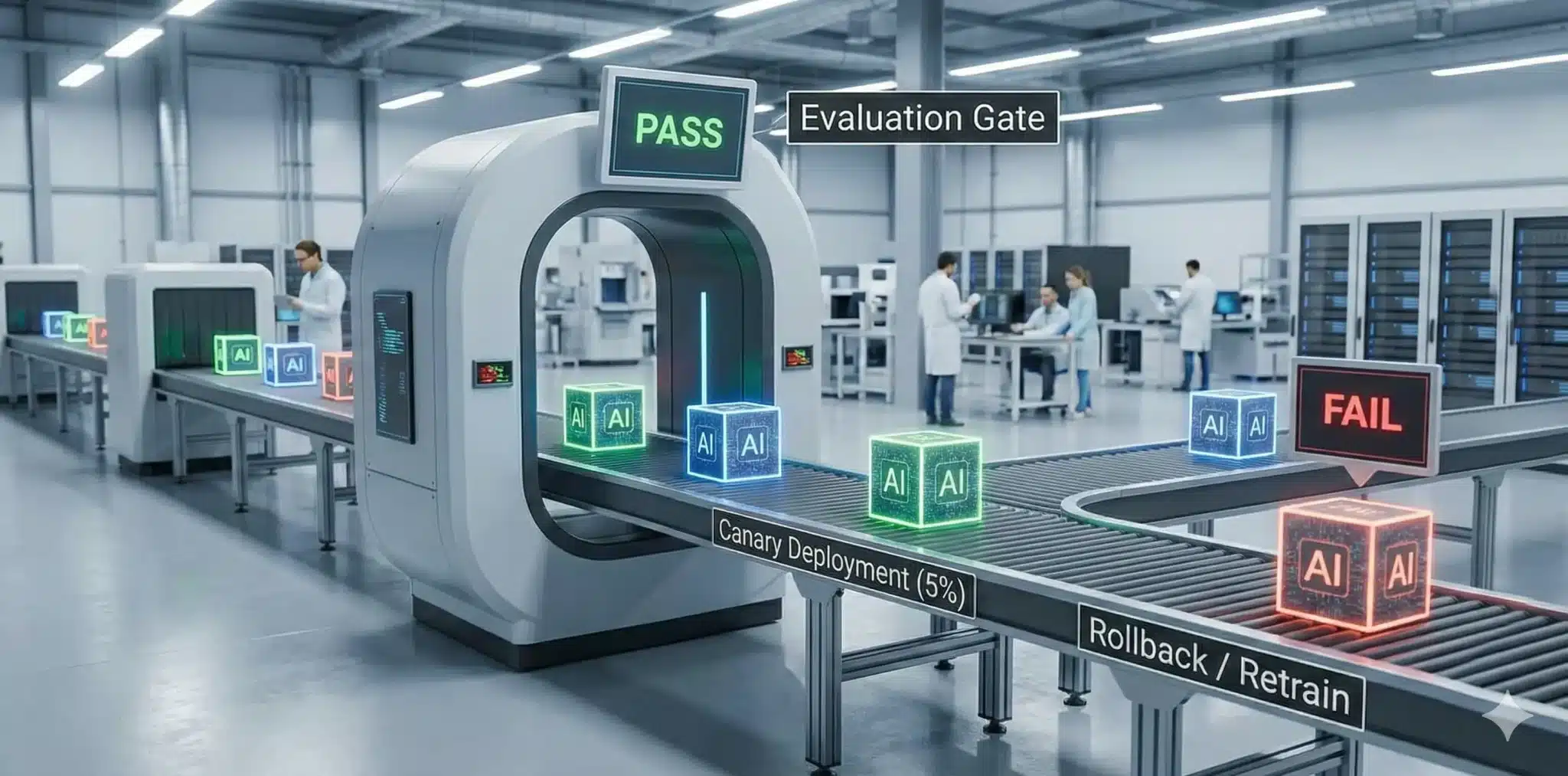

- 学習は“出しっぱなし”にしない:NeMo等で学習→評価ゲート→成果物(artifact)化し、合格だけを配信へ回す。

- 運用が主役:Dynamo等の推論配信で監視・段階展開・ロールバックまで含めて初めて「現場データ→再学習」が成立する。

Key Takeaways:

- PoC止まりの主因:モデル精度ではなく、ログ設計・評価ゲート・配信運用(監視/ロールバック)が欠けること。

- 差が出る場所:Simの試行回数より、失敗ログが学習に戻る速度と、現場で止まらない配信。

- OSS活用の意味:学習基盤はOSSを土台にできる。重要なのは、Physical AI向けにデータ契約・評価・運用を“つなぐ”こと。

0. まず全体像:どのツールをどう“接続”するか

この記事の目的:はPhysical AI(ロボット/自動運転)の開発で最も詰まりやすい「Sim→学習→運用」の断絶をなくし、現場データが学習へ戻り続ける“閉ループ”を、最小の設計原則(Contract→Gate→Ops)で再現することです。

この記事の目的:はPhysical AI(ロボット/自動運転)の開発で最も詰まりやすい「Sim→学習→運用」の断絶をなくし、現場データが学習へ戻り続ける“閉ループ”を、最小の設計原則(Contract→Gate→Ops)で再現することです。

狙い:

ツールの機能紹介ではなく、エンジニアが明日から設計に落とせるように、

①ログ/センサー仕様を固定(Contract)→②学習を合否判定で出荷(Gate)→③段階展開とロールバックで止めない(Ops)

という“つなぎ方”を、疑似コード(各15行程度)で具体化します。

読者が持ち帰るもの:

「どのツールを導入するか」ではなく、「何を次工程へ渡せばループが止まらないか」という設計の型です。

ポイントは個別ツールの優劣ではなく、ループを止めない“つなぎ方”です。

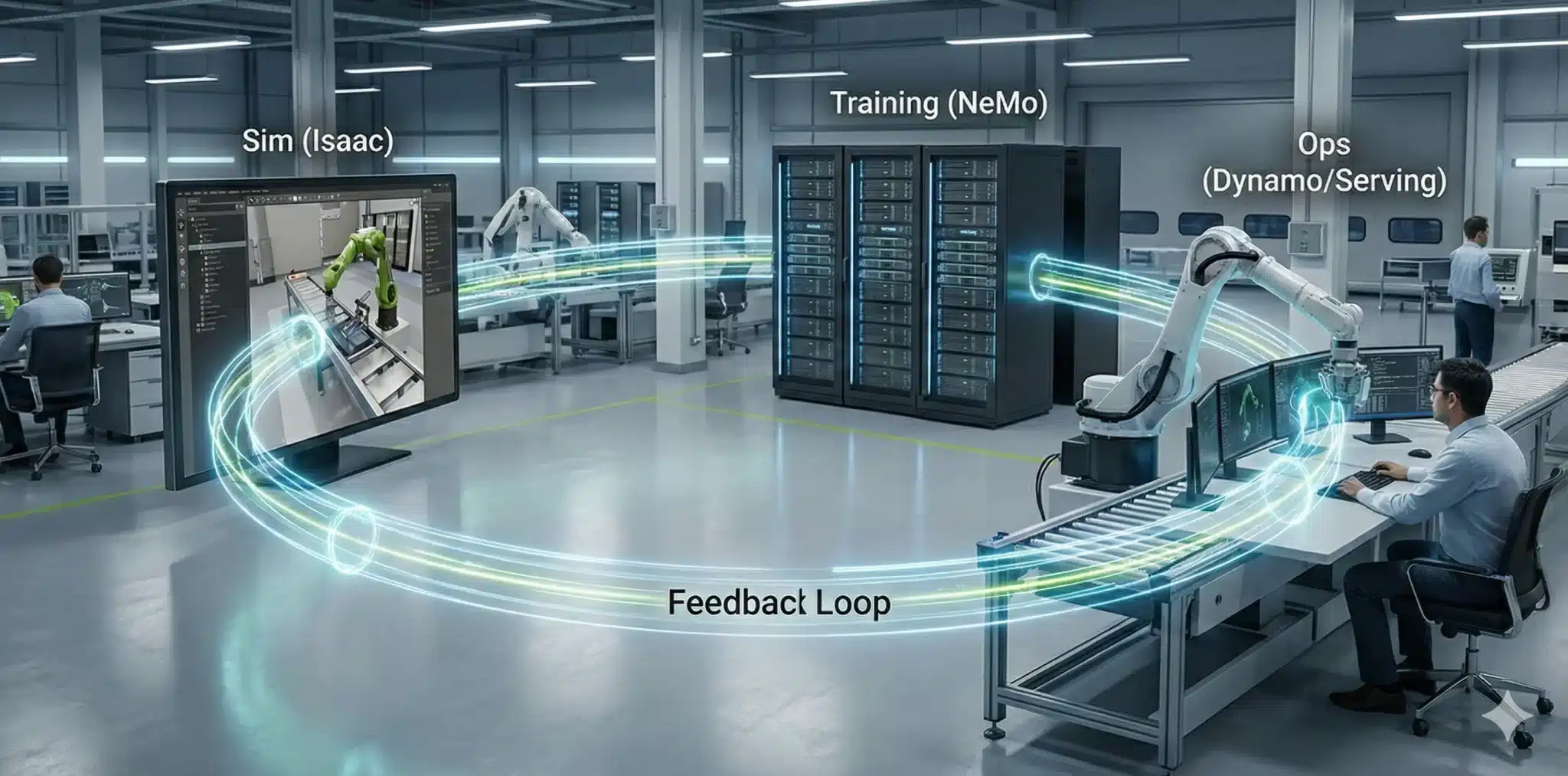

ここでは、OpenUSD→Omniverse→Isaac Sim→(Cosmosで拡張)→NeMo→Dynamo→現場ログ→再学習、という一本道に落とします。

- OpenUSD:工場・ロボ・センサー・ログ仕様を同じ設計図(Contract)として固定する

- Omniverse:OpenUSDの世界を共有し、シミュ・検証・協業を回しやすくする

- Isaac Sim:仮想で大量試行し、成功ログだけでなく失敗ログも学習材料にする

- Cosmos:環境バリエーション生成などでSim-to-Realを支援(世界の“揺らし”を供給)

- NeMo:学習・調整・評価・監視を束ね、品質と安全性を運用可能な形に整える

- Dynamo:本番推論を安定配信し、監視・段階展開・ロールバックで現場を止めない

- GR00T:ヒューマノイド等の行動生成に向けた基盤モデル(成果が表に出やすい領域)

読み方:この後は「ツール紹介」ではなく、各ツールがループ上のどこを担当し、次に何を渡すべきか(Contract)に集中します。

1. なぜVera Rubin時代は「接続=ループ設計」が主戦場なのか

1.1. 速いGPUがあっても、PoCは簡単に止まる

GPUが強くなるほど「学習は回せる」のに、現場では止まる――このズレの原因はシンプルです。

学習が“成果物(artifact)”として管理されず、運用に乗らないからです。

そして運用に乗らない最大要因は、モデル精度以前にログ設計と評価ゲートが欠けることにあります。

1.2. ループを止めないための3つの契約(Contract)

- データ契約:何をログとして残し、どの粒度で同期し、どのIDで追跡するか

- 評価契約:何をKPIとして測り、どの閾値で合否を決めるか(安全・介入・遅延・成功率…)

- 運用契約:誰が配信し、どう監視し、いつロールバックするか(責任分界を含む)

この3契約を“仕様として固定”するのが、OpenUSD(Contract)→学習(artifact)→配信(運用OS)の一本化です。

2. ループの設計図:Sim→学習→運用を回す「最小アーキテクチャ」

ここでは、実装の最低ラインを「5つの箱」に分けます。現場で迷子になりやすいので、まず“箱”を固定します。

- World/Contract(OpenUSD):世界・ロボ・センサー・ログ仕様を1つの設計図に

- Sim Orchestrator(Omniverse/Isaac Sim):試行を回し、ログを一貫形式で出す

- Training+Gate(NeMo等):学習→評価→合格のみartifact化

- Serving+Ops(Dynamo等):推論配信、監視、段階展開、ロールバック

- Feedback:現場ログをContractに沿って蓄積し、次のSim/学習へ戻す

以降の「4章 実務テンプレ」は、この5箱を疑似コードで“つなぐ”章です。

3. 実装で詰まる論点:ロボット開発ループを止める“よくある落とし穴”

現場の会話はだいたいこう始まります。

「Simでは動く。デモもできた。でも“次の改善”が回らない」。

ロボット開発がPoCで止まるのは、モデルが賢くないから…ではなく、Sim→学習→運用→回収のどこかが切れて、失敗が次に活かされないからです。ここでは、ループを止める典型パターンを先に潰します。

3.1. PoCが止まる「3つの落とし穴」

❶ ログが戻らない:

現場の出来事が「文章の報告」だと学習に戻せない。機械が読める形(構造化)で残す。

たとえ話:レシートが無い経費精算は、次の予算が組めない。

❷ 評価ゲートがない:

「良さそう」で出すと、現場で初めて壊れる。合否をコードで固定し、NG理由を返す。

たとえ話:検収基準が無い納品は、揉める未来が確定。

❸ 段階展開とロールバックがない:

100%投入は“一発勝負”。最後に止めを刺すのがロールバック不在。まず小さく出し、監視し、戻せるようにする。

たとえ話:非常口の無いイベント会場は、満席になった瞬間に詰む。

この3点が整うと、次章のContract→Gate→Opsが「考え方」ではなく「工程」になります。

3.2. NVIDIAのロボット開発システムの“オープン”戦略を読み解く

ここで一度、読者が勘違いしやすい点を整理します。

ここで一度、読者が勘違いしやすい点を整理します。

「オープン=全部自由に商用利用できる」ではありません。

ロボット開発の現場では、ここを誤解すると後工程(調達・法務・運用)で止まります。

CxO向け

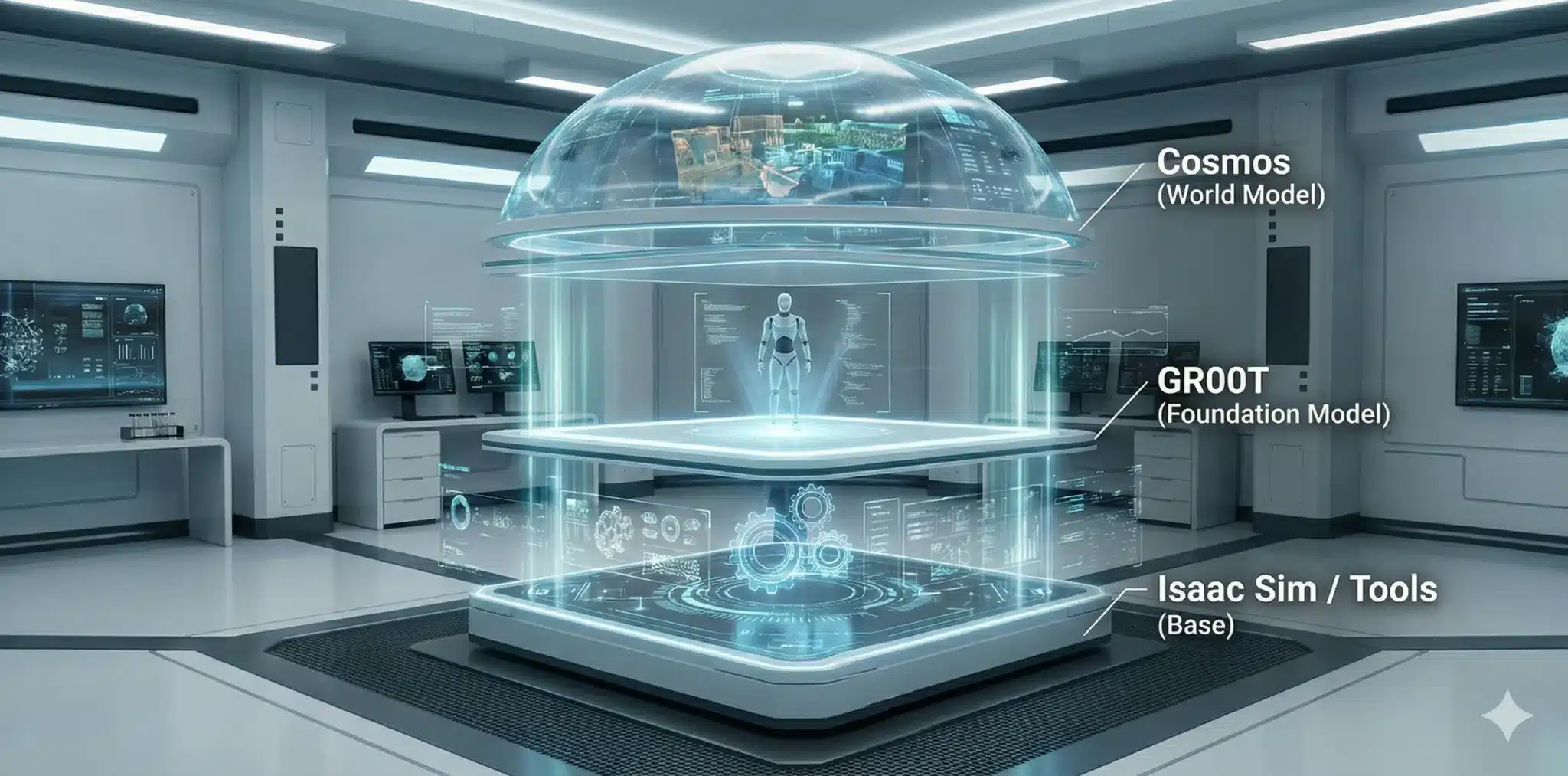

NVIDIAのロボット向けPhysical AIは、世界モデルCosmos、ロボット基盤モデルGR00T、シミュレータIsaacを中核に構成されます。

「オープン」と言っても、実態は①コード(OSS)、②モデル重み(Open Weights)、③データ(Open Dataset)が別ライセンスで動きます。

商用展開・クラウド提供・再配布の検討では、コード/モデル/データを分けて用途制限を確認するのが前提です。詳細は公式サイトを参照してください。

エンジニア向け

ロボット向けスタックは、次の三層で捉えると迷いません。

- 世界モデル層(Cosmos World Foundation Models)

Cosmos-Reasonなど世界モデル群。物理世界の動画やドメイン特化データで学習し、重力・衝突など物理的一貫性を持つ表現を提供します。 - ロボット基盤モデル層(Isaac GR00T N)

ヒューマノイド向け reasoning VLA。モーションキャプチャ、実機ログ、合成データなどを統合した humanoid dataset で学習された基盤モデルです。 - ツール/Sim層(Isaac Sim / Isaac Lab)

物理シミュレーションと評価ベンチマークを提供するOSS系ツールで、OpenUSDベースのシーン構築や学習ループ検証に利用します。

※1)データとLLMの関係は次のイメージです。

・Cosmos / GR00T N:NVIDIAが収集・生成した実世界+合成データが載る独自コンポーネント。

・Nemotron:LlamaファミリーをベースにNVIDIAオープンデータで再学習したLLMで、ロボットの自然言語I/Fやエージェント用途に利用可能。

※2)「オープン性」は次の三分割で整理します。

・コード:Isaac Sim / Lab など → Apache-2.0等のOSS。

・モデル重み:Cosmos / GR00T / Nemotron → Open Weights(NVIDIA独自ライセンス)。

・データ:ロボット向けPhysical AIデータセット → Open Dataset(用途・再配布に制約)。

細目は更新され得るため、公式ドキュメントとライセンスPDFを正として参照してください。

次章では、この章で潰した“落とし穴”を前提に、Contract→Gate→Opsを「止まらない接続」として疑似コードで組み立てます。

4. 実務テンプレ:Sim→学習→運用を回す「最小構成」

ここからは、各節の冒頭で「何のために何をしているか」を短く説明し、その後に15行程度の疑似コードを置きます。

コードはロジック理解が目的で、実行前提ではありません。

4.1. OpenUSD:センサー/ログ仕様を“契約(Contract)”として固定する

目的:Simと現場で「同じログを、同じ意味で」扱うために、センサー仕様とログ契約をOpenUSD側に埋め込みます。

こうしておくと、Isaac Simの出力も現場の出力も、同じキーで学習に戻せます。

OpenUSD(擬似)例:センサー定義をUSDに埋め込む

# PSEUDO: OpenUSDに「センサー契約」を埋め込む(Sim/現場の共通言語)

stage = NewUSD("factory_world.usd") # USDファイルを作る

robot = stage.prim("/World/RobotA") # ロボットのPrim(ノード)

contract = { # 契約:センサー仕様の辞書

"camera_front": {"fps":30, "res":[1280,720], "frame":"cam_f"},

"lidar_top": {"hz":10, "range_m":50, "frame":"lidar_t"},

"imu": {"hz":200, "frame":"imu"}

}

robot.meta["sensor_contract"] = contract # USDメタデータに固定

robot.meta["log_contract"] = ["t","pose","action","reward","fail_reason"] # ログ項目の契約

Save(stage) # Contractを“設計図”として保存

ここでの要点:「あとでログを整形する」では遅いです。最初に契約を固定すると、ループが止まりにくくなります。

4.2. Omniverse:同じ世界(USD)を共有し、検証と協業を回す

目的:OpenUSDの世界をチームで共有し、Simの条件(環境・センサー・ロボ構成)を「同一の設計図」として扱います。

これにより、実験条件の再現性が上がり、学習と評価の議論がブレません。

Omniverse(擬似)例:USDを読み込み、シミュ条件を“セッション”として固定

# PSEUDO: OmniverseでUSDを共有し、実験セッションを固定する

usd = LoadUSD("factory_world.usd") # 共通の設計図(Contract)

session = { # 実験条件(後で再現するための鍵)

"usd": usd.path, "seed": 42, "sim_fps": 120,

"domain_rand": {"friction":[0.6,1.2], "light":[0.7,1.3]}

}

PublishToOmniverse(session) # チームで共有(同一条件で検証)

Lock(session) # 条件を固定(議論のブレ防止)

print("SESSION_ID", Hash(session)) # 再現用IDを出す

ここでの要点:「誰がどの条件で回したか」をIDで追えるようにすると、Sim→学習→評価が運用になります。

4.3. Isaac Sim:大量試行で“成功も失敗も”ログ化し、学習材料にする

目的:Simで大量試行(rollout)を回し、成功だけでなく失敗理由(fail_reason)もログに残します。

失敗が構造化されるほど、次の学習が速くなります。

Isaac Sim(擬似)例:rolloutでログを吐き、失敗理由も残す

# PSEUDO: Isaac Simでrolloutし、Contract通りのログを作る

contract = ReadUSDMeta("factory_world.usd","log_contract") # ["t","pose","action","reward","fail_reason"]

runs = [] # ログ(学習燃料)を貯める箱

for ep in range(3): # 例:3エピソードだけ回す(本番は大量)

sim = NewSim(seed=ep) # 再現のためseedを固定

state = sim.reset() # 初期化

for t in range(5): # 例:5ステップ(本番は長い)

action = policy_stub(state) # いまは仮の方策(後で学習済みに置換)

next_state, reward, fail_reason = sim.step(action) # fail_reasonが重要(例:"collision" 等)

runs.append({"t":t,"pose":state.pose,"action":action,"reward":reward,"fail_reason":fail_reason})

state = next_state # 次へ

SaveJSONL("sim_rollouts_v3.jsonl", runs, contract=contract) # Contractに沿って保存

fail_reasonの意味:「何が原因で失敗したか」を機械が読める形で残す欄です。ここが空だと、改善ループが鈍ります。

4.4. Cosmos:環境バリエーション(揺らし)を供給し、Sim-to-Realを支援する

目的:現実はいつも“同じ条件”ではありません。Sim側で世界を揺らし(摩擦・照明・ノイズ・配置)、

ループが現場のばらつきに耐えるようにします。ここでは「揺らしのレシピ」をログとして残すのがポイントです。

Cosmos(擬似)例:揺らしレシピを生成し、Simに適用する

# PSEUDO: 世界を揺らすレシピ(domain randomization)を作って適用する

recipe = GenWorldRecipe( # ばらつきのレシピ(例)

friction=[0.5,1.3], light=[0.6,1.4],

sensor_noise={"camera":0.02, "lidar":0.01}

)

sim = NewSim(seed=7) # 再現用seed

sim.apply(recipe) # レシピをSim世界へ適用

runs = Rollout(sim, steps=5) # 少ステップだけ試行(例)

SaveJSON("world_recipe_v7.json", recipe) # 揺らし条件を保存(再現の鍵)

SaveJSONL("rollout_v7.jsonl", runs) # ログは学習燃料になる

ここでの要点:「揺らした」だけでは不足です。揺らし条件を保存して初めて、改善の議論が運用になります。

4.5. 学習→評価ゲート:合格したものだけ次工程へ(NG理由を返す)

目的:学習したモデルを“出しっぱなし”にせず、評価ゲートで合格したものだけを成果物(artifact)として保存し、

目的:学習したモデルを“出しっぱなし”にせず、評価ゲートで合格したものだけを成果物(artifact)として保存し、

配信(4.6)へ送ります。NGなら「どこがダメか(理由)」を返して再学習へ戻します。

学習→評価→合否判定(疑似):OKだけ保存、NGは理由を返す

# PSEUDO: train -> eval -> gate(疑似・ロジック理解が目的)

dataset = load("sim_rollouts_v3.jsonl") # 学習データ(Simログ)

gate = {"hard_stop_max":1, "intervene_max":0.03, "lat_p95_max":80, "success_min":0.92} # 合格ライン

model = train(dataset) # 学習(OSS基盤+最適化の“概念”)

m = eval_metrics(model) # KPI計測(安全/介入/遅延/成功率)

fail = [] # NG理由のリスト(どの条件で落ちたかを貯める箱)

if m["hard_stop"] > gate["hard_stop_max"]: fail.append("hard_stop") # 急停止が多い

if m["intervene"] > gate["intervene_max"]: fail.append("intervention") # 介入が多い

if m["lat_p95_ms"] > gate["lat_p95_max"]: fail.append("latency") # 遅延が悪い

if m["success"] < gate["success_min"]: fail.append("success") # 成功率が低い

if fail:

print("REJECT", fail, m) # NGなら理由+計測値を返して改善ループへ

else:

artifact = save(model, m) # OKならモデル+指標を成果物として保存(再現/監査用)

print("ACCEPT", artifact, m) # 次は配信(Serving)へ

ここでの要点:“落ちた理由”を返せると、改善が「根性」ではなく「工程」になります。これが運用OSの中核です。

4.6. Dynamo:推論を安定配信し、段階展開とロールバックで現場を止めない

目的:現場に出す段階でいちばん重要なのは、最初から100%展開しないことです。

まず小さく(canary)出し、監視し、問題があればすぐ戻す――この“止めない配信”が、現場ログを学習に戻す前提になります。

配信(擬似)例:canary→監視→OKなら拡大、NGならロールバック

# PSEUDO: serving with canary + monitor + rollback(運用OSの最小)

artifact = load_artifact("model_ok_v12") # 4.5で合格した成果物(モデル+指標)

deploy("canary", artifact, traffic=0.05) # 5%だけに段階展開(まず小さく)

ops = monitor(window_min=30) # 30分監視(遅延/介入/停止などを見る)

fail = [] # NG理由(運用側の異常)を貯める箱

if ops["error_rate"] > 0.01: fail.append("error_rate") # エラーが増えた

if ops["hard_stop"] > 0: fail.append("hard_stop") # 危険停止が出た

if ops["lat_p95_ms"] > 80: fail.append("latency") # 遅延が悪化した

if fail:

rollback(to="prev_stable") # すぐ戻す(現場を止めない)

print("ROLLBACK", fail, ops) # 理由を残して次の学習へ

else:

scale(traffic=1.0) # 全体へ拡大(安定したら)

print("PROMOTE", ops) # “安定版”として確定

ここでの要点:運用のfail(異常理由)が、次の学習の“教師”になります。これがSim↔Realの閉ループです。

4.7. 現場ログ→再学習:Realの経験をContractに沿って戻す

目的:現場で起きた例外(介入・停止・ヒヤリハット)を、OpenUSDで固定したContractに沿ってログ化し、

次のSim条件(揺らし)と学習データに戻します。ここが繋がると「改善が勝手に回る」状態に近づきます。

フィードバック(擬似)例:現場ログをContract形式で保存し、次の学習へ追加

# PSEUDO: real logs -> normalize -> append to training set

contract = ReadUSDMeta("factory_world.usd","log_contract") # ログ契約(Simと同じ)

real = read_telemetry("site_A_last_24h") # 現場テレメトリ(例:24h分)

norm = [] # Contractに合わせたログを作る箱

for e in sample(real, n=5): # 例:5件だけ整形(本番は大量)

norm.append({"t":e.t,"pose":e.pose,"action":e.action,

"reward":e.reward,"fail_reason":e.fail}) # キーをContractに合わせる

SaveJSONL("real_logs_siteA.jsonl", norm, contract=contract) # 形式統一して保存

Append("train_corpus.jsonl", norm) # 学習コーパスへ追記(次の学習へ)

ここでの要点:現場ログが“同じ形”で学習に戻ると、改善が属人化しにくくなります(=運用OS化)。

5. まとめ:エンジニアが今日決めるべきこと(最短チェックリスト)

- Contract(OpenUSD):センサー仕様、ログ項目、ID体系を“仕様”として固定したか

- 失敗の構造化:fail_reason を空欄にしていないか(学習が速くなる鍵)

- 評価ゲート:合否判定のKPI/閾値がコード化され、NG理由を返せるか

- 配信運用:canary→監視→ロールバックの手順が最初からあるか

- フィードバック:現場ログがContract形式で学習へ戻る経路があるか

結論:Physical AIの勝負は、モデルの賢さではなく「改善が止まらないループ設計」です。

ツールの採用より先に、Contract→Gate→Opsの3点を固定すると、PoCで止まりにくくなります。

よくある質問(FAQ)

Q1. なぜ「センサー契約(Contract)」を最初に固定するのですか?

A1. Simと現場でログの意味がズレると、学習に戻せずループが止まるからです。最初にContractを固定すると、後工程の整形コストが激減します。

Q2. fail_reason はなぜ重要ですか?

A2. 失敗が構造化されるほど、改善が「工程」になります。 fail_reason が空欄だと「何を直すべきか」が曖昧になり、学習速度が落ちます。

Q3. いちばんPoCで止まりやすいのはどこですか?

A3. 評価ゲートと配信運用(監視/ロールバック)がないことです。精度が良くても、現場で止まるとデータが戻らず改善が止まります。

専門用語まとめ(最小3つ)

- Contract(契約)

- センサー仕様・ログ項目・ID体系・評価KPIなどを「仕様として固定」し、Sim・学習・運用で同じ言葉を使うための設計。

- 評価ゲート(Gate)

- 学習したモデルを本番へ出す前に、KPIと閾値で合否判定し、NG理由を返して再学習へ戻す“安全弁”。

- Artifact(成果物)

- モデル本体だけでなく、学習条件・評価指標・バージョンを含む「再現・監査できる形」の出荷単位。

主な参考サイト

本記事は一次情報を軸に執筆しています。公式ドキュメント・標準化団体・一次データを優先し、外部リンクで検証可能性を担保します。

- NVIDIA Developer Blog(公式)

- OpenUSD(公式:標準化の入口)

- NVIDIA Omniverse Documentation(公式)

- NVIDIA Isaac Sim Documentation(公式)

- NVIDIA NeMo Documentation(公式)

合わせて読みたい

更新履歴

- 初稿公開