※本記事は継続的に「最新情報にアップデート、読者支援機能の強化」を実施しています(履歴は末尾参照)。

AIインフラ投資のナラティブ・シフト:2028年、96兆円市場の「物理的限界」を突破する覇者たち

この記事を読むと、AIインフラ投資について「何が争点で、どこまでが確度の高い事実か」が整理でき、2028年に向けた96兆円市場の投資戦略の策定ができます。

この記事の結論:

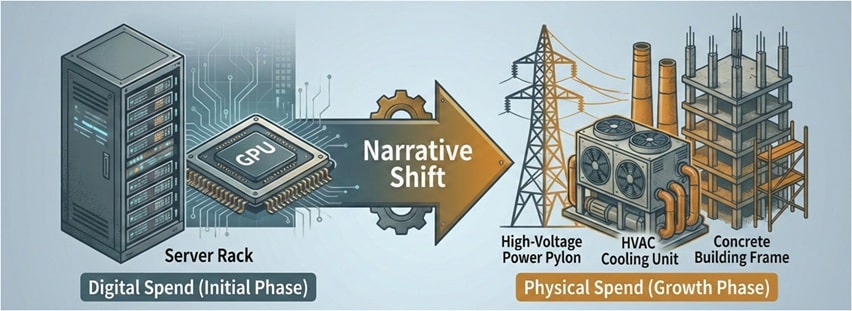

AI投資の勝負所は「エンジンの確保(GPU)」から「工場の稼働(電力・冷却・建屋)」という物理的実装力へ完全にシフトしました。

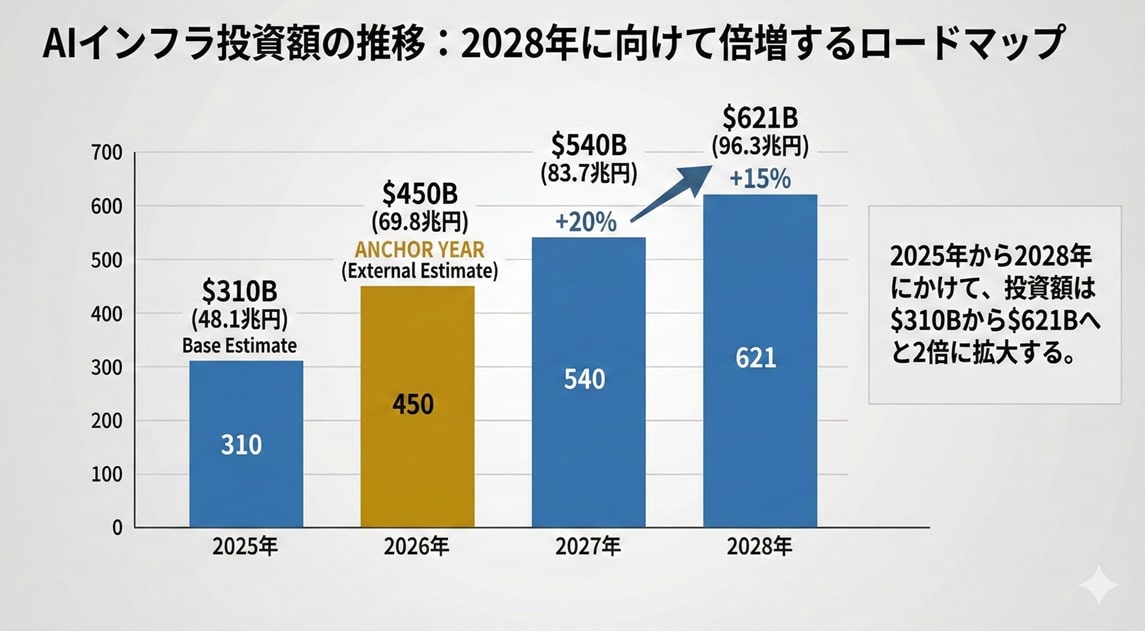

- 市場規模の劇的拡大:AIインフラCapExは2025年の3,100億ドルから、2028年には6,210億ドル(約96.3兆円)へと倍増する。

- System Multiplierによる逆算:GPU単体コストに対し、稼働に必要な周辺インフラ(電力・冷却等)を含めた総投資額を3.1〜5.8倍のレンジで捉える算定ロジックが不可欠。

- 物理的制約が「時間」を資源化:電力確保や建設リードタイムという物理的限界を突破し、稼働を前倒しできる主体が、実効的な計算資源で圧倒的な優位に立つ。

2026年1月、AIインフラの競争軸は明確に変質しています。わずか1年前まで、焦点は「いかにGPUを確保するか」に集約されていました。

ところが現在、現場で最も深刻なボトルネックはGPUの数量そのものではありません。戦場はシリコン上から、電力・冷却・土地・工期という物理世界へ移っています。

AIはデジタルな知能です。しかし、その知能を稼働させるには「器」が要ります。電力が流れ、熱が抜け、床が荷重に耐え、許認可を通した建屋が立ち、機器が搬入できる――その一連의物理条件が揃わなければ、どれほど高価なGPUも価値を生みません。

結果として、投資の主語は「GPUを買う」から「稼働を成立させる」へ移り、CapEx(設備投資)の中身が変わり始めています。

本稿は、投資議論で頻発する二重計上を避けるため、算定対象をAIインフラに対応するCapExへ寄せたうえで、2025年から2028年までの年次投資額を推定します。結論として、市場は2025年の3,100億ドルから、2028年には6,210億ドルへ拡大し、約2倍に達します。

第1章:投資額算定の算術 —— 二重計上を排除し、実体に寄せる

AIインフラ投資とは、GPUを単なる「部品」ではなく「巨大な計算工場」の起点として捉え、電力・冷却・建屋といった周辺インフラへの投資を含めたCapEx(設備投資額)の実体を指します。

1. なぜ「CapEx(設備投資額)」に限定するのか

AI投資のニュースで最も注意すべき落とし穴は「数字の重複」です。資本提携、利用料、設備投資が連鎖すると、同一価値が複数主体の発表に現れ、合算すれば市場が過大に見えてしまいます。

例えば企業Aが企業Bへ資金提供し、企業Bがクラウド事業者のサービスを購入し、クラウド事業者がGPUを購入した場合、発表を足し上げると「投資が増えた」ように見えます。しかし、物理資産として増えた実体は、GPUやデータセンター設備といったCapExに集約されます。

本稿は、物理インフラとして形成された増分に近い値を得るため、算定対象をAIインフラに対応するCapExへ限定します。

2. TSMCの生産能力から投資額を「逆算する手法」—— AIインフラの「幕の内弁当」理論

2026年の推定において採用するのが、供給側(TSMC)から投資額を逆算するアプローチです。需要サイドの計画合算ではなく、まず物理的に供給できる上限で市場規模を拘束します。これにより、過大推計(願望の足し算)を避け、供給制約を前提に年次の筋を立てられます。

この考え方を「お弁当」に例えるなら、チップ製造からAI稼働までのプロセスは、次の3つの要素によって律速(制限)される「幕の内弁当セット」のような構造をしています。

- お米(ウエハ): 半導体の原材料となるウエハ投入量です。これが供給できる「ごはん」の総量を規定します。

- お弁当箱(先端パッケージング / CoWoS等): どんなにお米(ウエハ)があっても、それを詰める「弁当箱」が足りなければ商品として出荷できません。現在、物理的な出荷上限を決めている最大の要因はこの「箱」の不足です。

- おかず・お箸・お茶(周辺インフラ): お米と箱(GPU)が揃っても、それだけでは食事は成立しません。サーバー筐体、ネットワーク、そして電力を供給する配電設備や熱を逃がす冷却装置という「おかずや飲み物」が揃って初めて、AIは実稼働します。

さらに、これらを広げて食べるための「テーブル(データセンター施設)」がなければ、どれほど豪華なお弁当も価値を生みません。供給側から投資額を推定する概念モデルは次の通りです。

![]()

ここで重要なのは、GPUという「箱」を推定しただけでは、実体としての「AIインフラ投資」にはならない点です。GPUは稼働の起点に過ぎず、それを食事として成立させるための周辺投資(おかずやテーブル)が必ず伴います。そこで登場するのが、次節で詳述するSystem Multiplier(システム・マルチプライヤー)です。

3. 解説:System Multiplier(システム・マルチプライヤー)とは何か?

GPUを買うだけではAIは動きません。System Multiplier(システム・マルチプライヤー)とは、言わば「チップという部品」を「巨大な計算工場」へと拡張し、稼働させるための魔法の換算係数です。

想像してみてください。1億円分の最新GPUを調達したとしても、それを載せるサーバー筐体、超高速でデータをやり取りするネットワーク、そして何より膨大な電力を供給する受電設備や、発生する熱を冷やす液冷システム、これらを収める頑強な建屋がなければ、GPUはただのシリコンの塊です。

具体的には、GPUコストを「1.0」とした場合、周辺投資の比率は以下のように積み上がります。

| 投資レイヤー | GPU=1.0とした相対比率 | 代表的な費目 |

|---|---|---|

| GPU (起点) | 1.0 | アクセラレータ(AIチップ) |

| Compute | 0.4~0.8 | サーバー筐体、CPU、DRAM、SSD |

| Network | 0.3~0.8 | スイッチ、光学、配線(学習クラスタで上振れ) |

| Electrical | 0.3~0.7 | UPS、配電盤、ラックPDU、変圧器 |

| Mechanical | 0.3~0.8 | 液冷設備(DLC)、CDU、配管、熱交換器 |

| Facility | 0.8~2.2 | 建設、受電設備、造成・用地、接続工事 |

| 合計レンジ | 3.1倍 〜 5.8倍 | |

この比率を合算すると、GPU=1.0に対して総投資額は概ね3.1〜5.8倍という巨大なレンジになります。本稿ではこの関係を以下の数式で定義します。

![]()

本稿の予測モデルは、この「物理的な必然性」に基づいています。供給元(TSMC)の生産能力から「GPUの総額」を割り出し、そこにこのMultiplierを掛け合わせることで、願望に基づいた積み上げではない、物理的限界から逆算した「逃げようのない市場規模」を導き出しているのです。

第2章:2025年〜2028年 AIインフラ投資予測の全貌

本章では、2025年から2028年までのAIインフラ投資額を年次で整理し、各年の数値がどの算定基準に基づくかを明確にする。結論として、投資額は2025年の3,100億ドルから、2028年には6,210億ドルへ拡大し、約2倍の規模に達する。

年度別の算定基準と予測値

本稿の年次推定は、(1)2025年は実績値ベース、(2)2026年は供給側(TSMC)からの逆算でアンカー固定、(3)2027年は物理制約(電力・受電・建設)を織り込み、(4)2028年は推論需要の増大を織り込む、という4段階のロジックで構成する。円換算は比較の一貫性のため1ドル=155円(固定)で算出する。

2025年:Base Estimate(年初来9か月実績+4Q推定による年次化)

2025年のBase Estimate($310B)は、対象各社の年初来9か月(3Qまで)のCapEx実績を合算し、残る4Q分はガイダンスおよび市場コンセンサスを用いて推定し、年次値として算出した推定である。

2025 Base Estimate = Σ(各社 2025年 1Q〜3Q CapEx実績)+ Σ(各社 2025年 4Q CapEx推定)

本稿執筆時点(2026年1月27日)では、暦年ベースの主要社(例:Meta/Alphabet/Amazon)の2025年4Q(通年)決算は未公表であり、各社の決算発表によって4Q推定は確定値に置き換わる。

- Meta:2026年1月28日に2025年4Q/通年の発表予定

- Alphabet:2026年2月4日に2025年4Q/通年の発表予定

- Amazon:2026年2月5日に2025年4Q/通年の発表予定

なおMicrosoftは会計年度が暦年と異なるため(FY表記)、本稿では各社の比較が可能となるよう、「当該期間に対応する直近四半期のCapEx実績(またはガイダンス)」へ揃えたうえで集計している。

2026年:ANCHOR YEAR(TSMC逆算推定により固定)

2026年は、供給側(TSMC)から推定されるAI GPU供給の上限を起点に、投資総額を逆算して固定するアンカー年である。手順は、(1)ウエハ投入量・歩留まり・先端パッケージング能力(例:CoWoS)から供給可能なGPU総量を推定し、(2)平均販売単価(ASP)によりGPU出荷総額を推定し、(3)第1章で定義したSystem Multiplier(GPUを含む総投資倍率)により、周辺投資(電力・冷却・建屋)まで含むAIインフラCapExへ拡張する、という流れで構成する。

2026年(アンカー固定)= 推定GPU出荷総額 × System Multiplier = $450B

2027年:物理制約(電力・受電・建設リードタイム)を織り込む

2027年は、GPU供給だけではなく、電力・受電工事・建設リードタイムが投資の主戦場になる局面として扱う。この局面では、投資の伸びは需要の限界ではなく、物理的な供給制約(送電・変電・用地・設備工事)によって規定される。本稿ではこの制約要因を織り込み、2026年に対して+20%の増加率を適用する。

2027年 = 2026年 × 1.20 = 450 × 1.20 = $540B

2028年:推論需要の増大(利用頻度に比例する追加稼働)を織り込む

2028年は、学習(トレーニング)に加え、推論(インファレンス)が恒常稼働として積み上がる局面として扱う。モデル利用頻度の増大は、推論向けのサーバ台数・電力消費・冷却負荷として設備側に転写されやすく、投資額は利用の増加に伴い段階的ではなくリニアに増加しうる。本稿ではこの要因を織り込み、2027年に対して+15%の増加率を適用する。

2028年 = 2027年 × 1.15 = 540 × 1.15 = $621B

結論:AIインフラ投資は2025年の3,100億ドルから2028年には6,210億ドルへと、物理的な供給制約の中で拡大し続けます。

| 年度 | 予測額(ドル) | 予測額(日本円) | 算定基準・根拠(検算式) |

|---|---|---|---|

| 2025年 | $310B | 48.1兆円 | Base Estimate(年初来9か月実績+4Q推定) |

| 2026年 | $450B | 69.8兆円 | ANCHOR YEAR(TSMC逆算推定で固定) |

| 2027年 | $540B | 83.7兆円 | 物理制約を織り込み:450×1.20 |

| 2028年 | $621B | 96.3兆円 | 推論需要の増大を織り込み:540×1.15 |

伸び率が2025年の前年比70%増から徐々に鈍化して見えるのは、需要の減退ではなく、供給側(電力・受電・建設)の上限により投資配分の主戦場が「GPUの買い増し」から「物理インフラの拡張」へ移るためである。

第3章:インフラ投資のナラティブシフト —— デジタルから物理へ

1. 「計算資源(GPU)」から「物理制約(電力・冷却・土地)」へ

GPUは、供給制約の強い資源である一方で、調達できたとしても稼働させるための環境が整わなければ価値を生みません。現在の制約は、GPUを置く「器」そのもの——すなわちデータセンターの物理インフラへ集中しています。

- 電力(受電・系統連系):

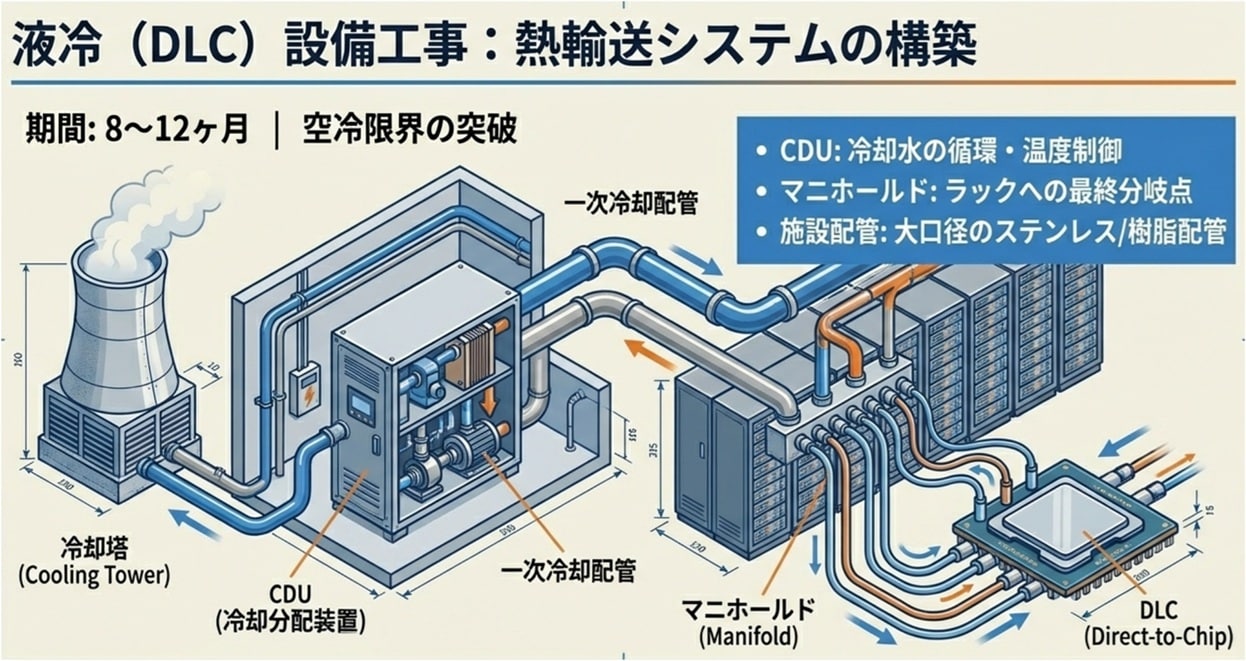

大規模データセンターでは、受電容量の確保、送配電設備の増強、変電設備の設置、系統連系の調整が必要になります。これは設備調達だけでなく、自治体・電力会社・系統運用者との調整を伴い、計画から稼働までに長いリードタイムを要します。 - 冷却(熱設計・水・機械設備):

高密度GPUクラスタは発熱密度が高く、従来型の空冷前提の設備設計では限界が生じます。液冷(DLC)やCDU、配管、熱交換といった機械設備が“標準装備”になりつつあり、投資の重心が移動します。 - 土地・建物(床荷重・建設工期・許認可):

高密度ラックは床荷重、天井高、配線経路、冷却導線、耐震・防火といった要件を強く規定します。既存建屋の転用には限界があり、新設・増築・大規模改修が不可避になります。

2. 物理制約時代の投資構造 —— 「GPUを買う」から「稼働を成立させる」へ

投資の中身は、GPU購入の比率が低下するというより、GPUを稼働可能にする周辺投資が相対的に増える方向へ変化します。第1章で定義したSystem Multiplierの中でも、とくにElectrical(配電・UPS)/Mechanical(冷却)/Facility(建屋・受電・用地)の比重が上がる局面です。

結論:AIインフラ投資の競争優位は「GPUの確保」から「電力と工期を短縮する実行力」へと移っています。

| 投資要素 | 従来(GPU律速期) | 現在(物理制約期) |

|---|---|---|

| 主要制約 | チップ供給、調達 | 受電、冷却、建設工期、用地 |

| 投資の中心 | Compute(GPU/サーバ) | Electrical/Mechanical/Facility(電力・冷却・建屋) |

| 競争優位 | GPUの確保能力 | 電力と工期を短縮する資本力・交渉力・実行力 |

3. 「時間」が資源化する —— 受電・建設リードタイムの経済学

物理制約期において最も希少なものは、GPUそのものではなく、稼働までの時間です。同じ設備投資でも、稼働が1年遅れれば、その間に発生する推論需要・サービス収益・学習効率の差は致命的になります。

したがって、ハイパースケーラーの投資競争は、単なる「投資額の多寡」から、稼働までの時間を短縮する能力へと再定義されます。この文脈で、電力調達(PPA/直接契約)、用地確保、建設パイプライン、機器調達網の優劣が、投資効率を左右します。

4. 第2章(年次予測)との接続 —— 伸び率の鈍化は需要減ではない

第2章で示した2027年(+20%)および2028年(+15%)という伸び率は、需要の衰退を意味しません。むしろ、投資の上限が“供給側(電力・受電・建設)”で決まる局面に入ったことを反映しています。

GPUの供給が拡大しても、受電・冷却・建屋が追いつかなければ稼働が成立しません。この制約構造こそが、AIインフラ投資のナラティブが「デジタル」から「物理」へ移行した本質です。

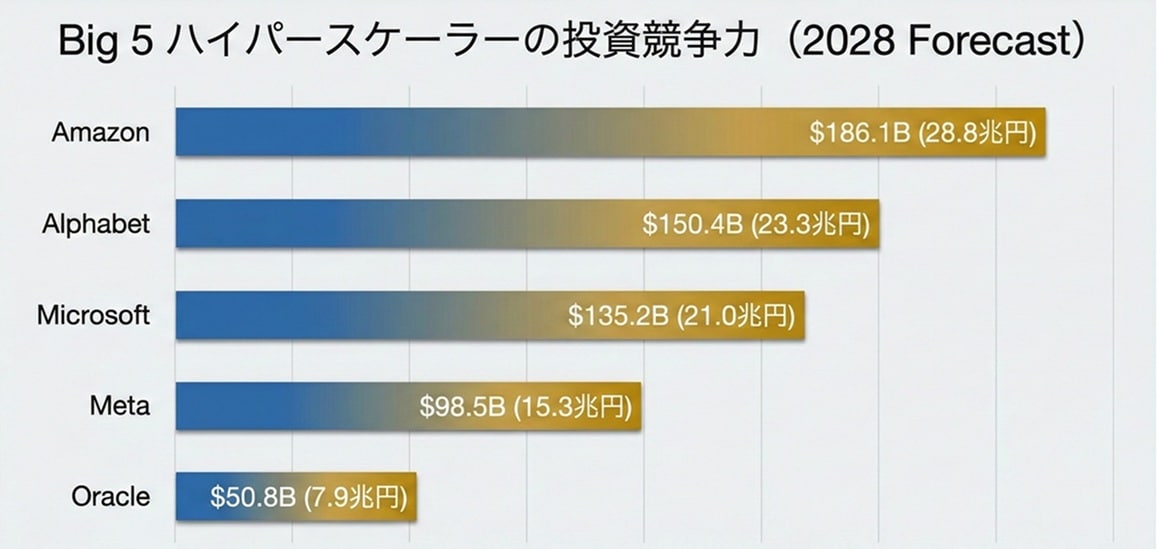

第4章:Big 5 ハイパースケーラーの投資競争力(2028 Forecast)

2028年時点の投資競争は、資本の多寡だけでなく「稼働の前倒し能力」を巡る競争になります。電力・用地・施工能力を押さえた企業ほど、同じ投資額でも実効稼働量を伸ばせます。ここでは2028年の企業別投資の読み方を整理します。

1. Amazonの規模と総投資の逆算

本稿では、Amazonの2028年AIインフラ投資を1,861億ドル(約28.8兆円)として扱います。ここで重要なのは、数値が要求する総投資規模を算術で把握できる形にすることです。

CreditSightsは、Big5ハイパースケーラーの2026年CapEx(約$602B)のうち、約75%(約$450B)がAIインフラ向けで、残りは従来クラウドや他事業向けと推定しています。

この「AI比率:約75%」を、便宜上2028年の逆算にも適用すると、Amazonの総DC投資は次式で復元できます(比率は将来変動し得ます)。

総DC投資(推定)= AI投資 ÷ 0.75 = 1,861億ドル ÷ 0.75 = 約2,481億ドル

この計算が示すのは感想ではなく、AI比率が75%近辺で推移する場合に、総投資がどれほどの規模を要求するかという条件です。読者が前提(比率)を差し替えて再計算できる形にしておくことで、議論が崩れにくくなります。

2. トップティアの共通項 —— 「投資額」ではなく「稼働量」を最大化できる

Alphabet、Microsoft、Amazonなど上位企業の強みは、GPUを多く買えることだけではありません。同じCapExでも、より早く稼働させ、より高い稼働率で回し続けられる点にあります。

AIインフラでは、GPUを調達しても、受電・冷却・建設・ネットワークが揃わなければ稼働しません。物理制約期に入ると、投資の成果は「購入額」ではなく、実際に立ち上がった計算能力(稼働量)で決まります。

上位企業が押さえているのは、次のような“稼働を前倒しする要素”です。

- 電力(受電枠・系統連系・変電設備): 最終的に稼働時期を決めるボトルネック

- 用地と建設パイプライン: 施工枠・設計テンプレ・許認可の蓄積で工期を圧縮

- ネットワーク調達: 光トランシーバや配線・スイッチなど不足しがちな部材を先回りして確保

- 冷却方式の実装力: 液冷対応を前提に設計・調達・施工を一体で回す

結果として、物理制約期では、同じ投資額でも「稼働開始が早い」「止まらない」「増設が早い」企業の方が、実効的な計算資源を大きくできます。これが投資効率(1ドルあたりの稼働計算能力)を左右します。

3. 「時間」を買う —— SBGのDigitalBridge買収が意味するもの

ソフトバンクグループ(SBG)はDigitalBridge Group, Inc.を買収するためのdefinitive agreement(最終契約)を公表しています。SBGの発表では、次世代AIサービスを大規模に展開するための基盤インフラ(データセンター等)を、より強く「構築・拡張・資金調達」できる体制を狙うと説明しています。

(出典:SoftBank Group Press Release)

取引条件として、SBGはDigitalBridgeの普通株式を1株あたり16.00ドル(現金)で取得し、取引完了は2026年後半(規制当局承認などの条件付き)とされています。

(出典:DigitalBridge Press Release)

この買収を物理制約期の競争軸で見ると、価値は話題性ではありません。運用中アセット、開発パイプライン、投資運用能力、案件組成・資金調達の実務といった「稼働を前倒しする実装能力」を取り込めるほど、受電・用地・建設・調達をゼロから積み上げる場合と比べて、稼働までの時間を短縮できる可能性が高まります。

第5章:物理の壁を突破する戦略オプション

物理制約期の本質は「GPUがあっても動かない」ことにあります。したがって突破策は、電力・冷却・工期という制約項を直接動かす方向へ向かいます。ここでは代表的なオプションを整理します。

1. 電力の確保

大規模AIは電力を「公共サービス」ではなく「戦略資源」として扱い始めています。長期電力購入契約(PPA)、発電アセットとの直接契約、特定地域での増強投資など、供給の確実性を上げる方向が現実的な選択肢になります。

Metaに関しては、5〜6GW級の電力確保という文脈で語られることがありますが、数字を扱う際は、何を指すのか(単一サイト、複数サイト合算、契約容量、ピーク/平均)を切り分けて記述する必要があります。いずれにせよ、電力は「足りないなら待てる」資源ではないため、企業行動はより直接的になっていきます。

2. 立地と工期

用地確保、許認可、施工能力の確保は、投資額と同等かそれ以上に重要な差分を生みます。工期が短いほど、同じCapExでも稼働量が増え、実効ROIは上がります。物理制約期の覇者は、資金の量だけでなく、実装速度を武器にします。

3. 実装の優先順位

新概念は可能性として魅力がありますが、投資競争の中心にあるのは、電力・冷却・建設を現実に回す実装力です。したがって本文では、投資の中心がどこに移っているか(Electrical/Mechanical/Facilityの比重)を押さえることが重要になります。

第6章:冷却革命 —— 液冷がデータセンターの前提を変える

1. チラーレスと温度設計

冷却は、除熱量と温度差に依存します。設計温度の考え方が変われば、必要設備も変わります。

![]()

液冷では、熱を「空気に渡す」よりも「水(冷媒)で運ぶ」方が効率的になり得ます。結果として、チラー設備、配管、熱交換器、CDU、ラジエーターなどの構成が投資の中心に入り、MechanicalとFacilityの重要度が上がります。

2. 投資配分の変化

冷却は、運用費(Opex)だけでなく、設備投資(CapEx)にも影響します。高密度化が進むほど、配電・冷却・建屋の設計難度が上がり、工事・受電・設備の制約が強くなります。これが、投資ナラティブを「GPU」から「物理」へ押し出す力になっています。

エピローグ:知能の器としての「物理インフラ」

AIインフラ投資の本質は、知能を動かす「器」を現実世界に実装することにあります。GPU確保の時代は終わりつつあり、次の競争は電力を通わせ、冷却で熱を制御し、建設で稼働を前倒しできるかに移りました。

2028年へ向かう96兆円市場は、投資額の多寡ではなく、物理制約を突破する実装能力を選別します。覇者は、デジタルの速度を、現実世界の制約の中で成立させた主体です。

付:算定前提・定義(Appendix)

付-1. 「AIインフラCapEx」の範囲

- 対象(含む):AIサーバ(GPU/AIチップ含む)、ホスト側、ネットワーク、配電/UPS、冷却設備、建屋・受電設備・造成等

- 非対象(原則含めない):持分投資、研究開発費(Opex)、クラウド利用料、ソフトウェア購読料等

付-2. 二重計上の回避

資本提携・利用料・設備投資が連鎖する場合、同一価値が複数主体で計上されます。本稿はCapExへ寄せ、物理資産形成の実体に近い値を採用します。

付-3. 年次推定の要点

- 2025:年初来9か月実績+4Q推定で年次化(Base Estimate)

- 2026:供給側(TSMC)逆算でアンカー固定(GPU供給総額×System Multiplier)

- 2027:物理制約(電力・受電・建設)を増加率へ反映(+20%)

- 2028:推論需要の増大を増加率へ反映(+15%)

専門用語まとめ

- System Multiplier

- GPU単体コストから、稼働に必要な周辺インフラ(電力・冷却・建屋等)を含めた総投資額を算出するための換算係数。概ね3.1〜5.8倍のレンジとなる。

- CoWoS

- TSMCが提供する先端パッケージング技術。高性能AIチップ供給の物理的なボトルネックとなる。

- 液冷(DLC)

- Direct Liquid Cooling。冷媒を直接熱源に当てる冷却方式。高密度GPUクラスタの標準になりつつある。

- PPA

- 電力購入契約。発電事業者から長期にわたり直接電力を購入し、安定稼働と再エネ比率を確保する手法。

- CapEx

- 設備投資。物理資産(建物、設備、機器)の取得・拡張・維持のために投じられる資金。AIインフラの実体把握の主要指標。

- TSMC逆算モデル

- 供給側(半導体製造)の生産能力上限から、最終的なインフラ投資規模を逆算する推定手法。

- ハイパースケーラー

- Amazon、Google、Microsoftなどの大規模クラウド・インターネットサービス事業者。AIインフラ投資の主要プレイヤー。

よくある質問(FAQ)

Q1. なぜ投資額を「CapEx」のみで算出するのですか?

A1. 資本提携や利用料などの「数字の重複」を排除し、物理的な資産形成の実態に最も近い値を抽出するためです。

Q2. System Multiplierは将来的にどう変化しますか?

A2. 高密度GPUへの対応で冷却(Mechanical)や電力(Electrical)の難度が上がるため、Multiplierは上昇傾向にあります。

Q3. 2027年以降の伸び率鈍化は、需要が減るからですか?

A3. いいえ。受電容量や建設工期といった「供給側の物理的上限」によって投資ペースが規定されるためです。

Q4. SBGによるDigitalBridge買収の最大のメリットは何ですか?

A4. 既存の運用アセットやパイプラインを取り込み、インフラ稼働までの時間をゼロから構築するよりも大幅に短縮できる点です。

Q5. 推論需要の増大がなぜ投資額をリニアに押し上げるのですか?

A5. 利用頻度に比例してサーバー台数、電力消費、冷却負荷が増加し、それが設備投資に直接反映されるためです。

まとめ

AIインフラ市場は、2028年に向けて96兆円規模へと拡大し続けますが、その競争の舞台はシリコンから電力・冷却・建屋という「物理」へと移りました。もはやGPUを買うことだけが優位性ではなく、物理的な制約を突破し、いかに早く稼働を立ち上げられるかが、AI時代の投資勝者を決定づけます。

CxO向け

- 投資のボトルネックはGPU調達から「電力・工期・土地」へ移りました。物理的なインフラ実装能力を経営戦略の核に据えてください。

開発統括/リード向け

- 計算資源の確保を「調達」だけでなく、受電リードタイムを考慮した「中長期的な実装パイプライン」として管理してください。

実装担当向け

- 液冷対応や高密度ラック設計など、物理設備側の要件が稼働開始日(クリティカルパス)を決定付けることを意識した設計が必要です。

落とし穴(1行):GPU購入額だけを追っていると、受電待ちで稼働しない「死蔵資産」のリスクと機会損失を見落とします。

今日のお持ち帰り3ポイント

- AIインフラ市場は2028年に96兆円規模に達するが、成長は物理的供給力に律速される。

- 「GPU確保」の時代は終わり、「電力・冷却・工期」を前倒しする実装競争が始まった。

- 同じ1ドルの投資でも、稼働までのリードタイムを短縮できる主体が、実効計算資源で圧倒する。

主な参考サイト

本記事は一次情報を軸に執筆しています。公式発表・仕様・標準化団体・論文を優先し、検証可能性を担保します。

- CreditSights: Technology: Hyperscaler Capex 2026 Estimates (2025)

- SoftBank Group: Press Release (2025)

- DigitalBridge: Press Release (2025)

- TSMC 2025Q3 Earnings Call Transcript (2025)

- Meta/Alphabet 2025Q3 Financial Results (2025)

合わせて読みたい

- AIインフラ市場2025最新|NVIDIA独占に挑む各社戦略

- AIインフラ戦争2025|NVIDIA×OpenAI・45兆円契約の全貌

- ソフトバンク×DigitalBridge買収 AIインフラ覇権と20.9GW電力の真実

- AIネットワーク三層|NVLink・InfiniBand・Ethernet/Spectrum-X〖2025〗

- NVIDIA CES基調講演分析:AI新時代を定義するプラットフォーム、物理AI、そして「Vera Rubin」

更新履歴

- 初版公開