この記事を読むと生成AIがロボットの何をどう変えるのかがわかり、ビジネスにおける「次世代の自動化」の姿を具体的に掴めるようになります。

執筆者からひと言

こんにちは。30年以上にわたるITエンジニアとしての現場経験を基に、AIのような複雑なテーマについて「正確な情報を、誰にでも分かりやすく」解説することを信条としています。この記事が、皆さまのビジネスや学習における「次の一歩」のヒントになれば幸いです。

生成AIがロボットにもたらす「知性の革命」

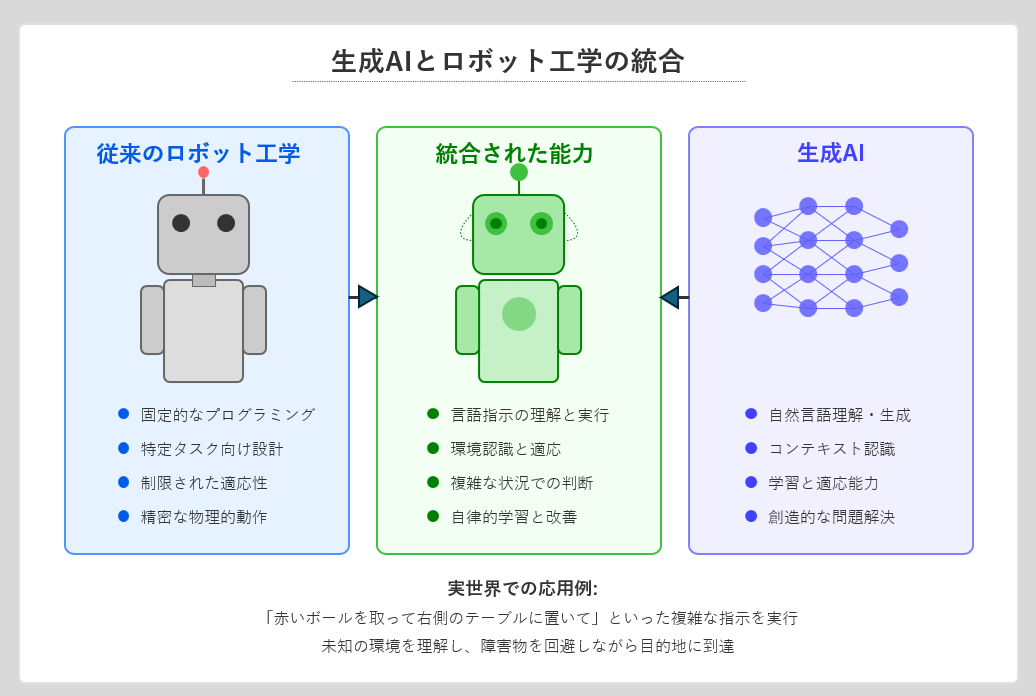

生成AIは、ロボットに「状況を理解し、未知の課題を解決する能力」を与えます。これは、プログラムされた動きを繰り返すだけの機械から、自律的に思考・行動する「真のパートナー」への質的な大転換です。

従来の産業用ロボットは、決められた動作を高速かつ正確に繰り返すことに長けていました。しかし、それは裏を返せば「指示されたことしかできない」ということ。少しでも環境が変わったり、予期せぬ事態が起きたりすると、途端に機能不全に陥ります。しかし、生成AI、特に大規模言語モデル(LLM)や視覚言語モデル(VLM)の登場が、この前提を根底から覆しました。ロボットは今や、人間の言葉を理解し、目で見たものを解釈し、自ら「考えて」動く能力を手に入れようとしているのです。

👨🏫 かみ砕きポイント

「料理」に例えると違いは明確です。従来のロボットは「塩を3g入れ、10回混ぜる」という詳細なレシピ通りにしか動けません。一方、生成AIロボットは「冷蔵庫にあるもので、何か健康的なものを作って」という曖昧なリクエストに応えられます。冷蔵庫の中身を見て(視覚)、メニューを考案し(思考)、調理を実行する(行動)。これが「知性の革命」です。

革命の心臓部 – GoogleとNVIDIAの最新技術

この革命は、Googleの「RT-2」やNVIDIAの「Cosmos」といった具体的な技術によって牽引されています。これらのモデルが、どのようにしてロボットに知性を与えているのか、その仕組みの核心に迫ります。

Google DeepMind RT-2:Webの知識で世界を動かす

Google DeepMindが開発したRT-2(Robotic Transformer 2)は、「Web上の膨大な知識を使って、現実世界のタスクをこなす」という壮大な問いへの答えです。このモデルの核心は、Web上のテキストと画像を学習した「視覚言語行動(VLA)モデル」にあります。これにより、ロボットは「見る」「話す」そして「行動する」を一つのモデルで繋げられるようになりました。RT-2の真価は、一度も教えられていないタスクさえ実行できる「ゼロショット学習」能力にあります。「ゴミを拾って」という抽象的な指示で、AIが「ゴミ」という概念を理解し、空き缶を認識してゴミ箱へ捨てる動作を自律的に生成した事例は、ロボットが「推論」を始めたことを示す象徴的な成果です。

NVIDIA Cosmos:ロボットのための汎用基盤モデル

NVIDIAが提唱する「Cosmos」は、「ロボット版ChatGPT」とも言える、多様なロボットに適用可能な汎用基盤モデルです。特定のロボットやタスクに依存せず、言語指示と物理的な操作を結びつける汎用的な「脳」を提供することを目指しています。例えば「この部品をワークステーションに運んで」という指示に対し、Cosmosは視覚情報から対象物を識別し、安全な経路を計画し、適切な把持方法を判断して実行します。NVIDIAの強みであるシミュレーション技術(Isaac Simなど)と連携し、仮想空間で膨大な訓練を積むことで、現実世界での適応能力を高めている点が特徴です。

Key Takeaways(持ち帰りポイント)

- 生成AIロボット研究の最前線は、単一タスクの自動化から、あらゆるタスクに応用可能な「汎用知能」の開発へとシフトしている。

- GoogleはWebの知識、NVIDIAはシミュレーションと、各社のアプローチは異なるが、「言語・視覚・行動」の統合というゴールは共通している。

- これらの基盤モデルの登場により、企業はロボットごとにAIを開発する手間から解放され、AIの導入が加速する可能性がある。

フィジカルAIロボットの初級サンプルコード解説

本章では、フィジカルAIの動作原理を簡単なPython風コードで解説します。このコードは実際のロボットを動かすものではなく、フィジカルAIの基本的な考え方を示す概念モデルです。

class PhysicalAIRobot:

def __init__(self, name):

self.name = name

self.knowledge_base = {

"objects": {

"bottle": {"position": (5, 1), "properties": ["recyclable"]},

},

"locations": {

"recycle_bin": [(8, 8)],

}

}

def process_command(self, command_text):

"""自然言語コマンドを処理し実行可能なアクションに変換"""

# 実際はLLMが担当する複雑な自然言語理解

intent = self._understand_intent(command_text)

# 意図に基づいたアクションプランの生成

action_plan = self._generate_action_plan(intent)

# アクションプランの実行

return self._execute_action_plan(action_plan)

def _understand_intent(self, text):

# 簡易的な意図理解

if "bottle" in text and "recycle" in text:

return {"task": "recycle", "object": "bottle"}

return None

def _generate_action_plan(self, intent):

if not intent:

return None

# "ボトルをリサイクルして"という指示から生成されるアクションプラン例

return {

"steps": [

{"action": "move_to", "target": "bottle"},

{"action": "pick_up", "object": "bottle"},

{"action": "move_to", "target": "recycle_bin"},

{"action": "place", "object": "bottle"},

{"action": "report_success", "message": "ボトルをリサイクルしました"}

]

}

def _execute_action_plan(self, plan):

if not plan:

return "指示を理解できませんでした。"

for step in plan['steps']:

print(f"実行中: {step['action']}, 対象: {step.get('target') or step.get('object')}")

return plan['steps'][-1]['message']

# 実行例

robot = PhysicalAIRobot("Assistant")

result = robot.process_command("ボトルをリサイクルして")

print(result)

このコードは、ロボットが「ボトルをリサイクルして」という自然言語の指示を受け、それを「ボトルの場所へ移動 → 掴む → ゴミ箱へ移動 → 置く」という具体的な行動計画に分解し、実行する流れを模擬しています。実際のフィジカルAIでは、この各ステップがより高度な認識・判断技術によって支えられています。

ビジネスはどう変わる?- 次世代の自動化が拓く3つの領域

生成AIロボットの登場は、ビジネスの現場を根底から変えます。「製造」「物流」「サービス」の3つの領域で、具体的にどのような変革が起こり、どのような新しい価値が生まれるのかを予測します。

製造業:変種変量生産への完全対応

従来は困難だった少量多品種の生産ライン(変種変量生産)において、生成AIロボットは絶大な効果を発揮します。製品ごとにプログラムを書き換える「ティーチング」作業が不要になり、新しい製品の設計図を読み込ませるだけで、ロボットが自ら組み立て手順を理解し、作業を開始します。これにより、マスカスタマイゼーションが現実的なコストで実現可能になります。

物流業:予測不能な事態に動じない倉庫

物流倉庫では、日々さまざまな形状や大きさの荷物が扱われます。生成AIロボットは、荷崩れやイレギュラーな形状の荷物といった予測不能な事態に直面しても、状況を判断して最適なピッキングや梱包方法を自ら編み出します。これにより、倉庫全体の自動化率が飛躍的に向上し、人手不足の解消とリードタイムの短縮に貢献します。

サービス業:人間に寄り添うパーソナルアシスタント

最も大きな変革が期待されるのがサービス業です。高齢者介護施設での食事や移動の介助、店舗での複雑な問い合わせ対応や商品提案など、状況に応じた細やかなコミュニケーションと物理的な作業が求められる場面で、生成AIロボットは「人間に寄り添う」アシスタントとして活躍します。人間とロボットの協働が、新たなサービス価値を生み出すでしょう。

将来展望:フィジカルAIの進化ロードマップ

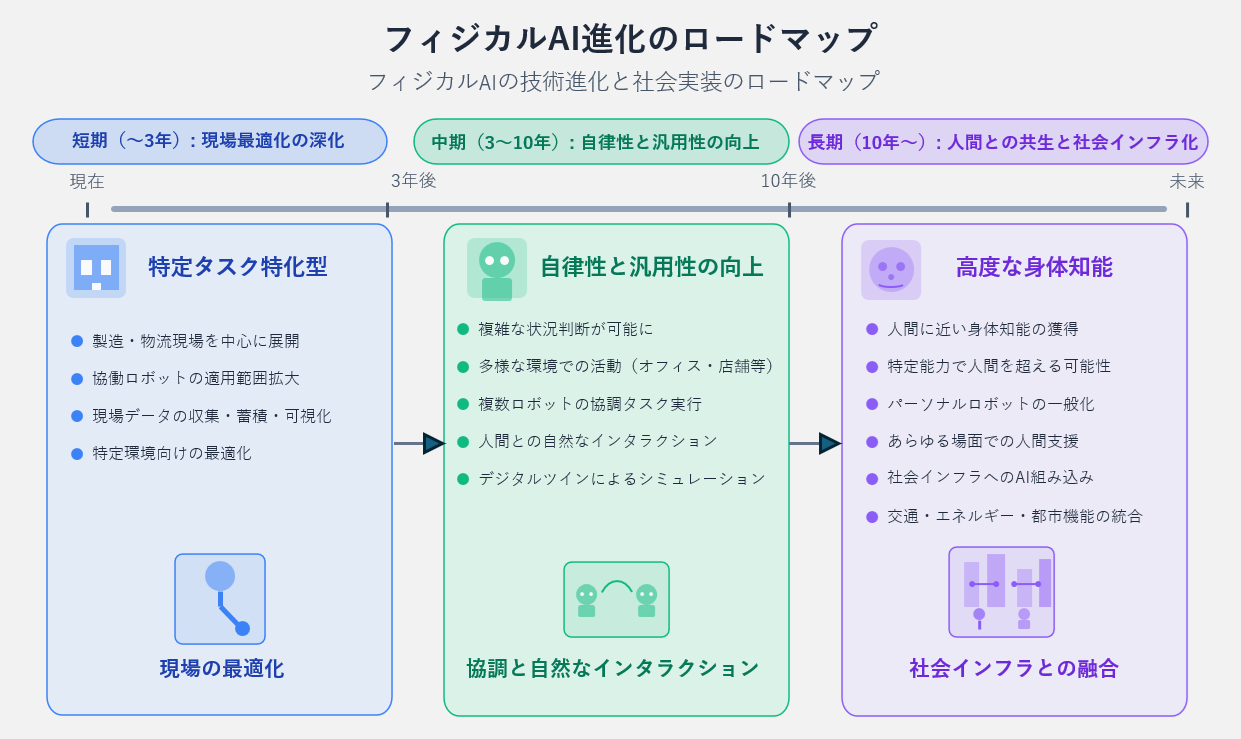

本章では、フィジカルAIが描く未来の進化図を短期〜長期で展望します。技術の進化と社会実装は段階的に進んでいくと考えられます。

- 短期(~3年): 現場最適化の深化

現在は、製造・物流といった特定の産業現場を中心に、特定タスク特化型のAI・ロボット導入が進むフェーズです。協働ロボットの適用範囲も広がります。ここでは、現場データの収集・蓄積・可視化による**「現場の最適化」**が主要テーマとなります。 - 中期(3~10年): 自律性と汎用性の向上

次のフェーズでは、AIの自律性と汎用性が向上し、より複雑な状況判断や多様な環境(オフィス、店舗、屋外等)での活動が可能になります。複数のロボットが協調してタスクを実行し、人間との自然なインタラクションも進化するでしょう。 - 長期(10年~): 人間との共生と社会インフラ化

長期的には、人間に近い、あるいは特定の能力で人間を超える身体知能を持つAIロボットが登場する可能性があります。あらゆる場面で人間を支援するパーソナルロボットが普及し、交通や都市機能といった社会インフラそのものにAIが組み込まれていく未来が想定されます。

まとめ

生成AIとロボットの融合は、単なる作業の効率化ではありません。それは、機械を「プログラムされた通りに動く道具」から、「自ら考え、未知の課題を解決するパートナー」へと進化させる知性の革命です。GoogleやNVIDIAが示す最前線では、汎用的な知能をロボットに与える研究が加速しており、その波は製造・物流・サービスといったあらゆるビジネスの現場に押し寄せています。この歴史的な転換点を前に、企業や技術者に問われているのは、この新しいパートナーと「何を成し遂げるか」という創造性そのものなのかもしれません。

専門用語まとめ

- VLA (視覚言語行動) モデル

- 視覚情報(Vision)と言語(Language)を統合し、ロボットの行動(Action)を生成するAIモデル。GoogleのRT-2が代表例。

- 基盤モデル (Foundation Model)

- 大規模データで事前学習された、多様なタスクに適応可能な汎用AIモデル。ロボットの「脳」として機能し、個別のタスクごとにAI開発する手間を省く。

- ゼロショット学習 (Zero-shot Learning)

- AIが一度も直接学習したことのない、全く新しいタスクや概念に推論して対応できる能力。汎用知能の重要な指標とされる。

- ティーチング (Teaching)

- 産業用ロボットに特定の動作を教え込むプログラミング作業のこと。専門知識が必要で、生産ライン変更時の大きなコスト要因となる。

よくある質問(FAQ)

Q1. 生成AIロボットと、従来の産業用ロボットの最大の違いは何ですか?

A1. 「自律的な判断能力と適応性」です。従来のロボットは事前にプログラムされた動作を繰り返すだけですが、フィジカルAIは言語や映像から状況を理解し、未知のタスクにも推論を働かせて対応できます。

Q2. フィジカルAIはすぐに家庭で使えるようになりますか?

A2. すぐには難しいでしょう。まずは工場や物流倉庫など、管理された環境での実用化が進みます。家庭のような複雑で予測不可能な環境に対応するには、安全性やコストなど、まだ解決すべき課題が多く残っています。専門家は5年〜10年スパンでの普及を予測しています。

Q3. フィジカルAIを学ぶには何から始めればいいですか?

A3. まず、基本的なプログラミング(特にPython)と、機械学習・ディープラーニングの基礎知識を習得することをお勧めします。その後、ロボット工学の入門(運動学や制御工学)や、画像認識、自然言語処理(NLP)といった専門分野へ進むのが一般的な学習パスです。

更新履歴

- 情報アップデート、専門用語、FAQ等のセクションを追加。

- 記事を公開。

主な参考サイト

- Google DeepMind – RT-2: New model translates vision and language into action

- NVIDIA Blogs – Generative AI for Robotics: Language Models for Robot Control

- AssemblyAI – How robotics and generative AI are converging

合わせて読みたい

- PHYSICAL AI(フィジカルAI)とは?- 社会構造を再定義する究極のDX【徹底解説】

- フィジカルAIのビジネス最前線:常識を覆す最新ロボット5選

- フィジカルAIは日本の処方箋となるか?- 社会課題解決の最前線と未来展望

以上