🔧 Ambient Agent の核心(続):parse_actionsメソッド完全解説

LLMの抽象的判断を実行可能なアクションに変換する重要プロセスを、ステップバイステップで詳細解説します。

本記事は以下の記事の補足資料となります。

Ambient Agent:AI新時代の幕開け

おさらい:そもそもAmbient Agentとは?

本記事の主役であるparse_actionsメソッドは、「Ambient Agent(アンビエントエージェント)」という、より大きなAIコンセプトを実現するための重要な部品です。

では、そのAmbient Agentとは何でしょうか?

簡単に言えば、Ambient Agentとは、「私たちの周りの環境に溶け込み、私たちの状況やニーズを察知して、まるで気の利くアシスタントのように自律的にサポートしてくれるAI」のことです。従来の「指示待ち」型AIとは異なり、ユーザーが明示的に命令しなくても、状況を理解し、先回りして適切な提案やアクションを実行しようとします。

例えば、

- 会議の時間が近づいたら、何も言われなくてもリマインドしてくれる。

- 雨が降りそうなら、傘を持っていくよう教えてくれる。

- プリンターのインクが切れそうになったら、自動で注文してくれる。

このように、Ambient Agentは私たちの生活や仕事をよりスムーズで快適にするための「空気を読む」AIを目指しています。今回詳しく見ていくparse_actionsメソッドは、まさにこの「空気を読んだ」結果を具体的な行動に移すための設計図の役割を担っているのです。

Ambient Agentの全体像については、以下の記事をご参照ください。

Ambient Agent:AI新時代の幕開け

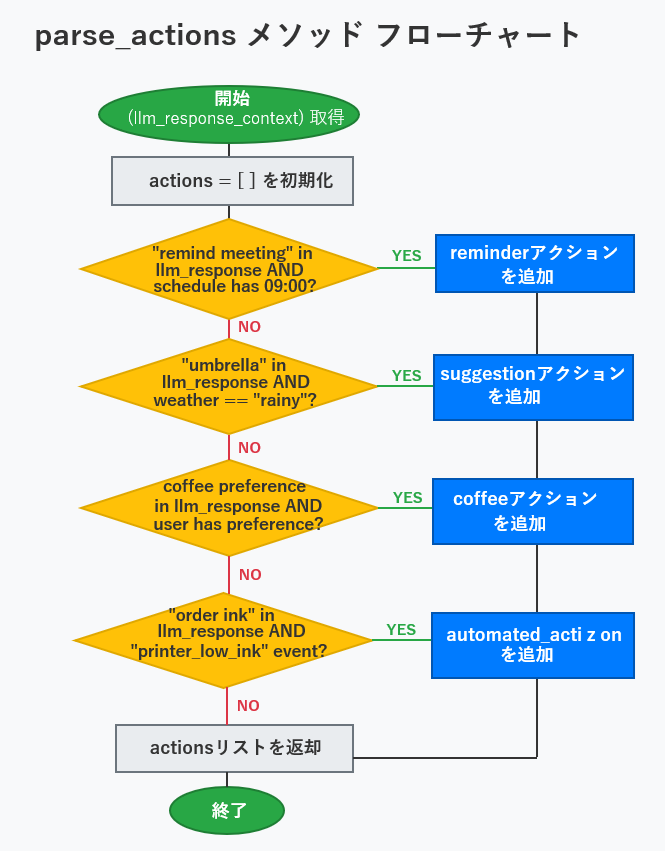

parse_actionsメソッドの処理フロー解説

このフローで実現したいこと。

このparse_actionsメソッドのフローチャートが目指しているのは、「AI(LLM)が提案したこととその時の様々な実際の状況(コンテキスト)を総合的に判断して、『じゃあ、具体的に何をすればいいか』という実際のアクションリストを作り出すこと」です。AIが机上で出したアイデアを、具体的な「やることリスト」に変換する処理の流れだと考えてください。

以下に示したフローチャートは、LLMの自然言語提案を実行可能なアクションに変換する重要なプロセスを示しています。

フローチャートの逐次説明

このフローチャートは、上から下へと処理が進みます。具体的には以下のステップで判断とアクションの追加が行われます。

1. 開始と初期化:

まず、AI(LLM)からの応答(llm_response)と現在の状況(context)を受け取ります。そして、これから実行するアクションをためておくための空のリスト(actions = [])を用意します。

2. 会議リマインダーの確認:

- LLMの応答に「会議をリマインド」が含まれていて、かつ、実際にスケジュールに9時の予定があるか?

- もし両方ともYESなら、「reminderアクション」をリストに追加します。

3. 傘の提案の確認:

- LLMの応答に「傘」の提案が含まれていて、かつ、実際の天気が「雨」か?

- もし両方ともYESなら、「suggestionアクション(傘)」をリストに追加します。

4. コーヒーの好みの確認:

- LLMの応答に「コーヒーの好み」に関する提案があり、かつ、ユーザーが実際にコーヒーの好みを持っているか?

- もし両方ともYESなら、「coffeeアクション」をリストに追加します。

5. インク注文の確認:

- LLMの応答に「インクを注文」が含まれていて、かつ、実際に「プリンターのインク残量低下」イベントが発生しているか?

- もし両方ともYESなら、「automated_action(インク注文)」をリストに追加します。

6. アクションリストの返却:

上記のチェックを経て、リストに追加された全てのアクションをまとめて返します。これがparse_actionsメソッドの最終的な成果物となります。

7. 終了: これで処理は終わりです。

このように、各ステップでAIの提案と実際の状況を照らし合わせることで、より確実で適切なアクションだけを実行しようとする仕組みになっています。

parse_actionsメソッドはAmbient Agentの中核となる部分です。LLMの抽象的な判断を、実際に実行可能な具体的アクションに変換する重要な役割を担っています。

更にコードベースで詳しく解説します。

📋 parse_actionsメソッドの全体構造

def parse_actions(self, llm_response, context: AmbientContext): actions = [] # 各種条件分岐でアクションを生成 return actions

📥 入力パラメータ

- llm_response: LLMが生成した自然言語の提案

- context: 現在の環境情報

📤 出力

- actions: 実行可能なアクションのリスト

🎯 ステップ1: 会議リマインダーの解析

if "remind meeting" in llm_response.lower() and context.schedule.get("09:00"):

actions.append({"type": "reminder", "content": f"Team Meeting at {context.schedule.get('09:00')}"})

🔍 詳細解析:

❶ 条件チェック(二重安全装置)

"remind meeting" in llm_response.lower() # LLMが会議リマインドを提案したか?

and

context.schedule.get("09:00") # 実際に09:00に予定があるか?

💡 なぜ二重チェックが必要?

- LLMは時々間違った提案をする可能性がある

- 実際のスケジュールデータと照合することで確実性を担保

- これがAmbient Agentの「信頼性」の源泉

❷ アクション生成

{

"type": "reminder", # アクションの種類を明確化

"content": f"Team Meeting at {context.schedule.get('09:00')}" # 具体的な内容

}

✅ 構造化の利点

- 後続の処理でtypeによって処理方法を分岐可能

- contentで実際にユーザーに表示する内容を指定

☂️ ステップ2: 傘の提案の解析

if "umbrella" in llm_response.lower() and context.weather == "rainy":

actions.append({"type": "suggestion", "content": "It's rainy, don't forget your umbrella!"})

🔍 詳細解析:

❶ 環境連動の判断ロジック

"umbrella" in llm_response.lower() # LLMが傘を提案 and context.weather == "rainy" # 実際に雨が降っている

🌟 重要なポイント

- LLMの提案とリアルタイム環境データを照合

- 天気が変わっていれば、LLMの提案を却下

- これにより「的確なタイミング」でのサポートを実現

❷ ユーザーフレンドリーなメッセージ

"content": "It's rainy, don't forget your umbrella!"

単に「傘」ではなく、理由付きの親しみやすいメッセージでユーザーが自然に受け入れやすい表現を使用。

☕ ステップ3: コーヒー提案の解析

if f"{context.user_preference.get('coffee')} coffee" in llm_response.lower() and context.user_preference.get("coffee"):

actions.append({"type": "suggestion", "content": f"How about a cup of {context.user_preference.get('coffee')} coffee?"})

🔍 詳細解析:

❶ パーソナライゼーション

f"{context.user_preference.get('coffee')} coffee" # "black coffee"

ユーザーの具体的な好み(”black”)を動的に埋め込み、汎用的な提案ではなく、個人に最適化された提案を実現。

❷ 存在チェック

context.user_preference.get("coffee") # Noneでないことを確認

ユーザーがコーヒーの好みを設定していない場合は提案しない。プライバシーと個人設定の尊重を実現。

🖨️ ステップ4: 自動調達の解析(最重要)

if "order ink" in llm_response.lower() and "printer_low_ink" in context.system_events:

actions.append({

"type": "automated_action",

"tool_id": "procurement_agent",

"request": "order_printer_ink_model_XYZ"

})

🔍 詳細解析:

❶ システムイベント連動

"order ink" in llm_response.lower() # LLMがインク注文を提案 and "printer_low_ink" in context.system_events # 実際にプリンターでインク切れが発生

🚀 この条件分岐の革新性

- IoTデバイスからの信号(プリンターのインク切れ)

- LLMの判断(インク注文の必要性)

- ビジネスロジック(会議前なので急ぎで必要)

を統合した高度な判断を実現

4.2 マルチエージェント連携

{

"type": "automated_action", # 完全自動実行

"tool_id": "procurement_agent", # 調達専門エージェントに委譲

"request": "order_printer_ink_model_XYZ" # 具体的な指示

}

⭐ ここがAmbient Agentの真骨頂

- ユーザーに負担をかけない完全自動化

- 専門性の高いタスクは専門エージェントに委譲

- 機種まで特定した具体的で実行可能な指示

🏗️ parse_actionsメソッドの設計思想

1. 防御的プログラミング

if 条件A and 条件B: # 常に複数条件でチェック

- LLMの判断ミスから保護

- 実環境との整合性を確保

2. 段階的自動化

"reminder" # ユーザーへの通知のみ "suggestion" # ユーザーへの提案 "automated_action" # 完全自動実行

- 重要度・影響度に応じた適切な自動化レベル

- ユーザーの制御権を適切に保持

3. 拡張性の確保

actions.append({

"type": "新しいタイプ",

"カスタムキー": "カスタム値"

})

- 新しいアクションタイプを簡単に追加可能

- 各アクションに必要な情報を柔軟に格納

⚠️ 実際の運用で考慮すべき点

🔒 セキュリティ面

if "order ink" in llm_response.lower() and "printer_low_ink" in context.system_events: # 実際の実装では追加チェックが必要: # - 予算上限チェック # - 承認プロセス # - 注文履歴との重複チェック

🛠️ エラーハンドリング

try:

actions.append({"type": "reminder", "content": content})

except Exception as e:

# ログ記録、フォールバック処理

⚡ パフォーマンス

- 大量のイベントが発生する環境では、条件チェックの最適化が重要

- キャッシュやインデックスの活用

| アクションタイプ | 自動化レベル | ユーザー関与 | 適用場面 |

|---|---|---|---|

| reminder | 低 | 通知のみ | スケジュール管理 |

| suggestion | 中 | 提案・選択 | 生活支援 |

| automated_action | 高 | 事後報告 | 業務自動化 |

📝 まとめ

parse_actionsメソッドは、Ambient Agentが「空気を読む」能力を実現する最も重要な部分です。ここで行われていることは:

- LLMの抽象的判断を具体的行動に変換

- 複数データソースの整合性チェック

- 適切な自動化レベルの選択

- 他システムとの連携準備

この設計により、ChatGPTのような「指示待ち」のAIから、「環境に溶け込み自律的に動作する」Ambient Agentへの進化が実現されているのです。

参考外部リンク

- LangChain – Introducing ambient agents

LangChainが公式に発表したAmbient Agentの概念説明とリファレンス実装。あなたの記事で扱っているparse_actionsメソッドの背景となる理論的基盤と実装パターンが詳しく解説されています。 - Anthropic – Building Effective AI Agents

Anthropicによる信頼性の高いAIエージェント開発のベストプラクティス。LLMの判断を実行可能なアクションに変換する際の安全性考慮、ツール設計、エラーハンドリングなど、あなたの記事の設計思想と合致する重要な技術指針が提供されています。

以上

ケニー狩野(中小企業診断士、PMP、ITコーディネータ)

キヤノン(株)でアーキテクト、プロマネとして多数のプロジェクトをリード。

現在、株式会社ベーネテック代表、株式会社アープ取締役、一般社団法人Society 5.0振興協会評議員ブロックチェーン導入評価委員長。

これまでの知見を活かしブロックチェーンや人工知能技術の推進に従事。趣味はダイビングと囲碁。

2018年「リアル・イノベーション・マインド」を出版。

/* JINテーマ対応のスタイル */

.wp-block-code {

background-color: #f8f9fa;

border: 1px solid #e1e8ed;

border-radius: 4px;

padding: 16px;

margin: 1em 0;

overflow-x: auto;

}

.highlight-box {

background: linear-gradient(135deg, #667eea 0%, #764ba2 100%);

color: white;

padding: 20px;

border-radius: 8px;

margin: 20px 0;

}

.important-note {

background-color: #fff3cd;

border-left: 4px solid #ffc107;

padding: 15px;

margin: 15px 0;

border-radius: 0 4px 4px 0;

}

.step-header {

background-color: #e3f2fd;

padding: 15px;

border-left: 4px solid #2196f3;

margin: 20px 0 10px 0;

border-radius: 0 4px 4px 0;

}

.code-explanation {

background-color: #f1f8e9;

padding: 15px;

border-radius: 4px;

margin: 10px 0;

}

.warning-box {

background-color: #ffebee;

border-left: 4px solid #f44336;

padding: 15px;

margin: 15px 0;

border-radius: 0 4px 4px 0;

}

.success-box {

background-color: #e8f5e8;

border-left: 4px solid #4caf50;

padding: 15px;

margin: 15px 0;

border-radius: 0 4px 4px 0;

}

.table-responsive {

overflow-x: auto;

margin: 20px 0;

}

table {

border-collapse: collapse;

width: 100%;

margin: 20px 0;

}

th, td {

border: 1px solid #ddd;

padding: 12px;

text-align: left;

}

th {

background-color: #f2f2f2;

font-weight: bold;

}

.inline-code {

background-color: #f4f4f4;

padding: 2px 6px;

border-radius: 3px;

font-family: ‘Courier New’, monospace;

font-size: 0.9em;

}