※本記事は継続的に「最新情報にアップデート、読者支援機能の強化」を実施しています(履歴は末尾参照)。

【2026年】巨大化競争の「次」に来るもの。「協調・標準・動的」で勝ち抜くAI設計戦

この記事を読むと、2026年に主流となるAI開発の4大トレンド(協調・適応・標準化・動的配分)について「何が争点で、どこまでが確度の高い事実か」が整理でき、自社のAI戦略を従来の「総力戦(拡大競争)」から、コストと成果を両立させる「設計戦」へと転換するための具体的なアーキテクチャを描くための最初の一手を決められます。

確度マップ(2025/12/19時点):

- 確度A:一次情報で確認済み … AAIF設立、MCPの位置づけ、Microsoft ResearchによるFara-7Bの報告、OpenAIのFrontierMath報告

- 確度B:研究結果として有望(射程あり) … DisCIPLの効率改善(特定条件・ベンチマーク)

- 確度C:設計仮説(本記事の主張) … “設計戦(協調×標準×動的配分)”が主戦場になる

超要約:

2026年のAIは「巨大モデル一強」から「巨大モデル+小規模モデルの協調」へ重心を移していきます。勝負は“モデル選び”ではなく“設計力”。

この記事の結論:

- 協調:小規模モデルを役割分担で動かす(プランナーとフォロワーの分業)

- 標準:MCPで接続コストを下げる(AAIFなどの標準化の動きで“交換可能性”を高める)

- 動的配分:難問だけ計算資源を厚くする(QPD最大化)

単に性能を追うのではなく、コスト効率(Quality-per-Dollar)と環境負荷を考慮し、タスクに応じて計算リソースを動的に配分する「設計力」が問われるようになります。

MIT(CSAIL)とYale大学の研究チームは、最先端推論モデル(o1)に近い精度へ迫りつつ、特定ベンチマークでは推論(reasoning)を40.1%短縮し、トークン単価ベースではコストを約80%(80.2%)削減できた例が報告されています。

2025年12月にLinux Foundation傘下のAAIFへ寄贈され、特定企業の独自規格ではなく、中立的ガバナンスのもとで進化する基盤プロトコルとして位置づけられました。

この記事の構成:

- Scaling Laws(拡大競争)の先にある「効率と協調」の新常識

- MIT(CSAIL)・Yale「DisCIPL」が証明した、小規模モデルチームの圧倒的コスパ

- Linux Foundation傘下AAIFに寄贈されたMCPと、オンデバイスでの動的計算配分

序章:Scaling Lawsの「その先」にあるもの

終わらない軍拡競争への違和感

深夜のデータセンター。空調の轟音が響く中、無数のGPUがうなりを上げ、電力計の針は危険な領域まで跳ね上がり続けている――。

2024年まで、私たちは一つの「神話」を信じて疑いませんでした。「パラメータ数を増やし、学習データを積み上げれば、AIは無限に賢くなる(Scaling Laws)」という神話です。テックジャイアントたちは、まるで冷戦時代の軍拡競争のように、天文学的なコストを投じてモデルの巨大化を競い合いました。

しかし、2025年の終わりにかけて、AI開発の現場は冷厳な現実に直面しました。

「学習(Training)」を盛るだけでは、コストとエネルギーの壁を越えられない。「推論(Inference)」の現場では、巨大すぎる知性は時として鈍重で、あまりに高価すぎたのです。

ビジネスの実装現場で求められていたのは、必ずしも「何でも知っている一人の天才」ではありませんでした。求めていたのは、「必要な時に、必要な精度で、適切なコストで答えを出せるチーム」だったのです。

2026年、AIのパラダイムは以下のように大きくシフトするのではないでしょうか。

勝負の土俵は「筋肉(計算力)の増強」から、「神経系(協調・制御・効率化)の洗練」へ。

ここからは、これらのキーワードがどのように絡み合い、新しいAIアーキテクチャを形成していくのかを紐解いていきましょう。

2026年を決定づける4つのキーワード

本記事で詳細に解説する、2026年に向けて加速するトレンドは以下の4点です。

- 協調(Collaboration): 単体ではなく、モデルの「組織」で戦う。

- 適応(Adaptation): 問題の難易度に合わせて、脳のギアを変える。

- 標準化(Standardization): エージェント同士を「共通言語」で繋ぐ。

- 動的配分(Dynamic Allocation): 計算リソースを流動的に最適化する。

1. 「一人の天才」から「組織的な分業」へ:MIT(CSAIL)+Yale「DisCIPL」が示した解

これまでの常識では、「性能向上=モデルの巨大化」でした。しかし、その常識は2025年12月、MIT(CSAIL)を中心にYale大学の研究者も加わったチームの報告によって揺らぎ始めました。彼らが提示したのは、「巨大な単一モデルよりも、連携のとれた小規模モデルのチームの方が、特定のタスクで効率面の優位を取りうる」という示唆です。

図の要点まとめ:

- プランナー(上司役)が戦略を立て、フォロワー(部下役)が並列で実務を実行する

- 制約付き生成タスクの条件では推論(reasoning)を40.1%短縮し、トークン単価ベースではコストを約80%(80.2%)削減できたケースが報告されています(o1比)。

- 人間の組織論(上司と部下の分業)をAIアーキテクチャに応用した「適材適所」の設計

「self-steering」による圧倒的なコスト効率

MIT(CSAIL)とYale大学の研究者を含むチームが発表した「DisCIPL」は、LLM(プランナー)が計画を立て、小規模モデル(フォロワー)を並列に協調させる“self-steering(自己誘導型)”方式です。従来のように「社長(巨大モデル)」がコピー取りから戦略立案まで全てを行うのではなく、DisCIPLは役割を明確に分担します。

- 要点: DisCIPLは、制約付き生成タスクの条件で、o1クラスのモデルに近い精度を保ちながら推論効率を大きく高めうることを示した。

- 元ネタ: MIT News / CSAIL & Yale Joint Research

- 検証結果: 推論プロセスを40.1%短縮、コストを80.2%削減

- 最終検証:

さらにMITは、従来の推論モデルが“文章で長く考える”のに対し、DisCIPLはPythonコードとして推論手順を組み立て、必要部分に計算を集中させることで、推論をコンパクトにできると説明しています。

2026年のシステム設計において、特化した小規模モデルたちが司令塔の下で有機的に連携するプロフェッショナルチームこそが、最強のAIシステムとなるというのが彼らの主張です。

この章を読んで湧き上がる疑問

Q4. 小規模モデルのチームは「誰」がどのように管理するのですか?

A4. 基本は「司令塔(オーケストレーター)」が管理します。上位モデル(プランナー)が仕事を分解し、下位の小規模モデル(実行役)へ指示を配り、ログや結果をまとめます。人間は監督(目的・ルール・責任)を持ち、日々の割り振りや再試行などの運用はオーケストレーターに寄せる設計が現実的です。

Q5. コストは下がっても、システムが複雑になりすぎませんか?

A5. 複雑性は増えやすいので、「型」で封じ込めるのがコツです。具体的には①接続の標準化(例:MCP)、②役割の固定、③観測、④失敗時のフォールバックの4点を先に設計しておくと、運用が破綻しにくくなります。

2. 適応的推論:QPD(対費用品質)という新指標

この無駄を排除するために開発されたのが、「適応的推論(Adaptive Inference)」です。近い系統として、入力ごとに計算量を変える“インスタンス・アダプティブ”な設計が議論されています。

「System 1」と「System 2」の工学的実装

行動経済学におけるダニエル・カーネマンの「System 1(直感・即答)」と「System 2(熟考・論理)」の違いを、AIの推論プロセスに実装する試みが進んでいます。簡単なタスクは直感的に即答し計算リソースを節約する(System 1)。複雑なタスクは思考の連鎖(Chain of Thought)を展開し、計算リソースを大量に投入して検証を繰り返す(System 2)。

MITは、入力ごとに計算量を調整するインスタンス・アダプティブなアプローチにより、同等精度を維持しつつ計算量を大幅に抑えられるケースがあると報告しています。

OpenAIもGPT-5.1/5.2で「adaptive reasoning」を導入し、簡単なタスクではトークン削減、難しいタスクでは追加計算を許容する設計を示しています。

本記事では、こうした潮流をまとめてQPD(Quality-per-Dollar:1ドルあたりの品質)という“実務の整理指標”で扱います。

ビジネス現場での実証:FrontierMathの新記録

OpenAIは、FrontierMath(Tier 1–3)において、GPT-5.2 ThinkingがPythonツールを有効化し、reasoning effort(推論量)を利用可能な最大(maximum available)に設定した条件で、40.3%の正答率を記録したと報告しています。

| 評価軸 | 従来の巨大LLM | 適応型推論モデル |

|---|---|---|

| 計算リソース配分 | 一律(全問全力) | 動的(難易度で可変) |

| コスト構造 | 高止まり | 条件次第で大幅削減が報告(例:推論プロセス40.1%短縮、トークン単価ベースで約80.2%削減のケース) |

| 主な指標 | 最高到達点(精度) | QPD (Quality-per-Dollar) |

これからのAI評価軸は、「最高到達点(どれだけ賢いか)」だけではありません。私たちが最大化すべき指標は次のように表せます。

![]()

ここでPerformanceには「正答率」「一次解決率」「処理時間短縮」など業務KPIを入れ、Costには「推論費(トークン/計算)+インフラ+運用工数」を合算するのが現実的です。

- 要点: QPD(Quality-per-Dollar)の最大化が2026年の最重要指標となる。

- 元ネタ: OpenAI / Introducing GPT-5.2(adaptive reasoning / reasoning effortの設計例)

- 補助資料: OpenAI / GPT-5.1 for developers

- 設計示唆: 「常に100点の回答で1000円」より「80点で1円、必要時のみ1000円」の設計がROIを制しやすい

QPD(Quality-per-Dollar:1ドルあたりの品質)こそが、ビジネス実装における主戦場となります。

3. 「AI経済圏」の確立:接続の地獄を終わらせる標準化の動き

小規模モデルが連携し、適応的に動作する「チーム戦」の世界において、最大の敵は何でしょうか? それは「言葉が通じないこと」、つまりシステムの断片化です。この「接続の地獄」を終わらせるために、歴史的な標準化が動き出しました。

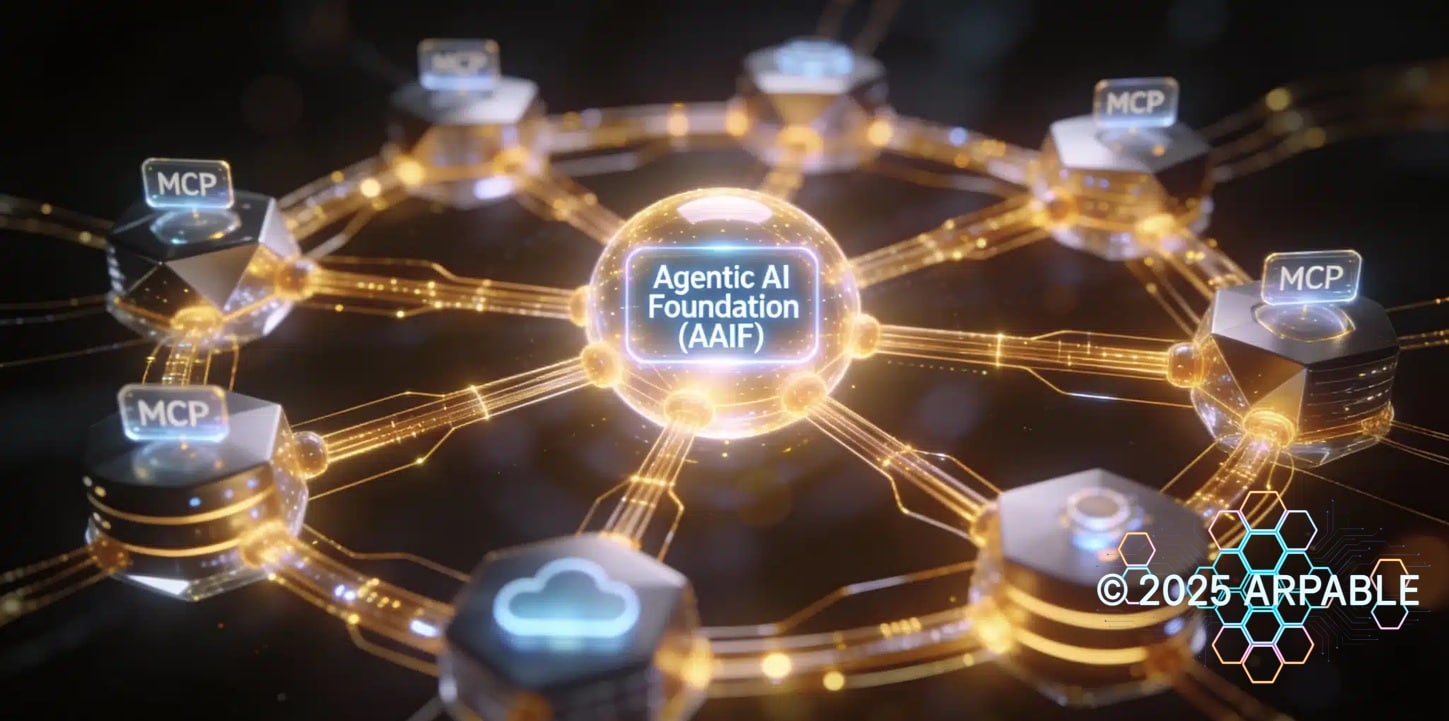

Agentic AI Foundation(AAIF)の形成

2025年12月9日付の発表では、Anthropic/Block/OpenAIが創設時の寄贈(founding contributions)として、MCP、goose、AGENTS.mdの3プロジェクトを提供しています。さらに、Google、Microsoft、AWSなどの支援を得て、業界全体が標準化へ舵を切り始めたことが示されました。

補足: MCPはAAIFの中核プロジェクトの1つですが、AAIF自体は「エージェント全般のオープン標準」を扱う、より広い枠組みとして位置づけられています。

- 要点: AAIFという“共通ルール作り”の団体がLinux Foundationのもとで動き出した。

- 元ネタ: LF公式プレスリリース(2025年12月9日付)

- 今のところ: As of 2025年12月 / MCP / goose / AGENTS.md が創設時の初期プロジェクト。

- 確認日:

AAIFへ寄贈された共通基盤「MCP」

Anthropicが公開したMCP(Model Context Protocol)は、2025年12月に正式にLinux Foundation傘下のAAIFへ寄贈されました。Linux Foundationの発表(2025年12月9日付)では、MCPは“10,000超のpublished MCP servers”に拡大したと記載されており、エコシステムの成熟は加速しています。

{

"jsonrpc": "2.0",

"id": 1,

"method": "initialize",

"params": {

"protocolVersion": "2024-11-05",

"capabilities": {

"roots": { "listChanged": true },

"tools": { "listChanged": true }

},

"clientInfo": {

"name": "ExampleClient",

"version": "1.0.0"

}

}

}

このように標準化されることで、ベンダーロックインが回避され、エコシステムが爆発的に広がります。今後は「自社独自のAPI」よりも「MCPに準拠しているか」が、企業の技術選定における最重要基準になるでしょう。

※)MCPに関する詳細はこちらの記事にまとめてます。

【技術解説】Anthropic MCPで拓く!AI連携とビジネス活用の第一歩

4. 2026年の本丸:オンデバイスと動的計算配分

「協調」「適応」「標準化」。これら全ての流れが合流し、具現化する“舞台”があります。それが、私たちの手元にあるデバイスです。これまでのAIはクラウドという「遠くの神殿」にいましたが、2026年、AIは私たちのPCやスマートフォンという「現場」に降りてきます。これを可能にするのが「動的計算配分」です。

Microsoft「Fara-7B」とピクセル主権

Microsoftが発表した「Fara-7B」は、わずか70億パラメータ(7B)というサイズでありながら、WebVoyagerベンチマークで73.5%の成功率を記録し、コンピュータ利用エージェントとして構成したGPT-4oの65.1%を上回りました。

※同ブログではBrowserbaseによる独立評価(62%)も併記されています(試行条件やリトライ設定が異なるため単純比較は不可)。

これは、「クラウドの超巨大モデル」だけでなく、「デバイス上の小型モデル+巧みに設計されたエージェント」が実務レベルの性能に到達しつつある象徴的な事例です。

- 要点: 7Bの小規模モデル(Fara-7B)が、GPT-4oを超えるWeb操作能力を示した。

- 元ネタ: Microsoft Research Blog “Fara-7B”

- 検証結果: Fara-7B 73.5% vs GPT-4o 65.1%

- 確認日:

Microsoft Researchの担当PMや解説記事では、画面の視覚入力と推論を端末内で完結させる設計を「Pixel sovereignty(ピクセル主権)」と表現しています(※呼称は文脈依存)。これにより、医療や金融といった規制の厳しい産業でも、AIエージェントのフル活用が可能になります。

新たなリスク:「透明性」への渇望

そのため、2026年の開発トレンドには、性能向上とセットで「説明可能性(Explainability)」が不可欠になります。OpenAIの「Confessions(告白/自己申告)」研究は、万能な不正防止策というより、モデルの逸脱を可視化し、監視・診断しやすくするための“透明性レイヤー”として捉えると理解がズレません。複雑なエージェント組織の透明性を高める方向性として重要です。

この章を読んで湧き上がる疑問

- Q. オンデバイスでの計算配分を最適化するためのOS側の支援はどうなるのか?

- Q. プライバシー保護と利便性のバランスをどう設計すべきか?

専門用語まとめ

- Scaling Laws(スケーリング則)

- モデルのパラメータ数や学習データ量を増やせば増やすほど性能が予測的に上がる経験則。

- DisCIPL

- MIT (CSAIL) とYale大学の研究者らが発表した自己誘導型AIフレームワーク。大規模な「プランナー」と小規模な「フォロワー」に役割を分担させ、計算コストを下げつつ性能を向上させる。

- MCP (Model Context Protocol)

- Anthropicが公開し、Linux Foundation傘下AAIFへ寄贈されたオープン標準プロトコル。AIモデルと外部データ・ツールを接続する基盤技術。関連語: interoperability(相互運用)/ agent-tool protocol(文脈で使われる呼び方)。

- System 2(システム2)思考

- 直感的に即答するSystem 1に対し、論理的で熟考を要する思考プロセス。AIでは、難問に対して追加計算を許容して推論する“熟考モード”を指す文脈で使われる。

- ピクセル主権 (Pixel Sovereignty)

- 画面上の情報(ピクセル)や操作データを、デバイス外部(クラウド)に出さず、ユーザーの管理下にあるローカル環境だけで処理・完結させるセキュリティ概念。

- 動的計算配分 (Dynamic Compute Allocation)

- タスクの難易度や重要度に応じて計算リソースの量を最適化させる設計思想。近い考え方として、OpenAIなどが説明する adaptive reasoning / reasoning effort(思考量制御)がある。

- Agentic AI (エージェンティックAI)

- 単に質問に答えるだけでなく、自律的に計画を立て、ツールを使いこなし、タスクを完遂する能力を持ったAIエージェントのこと。

よくある質問(FAQ)

Q1. 小規模モデルだけで本当に複雑な業務ができますか?

A1. 単体では限界がありますが、チーム化することで可能です。 DisCIPLの事例のように、司令塔役のモデルが適切にタスクを分解・指示すれば、個々の小規模モデルは専門タスクにおいてo1などの巨大モデルに近い性能を発揮するケースが報告されています。

Q2. 既存のLLMシステムを2026年モデルに移行するには?

A2. まずは「タスクの仕分け」から始めてください。 全てを高級モデルに投げるのではなく、定型業務を安価なモデルやオンデバイスAIに委譲(オフロード)する設計に見直すことが第一歩です。MCP対応ツールの導入も並行して進めるべきでしょう。

Q3. 透明性(Explainability)はなぜ重要なのですか?

A3. 分業化によりエラーの原因特定が難しくなるためです。 複数のモデルが連携する場合、どの指示が間違っていたかを追跡できる「説明責任」機能がないと、誤作動時のリスク管理ができず、企業導入の障壁となります。

まとめ(終章)

本章は要点の繰り返しではなく、「判断の着地」と「次の一手」に絞って締めます。

2026年のAI開発は、パラメータ数を競う「巨大化競争」から、小規模モデルの協調(チーム戦)と動的計算配分(必要なところだけ全力)へ軸足が移ります。

鍵は、MCPを起点とした標準化で接続コストを下げ、Quality-per-Dollarを最大化するアーキテクチャを描けるかどうかです。

次の90日でやること:

CxO向け:まずは「モデル別の推論コスト」と「業務別の削減時間」を洗い出し、QPDを四半期でモニタリングするKPIとして定義してください。

落とし穴(1行): 複数の小規模モデルが連携する「階層型エラー」のデバッグは従来の単体モデルより困難になるため、観測性の確保が急務です。

今日のお持ち帰り3ポイント

- 2026年は「モデルの巨大さ」ではなく「チーム編成(協調)の巧みさ」が勝負を決める

- Linux Foundation傘下のAAIFへ寄贈されたMCPに対応し、インフラを作ることが急務

- 「Quality-per-Dollar」を指標化し、難問以外はリソースを節約する「動的配分」を設計せよ

主な参考サイト

- MIT News: Enabling small language models to solve complex reasoning tasks (2025)

- Microsoft Research Blog: Fara-7B — An Efficient Agentic Model for Computer Use (2025)

- OpenAI: Introducing GPT-5.2 (Adaptive reasoning / FrontierMathの記述あり)

- OpenAI: Introducing GPT-5.1 for developers (Adaptive reasoning)

- Linux Foundation: Announces the Formation of the Agentic AI Foundation (AAIF)

- Anthropic: Model Context Protocol (MCP) Announcement / Overview

合わせて読みたい

更新履歴

- 初版公開

- 改善パッチ反映、誤字修正、詳細情報の復元、参考リンクの最終適正化