XAIと因果AIの実践ガイド:EU AI法対応から経営実装まで【2025年版】

この記事を読むとXAIと因果AIの本質的な価値がわかり、自社のAIプロジェクトにおいて「なぜその判断なのか」を説明し、戦略的な意思決定を下せるようになります。

- 要点1:AIのブラックボックス問題は深刻な事業リスクです。XAI市場は2025年時点で、調査機関により90億ドル〜103億ドル規模と推計され、年率20%近い急成長が見込まれています。

- 要点2:XAIは「どの特徴が影響したか」という相関関係は示しますが、「なぜその結果になったか」という因果関係までは説明できず、戦略的な意思決定には限界があります。

- 要点3:因果AIは「もし介入したらどうなるか」をシミュレーション可能にし、AIを単なる予測ツールから、ビジネスの未来を共に創る「対話可能なパートナー」へと進化させます。

📖 読了 約14分|🎯対象:経営者・エンジニア・技術戦略統括

🛠 難易度:★★★☆☆(中級)

【キーマップ】XAI/因果AI/自己説明型AI/AutoXAIの位置付けと役割(2025年版)

要約:本記事で扱う主要な技術群の関係性を一覧で示します。各技術がどのような役割を担い、どう進化してきたかを把握することで、全体像の理解が深まります。

| 技術概要 | 進化の段階/役割 | 主な目的・特徴 |

|---|---|---|

| XAI | 後付けの説明/機能の可視化 | 規制・説明責任への対応。人間がAIの判断根拠を要求する場面で機能。 |

| Causal AI | 因果を考慮した説明 | 意思決定の強化。「なぜその結果になったか」「もし介入したらどうなるか」をシミュレーション。 |

| Self-Explaining AI | モデル自体がもつ説明性 | 予測と同時に説明を生成。AIの透明性と判断プロセスを一体化させるアプローチ。 |

| AutoXAI | 説明形式の自動適応 | 専門知識なしに、特定の課題に最適なXAI手法や因果関係を自動で発見・適用する。 |

【序章】ある日、AIは「正しいが、受け入れられない答え」を出した

要約:AIの判断が正しいだけでは、ビジネスや社会の要請に応えられなくなりました。AIの「ブラックボックス問題」がなぜ今、深刻な事業リスクとなるのか、その原点を解説します。

ベテランの審査官が承認するはずの、ある中小企業の融資案件。

しかし、最新AIは冷徹に「否決」と判断しました。理由は誰も説明できません。このAIの判断は統計的に「正しい」のかもしれませんが、ビジネスとして、社会として、本当に「受け入れられる」答えなのでしょうか?

この問いこそ、本記事の原点です。

金融、医療、採用など、人の人生を左右する領域でAIの活用が広がる今、その判断プロセスを説明できないことは、深刻な事業リスクに他なりません。

特に、世界で最も包括的なAI規制である**EU AI法**が段階的に施行され、その影響は全世界に及びます。汎用AI(GPAI)モデルに関する透明性義務は、**新規モデルには2025年8月から、既存モデルも2027年8月までに適合**することが求められます。

EU市場にAIシステムを供給・導入する事業者は、たとえEU域外の企業であってもAI法の対象となり得ます。違反内容に応じて厳しい罰則が定められており、例えば禁止AIの提供といった最も重い違反には**全世界年間売上の最大7%(または3,500万ユーロ)**、本記事で扱う透明性義務など多くの違反には**最大3%(または1,500万ユーロ)**という高額な制裁金が科される可能性があります。

もはや、AIの説明責任は倫理的な要請に留まらず、国際的なビジネスを行う上での法務・経営マターなのです。

本記事は、AIを「謎の預言者」から「対話可能な、信頼できるパートナー」へと変えるための羅針盤です。

【第1部】XAIで“なぜ?”を解く方法 ~ AIブラックボックス問題と解決策(SHAP/LIME)徹底解説

要約:AIを「無口な天才料理人」に例え、その秘伝のレシピ(判断根拠)を解き明かすXAIの3つの基本アプローチを解説します。何がわかり、何がわからないのか、その限界を明らかにします。

高度なAIは、しばしば「長年の勘だけで絶品料理を作る、無口な天才料理人」に例えられます。彼の料理(予測)は美味しい(正確だ)が、レシピ(判断プロセス)は不明です。そこで登場するのが、厨房に持ち込まれた特殊な分析ツール(虫眼鏡)、すなわちXAIです。

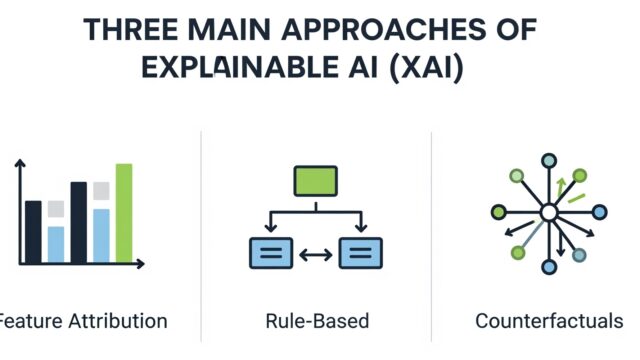

どの特徴が効いた?

ルール通りに判断

どうすれば良くなる?

XAIの主要アプローチと手法選択

XAIには複数のアプローチがあり、用途に応じて選定します。SHAPはモデル全体の説明精度・公平性から金融/医療/規制分野向け、LIMEは手軽さから個別案件の分析やPoC、初学者向けとされます。

SHAPとLIME、どう違う? ― 思考法の核心

両者の思考法をサッカーの試合分析に例えましょう。

- LIMEは「ワンプレー解説者」です。 ある選手のスーパーゴール(AIの個別予測)に対し、その周辺状況だけを切り取り、「もし相手DFがここにいなければ…」と局所的に解説します。手軽ですが、試合全体への影響は不明です。

- SHAPは「シーズンMVP査定官」です。 一人の選手(特徴量)がシーズン全体(AIモデル全体)の勝利にどれだけ貢献したかを、あらゆる連携を考慮し、ゲーム理論に基づき公平に算出します。計算は複雑ですが、絶大な信頼性があります。

👨🏫 AI専門家が解説:XAIハルシネーションリスクと検証手順

生成AIと同様、XAIによる説明が「もっともらしい嘘(ハルシネーション)」である可能性に注意が必要です。

実務では多層的検証が必須となり、

①SHAP/LIME/AutoXAI等複数手法の一致率確認、

②業界外データベンチマークとの突合、

③ユーザー/専門家の現場確認、

④EU AI法で規定されるような第三者機関による定期監査の導入

まで整備することが、説明の信頼性を担保しハルシネーションリスクに対する強力な対策となります。

👨🏫 AI専門家が解説:かみ砕きポイント

XAIでAIの判断の「根拠」はかなり深く理解できます。しかし、これだけではまだ不十分です。料理人はまだ最も重要な問いに答えてくれません。それは、「なぜ、その食材が、その味を生み出すのか?」という、物事の根本的な『原因と結果の関係(因果)』です。この最後の謎に挑むのが、次の主役です。

【第2部】因果AIで未来を予測する ― 相関の先にある「次の一手」の見つけ方

要約:XAIの限界である「相関」と「因果」の違いを解説します。「フードサイエンティスト」に例え、因果AIがどのようにしてビジネスの最適な意思決定を可能にするかを明らかにします。

XAIの厨房に、新たに「フードサイエンティスト(因果AI)」が登場します。彼は、美味しさの裏にある科学、すなわち「因果関係」を解明します。

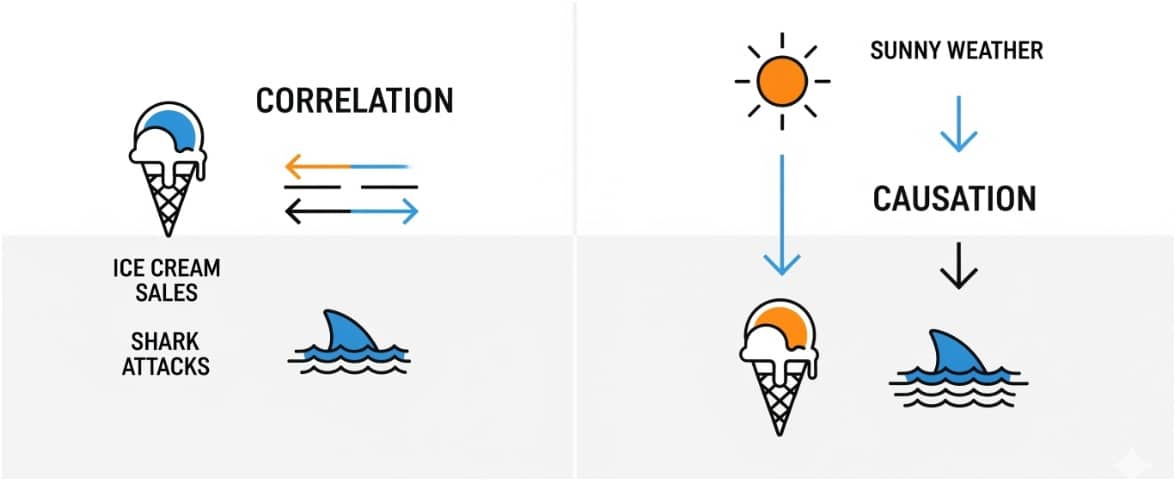

データ上の見かけの関係

隠れた第3の要因

本当の原因と結果

ビジネスでよくあるのが「夏の気温が上がると、アイスの売上もビールの売上も上がる」という関係(相関)です。しかし、真の原因(因果)は「気温」です。

なお、黎明期の市場であるため、因果AI市場の規模は調査機関や定義範囲により推計に大きなばらつきがあります。数千万ドルから数百億ドル規模まで桁が異なる予測が存在しますが、いずれも年率40%を超える極めて高い成長率を予測している点は共通しており、そのポテンシャルの高さを示しています。

最新トレンド:AutoXAIによる因果発見の自動化

2025年現在、AutoXAI(自動化されたXAI)の潮流が因果推論にも及んでいます。従来は専門家が手動で設計していた因果グラフ(変数間の因果関係を示した図)を、アルゴリズムがデータから自動で発見・学習する「自動因果発見」の研究が大きく進展しています。これにより、最小限の人間の介入で、リアルタイムに変化する状況から因果関係を推論し、迅速な意思決定を支援することが可能になりつつありますが、実務適用はまだケース依存であり、適切なガバナンス設計と並行して進める必要があります。

Key Takeaways(持ち帰りポイント)

- XAIは過去の判断の「説明」に強く、規制対応やデバッグに有効です。

- 因果AIは未来の行動の「予測と最適化」に強く、戦略的な意思決定に不可欠です。

- 両者は対立せず、AIとの対話を深めるために相互に補完しあう関係にあります。

【第3部】XAIと因果AIの実例で学ぶ:AIと人間が「協働」する最前線

要約:XAIと因果AIが導入されたビジネスの最前線を、具体的な企業事例で解説します。金融、マーケティングの現場で、AIとの「対話」がどのように競争優位性を生み出すかを示します。

金融:高リスクAIにおける説明可能性

JPMorgan Chaseは“Explainable AI Center of Excellence”を設置し、モデルの解釈可能性や責任あるAIに関する体制を公表しています。個社の運用詳細は非公開ですが、一般に金融機関の不正検知のような高リスクAI領域では、AIが不正取引を検知した際、リアルタイムで「どの取引パターンが不正と判断した根拠か」を分析官に提示する仕組みが不可欠です。EU AI法では、こうした高リスクAIシステムに対して、人間の監視、ログ機能、そして高いレベルの説明可能性を法的に義務付けています。

マーケティング:広告ROIの罠を見抜く

(causaLens社の公開事例として)ある広告キャンペーンのROIが、相関分析では1,400%と見えた一方、因果分析では-63%と推定されたと報告されています。これはあくまでベンダーによる報告であり、妥当性は前提条件に依存するため原典の確認が推奨されます。しかし、この発見の方向性は、**eBay社自身がNBER(全米経済研究所)で発表した大規模実験の研究結果とも一致しており**、従来の非実験的な手法が広告効果を過大評価しがちである可能性が学術的にも示唆されています。

医療:米国医師会(AMA)が求める透明性の強化

米国医師会(AMA)は2025年6月、医療現場で用いるAIツールの透明性確保を求める新方針を採択しました。この方針は、医師や患者がAIの推奨を評価できるよう、臨床AIツールに安全性と有効性に関するデータの提供を求めており、医療におけるXAIの重要性が一層高まっていることを示しています。

まとめ

本記事では、AIのブラックボックス問題という「原点」から出発し、その解決策としてのXAI、そしてAIとの真の対話を実現する因果AIまでを、最新の動向と実例を交えて解説しました。

AI社会実装とは、単に便利なツールを導入することではありません。AIの答えを鵜呑みにせず、その根拠を問い、対話し、時にはAIの間違いを正し、人間が最終的な責任を持つという覚悟を持つことです。

EUでは、GPAIモデル提供者が遵守すべき自主的な行動規範として「AI協定(AI Pact)」や「GPAI行動規範(Code of Practice)」が提示されており、企業の対応方針が注目されています。日本企業や自治体も、こうした国際的な潮流を無視しては、グローバルなビジネス展開で深刻なリスクを負うことになります。

この記事を参考に、自社で「このAIの判断、その理由は?」という最初の問いを投げかけること。それこそが、AIを真のパートナーとして社会実装を促す、最も重要で価値ある第一歩なのです。AIの「なぜ?」に向き合うこと。それこそが、AI時代の勝者となるための不可欠な羅針盤なのです。

専門用語まとめ

- XAIハルシネーション

- 説明可能AIが生成する説明が、もっともらしく聞こえるが事実やモデルの実際の動作に基づかない現象。このリスクを低減するため、多角的な検証が不可欠です。

- 自動因果発見(Automated Causal Discovery)

- 従来は専門家の知識に頼っていた変数間の因果関係の特定を、アルゴリズムがデータから自動で学習・推論する技術。AutoXAIの潮流の中で研究が進展しています。

- Notified Body(通知機関)

- EU AI法において、高リスクAIシステムが法の要件を満たしているかを評価・認証する、各加盟国によって指定された第三者適合性評価機関のことです。

よくある質問(FAQ)

Q1. 既存のAIシステムにXAIを後から追加できますか?

A1. はい、多くの場合可能です。特にSHAPやLIMEのような「モデル非依存」の手法は、既存のAIモデルに大きな変更を加えることなく説明機能を追加できます。ただし、AI開発の初期段階から説明可能性を設計に組み込むアプローチが理想的です。

Q2. 高リスクAIでは因果AIも必須になりますか?

A2. 2025年8月時点で、EU AI法は因果AIの導入を直接義務付けてはいません。しかし、同法が要求する「リスク管理システム」や「人間による監視」といった要件を満たし、判断の妥当性をより深く説明する上で、因果AIは実務上非常に有効な手段となり得ます。

Q3. 中小企業でもXAIや因果AIは導入できますか?

A3. 可能です。多くのXAIツールはオープンソースで利用でき、初期コストを抑えられます。まずは顧客からの問い合わせが多い業務など、課題が明確な領域でスモールスタートし、その価値を実証していくアプローチが有効です。

主な参考サイト

合わせて読みたい

更新履歴

- 初版公開

- 2025年8月時点のEU AI法の段階的施行、最新の市場データ、学術的背景に基づき内容を改訂。