Oracle Cloud AI戦略:タイタンの賭けと「Stargate」が拓くAIキングメーカーへの道

この記事を読むと、OracleのAIインフラ戦略の核心がわかり、現場のコストと移行リスクを減らす要点を実務に落とし込めるようになります。

- 要点1:RDMA×RoCE×ベアメタルで通信待機を削減し、同じGPUでも早く終わる=安くなる+生産性が上がるを実現。

- 要点2:NVIDIAのフルスタック最適化と、Database@Azure/@Google Cloudなどの連携で既存資産を動かさずAIに接続。

- 要点3:大型契約を起点に受注→構築へ転換し、GPU・電力・用地を前倒しで確保。供給確度を競争力に変換。

序章|周回遅れから主役級へ

要約:量の勝負を捨て、通信待機を減らす設計と同盟で「実務の完了時間」を縮める物語です。

検証ポイント:通信待機の削減が請求額と体感性能を同時に改善するという因果を押さえます。

かつてクラウドで「周回遅れ」と評されたOracleは、AIインフラ時代に急速に存在感を高めました。それは決して偶然ではなかったのです。

ネットワーク起点の設計と、NVIDIA・主要クラウド・電力パートナーとの同盟、そしてデータの隣にAIを置く提供形態を積み上げた結果です。

本稿は、現場の請求額を左右する要素に焦点を当て、Oracleがどのように「速く終わる×確実に出せる」を実現したかをたどります。

本稿では、クラウド後発と評されてきたOracleが、どのようにAIクラウドの旗手へと躍進したのかを解き明かします—鍵は「速く終わる × 確実に出せる」。

技術(RDMA/RoCE・ベアメタル)、運用(p99最適化)、調達(受注→構築)の三面から、その設計と実装を具体的にたどります。

序-1|比喩ではなく数式でわかる「速く終わる=安くなる」

なぜ、早く終わると安くなるのか。以下の関係を押さえます。

学習コスト ≒ ジョブ時間 × GPU単価 × GPU台数

ジョブ時間 = 計算時間 + 同期待機時間(通信)

つまり、RDMA等で同期待機を減らせばジョブ時間が短くなり、同じGPUでも安くなる+生産性が上がるというわけです。

👨🏫 AI専門家が解説:かみ砕きポイント

AI学習は「みんなで計算して、結果をそろえる」を繰り返します。遅いのは結果をそろえる通信です。ここを速くする配線(RDMA/RoCE)と、揺らぎを抑える実行形態(ベアメタル)に投資すると、完了時刻が前倒しされます。費用と体感の両方に効きます。

第1章|AIブーム前夜:土俵を変える

要約:量では勝てない土俵から降り、「GPUどうしの間」を詰める設計で実効性能の勝負に切り替えます。

検証ポイント:市場シェアの不利と、ネットワーク中心設計への転換を一続きの流れで確認します。

「GPUを増やす」のではなく、GPU間通信の待機を減らす設計に振り切ります。RDMA/RoCE、ベアメタル、p99レイテンシ監視をセットで導入し、学習ジョブの同期待機を継続的に短縮します。

1-1|「間」を詰めると請求が下がる

AI学習は計算の後に同期が入ります。誰かが遅れると全員が待ちます。待機が積み上がるほどジョブ時間と請求額が膨らみます。Oracleはここに正面から取り組み、RDMA/RoCE前提のネットワークとベアメタルで時間のブレを抑えます。重視するのは平均でなくp99です。たまの大遅延を小さく保つほど、体感とコストが同時に改善します。

1-2|データは動かさない:現実解としてのマルチクラウド戦略

世界の基幹業務は今なおOracle Databaseの上で動くケースが多く、企業はクラウド更新後も既存のOracle DBを使い続けたいという現実を抱えます。Oracleはこの要求に対し、データを大移動させず、AIをDBの“隣”へ寄せる解で応えます。

Database@Azure/Database@Google Cloudでは、主要クラウドのDC内にOracleの心臓(OCIのDB基盤)を同居させ、アプリは現行のまま、データはそのままでAIに近接接続できます。

| 連携 | どこで動く? | 利点(一般向けに一言) |

|---|---|---|

| Database@Azure | AzureのDC内(OCI機材同居) | アプリはAzureのまま、DBはOracleのまま。移行リスク小 |

| Database@Google Cloud | GCPのDC内(OCI機材同居) | GCPのAI/分析とOracle DBを近接で連携 |

| 共通の判定根拠 | データ移動を避けつつ、近接でAIに接続できること | |

👨🏫 AI専門家が解説:かみ砕きポイント

アプリとDBを無理に引っ越さず、AIだけを近づけます。転送・主権・監査の悩みを抑えつつ、RAGや推論を現実的に始められます。

1-3|競合との差別化:適材適所のAIインフラ

では、この戦略はAWSやAzure、GCPといった巨人たちとどう違うのでしょうか。結論から言えば、これは優劣ではなく「適材適所」の問題です。

- AWS/Azure/GCP: 多様なサービス群との緊密な連携や、サーバレス、コンテナ技術などを駆使した柔軟なアプリケーション開発環境に強みを持ちます。比較的小規模から始めるAI開発や、既存のクラウドネイティブなアプリとの連携では依然として強力な選択肢です。

- Oracle (OCI): 数千〜数万基のGPUを連携させる超大規模なAIモデルの学習や、金融・医療分野などミリ秒単位の応答性能が求められる推論処理のように、ネットワーク性能が直接コストと時間に跳ね返るワークロードで特に優位性を発揮します。

つまりOracleは、汎用性の競争から降り、AI時代の「超高性能計算」という最も困難で価値ある領域に特化することで、キングメーカーとしての地位を確立したのです。

第2章|逆襲の設計者:収益三段ロケット始動

要約:ラリー・エリソンが「通信待機を減らす」設計へ舵を切り、サフラ・キャッツが受注→構築の資本設計で下支えします。

検証ポイント:技術(ネットワーク中心)と資本(受注→構築)を連動させ、実効性能と供給確度を同時に高める。

2-1|設計者の視点:何に賭け、何を捨てたか

つまり、チップ間の同期の待ち時間を減らせばジョブは早く終わるというわけです。

そこでRDMAでCPU経由ではなくGPU間の直接転送を行い、RoCEで大規模クラスタの低遅延化を図り、ベアメタルで仮想化の冗長性を排除するという方針を示しました。

この方針は、GPUのカタログ値ではなく学習ジョブの完了時間を縮めることを狙います。学習は「計算」と「同期」を交互に繰り返し、遅れの多くは後者(通信待機)で生じます。

そこで平均ではなくp99レイテンシを重視し、たまに起きる大きな遅れを小さく保つことで全体の終了時刻を安定させます。

結果として、同じGPU台数でも早く終わる=安くなる+生産性が上がる状態を実現します。

資本面では、CEO サフラ・キャッツがこの設計を下支えします。先に長期需要を確保してから建設に入る受注→構築の枠組みで、GPU・電力・用地を前倒しで確保し、必要なときに必要な規模のクラスタを出せる体制を整えます。技術の選択が請求額に、資本設計が供給確度に直結するように、設計と調達を連動させます。

2-2|収益三段ロケット:基盤構築→実証・牽引→収穫・加速

フェーズ1:基盤構築(〜2022)

ネットワークはRDMA/RoCEを前提に、サーバはベアメタルを標準化します。高電力・高冷却のデータセンター設計を整え、NVIDIA(DGX Cloud/NVIDIA AI Enterprise)とフルスタック最適化で短期立ち上げを可能にします。

フェーズ2:実証・牽引(2023–2024)

生成AI需要が爆発し、「早く終わる=安くなる+生産性向上」が可視化します。Cohere や Adept に加え、2025年6月には xAI の Grok モデルが OCI で提供開始と発表。直近の案件でもOCI 上での学習・提供体制が再強化されています。さらにDatabase@Azure/@Google Cloudでデータは動かさずAIを近づけるを実現します。SREが専用クラスタ運用を伴走し、本番移行を支援します。

フェーズ3:収穫・加速(2025〜)

超大型契約をアンカーに受注→構築を本格化。複数州・複数サイトでキャンパス建設を並行進行し、電力・用地・冷却を同時確保します。指標はRPO(受注残)の段差増、供給リードタイム短縮、引き渡し本数の増加です。

| フェーズ | 主眼 | 主なKPI | 判定根拠 |

|---|---|---|---|

| 基盤構築 | RDMA前提・ベアメタル標準・DC設計 | p99低下/スループット上昇 | 同期待機の構造的削減に直結 |

| 実証・牽引 | 有力顧客案件・Database@各社・SRE伴走 | 契約残高増/RPO増 | 本番移行の速度と確度が上がる |

| 収穫・加速 | 受注→構築・並行建設 | RPO段差増/供給LT短縮 | 希少リソースを前倒し確保できる |

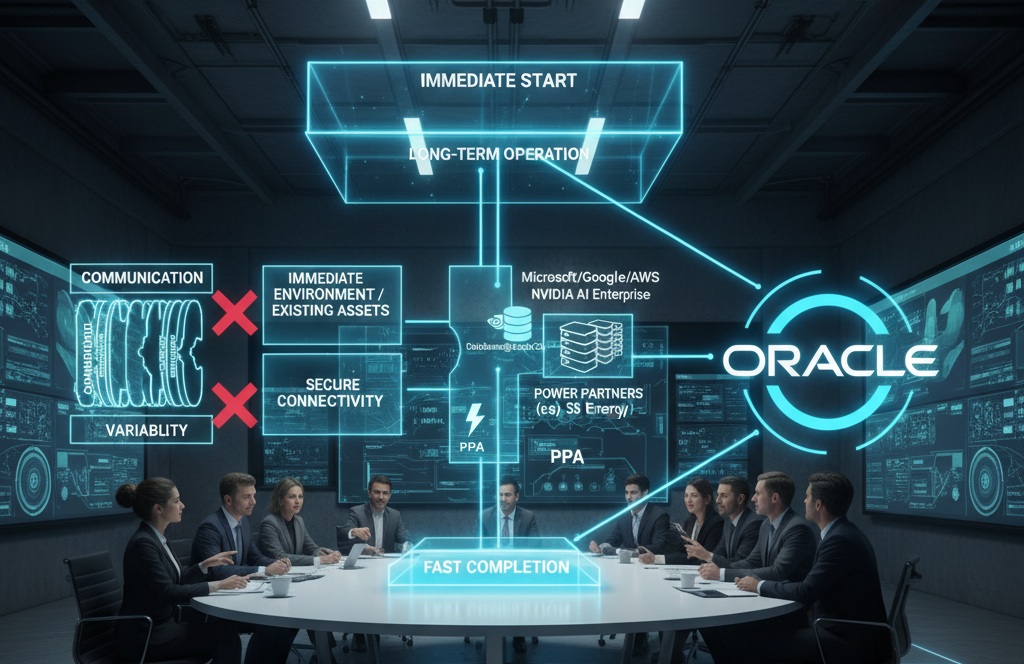

2-3|技術と同盟:筋肉・血管・接続・脳・燃料を束ねる

GPUという筋肉(NVIDIA)、それを結ぶ血管(RDMA/RoCEネットワーク)、既存資産へ橋を架ける接続(Database@Azure/@Google Cloud ほか)、業務で意味を与える脳(Palantir)、動かし続ける燃料(長期電源・PPA)。これらを同時に揃えることで、PoCから本番までの距離を縮めます。

Key Takeaways(持ち帰りポイント)

- 勝負はGPU個体値ではなく「GPUどうしの間」。同期待機を詰めるほど安く速い。

- データは動かさない。AIをDBの隣へ寄せると、移行リスクとコストを抑えやすい。

- 受注→構築で希少リソースを前倒し確保。供給確度が差別化の源泉になる。

第3章|勝利の方程式:ネットワーク=コンピュータ

検証ポイント:「平均」ではなくp99で体感を底上げし、ジョブ完了時刻と請求額が下がる因果を押さえます。

3-1|ストップウォッチの真実:速さは「1枚のGPU」では決まらない

学習は「計算」→「同期」を何度も繰り返します。全員の計算が終わっても、同期で一人が遅れると全員が待ちます。

つまり、支配的なのはGPUの個体値ではなく同期の待ち時間=GPUどうしの間です。ここを詰めるために、Oracleは配線(RDMA/RoCE)と実行形態(ベアメタル)に集中投資します。

3-3|縦串最適化:配線だけでは勝てない

配線を速くするだけでは不十分です。ネットワーク、スケジューラ、ストレージ、障害ドメインを縦にそろえて最適化します。

RDMA/RoCE前提のトポロジでホットスポットを避け、ベアメタルで性能のブレを抑え、データ読み込み経路を短くして「止まる」「待つ」を減らします。重視する指標はp99レイテンシとジョブ成功率、スループットです。

OCIは最新のNVIDIA Blackwell世代に対応し、OCI Superclusterは“最大”131,072基のNVIDIA GPUまでスケール可能な設計です。大規模AIモデル学習に最適化されたHPC環境として提供されます。

| ボトルネック | 典型症状 | 設計方針 | 現場の実感 |

|---|---|---|---|

| GPU間通信 | 同期で待ち行列/p99が荒れる | RDMA/RoCE前提のトポロジ | 待ち時間が目に見えて減る |

| 仮想化オーバーヘッド | ピーク時の頭打ち・ばらつき | ベアメタル標準 | スループットが安定する |

| スケジューリング | ホットスポット/再実行多発 | トポロジ意識の割り当て | 計画通りに回る |

| ストレージI/O | ローダー詰まり | 高速分散ストレージ+近接配置 | 読み込み待ちが減る |

| 障害ドメイン | 1故障で広域に波及 | 狭小ドメイン隔離+自動復旧 | 「止まらず縮退」で済む |

| 判定根拠 | p99とスループットが改善し、請求額(時間×単価×台数)が下がる | ||

3-4|同盟で欠けを埋める:筋肉・血管・接続・脳・燃料

GPUという筋肉(NVIDIA)、それを結ぶ血管(RDMA/RoCE)、既存資産へ橋を架ける接続(Database@Azure/@Google Cloud ほか)、業務で意味を与える脳(Palantir:データの関係性可視化とAIの説明可能性を提供し、特に政府・防衛・金融分野でのソブリンAI実装を支援)、動かし続ける燃料(長期電源・PPA)。これらを同時にそろえて、PoCから本番までの距離を縮めます。

Key Takeaways(持ち帰りポイント)

- 勝因はGPUどうしの間を詰めたこと。p99重視で体感と請求に効く。

- 縦串最適化で「止まる」「待つ」を減らし、スループットと成功率を引き上げる。

- 同盟で筋肉・血管・接続・脳・燃料を束ね、本番移行までを短縮。

第4章|転換点:巨大AIファクトリー構想と「受注→構築」が変えた順序

要約:大型契約を起点に順序を反転(受注→構築)。先に需要を確定させ、GPU・電力・用地を前倒しで確保し、納期と安定供給を競争力へ転換します。

4-1|順序の反転:交渉力と納期が変わる

従来は先に設備を用意して売る構築→受注が主流でした。Oracleは大型契約をアンカーに受注→構築へ転換します。

将来キャッシュフローが先に見えるため、GPUや電力の長期枠取りが容易になり、複数サイトの並行建設で供給リードタイムも短縮できます。

| 観点 | 構築→受注(従来) | 受注→構築(Oracle) |

|---|---|---|

| 資金繰り | 先行投資が重い | 受注を裏づけに資金調達が容易 |

| サプライ確保 | 標準在庫ベース | GPU・電力・用地の長期枠取り |

| 建設方法 | 段階的・漸進的 | 複数サイトの並行建設 |

| 価格性能 | 在庫都合の最適化 | ジョブ完了時間起点の最適化 |

| 判定根拠 | RPOの段差増とリードタイム短縮が同時に観測できる | |

4-2|巨大プロジェクト「Stargate」における中核的役割

OpenAIが主導する1000億ドル規模の巨大AIデータセンター計画「Stargate」。OracleはNVIDIAやSoftBankと共に、この計画に不可欠なパートナーとして参画しています。Oracleの役割は、単なるサーバー供給に留まりません。同社の「受注→構築」モデルと、RDMA/RoCEを前提としたOracle Cloud AIの高性能インフラ構築ノハウが、この巨大プロジェクトの供給と建設という心臓部を担っているのです。

(📅 2025年9月30日更新) 2025年9月23日には、テキサス州Abilene第1サイトでGB200 NVL72ラックの受け入れが始まり、段階的な初期運用が進行。あわせて5つの新規サイト計画が公表され、プロジェクトが加速しています。これは、Oracleの供給確度が机上の空論ではないことを示す、何よりの証左と言えるでしょう。

4-3|主権・近接・分散:エンタープライズの現実対応

政府・金融・医療では、データの所在と監査が前提です。OracleはDedicated Region、地理分散のDistributed Cloud、そしてDatabase@Azure/@Google Cloudを組み合わせ、データ移動を避けつつAIを本番へ導きます。

| 提供形態 | どこに置く? | 効く課題 | 代表ユースケース |

|---|---|---|---|

| Dedicated Region | 顧客専用(自社内/指定国内) | 主権・隔離・監査 | 政府・金融・防衛 |

| Distributed Cloud | 地域分散(エッジ含む) | 遅延・所在・可用性 | 製造・通信・小売 |

| Database@Azure/@Google Cloud | 各クラウドDC内にOracleの心臓を同居 | データ移動回避・監査適合 | 既存アプリとAIの近接連携 |

| 判定根拠 | 移行リスクを抑えつつ、近接でAIを動かせるため導入が進む | ||

Key Takeaways(持ち帰りポイント)

- 受注→構築で希少リソースの前倒し確保が可能に。

- 巨大AIファクトリー構想は多拠点の総体。段階引き渡しで納期とリスクを両立します。

- 主権・近接・分散の選択肢で、現実の制約を踏まえたAI本番導入がしやすくなります。

終章|結論:AI時代の新たな産業構造と未来への展望

要約:AI向けHPCへの早期集中、RDMAを核とする通信最適化、マルチクラウド/Dedicated Regionの現実解が結実し、三位一体の連携で実装が加速します。

Oracleの戦略は、AI向けHPCへの早期集中、RDMA技術による優位性の確立、そしてマルチクラウドやDedicated Regionといった顧客ニーズへの的確な対応が見事に結実したものです。この成功の背景には、NVIDIA(筋肉)、Oracle(血管)、Palantir(脳)という三位一体の連携があります。

この連携により、高度なエンタープライズAIやソブリンAIの実現が可能になります。国家安全保障や金融といった機密性の高いデータをDedicated Regionに集約し、Palantirのソフトウェアで意味付けし、Oracleの高速インフラとAI機能でリアルタイム分析やシミュレーションを行う——こうした新しいAI産業のエコシステムが形成されつつあります。

今後の展開を見極める上で、三つの指標が羅針盤となります。

❶ 四半期ごとのRPO(残存履行義務)増加額

2025年9月の決算発表で4,550億ドル、前年比+359%を記録

※Oracle Investor Relations。

❷ マルチクラウド展開の加速。

Oracle Database@Azure は2024年11月時点で9リージョンGA、

2025年末までに+24リージョン計画。

Oracle Database@Google Cloud も2025年1月に“+8リージョン計画”を発表

❸ 設備投資の継続的な伸び。

これらが順調であれば、戦略は着実に進行していると判断できます。

そして、これらの指標は、本記事の読者層ごとに異なる意味を持ちます。

- 経営層にとって、「RPOの段差増」は将来キャッシュフローの安定性を意味し、AIへの大型投資判断の強力な根拠となります。

- IT企画・情報システム部門にとって、「マルチクラウド拠点数の拡大」は、既存資産を動かさずにAIを導入できる現実的な選択肢が増えることを意味し、次期システム構想の重要な判断材料となります。

- 現場のエンジニアにとって、「継続的な設備投資」と「最新GPUへの対応」は、自らの技術が陳腐化せず、最先端の環境でキャリアを築けるという確信に繋がります。

私たちは今、AI革命の初期段階に立ち会っています。

そしてOracleの戦略の要諦は、これら三者の視点がそれぞれの立場で「賭けるに値する」と判断できる未来を、具体的な数字と性能で示している点にあるのです。

よくある質問(FAQ)

Q1. Oracleはなぜ今、評価が変わったのですか?

A1. 量の競争を避け、RDMA×ベアメタルで同期待機を減らし、学習の完了時間=実効コストを下げたためです。さらに受注→構築と電力・GPUの先行確保で、必要な時に必要量を出せる供給確度を高めました。

Q2. InfiniBandとRoCEの違いは何ですか?

A2. InfiniBandは専用ファブリックで低遅延・高スループットに強みがあります。一方、RoCE(RDMA over Converged Ethernet)は既存のイーサネット上でRDMAを実現します。OCIは大規模クラスタ前提でRoCE中心にネットワーク最適化を進めています。事実、OracleのExadata X8M(2019年)で内部ファブリックをInfiniBand→RoCEへ移行。以降、RoCE前提の最適化を継続しています。

Q3. 既存の基幹DBを動かさずに生成AIを使えますか?

A3. はい。Database@Azure/@Google Cloudにより、AzureやGCPのデータセンター内でOracle Databaseをそのまま使いながら、近接するAIクラスタと連携できます。データ移動のリスクや転送コストを抑えられます。

Q4. 「同じGPUでも安くなる」は本当に起こりますか?

A4. 学習コストは概ね「ジョブ時間 × GPU単価 × 台数」です。RDMA等で同期待機が減ればジョブ時間が短くなり、同じ単価・台数でも請求額は下がります。p99レイテンシやスループットで効果を測定します。

Q5. 主要なリスクは?どのように備えるべきですか?

A5. 顧客集中、建設・調達の実行、技術変動(アルゴリズム効率)などです。用途ミックスや段階引き渡し、複数拠点分散、PPAによる長期電源、世代ミックス設計などで冗長性を確保し、RPO・供給リードタイム・p99を継続監視します。

巻末|用語ミニ解説

- RDMA(Remote Direct Memory Access)

- 離れたサーバのメモリにカーネルを介さず直通でアクセスする方式です。GPU同士の同期待ちを削り、学習ジョブの完了時間を短縮します。

- RoCE(RDMA over Converged Ethernet)

- イーサネット網でRDMAを実現する手法です。既存ネットワーク資産を活かしつつ、低遅延・高帯域の通信を実現しやすい特長があります。

- ベアメタル

- 仮想化レイヤをほぼ介さず物理サーバを占有する実行形態です。オーバーヘッドが小さく、性能のブレが少なくなります。

- p99レイテンシ

- 処理の99%がこの時間以内に終わるという遅延指標です。平均では隠れる「たまの遅さ」を可視化し、体感性能の底上げに効きます。

- Distributed Cloud

- クラウド機能をユーザー拠点や特定地域に分散配置して提供するモデルです。遅延やデータ所在、可用性・主権要件に合わせやすい構成です。

- Dedicated Region

- パブリッククラウド相当の機能を顧客専用で自社内や指定国内に丸ごと設置・運用する形態です。主権・隔離・監査要件を満たしやすい利点があります。

- データ近接(Data Proximity)

- AIの計算資源をデータのすぐ隣に置く設計思想です。転送コストと遅延、セキュリティ懸念を同時に抑えます。

- DGX Cloud

- NVIDIAのGPU基盤とソフト群をクラウドで一体提供するサービスです。最適化済みの学習環境を短期間で立ち上げられます。

- NVIDIA AI Enterprise

- 企業向けAIソフトウェアスイートです。ドライバやフレームワーク、管理ツールを含み、互換性とサポートで運用リスクを下げます。

- Palantir(主権AI/説明可能性)

- データの意味づけ・関係づけと、説明可能性・監査性を重視する基盤です。公共・金融など厳格な領域で本番運用を後押しします。

- SB Energy(電力調達の例)

- 大規模データセンター向けの長期電力確保(PPA等)を担う電源パートナーの代表例です。ギガワット級の供給確度とコスト安定に寄与します。

必須の参考サイト(外部・最新公式/一次情報中心)

- Oracle Database@Azure:9リージョンGAと2025年末までの拡張計画(公式発表, 2024-11-19)

- Oracle Database@Google Cloud:GA発表(公式, 2024-09-09)

- Oracle × Palantir 提携発表(公式, 2024-04-04)

- Oracle FY26 Q1 決算リリース(公式IR, 2025-09-09)

- Reuters:OpenAI×Oracle×SoftBank「Stargate」新規5拠点計画(2025-09-23)

合わせて読みたい(arpable.com 内部リンク)

変更履歴

2025-09-30 初稿アップ

以上