執筆者からひと言

こんにちは。30年以上にわたるITエンジニアとしての現場経験を基に、AIのような複雑なテーマについて「正確な情報を、誰にでも分かりやすく」解説することを信条としています。この記事が、皆さまのビジネスや学習における「次の一歩」のヒントになれば幸いです。

はじめに|「信頼されるAI」へ──EUが示す新たな世界基準

EUのAI規制法(AI Act)は、人工知能(AI)の開発と利用に関する世界初の包括的な法的枠組みとして成立した。これは、巨大IT企業の市場支配力に焦点を当てたデジタル市場法(DMA)とは異なり、AIという技術そのものがもたらすリスクと社会的影響に網をかける、全く新しいアプローチの法律である。

本法は単にEU域内のルールに留まらない。グローバル企業が最も厳しいEU基準に合わせて製品開発を行うことで、事実上の世界標準が形成される「ブリュッセル効果」を通じて、その影響は世界中に及ぶと見られている。

特に日本企業にとって、この法律は二つの側面を持つ。一つは、準拠できなければ市場から締め出されかねない「EU市場への参入障壁」。もう一つは、グローバルで「信頼されるAI」を設計し、新たな競争優位を築くための「道しるべ」である。

本記事では、AI規制法の核心であるリスク分類から、企業や国際社会への具体的な影響、そしてイノベーションとの関係性までを深く掘り下げる。その上で、日本企業がこの大きな変化の波にどう乗り、未来への備えを固めるべきか、具体的な戦略を提示する。

第1章:AI Actの核心 ― 4段階のリスク分類と企業の責任

EUのAI規制法は、AIシステムがもたらすリスクを4つのレベルに分類し、それぞれ異なる義務を課す「リスクベース・アプローチ」をその核心に据えている。この設計思想は、イノベーションへの影響を最小限に抑えつつ、市民の権利と安全を最大限に保護することを目的としている。また、違反した場合には、最大で3,500万ユーロ(約58億円)または全世界の年間売上高の7%という巨額の罰金が科される可能性があり、その拘束力は極めて強い。

1.1 禁止される「許容できないリスク」

個人の自由や安全、民主主義的価値に看過できない脅威をもたらすAIは、原則としてEU域内での使用が全面的に禁止される。これらは、AIが悪用された場合に社会基盤を揺るがしかねないものと定義されている。

- サブリミナルな認知行動操作: 人々が意識できない方法で思考や行動を操作し、危険な行動を誘発するシステム。例えば、子どもに危険な遊びを無意識に促すおもちゃなどが該当する。

- 社会的スコアリング: 個人の行動、社会経済的状況、人種などに基づいて市民を格付けし、不当な不利益(融資の拒否、雇用の機会剥奪など)を与える政府によるシステム。

- 生体認証データによる無差別監視: 公共の場において、防犯カメラ映像などからリアルタイムで個人を特定し、無差別に監視するシステム(テロ対策など一部の重大な例外を除く)。

1.2 厳格な要件が課される「高リスク」

生命や健康、財産、基本的な権利に大きな影響を与える可能性のあるAIは「高リスク」と分類され、市場に投入する前に、また運用中も継続的に厳格な要件を満たす必要がある。これらのAIは、社会の重要インフラや個人の人生を左右する場面で利用されるものが中心となる。

- 重要インフラ: 自動運転車、航空管制、電力網の管理など、誤作動が大規模な事故に直結する分野。

- 医療・教育: AIによる診断支援システムや手術ロボット、また入学試験の採点や採用候補者のスクリーニングなど、個人の将来に決定的な影響を与える評価システム。

- 法執行・司法: 裁判における証拠の信頼性評価や、再犯予測システムなど。

高リスクAIの提供者(プロバイダー)と導入者(デプロイヤー)には、技術文書の作成、正確なログの記録、サイバーセキュリティ対策、そしてAIの判断を人間が適切に監督できる「人的監視」の仕組みを確保することが義務付けられる。

1.3 透明性が求められる「限定的リスク」

AIと人間が直接やり取りするような場面で、ユーザーが騙されたり誤解したりすることを防ぐため、透明性の確保が義務付けられるカテゴリ。

- チャットボット: 顧客対応などで利用する場合、ユーザーに対して対話相手がAIであることを明確に通知する必要がある。

- ディープフェイク: AIによって生成・操作された画像、音声、動画コンテンツは、それが人工的なものであることを開示しなければならない。

1.4 規制が最小限の「最小リスク」

上記以外の、リスクがほとんどないか、無視できるほど小さいAIシステム。現在、市場に存在する多くのAIアプリケーション(スパムフィルター、AI搭載のビデオゲーム、在庫管理システムなど)がこれに該当し、特段の法的義務は課されない。事業者は自主的な行動規範に沿うことが推奨されるに留まる。

Key Takeaways(持ち帰りポイント)

- AI Actはリスクの高低に応じて4段階の規制を設けている。

- 特に「高リスクAI」は、医療やインフラなど社会の根幹に関わるため、開発から運用まで厳しい義務が課される。

- 違反時の罰金は巨額であり、企業はコンプライアンスを軽視できない。

第2章:企業への影響 ― ビッグテックとスタートアップの明暗

AI規制法が、企業の規模によって異なる影響を与える「ゲームチェンジャー」となる理由を解説。巨大テック企業には新たな責任、スタートアップには機会と障壁がもたらされます。

AI規制法は、単なるコンプライアンス上の課題ではない。それはAI市場の競争ルールそのものを変え、企業規模によって異なる影響を及ぼす「ゲームチェンジャー」である。

2.1 信頼性への要求が強まるビッグテック

Google、Microsoft、OpenAIといった巨大テック企業は、自社が開発する大規模言語モデル(LLM)や汎用AIシステムが、他社によって「高リスク用途」で利用される場合、そのサプライチェーン全体における責任を問われることになる。

自社のAPIが医療診断や採用評価システムに組み込まれた場合、そのAIの品質や安全性について、利用者である企業との間で責任分担を明確にする契約を結び、技術的な情報を提供する必要が生じる。また、EU域内での事業活動を監督する「法定代理人」の設置や、システムの透明性に関するレポートの定期的な提出など、新たなコンプライアンスコストの増大は避けられない。

2.2 スタートアップに訪れる機会と障壁

一方、スタートアップにとっては、この規制は機会と障壁の両面を持つ。

高リスク分野に参入しようとするスタートアップにとって、厳格な文書管理や第三者による適合性評価、継続的なテスト体制の構築は、資金や人材の面で大きなハードルとなる可能性がある。

しかし、逆に言えば、開発の初期段階から規制要件を設計に組み込む「コンプライアンス・バイ・デザイン」のアプローチを取ることで、信頼性を武器に大企業と渡り合うことが可能になる。特に、AIの判断根拠を分かりやすく提示できる「説明可能性(XAI)」に強みを持つスタートアップは、市場で大きな差別化を図れるだろう。

2.3 イノベーションを止めないためのEUの支援策

EUも、規制がイノベーションの芽を摘むことのないよう、いくつかの支援策を用意している。

- AIサンドボックス制度: スタートアップや研究機関が、規制当局の監督のもとで、現実のデータを使って革新的なAIを安全に実験できる「規制の砂場」。これにより、市場投入前に技術の安全性と有効性を検証し、規制要件への適合性を確認できる。

- 中小企業向けの軽量基準: 中小企業に対しては、コンプライアンスに関する一部の義務を簡素化したり、情報提供を優先的に行うなどの措置が検討されている。

これらの動きは、AI企業にとって規制を「避けるべき障壁」ではなく、「信頼を勝ち取るための設計基準」として捉え直すことを促している。

第3章:グローバルな波及 ― ブリュッセル効果と各国の戦略

EUがAI規制で先行することにより、そのルールが事実上の世界標準となる「ブリュッセル効果」は、国際的なパワーバランスにも影響を与え始めている。各国は、この新たな潮流に対して、追随、警戒、あるいは独自の道を模索するという、三者三様の戦略的対応を迫られている。

👨🏫 かみ砕きポイント

「ブリュッセル効果」とは、EUが定めた製品やサービスの基準が、EU域外の企業にも適用され、結果的に世界標準(デファクトスタンダード)となる現象のことです。グローバル企業は、市場ごとに基準を変えるより、最も厳しいEUの基準に合わせて製品開発を行う方が効率的であるため、この現象が起こります。

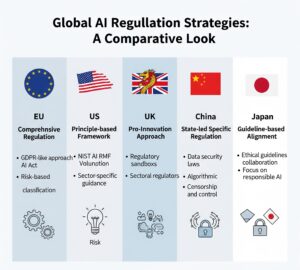

3.1 各国の動向:ルール形成の主導権争い

アメリカ:

連邦レベルでの包括的なAI規制法は未整備だが、大統領令に基づく「AI権利章典」やNIST(米国国立標準技術研究所)の「AIリスク管理フレームワーク」など、法的な強制力を持たない「原則ベース」のアプローチを推進している。産業界のイノベーションを重視し、過度な規制には慎重な姿勢を見せつつも、EUとの間で政策対話を重ね、ルールの相互運用性を模索している。

イギリス:

EU離脱後、独自のAI戦略を掲げている。特定の技術やリスクに対して個別の規制を適用する「プロ・イノベーション」アプローチを基本とし、分野ごとの規制当局(医療、金融など)がそれぞれの裁量でルールを策定するモデルを採用。EUのような包括的な法律ではなく、柔軟性と対話を重視する姿勢を明確にしている。

中国:

国家戦略としてAI技術開発を強力に推進する一方、生成AIやアルゴリズム推薦、ディープフェイクといった特定の分野では、世界に先駆けて厳しい規制を導入している。その根底には、技術の利用を管理し、社会の安定を維持するという国家主導の強い思想が反映されており、西側諸国とは異なるアプローチが際立つ。

日本:

政府は、法的拘束力のない「AI事業者ガイドライン」を公表し、企業による自主的な取り組みを促している。このガイドラインは、EUのAI規制法が要求するリスク分類やガバナンス体制の考え方と整合性(アライメント)を取るように設計されており、日本企業がグローバル市場、特にEU市場でビジネスを行う上での指針となることを目指している。米・欧・中が主導権を争う中で、日本は「信頼できる自由なデータ流通(DFFT)」構想を掲げ、主要国間の「橋渡し役」としての地位を確立しようと模索している。

第4章:技術倫理とガバナンス ― 規制の本質は「透明性」を超えて

AI規制が企業に求めるのは、単なるルール遵守ではなく、AIを社会に説明する責任を持つ「ガバナンス体制」の構築です。その核心にある「ブラックボックス問題」を解説します。

AI規制法が本質的に求めているのは、単なるルール遵守(コンプライアンス)ではない。それは、企業が自社のAIに対して倫理的な責任を持ち、その挙動を社会に説明できる「ガバナンス体制」を組織内に構築することである。

👨🏫 かみ砕きポイント

「ブラックボックス問題」とは、AI(特に深層学習モデル)が、なぜ特定の結論に至ったのか、その判断プロセスや理由を人間が正確に理解できない状態を指します。AIが自己学習で複雑化するほど、この問題は深刻になり、安全な運用や説明責任を果たす上での大きな課題となります。

この法律は、LLMや生成AIといった、その判断プロセスが開発者自身にも完全には理解できない「ブラックボックス」問題や、自己学習によってAIが刻々と変化していくという新たな課題に、企業がどう向き合うべきかを問うている。静的なルールを一つ一つ確認するだけでは、進化し続けるAIのリスクを管理することはできない。

だからこそ、企業は自らの手で、倫理的な原則を定め、それを実践するための組織的な仕組みを内製化する必要がある。

- 倫理レビュー委員会の設置: 新しいAIサービスを開発・導入する際に、その社会的影響や倫理的リスクを、技術者だけでなく法務、広報、外部の有識者など多様な視点から多角的に審査する。

- AI責任者の任命: AIに関する戦略やリスク管理について、組織全体を統括する責任者(Chief AI Officerなど)を設置し、経営レベルでの意思決定を迅速化する。

- 外部監査の導入: 自社のAIガバナンスが客観的に見て適切に機能しているかを、第三者の専門機関に評価してもらう。

この点において、日本の先進企業はすでに行動を起こしている。富士通は2019年に外部専門家を含む委員会を設置し、自社AIの倫理性を客観的に評価する体制を構築した。NECも同様に、2018年から人権やプライバシーを重視したAIビジネスの専門組織を立ち上げ、リスク管理を強化している。これらの取り組みは、規制対応をコストと捉えるのではなく、「信頼」を競争力に変えるための戦略的投資と位置づけている点で、他の日本企業にとっても重要なモデルケースとなる。

第5章:規制とイノベーションの共存は可能か

「規制はイノベーションの妨げになる」という懸念に対し、EUが示す「信頼を基盤とした共存モデル」を解説。規制が新たな市場原理を生み出す可能性を探ります。

AI規制法の議論において、最も大きな論争を呼んだのが「厳しい規制は、イノベーションの妨げになるのではないか」という懸念だ。この問いに対して、EUは「規制とイノベーションは対立するものではなく、信頼を基盤として共存しうる」という答えを提示しようとしている。

5.1 抑制と促進の双方向の力学

確かに、規制にはイノベーションを抑制する側面がある。高リスクAIと認定されたサービスは、開発プロセスの長期化、コンプライアンスコストの増大、市場投入の柔軟性の低下といった課題に直面する可能性がある。

しかし、同時に規制はイノベーションを促進する力も持つ。「信頼性」や「安全性」が保証されたAIは、特に医療、金融、公共調達といった分野で強力な競争優位性を持つことになる。将来的には、規制への適合性が、製品やサービスを選定する上での「必須要件」となる事例が増えていくだろう。「安全だから選ばれる」という新しい市場原理が生まれるのだ。

5.2 罰則からインセンティブへの転換

EUは、単に罰則で縛るだけでなく、規制を遵守する企業を後押しする「インセンティブ型モデル」への移行も視野に入れている。前述の「AIサンドボックス制度」に加え、規制に準拠したAI開発プロジェクトに対する補助金の提供や、政府調達における優遇措置などが考えられる。これは、「規制は成長の足かせ」という固定観念を打破し、企業が前向きに規制対応に取り組む動機付けとなる。規制は、イノベーションを導くためのガードレールとして機能し始めるのだ。

Key Takeaways(持ち帰りポイント)

- 規制はコスト増などの抑制効果だけでなく、「信頼性」という競争優位を生む促進効果も持つ。

- 「安全だから選ばれる」という新しい市場原理が、特に医療や金融分野で生まれる可能性がある。

- EUは罰則だけでなく、補助金などのインセンティブを通じて、企業の積極的な規制対応を後押しする。

第6章:まとめ ― 日本企業が今すぐ取るべき4つのアクション

EUのAI規制法は、日本企業に「信頼性」という新たな競争軸を提示しています。これは守りのコストではなく、未来への戦略的投資です。全社的なリスク把握とガバナンス構築を今すぐ始め、変化の波を乗り越えることが企業の持続的成長の鍵となります。

EUのAI規制法は、もはや対岸の火事ではない。日本企業にとって、それは無視できないグローバルな経営課題である。この大きな変化を乗り越え、未来の成長に繋げるために、企業は以下のアクションに今すぐ着手すべきである。

6.1 自社のAI利用状況の全社的な棚卸しとリスク分類

まずは、自社のどの部署が、何の目的で、どのAIツール(自社開発か外部サービスかを含め)を利用しているかを正確に把握することから始める。その上で、AI規制法のリスク分類に基づき、自社が利用するAIがどのカテゴリに該当するのかを仮評価する。これは、リスク管理の出発点となる。

6.2 部門横断的なガバナンス体制の構築と責任者の任命

AIのリスク管理は、開発部門だけで完結するものではない。法務、コンプライアンス、事業部門、経営層を巻き込んだ部門横断的なガバナンス体制を構築し、AIに関するリスクと戦略について全社的に議論する場を設ける。そして、その取り組みを統括する責任者を明確に任命することが不可欠だ。

6.3 外部サービス利用に関する契約・ポリシーの見直し

外部のAIサービス(SaaSなど)を利用している場合、そのサービスがAI規制法に準拠しているかを確認する必要がある。今後の契約においては、AIの安全性や透明性に関する情報提供義務や、万が一問題が発生した際の責任分担などを明記した条項を盛り込むことを検討すべきである。

6.4 技術的対策と全社員への人材育成

高リスクAIを開発・利用する可能性がある場合、AIの判断根拠を記録・検証するためのログ取得や、ユーザーに判断プロセスを説明するためのUI/UX設計など、技術的な対策を進める。同時に、AIを利用するすべての従業員に対して、AIの基本的な仕組みと倫理的リスクに関する研修を実施し、組織全体のリテラシーを向上させることが重要である。

「強い規制はイノベーションを阻害する」という慎重論は、確かに一面の真実を捉えている。しかし、グローバル市場において「信頼性」が企業価値の源泉となる時代、この変化への適応こそが、企業の持続的な成長の鍵を握っている。EUが示した未来への「設計図」をどう読み解き、自社の戦略に活かせるか。日本企業の対応力が今、問われている。

専門用語まとめ

- AI規制法(AI Act)

- EUが制定した世界初の包括的なAIに関する法的枠組み。AIがもたらすリスクに応じて異なる義務を課す「リスクベース・アプローチ」を特徴とし、違反者には高額な罰金が科される。EU域外の企業も対象となる。

- ブリュッセル効果

- EUが定めた市場ルールや製品基準が、グローバル企業によって世界中で採用され、事実上の世界標準(デファクトスタンダード)となる現象。企業のグローバル戦略に大きな影響を与える。

- 高リスクAI

- 生命や健康、基本的権利に重大な影響を及ぼす可能性のあるAIシステム。AI規制法では、医療機器、重要インフラ、採用・評価システムなどが指定され、開発から運用まで厳格な要件を満たすことが義務付けられる。

- 説明可能性(XAI)

- AIがなぜその判断や予測を行ったのか、その理由や根拠を人間が理解できる形で説明できる能力のこと。AIの信頼性や透明性を確保するための重要な技術とされる。

- AIサンドボックス

- 企業や研究機関が、規制当局の監督下で、現実のデータを用いて革新的なAIを安全に実験できる環境。「規制の砂場」とも呼ばれ、イノベーションを促進しつつ、市場投入前に安全性を検証することを目的とする。

よくある質問(FAQ)

Q1. EUに拠点がない日本企業にも、この規制は関係ありますか?

A1. はい、大いに関係あります。EU市場向けにAIを搭載した製品やサービスを提供する場合、あるいは自社のサービスのアウトプットがEU域内で利用される場合は、たとえ日本企業であってもAI規制法の対象となります。事実上の世界標準となる可能性が高いため、早期の対応が推奨されます。

Q2. 規制対応はコストがかかるだけで、企業にメリットはありますか?

A2. 短期的にはコンプライアンスコストが発生しますが、長期的には大きなメリットがあります。規制に準拠することで「信頼できるAI」というブランド価値を獲得し、特に医療や金融など安全性が重視される市場で強力な競争優位性を築くことができます。規制対応は、リスク回避だけでなく、新たなビジネスチャンスを掴むための戦略的投資と捉えることができます。

Q3. 自社がどのリスクに該当するかわかりません。まず何をすべきですか?

A3. まずは、社内で利用・提供しているAIシステムをすべて洗い出す「棚卸し」から始めることが第一歩です。自社開発か外部サービスかを問わず、どのような目的でAIが使われているかをリストアップし、それらがAI規制法のどのリスク分類(特に「高リスク」に該当しそうか)に当てはまるかを仮評価することが、具体的な対策を検討する上での出発点となります。

更新履歴

- 情報アップデート、FAQ、用語解説など読者支援強化。

- 初版公開

主な参考サイト

合わせて読みたい

以上