AI電力枯渇の危機!宇宙にデータセンターを作る「宇宙クラウド」構想とStarship革命

この記事を読むと「宇宙クラウド構想」の全貌と技術的課題がわかり、来るべきAIインフラ革命の動向を先読みできるようになります。

AIの電力不足を解決する有力な選択肢として、データセンターを宇宙に建設する「宇宙クラウド」構想が現実味を帯びてきました。SpaceXのStarshipによる輸送コスト革命を背景に、StarcloudやGoogleなどが技術的課題(熱・放射線)の克服に挑む、新たなインフラ開発競争が始まっています。

この記事の構成:

- 地上のデータセンターが直面する「電力・水・場所」の限界がわかります。

- 宇宙クラウド実現の鍵となる「熱・放射線・通信」の技術的課題と解決策を理解できます。

- Starcloud、Google、欧州ASCENDなど、主要プレイヤーの戦略と最新動向を把握できます。

- 宇宙クラウドの経済性や環境への影響(LCA)についての議論がわかります。

「2030年、AIは人類の電力供給能力を超越するかもしれない」

これはSF作家の空想ではなく、IEA(国際エネルギー機関)や主要なテックジャイアントが直面している、冷徹な「物理的限界」の予測です。ChatGPTの登場以降、生成AIの学習・推論に必要な電力は指数関数的に増大し続けており、地上のデータセンターは今、電力・水・土地のすべてが枯渇する「三重苦」に喘いでいます。

この閉塞状況を打破する有力な選択肢のひとつとして、シリコンバレーと宇宙産業界で真剣に検討され始めたのが、「データセンターそのものを宇宙空間に建設する」という、かつてない規模のインフラ構想——「宇宙クラウド(Space-based Cloud Computing)」です。

本記事では、NVIDIA支援のStarcloud、Googleの野心的プロジェクトProject Suncatcher、そしてEU主導の研究プロジェクト「ASCEND」など、世界中で加速する開発競争の全貌を徹底解説。さらに、熱力学の方程式や放射線対策アルゴリズムといった技術の深層まで、ストーリー仕立てで分かりやすく解き明かします。

第一章:なぜ「地上」では限界なのか? わかりやすく解説

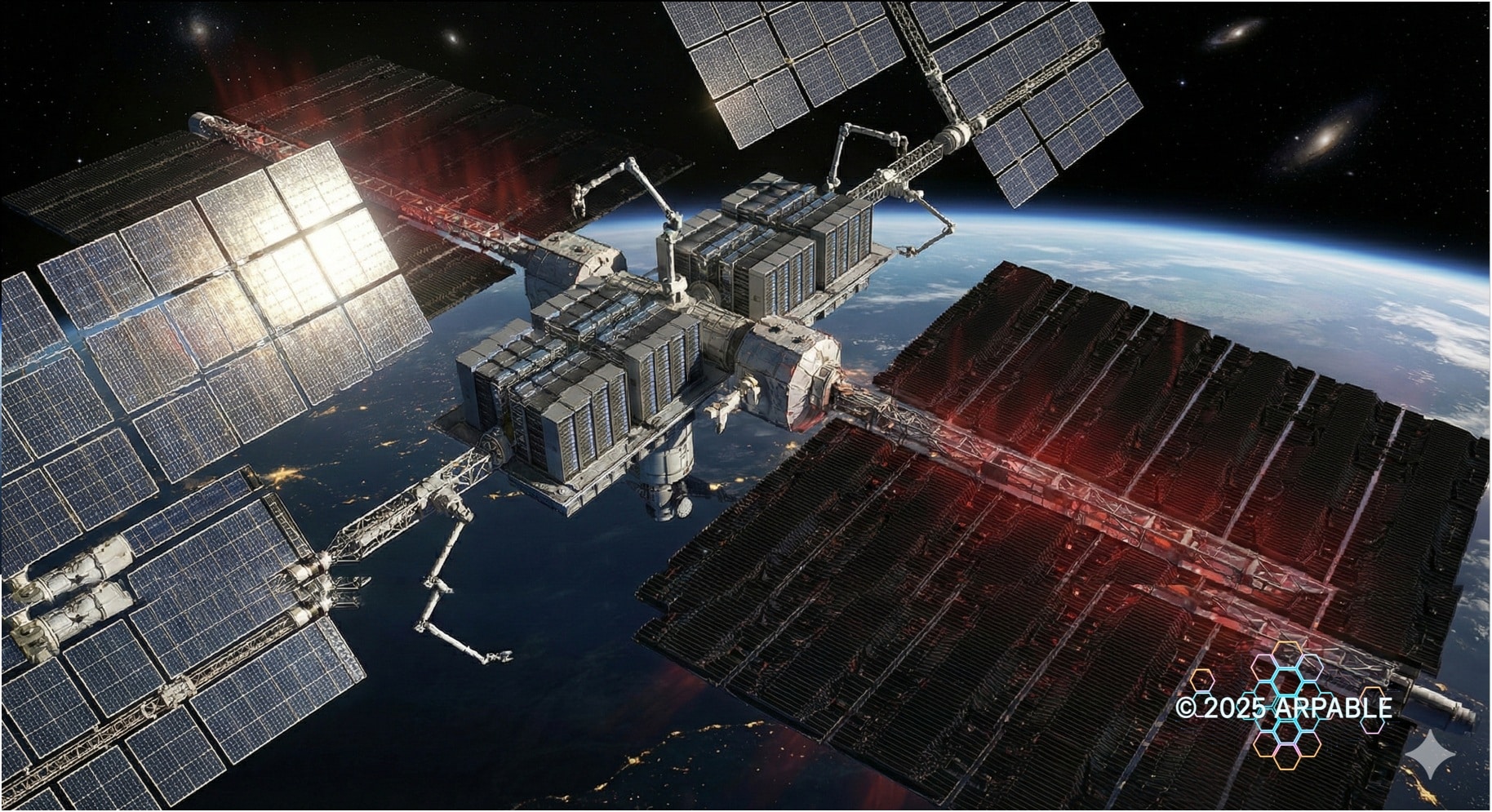

図の要点まとめ:

・Starshipのような超大型ロケットが、大量のサーバー機器を宇宙へ運ぶことを可能にします。

・劇的な輸送コストの低下が、宇宙クラウドの経済的実現性を高める最大の要因です。

・従来の繊細な衛星ではなく、コンテナ化された堅牢なモジュールを大量に展開する「宇宙の産業化」を象徴しています。

高度な技術論に入る前に、まず「なぜ莫大なコストをかけてまで宇宙へ行く必要があるのか」という根本的な疑問に答えます。地上のインフラ事情は、一般に知られている以上に切迫しています。

1. 「電気」が足りない:AIという大食らいのモンスター

最新のAIチップ(GPU)は、1つでドライヤーや電子レンジ数台分もの電力を消費します。これらが数万個集積されたデータセンターは、もはや「巨大な工場」や「小都市」並みの電力を必要とします。

【衝撃の事実】

IEA の試算では、世界のデータセンター電力需要は 2024 年の約 4,150 億kWh から、2030 年には約 9,450 億kWh(約 2.3 倍)に達すると見込まれており、これは現在の日本一国分に相当する電力消費に近い規模です。複数のシナリオでも、2030 年前後に「主要国ひとつ分の電力をデータセンターだけで食う」水準に迫るとの警鐘が鳴らされており、この急増ペースに既存の電力インフラが追いつかないリスクが「2030 年の崖」として議論されています。

「AI は本当に電力危機を引き起こすのか?」「データセンターの電力消費はどこまで増えるのか?」といった疑問に対して、IEA の最新レポートは、2030 年頃にはデータセンターだけで現在の日本一国分に近い電力を消費しうると指摘しており、「AI電力危機」という問いが現実味を帯びつつあります。

いま世界中で生成 AI ブームが進む一方で、「AI が電力網をパンクさせるのではないか」「AI データセンターが電力不足を加速させるのではないか」という懸念も急速に高まっています。AI インフラの未来を考えるには、この「AI と電力危機」「データセンター電力問題」を正面から捉える必要があります。

既存の送電網(グリッド)は、これほど急激な需要増に対応できるようには設計されていません。新たな発電所と送電線を建設するには10年単位の時間が必要であり、AIの進化スピードにインフラ建設が物理的に追いつかない「2030年の崖」が迫っているのです。

2. 「冷やす水」が足りない:サーバーは超高熱ストーブ

チップが計算すればするほど、猛烈な熱が発生します。これを冷やすために、地上のデータセンターは大量の「水」を使用します(水冷方式)。

Microsoftの学習データセンターがある米国のアリゾナ州などでは、干ばつが深刻化する中で「AIが人間の飲み水を蒸発させている」という批判が高まり、データセンター建設反対運動が激化しています。冷却水確保の問題は、電力以上に解決が難しい地域課題となりつつあります。

3. 「場所」がない:NIMBY問題と用地枯渇

大量の電気が引けて、水があり、通信バックボーンが太い「好立地」は、すでに奪い合いで枯渇しています。住宅地の近くには騒音や熱汚染の問題で建設できず(NIMBY: Not In My Back Yard)、僻地に行けば送電コストが跳ね上がる。地上にはもう、AIを無限にスケールさせるための「空白地」が残されていないのです。

地上 vs 宇宙:環境比較まとめ

この八方塞がりな状況に対し、「宇宙」という環境がいかに理想的(かつ過酷)か、比較表で整理しました。

| 比較項目 | 地上のデータセンター(限界) | 宇宙クラウド(理想郷と課題) |

|---|---|---|

| 電力供給 | 化石燃料依存、送電網の容量限界。 再エネは天候に左右され不安定。 |

24時間365日の太陽光発電。 Google Research の分析では、最適な軌道設計と姿勢制御、連続的な日照が揃ったシナリオでは、同じ面積のソーラーパネルでも「累積の発電量ベースで」地上比最大約 8 倍のエネルギーを得られる可能性があると試算されています。 |

| 冷却方法 | 空冷ファンや水冷チラー。 大量の水資源と空調電力が必要。 |

宇宙背景に近い極低温(約 −270℃)方向への放射冷却。 水もコンプレッサーも不要だが、巨大な放熱板が必要。 |

| 土地・空間 | 好立地は枯渇。 建設反対運動や土地代の高騰。 |

物理的制約なし。 軌道上は無限の空間があり、拡張が容易。 |

| 輸送コスト | トラック輸送で安価。 | ロケット打ち上げが必要。 ※ただし、SpaceX のStarshipのような完全再使用型大型ロケットが本格運用段階に到達すれば、打ち上げコストが桁違いに下がると広く期待されています。Starship は最大 150 トン級のペイロード能力をうたっており、宇宙クラウドの経済性評価でも「このクラスの再使用ロケットによるコスト低下」が前提条件として組み込まれつつあります。 |

第二章:宇宙クラウドの物理学(熱・放射線・通信)

図の要点まとめ:

・宇宙クラウドの基本構成は、大規模な太陽光発電パネルと、熱を捨てるための巨大なラジエーター、そしてサーバーモジュールから成ります。

・真空の宇宙空間では空気による冷却ができないため、熱を赤外線として放出する「放射冷却」が唯一の冷却手段となります。

・これらの巨大な構造物をいかに効率よく軌道上で展開・維持するかが、技術的な大きな課題です。

ここからは、エンジニアや技術投資家の皆様に向けて、宇宙クラウド実現の前に立ちはだかる「物理学の壁」と、それを乗り越えるソリューションを深掘りします。

1. 熱力学:真空断熱と「シュテファン=ボルツマンの法則」

「宇宙は寒いから冷却が簡単だ」というのは、半分正解で半分間違いです。確かに宇宙背景放射の温度はおおよそ ![]() (約 −270℃)と非常に低い一方で、低軌道付近の実際の熱環境は太陽光や地球からの反射・赤外放射の影響を強く受けます。つまり「宇宙全体が −270℃で凍っている」のではなく、「極低温の宇宙背景を、どううまく放熱先として使うか」が冷却設計の核心になります。

(約 −270℃)と非常に低い一方で、低軌道付近の実際の熱環境は太陽光や地球からの反射・赤外放射の影響を強く受けます。つまり「宇宙全体が −270℃で凍っている」のではなく、「極低温の宇宙背景を、どううまく放熱先として使うか」が冷却設計の核心になります。

唯一使える冷却メカニズムは、熱エネルギーを電磁波(赤外線)として宇宙空間に放出する「放射冷却(Radiative Cooling)」のみです。その放熱能力 ![]() は、以下の式で決まります。

は、以下の式で決まります。

![]()

:放出される熱量 (Watt)

:放出される熱量 (Watt) :放射率(0〜1。黒体に近いほど1)

:放射率(0〜1。黒体に近いほど1) :シュテファン=ボルツマン定数 (

:シュテファン=ボルツマン定数 ( )

) :ラジエーターの面積 (

:ラジエーターの面積 ( )

) :ラジエーター表面温度 (K)

:ラジエーター表面温度 (K)

この式が示す残酷な事実は、「温度 ![]() を上げる」か「面積

を上げる」か「面積 ![]() を広げる」しか、冷却能力を増やす方法がないということです。

を広げる」しか、冷却能力を増やす方法がないということです。

しかし、半導体チップは低温で動作させたい(![]() を上げたくない)。となると、解は一つ。「巨大な面積

を上げたくない)。となると、解は一つ。「巨大な面積 ![]() を持つラジエーター」を展開することです。MW(メガワット)級のデータセンターを冷やすには、サッカーコート数面分ものラジエーターが必要になる計算もあり、これをいかに折りたたんで打ち上げ、宇宙で展開するかが最大のハードルとなります。

を持つラジエーター」を展開することです。MW(メガワット)級のデータセンターを冷やすには、サッカーコート数面分ものラジエーターが必要になる計算もあり、これをいかに折りたたんで打ち上げ、宇宙で展開するかが最大のハードルとなります。

技術解:展開式ラジエーターと熱スイッチ

- 二相流体ループ(Loop Heat Pipe): チップから発生した熱を、電力を使わずに流体の相転移(蒸発・凝縮)だけで数メートル先のラジエーターまで高速輸送する技術。

- 可変放射率素子(Smart Radiator): 太陽光が当たる面は放射率を下げて入熱を防ぎ、日陰側は放射率を上げて排熱する、VO₂(二酸化バナジウム)などを用いた「熱のスイッチ」素材の研究が進んでいます。

2. 放射線耐性:ハードウェアではなくソフトウェアで守る

宇宙空間(特に低軌道や極軌道)は、高エネルギー陽子や重粒子線が飛び交う「銃弾の雨」のような環境です。

- SEU(Single Event Upset): 放射線がメモリに衝突し、ビットが「0」から「1」に反転してしまう現象。計算結果が狂う。

- TID(Total Ionizing Dose): 累積被曝量により、半導体の絶縁膜が劣化し、最終的にチップが死ぬ。

- ラッチアップ: 寄生サイリスタがオンになり、過電流が流れてチップが焼き切れる致命的な故障。

従来の宇宙開発では、計算性能を犠牲にしてでも放射線に強い「耐放射線(Rad-Hard)チップ」を使っていました。しかし、これでは最新AIの学習には遅すぎます。

そこで、Starcloud が掲げる「software-defined radiation tolerance」に代表されるように、民生品(COTS)の GPU をできるだけそのまま使い、ソフトウェアとアーキテクチャで守るというアプローチが注目されています。

【ソフトウェア定義の放射線対策の例】 1. 空間・時間冗長性 複数の GPU や異なるタイミングで同じ計算を実行し、 結果の多数決・照合によって SEU(ビット反転)を検出・マスクする。 2. ECCメモリと整合性チェック ECC付きメモリやチェックサムで、ビット反転を検出・訂正する。 3. フェイルセーフ制御 電流や温度などの異常を高速に検知し、 チップが破壊される前に自動リセットや電源遮断を行う。

このように、ハードウェアを過度に特殊仕様にするのではなく、ソフトとシステム設計で放射線の影響を抑え込む発想が、最新 GPU や TPU を宇宙空間で活用する上での鍵になりつつあります。

3. 通信:光のボトルネックとデータ階層化

いくら宇宙で計算できても、データを地上とやり取りできなければ意味がありません。しかし、すべての生データを地上に送るには帯域が足りません。

そこで重要になるのが「データの階層化(Data Tiering)」です。

- Level 1 (Ground): 前処理。個人情報のマスキングや圧縮を地上で行う。

- Level 2 (Orbit): 学習・推論。圧縮された特徴量データのみをアップリンク。

- Level 3 (Downlink): 推論結果や学習済みモデル(Weight)のみをダウンリンク。

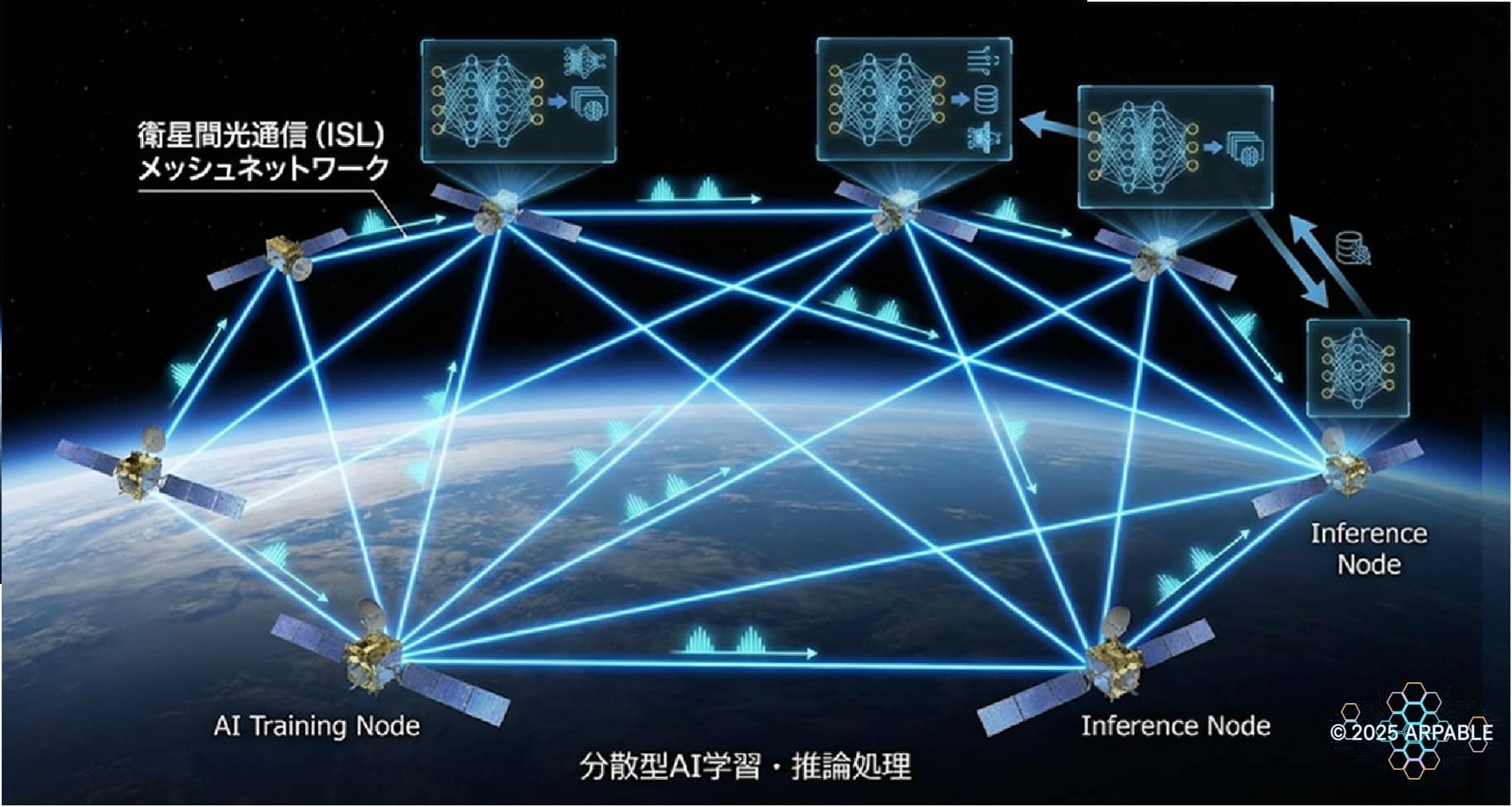

さらに、衛星同士をレーザーで結ぶ「衛星間光通信(ISL: Inter-Satellite Link)」により、特定の地上局(ゲートウェイ)の上空にいなくても、宇宙空間を経由して地球の裏側へデータを即座に送るメッシュネットワーク構築が必須となります。

第三章:主要プレイヤーの動向と戦略(Starcloud, Google, 欧州)

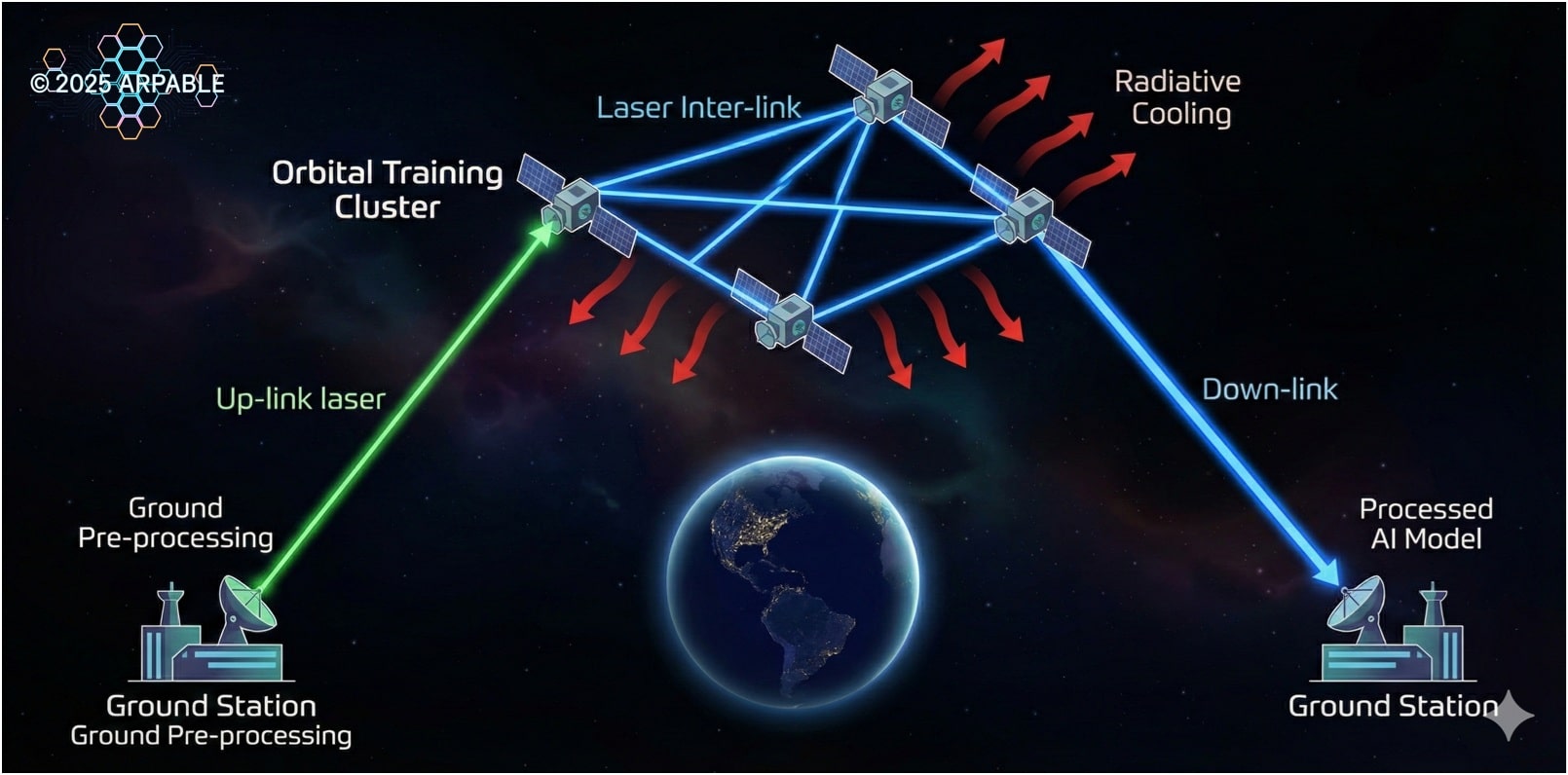

図の要点まとめ:

・データは地上で前処理された後、レーザー光通信で宇宙のデータセンターへアップリンクされます。

・宇宙空間では、複数の衛星が「衛星間光通信(ISL)」でメッシュネットワークを形成し、連携して学習・推論処理を行います。

・処理済みのAIモデルや推論結果は、再び地上局へダウンリンクされ、利用されます。

宇宙クラウドはもはや机上の空論ではなく、Starcloud-1 のような実証衛星や Project Suncatcher/ASCEND の概念設計が並行する「実験的な開発競争」のフェーズに入りつつあります。主要なプレイヤーと、その背後にある戦略の違いを見ていきましょう。

1. Starcloud:NVIDIA GPUをそのまま宇宙へ

戦略:「Time to Market(スピード)」重視

Starcloudは、「既存のAI開発者が何も変更せずに使える環境」を目指しています。彼らは NVIDIA の H100 などデータセンター級 GPU を搭載した衛星を打ち上げ、Kubernetes などの標準的なコンテナ技術でオーケストレーションする構想を掲げています。2025 年 11 月に打ち上げられた Starcloud-1 は H100 を搭載した実証機であり、今後の衛星では NVIDIA Blackwell 世代 GPU(B200 など)も順次統合していく計画があると報じられており、宇宙側の計算能力も地上クラウドと同世代で進化させていく構想です。

彼らの強みは、開発者が「kubectl apply -f space-gpu.yaml」のようにコマンドを打つだけで、地上のAWSやAzureと同じ感覚で宇宙リソースを使えるようにする点にあります。Starcloud は 2025 年 11 月に H100 搭載の実証衛星 Starcloud-1 を軌道に投入し、低軌道 325km で約 11 か月のミッションを進行中です。現在は放射線環境下での GPU 動作データを蓄積しつつ、次世代衛星でのクラスタ構成や電力・冷却スケーリングの検証に向けた計画を進めています。

【2025年11月追記】

Starcloud-1 は 2025 年 11 月 2 日に SpaceX Falcon 9(Bandwagon-4)で打ち上げられ、世界初の NVIDIA H100 GPU の軌道上運用を開始しました。小型冷蔵庫サイズ・約 60kg の衛星で、Astro Digital の Corvus-Micro バスをベースに設計されており、約 11 か月の運用後に高度 325km の軌道から離脱し、大気圏再突入で燃え尽きる計画です。

2. Google “Project Suncatcher”:TPUによるシステム全体最適

戦略:「TCO(総保有コスト)」と「効率」重視

一方のGoogleは、より長期的で根本的なアプローチを採っています。彼らは汎用 GPU ではなく、自社開発の TPU(Tensor Processing Unit)を宇宙環境に合わせてカスタム設計することを研究しています。さらに Google は衛星事業者 Planet Labs と連携し、2027 年初頭に 2 基のプロトタイプ衛星を打ち上げて、TPU の軌道上動作や衛星間光リンクによる分散学習の実証を行う計画であると報じられています。

Google Research の論文「Towards a future space-based, highly scalable AI infrastructure system design」(通称 Project Suncatcher)によれば、チップ単体ではなく、衛星の軌道高度、通信トポロジー、電源システム、そしてチップ設計を連立方程式として解き、「地上よりもトータルコストが安くなる分岐点」を数理的に導き出そうとしています。これは「宇宙版ハイパースケールデータセンター」を目指す動きと言えます。

3. 欧州 “ASCEND” プロジェクト:環境主権の確保

戦略:「カーボンニュートラル」と「データ主権」

欧州委員会が資金提供するEU主導の研究プロジェクト「ASCEND(Advanced Space Cloud for European Net zero emissions and Data sovereignty)」は、欧州ならではの視点を持っています。Thales Alenia Space らが手掛ける EROSS IOD などのオン軌道ロボット技術も視野に入れながら、「軌道上で組み立て・拡張可能なデータセンター」を目指すコンセプトが示されています。

主な目的は、デジタルインフラの環境負荷(カーボンフットプリント)を劇的に下げること、そして米国のテック企業に依存しない欧州独自の計算資源を確保することです。

4. Lumen Orbit とスタートアップ群

なお、Y Combinator(W24)出身のLumen Orbitは、2025年2月にStarcloudへ社名変更しており、本記事で先述した Starcloud と同一企業です。社名変更の背景には、米通信大手 Lumen Technologies との混同を避ける狙いがあるとされています。Starcloud は累計で約2,100万ドルを調達しており、2025年11月には Starcloud-1 の打ち上げに成功しました。

第四章:経済性と環境(LCA)——本当に割に合うのか?

技術的な実現性が拓かれた今、私たちはより本質的な問いに直面しています。「宇宙にデータセンターを建設することは、ビジネスとして採算が取れるのか?」そして「地球環境にとって本当に持続可能なのか?」。経済合理性と環境負荷(LCA)という、現代のインフラ開発における二つの天秤から、宇宙クラウドの真価を問い直します。

ユースケースと経済合理性

光の速さの限界により、低軌道でも往復数十ミリ秒の遅延が発生するため、Web検索や高頻度株取引には向きません。しかし、以下のタスクには「宇宙」が最適解となります。

- LLMの事前学習 (Pre-training): 数ヶ月かかる計算ジョブ。一度データを上げれば、計算中は通信遅延が関係ないため、24時間の太陽光発電の恩恵をフルに受けられます。

- 気候変動モデリング・創薬シミュレーション: 膨大な計算リソースを必要とするバッチ処理。

- 宇宙エッジコンピューティング: 地球観測衛星が撮影したPB(ペタバイト)級の画像データを、地上に降ろす前に宇宙で解析し、「異常値」だけを送信する。

環境アセスメント(LCA)のジレンマ

「宇宙はクリーン」と言われますが、ロケット打ち上げ時には大量のCO₂やブラックカーボン(煤)を排出します。ライフサイクルアセスメント(LCA)の観点では、以下の条件を満たしたときに初めて「地上よりエコ」になります。

- ロケットの完全再利用: Starshipのように、機体もブースターも再利用し、燃料にメタン(燃焼時の煤が少ない)を使用すること。

- 衛星の長寿命化: 放射線でチップが数ヶ月で壊れては、頻繁な打ち上げが必要になり本末転倒です。数年〜10年単位で稼働させる信頼性が必要です。

- 軌道上リサイクル: 故障したモジュールだけを交換したり、資材を再利用するサーキュラーエコノミーの確立。

結論:宇宙クラウドは、AIインフラの「再定義」である

宇宙クラウドは、単に「サーバーを空に浮かべただけ」ではありません。それは、エネルギー、冷却、用地、環境規制といった、地上におけるあらゆる制約条件(ボトルネック)をリセットし、人類の計算能力を次の次元へ引き上げるためのインフラの再定義です。

技術的な課題は山積みです。熱設計は困難を極め、放射線は容赦なくチップを破壊し、デブリのリスクも常に付きまといます。しかし、SpaceXのStarshipが輸送コストの壁を破壊し、AIの電力需要が地上の限界を超えようとしている今、この選択肢はもはや「夢物語」ではなく、必然的な「次のフロンティア」となりつつあります。

2030年代、私たちが使うAIの回答は、静寂な宇宙空間で、太陽の光を浴びて計算されたものになる——そんな未来が、今まさに始まろうとしています。

専門用語まとめ

- 宇宙クラウド (Space-based Cloud Computing)

- データセンターそのものを地球周回軌道などの宇宙空間に建設・運用するインフラ構想。地上の電力・冷却・用地の制約を、宇宙の豊富な太陽光と放射冷却で解決することを目指す。

- Starship (スターシップ)

- SpaceXが開発する、完全再使用型の超大型ロケット。従来のロケットと比べて輸送コストを劇的に低下させることが期待されており、大量のサーバー機器を宇宙へ運ぶための輸送手段として、宇宙クラウド構想の前提条件となっている。

- 放射冷却 (Radiative Cooling)

- 物体が熱エネルギーを電磁波(赤外線)として放出することで温度を下げる現象。真空の宇宙空間では対流や伝導による冷却ができないため、これが唯一の冷却メカニズムとなる。

- シュテファン=ボルツマンの法則 (Stefan-Boltzmann Law)

- 黒体の表面から単位面積あたりに放射される熱エネルギーが、その絶対温度の4乗に比例するという物理法則。宇宙でのラジエーター設計の基礎となる。

- SEU (Single Event Upset)

- 宇宙放射線が半導体のメモリ素子などに衝突することで、記憶されているビット情報が反転してしまう一時的なエラー(ソフトエラー)。

- TPU (Tensor Processing Unit)

- Googleが開発した、機械学習(特にニューラルネットワーク)の処理に特化した集積回路(AIアクセラレータ)。

- LCA (Life Cycle Assessment / ライフサイクルアセスメント)

- 製品やサービスの寿命全体(資源採取から製造、輸送、使用、廃棄まで)にわたる環境への影響を定量的に評価する手法。

よくある質問(FAQ)

Q1. 宇宙クラウドはいつ頃実用化されますか?

A1. Starcloudによる実証実験が既に始まっていますが、大規模なデータセンターとしての実用化は、Starshipなどの大型ロケットの本格運用と技術的課題の克服次第です。多くの専門家は、2030年代前半頃からの本格的な普及を予測しています。

Q2. 宇宙デブリ(ゴミ)の問題はどうなりますか?

A2. デブリとの衝突リスクは深刻な課題です。運用終了後の適切な軌道離脱(デオービット)や、衝突回避のための自律的な軌道制御技術、さらにはデブリ除去サービスとの連携などが不可欠となります。

Q3. 宇宙クラウドは地上のデータセンターを完全に置き換えるのですか?

A3. いいえ、通信遅延の物理的制約があるため、リアルタイム性が求められる用途には向きません。大規模なAI学習やバッチ処理など、遅延の影響が少ない特定のワークロードを補完する役割が中心となると考えられます。

今日のお持ち帰り3ポイント

- 地上のAIデータセンターは電力・水・場所の限界(2030年の崖)に直面しており、その解決策として宇宙クラウドが注目されている。

- 宇宙クラウド実現には、Starshipによる輸送コスト革命が前提であり、熱・放射線といった物理的課題の克服が鍵となる。

- Starcloud、Google、欧州など多様なプレイヤーが参入しており、AIインフラを根本から再定義する新たな開発競争が始まっている。

主な参考サイト

- IEA: Electricity 2024(2024)

- Google Research: Towards a future space-based, highly scalable AI infrastructure system design(2024)

- SpaceX: Starship(公式ページ)

- European Commission: Horizon Europe – ASCEND Project Details(2022)

- NVIDIA: H100 Tensor Core GPU(公式ページ)

合わせて読みたい

- NVLink vs Broadcom論争の真相|AIネットワークの力学を読み解く

- AIネットワーク三層|NVLink・InfiniBand・Ethernet/Spectrum-X【2025】

- AIインフラ戦争2025|NVIDIA×OpenAI・45兆円契約の全貌

- AI社会再実装の全貌:設計者・実装者・媒介者が描く未来図

- AI半導体英雄譚:GPU・FPGA・ASIC・NPUが共演する『適材適所』の未来

- 〖2025年最新〗MicrosoftとOpenAI:AIエージェント覇権争いの最新動向

- 2025年上半期 総まとめ:AI社会実装を決定づけた4大トレンド

- 初版公開