※本記事は継続的に「最新情報にアップデート、読者支援機能の強化」を実施しています(履歴は末尾参照)。

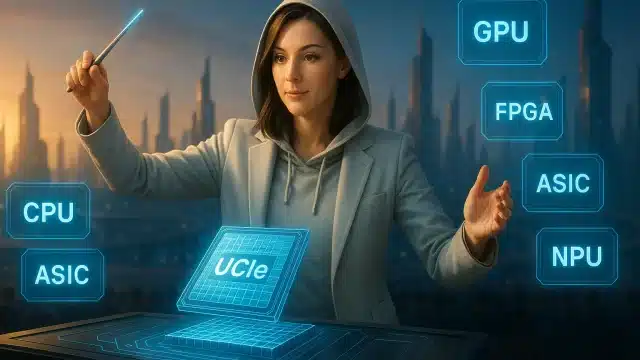

Vera Rubinとは?「AI劇場」を止めない次世代AIデータセンターの仕組みを直感で理解する

AIが賢くなるほど「遅い・高い」と感じる理由は、頭脳(モデル)よりも“劇場の裏方”が詰まってきたからです。

この記事ではVera Rubinを「劇場」に見立て、なぜ今“GPUだけ速くしてもダメ”なのか、そしてRubinがどこを作り替えて突破しようとしているのかを、初心者でも迷子にならない流れで解説します。

1幕:AIが賢くなるほど「遅い・高い」と感じる理由

昔のAIは、短い質問に「一発で答える」タイプでした。ところが今は、長文を読み、外部ツールを呼び、途中で考え直し、検証して、また考える。

まるで“その場で台本を書き換えながら演じ続ける”ような存在になっています。

すると何が起きるか。主演俳優(モデル)が賢くなっても、舞台裏の動線が細いと、俳優は待たされます。

つまりボトルネックは「計算」だけでなく、I/O(出し入れ)・メモリの置き場・クラスタ通信・冷却と電力へと移っていきます。

転機:AIは「答える」から「考える」へ

推論が“思考プロセス込み(Thinking / test-time scaling)”になると、途中メモ(文脈・KVキャッシュ)が膨らみます。

すると同じGPUでも、「計算する速さ」より「メモを捌く速さ」で詰まりやすくなります。

Vera Rubinの定義:なぜ“ラック全体の最適化”が必要になったのか

Vera Rubinとは、NVIDIAが提唱する次世代のAIデータセンター向け「統合プラットフォーム」です。

GPUだけでなく、CPU・ネットワーク・DPU・スイッチ・冷却までを“一つのAI工場”として同時に設計し、推論と学習の伸びを現実の物理制約の中で成立させることを狙います。

まず数字:AI側は「年5倍の要求」、チップ側は「せいぜい年1.6倍」

NVIDIAの発表では、推論(生成トークン)の総量が急増し、AIが欲しがる計算は加速度的に伸びている一方で、トランジスタ増分の伸びは「世代あたり約1.6倍」程度に収束しつつある、という構図が強調されています。

つまり今のボトルネックは「GPUの速さ」ではなく、GPUに台本(データ)を届ける裏方=データセンター全体の都合に移っています。

だからこそ、“主演(GPU)の進化だけでは、劇場(データセンター)が追いつかない”という前提がここで生まれます。

※この先の比喩対応:主演=GPU、段取り=CPU・DPU、通路=NVLink・ネットワーク、劇場=データセンター

だから結論:チップ単体ではなく「劇場まるごと再設計」へ

そこでNVIDIAが選んだ手段が、Extreme Co-design(極限の協調設計)です。

1〜2チップだけ更新する“いつもの世代交代”ではなく、CPU・GPU・NIC・DPU・スイッチ群をまとめて設計し直し、ラック単位で詰まり(待ち時間)を潰していく。

Vera Rubinは、この思想を「実装しきった」プラットフォームだと捉えると理解が早くなります。

2幕:Vera Rubinを「劇場」で直感理解する

ここからはVera Rubinを「劇場」に見立てます。ポイントは構造(箱)と登場人物(役割)を分けること。

先に“箱”を押さえると、後の技術要素がスルッと入ります。

劇場の構造:小さなチームが、巨大な公演へ膨らむ

階層1:Superchip(スーパーチップ=最小チーム)

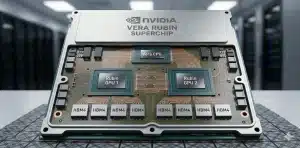

Superchipは、Rubin GPU 2基+Vera CPU 1基が一体になった最小計算ユニットです。

劇場で言えば、主演俳優2人と、段取り係のマネージャーが同じ控室で一緒に動ける状態です。

階層2:コンピュートトレイ(楽屋=サーバーノード)

複数のSuperchipが1枚の「コンピュートトレイ」に同居します。

劇場なら、いくつもの小チームが同じ楽屋フロアで支度し、出番の順番を待つ場所です。

階層3:NVL72ラック(楽屋棟=72GPUを一体運用)

NVL72は、1ラックにRubin GPU 72基(=Superchip 36個)を収め、NVLink 6で“棟内を一体化”する設計です。

ここまで来ると、個々の俳優の速さより、棟内の移動(データ移動)をいかに詰まらせないかが勝負になります。

階層4:クラスタ(劇場施設=数百ラックの大公演)

ラックが数百〜数千本になると、劇場は“施設”になります。

この規模では、主演俳優の実力よりも、施設の交通網(ネットワーク)と運営(冷却・保守)が公演の成否を決めます。

登場人物は6人:劇場を止めない役割分担

❶ Vera CPU(段取りを崩さない“舞台付きマネージャー”)

Vera CPUは、公演が詰まらないように「次の出番」と「次の台本」を前倒しで整える段取り役。

主演が一瞬でも待てば、劇場全体のテンポが落ちます。だから彼は、観客に見えない場所で“遅れの芽”をつぶし続けます。

技術メモ(クリックで開く)

Vera CPUは88個のNVIDIAカスタムArm「Olympus」コア(Arm互換)を中核に、最大1.5TBのLPDDR5X(SOCAMM)と1.2TB/s級のメモリ帯域を持つ構成として紹介されています。

さらにCPU↔GPUはNVLink-C2Cで最大1.8TB/sのコヒーレント接続を提供し、データ供給の待ちを減らす設計です(PCIe Gen6対応も言及あり)。

❷ Rubin GPU(舞台を走り切る“主演俳優”)

Rubin GPUは、実際に演じ切る主演俳優。ただし主演が強くても、台本が遅れ、合図がずれ、舞台転換が詰まれば名演は止まります。

Rubinは「俳優の強化」と同時に、「共演と転換が詰まらない前提」で鍛えられた主演です。

技術メモ(クリックで開く)

Rubin GPUはHBM4を統合し、推論はNVFP4で最大50 PFLOPS級、HBM4帯域は22TB/s級として紹介されています。

重要なのは、計算(演技力)だけでなく、長丁場で詰まりやすい読み書き(メモリ帯域)も同時に底上げしている点です。

❸ BlueField-4 DPU(舞台裏の“搬入責任者”)

BlueField-4は、裏方の物流責任者。長い会話や多段推論で増える「途中メモ」や中間結果を、必要な瞬間に運び、不要なら片づける。

主演が演技だけに集中できるよう、荷物運びと段取りの“重い仕事”を肩代わりします。

技術メモ(クリックで開く)

BlueField-4は64個のArm Neoverse V2コアを搭載し、800Gb/s級の高速ネットワークに対応する世代として紹介されています。

Rubinの文脈では「推論の文脈(コンテキスト)を扱う基盤」も強調され、ストレージ/I/Oやデータ移動を舞台裏で専任することで、GPUの“待ち”を減らす役回りを担います(PCIe Gen6にも言及あり)。

❹ ConnectX-9 SuperNIC(棟をまたぐ“超高速の伝令”)

ConnectX-9は、楽屋棟と楽屋棟の間を走る伝令。大規模公演では、合図だけでなく台本の断片や検証結果が行き来します。

ここが遅いと、主演は舞台で待つことになる。つまり伝令の速さは、公演のテンポそのものです。

技術メモ(クリックで開く)

ConnectX-9はスケールアウトの“終端(エンドポイント)”として、800GbE級の高速Ethernetや低遅延通信(RoCEなど)を担う位置づけで語られます。

分散学習/分散推論で頻発する同期通信の遅れを抑え、クラスタ全体の待ち時間を小さくする方向で設計されています。

❺ NVLink 6 Switch(棟内を一体化する“専用の大動脈”)

NVLink 6は「同じ棟の中だけを、異常に太くする」専用通路。俳優がすぐ集まり、すぐ打ち合わせし、巨大な台本を“ひとつの体”で回せます。

棟の中が別世界になれば、連携の待ちが消えて、公演の回転数が上がります。

技術メモ(クリックで開く)

NVLink 6(第6世代)は、RubinでGPUあたり3.6TB/sのGPU↔GPU帯域が示されています。

NVL72ラック全体では、棟内を束ねた総帯域が260TB/s級として紹介され、巨大モデルを“ラック一体”で扱いやすくする設計の核になります。

※なお1.8TB/sはCPU↔GPUのNVLink-C2C側で語られる数値です。

❻ Spectrum-X(施設全体を回す“交通管制つきシャトル網”)

Spectrum-Xは、劇場施設全体のシャトルと交通管制。ラックが増えるほど、速い道を増やすだけでは渋滞は解けません。

どの道を優先し、どこで詰まりを逃がし、同じ電気代で運べる量を最大化するか。交通整理そのものが次の伸びしろになります。

技術メモ(クリックで開く)

Spectrum-X(Spectrum-6 Ethernet Photonicsを含む)は、AIクラスタ向けEthernetを“渋滞しにくくする”思想で束ねた交通網です。

公式発表では、Ethernet Photonicsスイッチで電力効率と稼働性(uptime)が5倍改善するとされています。

規模が大きいほど、こうした“交通整理”の価値が効いてきます。

まとめ:なぜ6つ全部が必要なのか

Vera Rubinの肝は、主演(GPU)を速くする話ではありません。

“主演が待たされる原因を、劇場のあらゆる場所から消す”こと。

だから6人は、同時に、同じ脚本で設計されます。これがExtreme Co-designです。

推論の「作業机」問題:HBM・KVキャッシュ・外部メモリ

ここは初心者に一番効く直感です。メモリを「作業机」に見立てます。

机(HBM)は近くて速いが小さい。倉庫(外部メモリ/ストレージ)は大きいが遠い。

Thinking AIやエージェントAIは、途中経過のメモが増え続けます。机がメモで埋まると、演技は止まり、「倉庫に預ける→取りに行く」の往復が増えます。

この往復を現実的にするのが、BlueField-4や高速NICという“物流”です。

Rubinは、机を広げるより、机と倉庫の動線を作り替える方向へ踏み込みました。

3幕:Rubinがもたらす「読者にとってのメリット」

メリット1:推論の経済性(トークン単価)を下げ、できることを増やす

NVIDIAはRubinについて、前世代Blackwell比で推論トークンコストを最大1/10にし、MoE学習では必要GPU数を1/4にできると発表しています。

ここで大事なのは数字そのものより、「これまで高すぎて諦めた使い方」が現実になることです。

- 長文の社内規程・契約書を“全部読ませて考えさせる”

- 検索→検証→再推論を回す“エージェント運用”を部署横断で回す

- 同じ電力枠・同じラック数で、処理できる公演(仕事)を増やす

メリット2:クラスタが大きいほど効く(待ち時間を潰す設計)

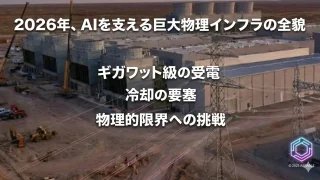

小さな構成では“多少の渋滞”は我慢できます。でも数百ラック規模になると、渋滞は収益そのものを削ります。

Rubinは、棟内(NVLink)と棟間(NIC/スイッチ)を含めて、「止まらない劇場」を狙っています。

メリット3:冷却と保守まで含めて“運用の地獄”を減らす

Rubinは「速い」だけでなく「回しやすい」に踏み込みます。

発表では、入口水温45℃でも冷却でき、チラー不要の運用に言及がありました。

さらにケーブル削減など“物理の手戻り”を潰す方向へ進んでいます。

これは、性能よりも現場では効きます。止まらない=儲かるからです。

専門用語まとめ

- Extreme Co-design

- CPU/GPU/ネットワーク/DPU/スイッチ/冷却などを個別最適ではなく「同時に」設計し、待ち時間(ボトルネック)をラック単位で潰す思想。

- NVL72

- Rubin GPUを72基まとめて扱うラック構成の呼称。棟内をNVLinkで束ね、巨大モデルや高速推論を“ラック一体”で回す発想。

- HBM

- GPU近傍の超高速メモリ。作業机のように速いが容量は有限で、長文脈・多段推論では“机不足”がボトルネックになりやすい。

- KVキャッシュ

- 推論中の文脈(途中メモ)を保持する仕組み。長文脈やThinkingで増え、置き場と出し入れの速度が性能を左右する。

- DPU

- データ移動・ストレージI/O・セキュリティなど“裏方作業”を肩代わりする専用プロセッサ。GPUの待ち時間削減に効く。

- Scale-up / Scale-out

- Scale-upは棟内(ラック内)の高速連携、Scale-outは棟間(ラック間)の拡張。大規模化ほど通信設計が支配的になる。

- AI Factory(AI工場)

- モデルを作り、推論で価値を生み続ける“生産設備”としてデータセンターを捉える言い方。性能だけでなく稼働率・電力・運用が核心になる。

よくある質問(FAQ)

Q1. Vera Rubinは「GPUの新製品名」ですか?

A1. GPU名ではなく、CPU・ネットワーク・DPU・スイッチ・冷却まで含む“統合プラットフォーム”です。

Q2. なぜ今、ネットワークやDPUが主役になるの?

A2. Thinking/エージェント化で文脈や中間結果の出し入れが増え、GPUが“待たされる”時間がボトルネック化するからです。

Q3. 「年5倍のトークン増」とは、どんな意味?

A3. 生成AIの利用が増えるほど、推論で作られるトークン(計算量)が爆発し、チップ単体の進化では追いつかない、という“需要側の伸び”を指します。

Q4. 45℃温水冷却がなぜ重要?

A4. チラー依存を減らし、データセンター全体の電力・設備・運用を軽くできる可能性があるからです(同じ電力枠で回せる量が増える)。

Q5. 初心者が最初に覚えるべき要点は?

A5. Rubinは「主演(GPU)を速くする」より「主演を待たせない劇場を作る」話だと掴むと、細部が全部つながります。

まとめ

Vera Rubinを一言で言うなら、“AIの主演が止まらないよう、劇場まるごと作り替える設計図”です。

AIが「答える」から「考える」へ進むほど、勝負はGPU単体ではなく、データの動線・メモリの置き場・棟内外の交通・冷却と保守へ移ります。

Rubinは、その“裏方の詰まり”をラック単位で潰しにいくアプローチです。

今日のお持ち帰り3ポイント

- AIが賢くなるほど「計算」より「出し入れ(I/O・文脈)」が詰まりやすい。

- RubinはGPUの話ではなく、劇場(ラック/クラスタ)を止めない話。

- 年5倍の需要に、年1.6倍のチップ進化だけで追いつくのは無理――だから“同時再設計(Extreme Co-design)”が必要になる。

主な参考サイト

本記事は一次情報を軸に執筆しています。公式発表・講演・主要メディアを優先し、最低5本の外部リンクで検証可能性を担保します。

- NVIDIA公式:Rubinプラットフォーム発表(2026)

- NVIDIA開発者ブログ:Inside the NVIDIA Rubin Platform(2026)

- NVIDIA公式:Vera Rubin NVL72(仕様ページ)(2026)

- PC Watch:Rubin発表・主要スペックまとめ(2026)

- Tom’s Hardware:Vera Rubin NVL72解説(2026)

合わせて読みたい

- AIが金を掘る時代へ:NVIDIA GTC 2025が示したトークン採掘の未来(背景)

— 「なぜ推論が爆発するのか」を物語として先に掴めます。

- AIインフラ戦争2025|NVIDIA×OpenAI・45兆円契約の全貌(業界の力学)

— Rubinが“技術”ではなく“覇権の道具”になる構図がわかります。

- AIインフラ市場2025最新|NVIDIA独占に挑む各社戦略(市場の全体像)

— 他社の打ち手も含めて、Rubinの位置づけが立体的になります。

- 〖CES2026速報〗ジェンスン・フアン基調講演|物理AIとVera Rubinが定義する産業の再設定(Rubin登場)

— Rubinの“全体設計”思想を、発表の文脈から理解できます。

- NVLink vs Broadcom論争の真相|AIネットワークの力学を読み解く(入門ハブ)

— 「なぜネットワークが主役になるのか」を最短で整理できます。

- AIネットワーク三層|NVLink・InfiniBand・Ethernet/Spectrum-X(仕組み)

— 本編の“劇場の通路と交通網”が一気に腑に落ちます。

- CoreWeaveが拓くAIクラウド新時代:MFU最大化戦略の全貌(運用・ROI)

— 「性能」よりも「稼働率・熱・I/O」で勝つ現場感がつかめます。

更新履歴

- 初版公開(初心者向けストーリー版)