AutoGen完全ガイド:Microsoftの“エージェント統合トレンド”と実装指針【2025年最新】

この記事を読むと、AutoGen v0.4で確立された実装知見(非同期・観測性・Studio)と、Microsoft周辺のエージェント統合トレンド(例:Semantic KernelのAgents強化 等)を踏まえた設計/選定の勘所がわかります。

- 要点1:GroupChat+Managerで自律進行を設計(終了条件と承認ポイントが安定化の鍵)

- 要点2:GUIのAutoGen Studioでローコード構築、観測性はOTelで標準化

- 要点3:比較はAutoGen/LangGraph/CrewAI/MetaGPTの4軸+MCP(補足)で即判断

→ 実装手順は「AutoGenの実装例」へ、評価指標は「評価フレーム(三位一体)」へ。

📨 300通の朝メールから“30分更新”へ

ある地方銀行のバックオフィスでは、毎朝8時に部門横断のメールが300通以上飛び交っていました。人手による集計は遅れ、現場の判断は昼過ぎ。

そこで小さな試みとして、AutoGenの会話駆動チーム(将来的に統合基盤でも同型運用しやすい原型)を導入。調査・分析・要約・検証の各役割を担うエージェントが、30分で経営ダッシュボードを更新するようになりました。

最初の成功で気が緩んだ矢先、「誤集計」を防ぐ停止条件と人間承認が不足していたことが露呈――以降は、この“つまずき”を避ける設計を具体的に解き明かします。

AutoGenとは何か? AIマルチエージェント時代の中心技術

要約:AutoGenは会話駆動でエージェントを協調させる基盤。v0.4で非同期化と観測性が強化され、実装と運用の再現性が上がった。現在はMicrosoft周辺でエージェント統合の動きが進行中。

人工知能(AI)研究の最前線では、単一のAIから複数エージェントが協調するマルチエージェント・システムへの転換が進んでいます。これは人間のチーム運営に似ており、異なる専門性の分担と相互補完で難題を解きます。

本稿はAutoGenを中心に、CrewAI・MetaGPT・状態管理に優れるLangGraphとの比較も交えて解説します。

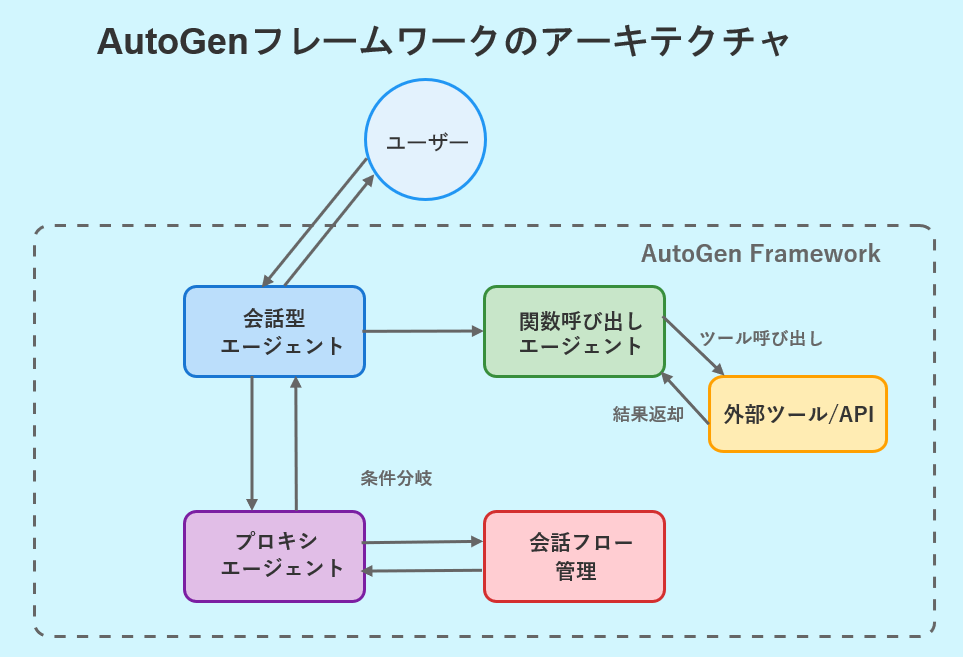

AutoGenのアーキテクチャと構成要素

要約:会話エージェント群とフロー管理が中核。v0.4で非同期・観測性・Studioを実装し、スケールとデバッグ性が向上。

AutoGenはエージェント間の自然言語会話で協調しながらタスクを遂行します。2025年時点のv0.4では、非同期イベント駆動、OpenTelemetry対応の観測性、ドラッグ&ドロップのAutoGen Studioが追加され、実運用に必要な透明性と拡張性が強化されました。

AutoGenの基本コンポーネント

図の要点:主要エージェント(会話/関数呼び出し/プロキシ)と会話フロー管理が連動し、外部ツール接続を会話文脈内で制御する。

- 会話型エージェント:LLMを基盤に対話・調整

- 関数呼び出しエージェント:コード実行やAPIアクセス

- プロキシエージェント:人間承認・コード実行の代行

- 会話フロー管理:

GroupChatとManagerで自律進行

設計思想|協調・透明性・人間の介在

会話協調:自然言語の会議進行で連携とデバッグが容易。

ツール透明性:関数/ツール利用を会話内で明示し可視化。

Human-in-the-loop:高リスク箇所に承認を挟み安全性を担保。

拡張性:役割/ツール/外部APIを柔軟に差し替え可能。

AutoGenの実装例とコード解説(Python)

要約:GroupChat+Managerで自律進行を設計し、停止条件と評価ログを用意するのが実装の肝。

基本的なエージェント設定とタスク実行

【事前準備】インポートとLLM設定

import autogen

from autogen import config_list_from_json

config_list = config_list_from_json(

env_or_file="OAI_CONFIG_LIST",

filter_dict={"model": ["gpt-4", "gpt-4-turbo"]}

)

llm_config = {"config_list": config_list, "temperature": 0, "seed": 42}

ステップ1~3:各役割のエージェントを定義

researcher = autogen.AssistantAgent(

name="Researcher",

system_message="優れた調査員として、事実とデータを収集する。",

llm_config=llm_config,

)

analyst = autogen.AssistantAgent(

name="Analyst",

system_message="データから重要なパターンや洞察を抽出する。",

llm_config=llm_config,

)

user_proxy = autogen.UserProxyAgent(

name="UserProxy",

human_input_mode="TERMINATE",

max_consecutive_auto_reply=10,

code_execution_config={"work_dir": "coding", "use_docker": False},

)

ステップ4: グループチャットによる協調フロー

👨🏫 AI専門家が解説:かみ砕きポイント

GroupChatは会議室、GroupChatManagerは議長。誰がいつ話すか・いつ終えるかを司り、会話を自律進行させます。

groupchat = autogen.GroupChat(

agents=[user_proxy, researcher, analyst],

messages=[],

max_round=12,

)

manager = autogen.GroupChatManager(

groupchat=groupchat,

llm_config=llm_config,

)

user_proxy.initiate_chat(

manager,

message="AIマルチエージェント(AutoGen, CrewAI, MetaGPT)を調査・比較し、短いレポートにまとめて。"

)

逐語解説:この3行が“自律進行”の肝

① max_round:暴走/コストを同時にガード。

② Manager:次発話者と終了判定まで司る。禁止事項と完了定義をプロンプトに明文化。

③ 初手:評価基準・出力形式・差異閾値を最初に付与すると修正コストが激減。

評価フレーム:速度・コスト・品質の三位一体

要約:AutoGenは探索に強い。だからこそ「いつ終わるか」を測る指標設計が必要。速度×コスト×品質を同時に最適化。

| 指標 | 定義 | 目標 | 計測方法 |

|---|---|---|---|

| 速度 | 完了までの分 | ≤ 10 | 開始〜最終出力のタイムスタンプ |

| コスト | API費(円/日) | ≤ 5,000 | モデル別請求×会話回数 |

| 品質 | 人間承認率(一次OK) | ≥ 85% | 承認ログの集計 |

| 安定 | 再現率(再実行で同等) | ≥ 80% | 同プロンプトの週次再試行 |

| 判定根拠 | SLA相当の目標を暫定設定し、月次で閾値を更新 | ||

3つの信号(速度・コスト・品質)を同時に「青」へ揃える運用が現場定着の鍵です。AutoGenは探索が得意な反面、終了条件や差異閾値を曖昧にすると迷走しやすい。先に停止条件・承認ポイント・観測メトリクスを決めるほど、総コストは下がります。

ケーススタディ:営業レポート自動化の一週間

要約:AutoGenで「集める・読む・比べる・要約する」を分業化。停止条件と人間承認を入れて現場定着までを追体験。

- Day1 相談:課題は「速報性」と「誤差」。

- Day2 設計:Researcher/Analyst/Reviewer/UserProxyで分担、差異±3%で承認へ。

- Day3 実装:

GroupChatで自律進行、OpenTelemetryで遅延と失敗箇所を可視化。 - Day4 運用:プロンプト・ドリフトで集計列がずれ、人間承認で即ロールバック。

- Day5 定着:30分→8分、人的確認0.7人日→0.2人日へ。

AutoGen/CrewAI/MetaGPTのユースケース別使い分け

要約:AutoGenは探索/対話、CrewAIは役割遂行、MetaGPTは工程化に強み。要件別に最短経路を選ぶ。

AutoGenが特に優位なケース

- 研究開発やカスタムワークフロー:決まった手順がない探索的タスク。

- 人間との密な連携:フィードバックをループに組み込み協働。

- 既存ツール連携:Python関数や外部APIを多用する複雑タスク。

他フレームワークが適したケース

- CrewAI:役割とプロセスが明確な定型タスク。

- MetaGPT:要求から工程化まで一貫のソフトウェア開発。

⏳ 30日カウントダウン:揺れる要件、迫るデモ

新製品発表まで残り30日。毎日変わる要件と競合情報に翻弄される中、

まずAutoGenで「調査→要約→差分検証」のループを回して霧を払う。

次にCrewAIで日次レポートを固定プロセス化。

最後にMetaGPTでデモアプリの骨組みを即時生成――三者三様の強みが“最短経路”をつくりました。

6. フレームワーク比較(差分早見表)

要約:AutoGen・LangGraph・CrewAI・MetaGPTを同一レイヤーで比較し、用途ごとの適性を即判断。

| 観点 | AutoGen | LangGraph | CrewAI | MetaGPT |

|---|---|---|---|---|

| 設計思想 | 会話駆動・ロール協調 | 状態遷移とガードの明示 | 役割ベースのチーム運用 | 開発工程のテンプレ化 |

| 強み | 探索/対話の柔軟性・拡張性 | 再現性・保守性・テスト容易 | 役割設計の直感性・説明容易 | 工程自動化と一貫性 |

| 向き/不向き | 反復探索◎/厳格制御は工夫要 | 厳格フロー◎/対話設計は手間 | 定型業務◎/細粒度制御は工夫要 | パターン適合◎/柔軟性は限定 |

| 運用観点 | 会話ログで改善しやすい | SRE的運用・テスト整備 | チーム運用の可視化 | ドキュメント化容易 |

| 判定根拠 | PoC〜運用の要件(探索性/再現性/役割分担/工程化)に照らした相対比較 | |||

Key Takeaways(持ち帰りポイント)

- 探索・対話主導ならAutoGen、厳格制御ならLangGraph

- 定型タスクのチーム運用はCrewAI、工程テンプレ重視はMetaGPT

- 実務では「AutoGen × LangGraph」のハイブリッドが現実解になりやすい

トラブルシュート:現場でよく詰まる10の落とし穴

要約:症状→原因→処方箋で即断。プロンプト設計と観測性で大半は未然に回避できる。

- 会話が長引く:終了条件が曖昧 → 完了定義と出力例の明文化

- 堂々巡り:ロール競合 → 入力/出力境界の分離

- 誤集計:列解釈違い → スキーマ固定+差異閾値で停止

- コスト超過:探索の寄り道 → max_round短縮+軽量モデル前段

- API失敗:リトライ無制御 → 指数バックオフ+サーキットブレーカー

- 責任曖昧:人/AIどちらの過失か不明 → 承認ログに理由必須

- モデル更新差異:挙動変化 → 週次リグレッションの自動実行

- 情報漏えい:秘匿取り扱い不備 → PIIマスキング+出力検疫

- 設定散逸:属人化 → IaCで構成管理

- 監査困難:決定経緯が不明 → 会話/ツール実行のトレースID記録

はじめてのAutoGen:最小構成で本番導入まで

要約:PoC→承認→本番の3段階。停止条件と観測性はPoCから仕込む。

- PoC準備:役割・停止条件・評価指標(速度/コスト/品質)を定義

- 最小実装:

GroupChatで調査/要約の2役から開始、max_roundは小さく - 観測性:OpenTelemetryメトリクス+会話ログ保存

- 人間承認:差異閾値(例:±3%)を超えたら承認フローへ

- 拡張:検証/レビュー役の追加と軽量モデルの前段化

AutoGenの導入事例と今後の可能性

要約:現場導入では“会話×観測×承認”が成功要因。今後はGUI設計と横断プロトコル連携の実務適用が進む。

🏭 “止まらないバックログ”を止めた日:ある製造業DXの12週間

不良解析レポートは毎週金曜の夜に滞留し、翌週の対策会議は“先週の振り返り”で終わるのが常でした。品質部と開発部は互いにデータの整合を疑い、議論は空転。そこでAutoGenの会話チームを立ち上げ、現場のエクセルと検査装置ログを突き合わせる役割を担わせました。

初週はうまくいきません。検査ラインのCSVは日によって列順が変わり、集計が静かに崩れる。

2週目、会話フローに停止条件と人間承認を挟み、OpenTelemetryでどのツール実行が遅く誤りやすいかを可視化。

4週目にはレビュー役を追加し、差分が±3%を超えた瞬間に承認待ちへ遷移。

8週目、週次会議は“先週の振り返り”から“今週の意思決定”へ。

12週目、バックログは自然減に転じました。

Microsoftによる導入事例|AutoGenがもたらした成果

Microsoft Researchのブログでは、複数のAIエージェント協調により開発効率/コード品質/学習支援へ効果があった旨が紹介されています(一次情報を参照)。

AutoGenの今後と課題

展望

- GUI設計の進化:Studio等の普及でPoCが加速

- 専門分野への特化:医療・法務などドメイン特化型

- 自己改良メカニズム:評価ループによる継続改善

課題

- コスト管理:マルチエージェントのAPI最適化

- 安全性と制御:ガード/デバッグ/権限分離

- 説明可能性:決定プロセスの透明性確保

まとめ

Microsoft開発のAutoGenは、複数AIエージェントの協調を可能にする柔軟なフレームワークです。GroupChatとAutoGen Studio、そして観測性+承認ポイントが現場定着の三種の神器。加えて、Microsoft周辺のエージェント統合トレンドを踏まえると、いま築く設計原則は将来の統合基盤でも資産として生き続けます。

専門用語まとめ

- マルチエージェント・システム(MAS)

- 自律的に動く複数のAI(役割持ち)が会話やメッセージで連携し、単体では難しい課題を分担して解く仕組み。例:調査・分析・検証が協力してレポートを完成。

- AutoGen

- Microsoft Research発のフレームワーク。複数エージェントを会話で協調させる。v0.4で非同期処理、OpenTelemetry対応の観測性、GUIのStudioが加わり、PoC〜運用まで扱いやすい。

- AutoGen Studio

- ドラッグ&ドロップで役割・ツール・会話フローを組めるGUI。コード量を減らし、実験から共有・実行までを素早く回せる。ログ閲覧や設定変更も画面から行える。

- GroupChat / GroupChatManager

- GroupChatは「会議室」、Managerは「議長」。誰が次に話すか、いつ終えるかを自動で調整する。max_roundや停止条件を設定して暴走や無駄な会話を抑えられる。

- LLM(大規模言語モデル)

- 大量のテキストで学習し、文章の理解・生成・要約・簡単な推論やコード生成を行うAI。エージェントの「頭脳」として利用され、指示に沿って会話や作業を進める。

- OpenTelemetry(OTel)

- トレース・メトリクス・ログを共通形式で収集するオープン標準。会話やツール実行の流れを一続きで可視化し、遅延や失敗箇所を特定。デバッグや監査に有効。

- MCP(Model Context Protocol)

- AIが外部ツールやデータに安全にアクセスするための接続プロトコル。権限やログを前提に再利用しやすくし、AutoGenやLangGraph等の上でも横断的に使える。

よくある質問(FAQ)

Q1. 統合トレンド下でAutoGen設計は無駄になりませんか?

A1. 無駄になりません。会話設計・観測性・終了条件/承認の原則は統合基盤でも共通。AutoGenで作った役割・プロンプト・指標はそのまま資産化できます。

Q2. コスト最適化の第一歩は?

A2. max_round短縮+軽量モデル前段が基本。要約→最終だけ高性能に切替、キャッシュ活用、トークン上限設定、週次で会話ログの失敗パターンを反映します。

Q3. 幻覚や誤集計はどう防ぐ?

A3. データのスキーマ固定、差異閾値(例±3%)で停止→人間承認、出力検疫、ツール実行の完全ログ化。参照元と根拠を出力に必ず付けます。

Q4. 人間承認はどこに挟むべき?

A4. 差異閾値超え、外部送信前、金額・法務関連、初期運用の4点。承認時は理由を必須化し、翌スプリントでプロンプトとガード条件へ確実に反映します。

Q5. 観測では何を見ればよい?

A5. レイテンシ、失敗率、会話回数、API費用、再現率が基本指標。OpenTelemetryで会話とツール実行に同一トレースIDを付け、遅延と責任範囲を可視化します。

主な参考サイト

合わせて読みたい

- 【2025年最新】Vertex AI Search / Agent Builder × Gemini 2.5 で作る超高速RAGシステム

- AIマルチエージェント協調技術の革新:MCP、CrewAI、MetaGPTが変える開発の未来

- Anthropic MCPで拓く!AI連携とビジネス活用の第一歩

- CrewAI: マルチAIエージェントの新たなフロンティア

- MetaGPT完全ガイド:AIエージェント協調によるソフトウェア開発革命

更新履歴

- 初版公開

- v0.4反映・全面改訂

- “エージェント統合トレンド”を反映(H1/リード/結論/Top FAQ/比較表キャプションを再構成、物語パート整備)