【2025年10月更新版】Google I/O ’25で発表されたパーソナルAIの現在地と未来

発表から5ヶ月、何が本当に動いたのか?Gemini 2.5以降の実装と影響を検証

Google I/O ’25で示された「パーソナルAI」は、発表から5ヶ月でAIモードの日本語対応など一部が現実のものとなりました。この進化は、AIが単なるツールからユーザー一人ひとりの文脈を理解し代行する「ユニバーサルAIアシスタント」へと変貌する時代の到来を告げています。

- 要点1:AIモードのグローバル展開と日本語対応の実現

- 要点2:カメラや音声で対話するマルチモーダルAIの実用化

- 要点3:個人の文脈を理解し、行動を代行するエージェント機能の段階的実装

→ 具体的な応用例は「パーソナルAIの具体的応用例」へ、最新の実装状況は「基調講演の5大発表ポイントのサマリー表」へ。

Google I/O ’25開催概要とその意義

Google I/Oはテクノロジーの未来を示す重要なショーケースとなっている。

2025年のGoogle I/Oは、5月20日から21日(現地時間)にかけて、米カリフォルニア州マウンテンビューにあるShoreline Amphitheatreにて開催された。オンラインでも全世界に無料でライブ配信され、開発者や技術者のみならず、あらゆるテック関係者が注目する世界的イベントとなっている。

Google I/O は、春の「Google Cloud Next」、秋の「Made by Google」とともに、Google の主要な年次イベントのひとつであり、中でもI/OはAndroid、Gemini、Chrome、Firebaseなど、Googleの基幹ソフトウェア技術や開発者向けツールの未来を初めて明らかにする中核会議だ。

今回の基調講演の中心的なテーマは、「個人的(personal)」「先を見越した(proactive)」「強力な(powerful)」という3つの要素を持つAIの実現でした。

ピチャイ氏はこれを「ユニバーサルAIアシスタント」というビジョンの基盤として位置づけ、人々の生活をより豊かで生産的にするための技術として提示しました。

こうした「パーソナルAI」の登場は、これまでのAIの進化の延長線上にある“次のステージ”を意味します。

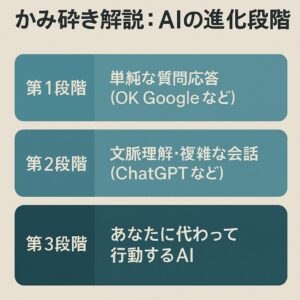

理解しやすくするため当サイト独自に以下の3段階に整理します。

※Google公式の定義ではありません。

- 第1段階:質問応答型AI

単純な音声命令に応答する「OK Google」や「Siri」に代表される、単機能の応答型AI。 - 第2段階:対話型AI(文脈理解型)

ChatGPTやGemini 1に見られるような、文脈を理解し複雑な会話ができるAI。 - 第3段階:パーソナルAI(行動型AI)

Google I/O ’25で発表されたGemini 2.5に代表される、“ユーザーの代わりに考え・行動する”AI。視覚情報や個人文脈を理解し、主体的にタスクを実行するのが特徴です。

基調講演の5大発表ポイント

GoogleのAI戦略が単なる検索からパーソナルアシスタントへとステップアップした。

1. Google Beam (旧Project Starline):3D会議の未来形

遠隔会議体験を根本から変革する新技術として登場したGoogle Beam。

Google Beamは、複数カメラで捉えた2D映像をAIがリアルタイムで統合し、まるで同じ部屋にいるような没入感のある3D体験を提供します。従来のビデオ会議の限界を超え、非言語コミュニケーション(ジェスチャーや視線など)も伝わる新しいコミュニケーション手段として位置づけられています。

HPは「HP Dimension with Google Beam」を $24,999 で発表(ハードウェア価格、Google Beamソフトウェアライセンスは別売)。2025年後半に選定顧客へ提供予定。対応地域:米・加・英・仏・独・日。

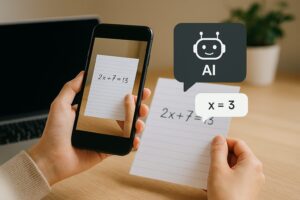

2. Gemini Live:Project Astra 技術が実現した “目で見て話す” AI

スマートフォンのカメラを通してAIが世界を理解する機能が実用化。

Gemini Liveは、「Project Astra」という研究プロトタイプの技術を製品に実装した機能です。Astra自体は製品ではなく、そのマルチモーダルな認識能力がGemini LiveやAI検索モードなどに順次展開されています。この機能により、ユーザーはカメラや画面共有を通じて、目の前の物体や画面上の情報についてAIと自然に対話できるようになります。

例えば、難しい数学の問題をカメラで映せば解法を説明してもらえたり、DIY作業中に工具の使い方をリアルタイムで教えてもらえたりするなど、実世界との連携が強化されました。I/O当日に無償提供の方針が示され、機能は順次拡大中です(Astra技術の実装ライン)。

3. Agentic Capabilities (旧Project Mariner):ユーザーの意図を理解しAIが代わりに動く

ユーザーの意図を理解し、Webと連携して複雑なタスクを自律的に実行。

Project Marinerの研究成果を製品化したこの機能は、AIがユーザーに代わって複雑なタスクを実行できるエージェント機能です。複数のタスクを同時に管理したり、「教示と繰り返し」によって学習したりする能力を持ちます。

具体的な例としては、特定の条件(価格が下がった時など)で自動的に商品を購入したり、複数のウェブサイトから情報を収集して総合的なレポートを作成したりといったタスクを自動化できます。Geminiアプリや検索機能への統合が進められています。

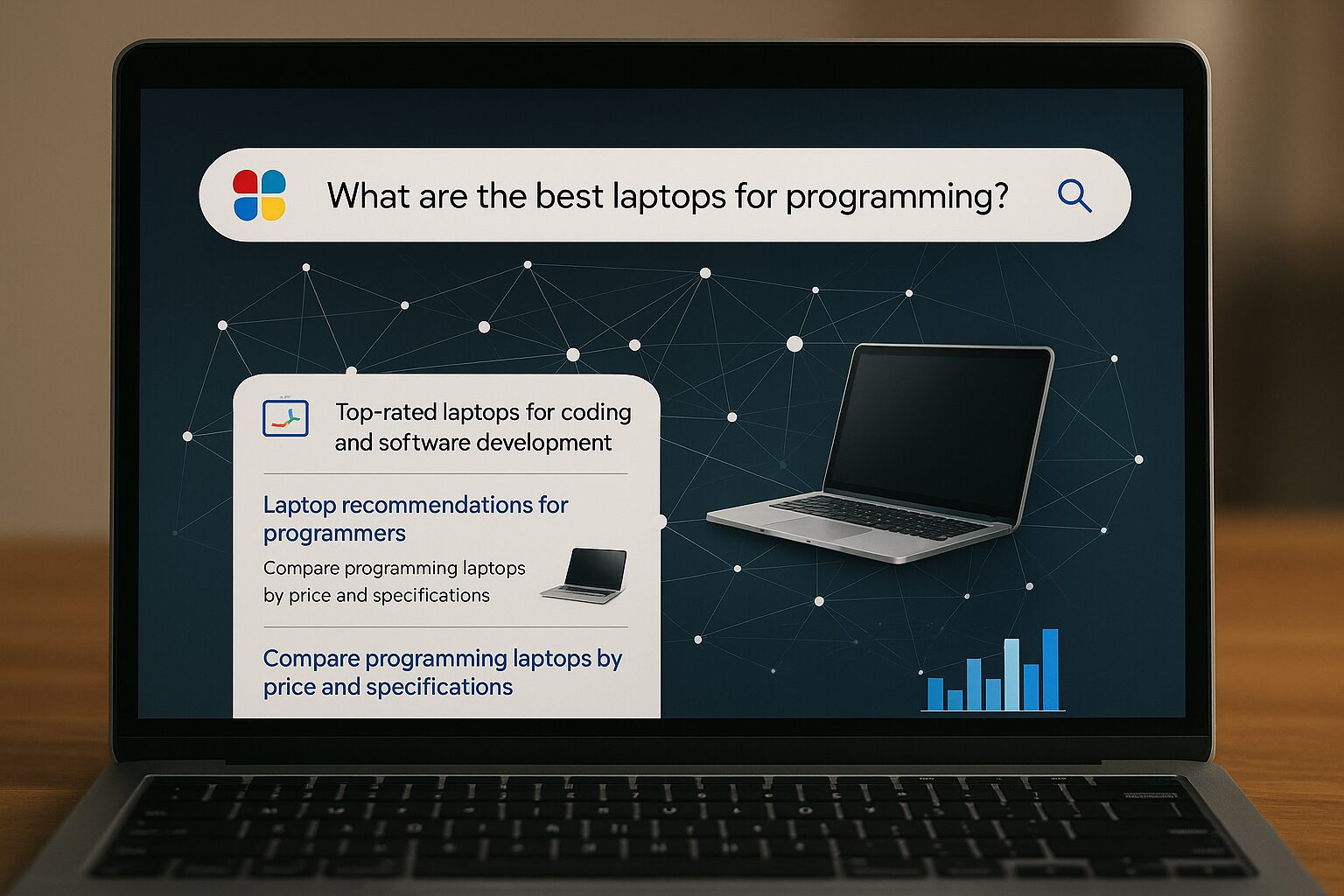

4. AIモードによる検索体験の刷新

検索の「次の大きな一歩」として、従来の検索体験を完全に再構築。

GoogleはAIモードを通じて検索体験を根本から再設計しました。Gemini 2.5モデルを中核として、複雑な質問に対しても多角的に情報を収集・整理し、対話形式で回答を提供します。

従来の検索では2〜3単語程度だった検索クエリが、AIモードでは文章単位の長い質問も扱えるようになりました。さらに「クエリファンアウト(query fan-out)」という新手法により、複雑な質問を分解して並列的に多数の検索を実行し、より深く多角的な情報を提供できるようになっています。米国では2025年5月20日に開始。その後、9月8日に日本語を含む複数言語へ拡大し、10月の月次まとめでも拡大が案内されています。

5. Personal Context:パーソナルデータとの連携

ユーザーのデータを活用し、よりパーソナライズされた回答を提供。

Personal Contextは、ユーザーの許可を得た上で、GmailなどのGoogleアプリ内の個人情報をGeminiが活用できるようにする機能です。

過去の検索履歴、メールの内容(旅行の予約確認など)、アプリの使用状況に基づいて、より個人的で役立つ提案や回答が可能になります。

プライバシーと透明性を重視し、ユーザーがデータの共有範囲を完全にコントロールできる設計になっています。【2025/10更新】 8/13以降、Personal Context(過去チャットの活用)とTemporary Chatが段階展開。既定オン/設定からオフに変更可。

| 評価軸 | I/O時の予定 | 現在の状況 |

|---|---|---|

| Gemini Live | 当日案内 | 無償方針の下で順次拡大(Astra技術を段階実装)。 |

| AIモード | 米国から開始 | 9/8に日本語対応を公式発表、以降も拡大案内。 |

| Search Live | 6月:Labs試験 | 9/24 米国英語で正式開始(Googleアプリの「Live」)。 |

| Virtual Try-On | 衣料で拡大 | 10/8 靴に拡張。数週間以内に日本・豪・加へ展開。 |

| Google Beam(HP Dimension) | 2025年内 | $24,999(ハード)+ Beamライセンス別売。2025年後半に選定顧客へ提供。 |

| Personal Context | 今夏の予定 | 8/13 段階展開開始(既定オン/Temporary Chatあり)。 |

| Agentic機能 | 数ヶ月以内 | Labs/AI Ultra中心で実験拡大。決済はAP2の枠組みを公開。 |

パーソナルAIという新戦略

Googleの次世代戦略は、単なるAIからパーソナルAIへと進化している。

スンダー・ピチャイ氏のスピーチで最も強調されたのは、「ユニバーサルAIアシスタント」のビジョンです。これは単なる情報検索や質問応答を超え、ユーザーの文脈を深く理解し、先回りして行動し、複雑なタスクを自律的に実行できるAIを目指すものです。

Geminiアプリを核として実現を目指すこのビジョンは、「世界モデル」としてユーザーの文脈を理解し、カメラや画面共有を通じて現実世界の情報も活用します。

これにより、ユーザーに代わって計画を立てたり、複雑なタスクや日常的な事務作業を効率化・自動化したりすることで、生活をより豊かに、生産的に変える可能性が語られました。

かみ砕き解説:パーソナルAIとは何か

パーソナルAIとは、あなたの「秘書」のような存在です。

- あなたのスケジュール、好み、習慣を理解している

- あなたが見ているものを理解できる

- あなたの代わりにWebで調査や予約ができる

- あなたの許可を得た範囲で、あなたに代わって行動できる

パーソナルAIの具体的応用例

日常生活のあらゆる場面でAIが活躍する未来像が示された。

📢 2025年9月:AIモード、日本語対応を正式発表

9月上旬、AI Mode が日本語を含む複数言語に拡大。段階的なロールアウトで提供範囲を拡大中です。

- マルチモーダル:テキスト/音声/画像で質問

- 会話継続:追問に文脈を引き継いで回答

- 視覚提示:画像・箇条書き・リンクで要点整理

※展開は段階的。10月の月次まとめでも拡大が案内。

検索体験の革新

AIモードによる検索は、従来のキーワード検索から大きく進化しています。Gemini 2.5モデルを中核として、複雑な質問に対しても、ウェブ全体から関連情報を多角的に収集・整理して提供します。

特筆すべきは「クエリファンアウト(query fan-out)」という新手法です。これにより、AIが複雑な質問を分解し、Knowledge Graph、Shopping Graph、ローカルデータなどから同時に多数の検索を実行し、単一の検索でより深く多角的な情報を提供します。

かみ砕き解説:「クエリファンアウト(query fan-out)」とは?

従来の検索は、ユーザーの入力したキーワードに対して1つの検索結果を返すものでした。

一方、「クエリファンアウト(query fan-out)」では、複雑な質問をAIが細かいサブクエリに分解し、それぞれを同時に検索します。

例えば「東京でおすすめの週末旅行プランは?」という質問に対しては、AIが以下のように分解して検索します:

- 東京の観光地ランキング

- 週末の天気予報

- 宿泊施設の空き状況

- 交通アクセスの所要時間

- 地元グルメのおすすめ

そして、それらを統合して「最適なプラン」を提案するのがこの技術の特徴です。

【2025/10追記】Search Live:音声とカメラで“話しかける検索”

- 9/24 米国英語で正式開始(Googleアプリの「Live」)

- 音声会話+カメラ共有でリアルタイム支援

- Transcriptで後からテキスト確認/作業中のバックグラウンド継続

※日本の提供時期は未公表(段階展開)。

Deep Research:専属リサーチアシスタント

複数サイトを横断して収集・分析し、出典リンク付きレポートを自動生成。

- 12/11/2024:公式発表(Advanced向け)

- 3/13/2025:45+言語へ拡大/一部無料トライ可

市場・競合調査や技術レビューなど「本来は数日かかる調べ物」を数分で下書きまで到達。

| 評価軸 | 候補A (Gemini 2.5 Pro) | 候補B (Gemini 2.5 Flash) |

|---|---|---|

| Latency | —(実測非公開) | —(実測非公開) |

| Cost(円/1k tokens) | 約 1.13円 (入力時) |

約 0.28円 (入力時) |

| 判定根拠 | 価格はGemini API公式のUSD単価(Pro: $7/1M tokens, Flash: $1.75/1M tokens)を採用。円換算は社内レート162円/ドルで計算。一般にFlash=低コスト・軽量/Pro=高品質・高負荷。 | |

ショッピング体験の変革

GoogleショッピングにおけるAI活用も大きく進化しました。特に注目すべきは以下の機能です。

❶ Visual Shopping(ビジュアルショッピング)

テキストでの説明(例:「明るいグレーのソファに合う、部屋を明るくするラグ」)から、関連性の高い商品の画像モザイクを生成。ユーザーの過去の検索スタイルも考慮してパーソナライズされます。

❷ Virtual Try-on(バーチャル試着)

ユーザーが全身写真をアップロードすると、ファッション向けに訓練された画像生成モデルと3D技術により、その写真上で衣服がどう見えるかをリアルにシミュレーション。

【2025/10更新】 10/8に靴への対応を公式発表。数週間以内に日本・オーストラリア・カナダへ順次展開。Google検索/ショッピングから利用可能。

❸ Agentic Checkout(エージェントによるチェックアウト)

商品の購入を自動化する機能。

ユーザーが欲しい商品と目標価格を設定すると、AIが価格を追跡し、下がった際に通知。指示があれば、Google Payを使って安全に購入手続きを完了させます。Labs/AI Ultra中心の実験的段階で拡張中。決済はAP2(Agent Payments Protocol)の枠組みが公表されています(一般提供時期は未定)。

コミュニケーションの未来形

Google Beam(旧Project Starline)は、複数カメラで捉えた映像をAIがリアルタイムで3D化し、まるで同じ部屋にいるような臨場感のあるビデオ通話を実現します。これにより、遠隔地にいても非言語コミュニケーション(視線やジェスチャー)まで含めた自然なコミュニケーションが可能になります。

実装ユースケースの広がり(2025年10月時点)

- 小売:アパレルECでのバーチャル試着(衣料→靴へ拡張)、来店前のサイズ・コーデ検討をオンライン完結。

- 教育:Gemini Liveのカメラ共有で、理科実験や工作のステップ解説をリアルタイム支援。

- 社内コミュニケーション:遠隔拠点間の合意形成で、臨場感の高い3D会議(Google Beam系)により非言語情報の伝達を補強。

- 業務自動化:価格監視や在庫確認など繰り返し作業をエージェントが代行、担当者は例外処理と意思決定に集中。

※ 具体的な導入事例は公表状況に依存します。固有名詞の引用は一次情報で確認のうえ随時更新してください。

ご利用上の注意:AIモードやエージェントによる自動行動は現在も精度向上の途上です。特に医療・法務・金融などの高リスク領域では、必ず一次情報や専門家の確認で裏付けを取り、最終判断は人間が行ってください。

役割別ポイント&アクション

各立場で注目すべきポイントと具体的なアクション

| 役割 | 注目ポイント | 具体的アクション |

|---|---|---|

| CEO/CTO | パーソナルAIが産業構造に与える影響 | ・自社製品/サービスへのAIエージェント機能の統合検討 ・Google BeamなどのB2B向け早期採用プログラムの調査 |

| プロダクトマネージャー | ユーザー体験の根本的変化 | ・Gemini APIの活用で製品のパーソナライズ能力向上 ・カメラ/画面共有機能の自社アプリへの統合可能性 |

| ITマネージャー | 社内業務効率化のポテンシャル | ・Google Beamの社内コミュニケーション導入検討 ・Gemini LiveとWorkspace連携による業務効率化 |

| コンサルタント | クライアント企業へのAI導入戦略 | ・パーソナルAIを活用した業界別変革シナリオの策定 ・プライバシーと効率性のバランス設計支援 |

| 研究者/エンジニア | 技術的可能性と実装課題 | ・クエリファンアウト(query fan-out)技術のベンチマーク調査 ・Gemini 2.5モデルAPIの検証とPoC開発 |

専門用語まとめ

- パーソナルAI (Personal AI)

- ユーザー個人のスケジュール、好み、検索履歴などの文脈を深く理解し、先回りして情報提供やタスクの実行を支援するAI。単なる応答だけでなく、個人の「秘書」のように振る舞うことを目指す。

- クエリファンアウト (Query Fan-out)

- ユーザーからの複雑な一つの質問を、AIが複数の小さなサブクエリに自動で分解し、並列的に検索を実行する技術。これにより、一度の検索で多角的かつ深い回答を生成することが可能になる。

- エージェント機能 (Agentic Capabilities)

- ユーザーの指示に基づき、AIが自律的にWebサイトの操作、情報収集、商品の購入予約といった複数のステップにまたがるタスクを代行する能力。単なる情報検索を超え、「行動」を実行する点が特徴。

- マルチモーダルAI (Multimodal AI)

- テキストだけでなく、画像、音声、動画など複数の異なる種類の情報(モダリティ)を統合的に理解・処理できるAI。スマートフォンのカメラをかざして質問するなど、より直感的な対話を実現する。

- AP2 (Agent Payments Protocol)

- AIエージェントがユーザーに代わって安全にオンライン決済を行うためにGoogleが提唱するオープンな技術規格(プロトコル)。暗号署名などを活用し、AIによる取引の信頼性と安全性を担保する。

パーソナルAIに関するQ&A

Q1: パーソナルAIとこれまでのAIの違いは何ですか?

A1: パーソナルAIは従来のAIと比較して3つの重要な違いがあります。第一に「文脈理解」が深まり、ユーザーの過去の行動やデータを理解して個人化された応答が可能になります。第二に「マルチモーダル能力」が向上し、テキストだけでなくカメラや画面共有を通じて視覚情報も処理できます。第三に「エージェント機能」が加わり、ユーザーに代わってWebサイトの操作や購入などの行動を実行できるようになります。

Q2: プライバシーはどのように保護されるのですか?

A2: Googleは「Personal Context」機能においてプライバシー保護を重視しています。ユーザーは共有するデータの範囲を完全にコントロールでき、いつでも設定を変更できます。また、データの使用状況は透明に表示され、AIが個人データにアクセスする場合は明示的に通知されます。個人データの使用は、ユーザーがオプトインした場合のみ有効となる設計です。

Q3: 日本でのサービス開始時期はいつ頃ですか?

A3: AI Mode は 2025年9月8日に日本語対応を公式発表。機能ごとに展開時期が異なるため、最新の公式情報を参照してください。

Q4: これらの機能を企業はどのように活用できますか?

A4: 企業にとっては主に3つの活用方法があります。1つ目は、Google Beamによる臨場感のある遠隔会議での社内コミュニケーション強化です。2つ目は、エージェント機能を活用した業務プロセスの自動化で、特に定型業務の効率化が期待できます。3つ目は、顧客体験の向上で、Virtual Try-onなどのAI機能を自社のECサイトに統合することでユーザー体験を向上させられます。

Q5: AIモードの検索が普及すると、SEO戦略はどう変わりますか?

A5: AIモードの検索普及により、SEO戦略は大きく変化することが予想されます。従来のキーワード最適化から「質問応答型」のコンテンツ設計へのシフトが必要になります。また、「クエリファンアウト(query fan-out)」により複数の検索が同時実行されるため、幅広いトピックをカバーする包括的なコンテンツが評価される傾向が強まるでしょう。さらに、構造化データの重要性が増し、AIが情報を正確に抽出できるようなマークアップがより重要になります。

Q6: AP2(Agent Payments Protocol)とは?

A6: AIエージェントが安全に決済を実行するためのオープンプロトコル。Mandate(暗号署名の委任)で認可・真正性・責任追跡を担保し、多様な決済手段と連携します。

結論:Googleが描くAIの未来

GoogleのAI戦略は「研究から日常へ」という変化を象徴している。

Google I/O ’25でスンダー・ピチャイ氏が提示したビジョンは、AIが抽象的な研究技術から私たちの日常生活に深く入り込み、個人の文脈を理解し、先回りして行動する「パーソナルAI」の時代の到来を示すものでした。

Geminiアプリを中心とした「ユニバーサルAIアシスタント」の実現は、AIが単なる情報提供ツールから、複雑なタスクを代行し、現実世界の課題に応える方向へと進化していることを象徴しています。

Google Beam、Gemini Live、AIモード検索、Personal Contextなどの機能は、それぞれが独立した製品ではなく、一貫したビジョンのもとに統合されたエコシステムの一部として機能します。これにより、AIはより自然に、より個人的に、そして私たちの生活をより豊かにする方向へと進化していくでしょう。

企業や組織は、こうしたAIの進化を単なる技術トレンドとしてではなく、ビジネスモデルや顧客体験を根本から変革する可能性を持つものとして捉え、早期からの検討と対応が求められています。

更新履歴

- 初版公開

- 最新情報にアップデート、読者支援機能の強化

参考サイト

- Google I/O ’25 公式サイト

- Google Blog「Google I/O 2025: From research to reality」

- The Verge「The 15 biggest announcements at Google I/O 2025」

- TechCrunch「Google’s 3D teleconferencing platform, now called Beam, will ship later in 2025」

- Stanford HAI「The 2025 AI Index Report」

- Google AI for Developers「Gemini Models(2.5)」

以上