AIチップ覇権戦争2025: NVIDIAの銀河系戦略に挑む反逆者たち

この記事を読むとAIチップ業界の覇権争いの構図が分かり、今後の技術トレンドを予測できるようになります。

📖 読了時間 22分 | 🎯 対象:経営者, 技術戦略担当者, エンジニア | 🛠 難易度:中級

3行まとめ:

①NVIDIAはNVLink Fusionで異種チップを取り込む“AIファクトリー”へ

②対抗勢力はシステム完結型・クラウド独自チップ・オープンソースの三つ巴

③HBM4の供給が2026年覇権を左右する

この記事の信頼性の源泉

AIの仕組みをやさしく解説します。筆者は長年ハード・ソフト、クラウド、人工知能を手がけるエンジニアで、2015年からディープラーニングや生成AI・LLMを継続的に研究。現場経験を生かし、最新情報を噛み砕いてお届けします。

AI時代の覇権は、その心臓部である「AIチップ」を制する者が握る。絶対王者NVIDIAを中心に、Intel、AMD、そして巨大クラウド企業が入り乱れる壮絶な開発競争が始まった。本記事では、2025年を舞台に繰り広げられる技術と戦略の最前線を、物語と共に解き明かしていく。

AIという現代の錬金術。その心臓部である「AIチップ」は、今や国家レベルの戦略的重要性を持つ技術領域となっています。この”魔法の石”を巡る主要企業間の競争は新たな局面を迎えており、業界構造の大きな変化が予想されます。

この記事では、絶対王者NVIDIAが描く未来と、それに「待った」をかける挑戦者たちの壮絶な戦いを、最新の事実を基に、少しだけ物語のスパイスを加えて解説します。

帝国の逆襲:NVIDIAが仕掛ける銀河系戦略

◆ セクション要約:絶対王者NVIDIAは、競合さえも自らのエコシステムに取り込む新戦略「AIファクトリー」構想を発表。恐怖による支配から、魅力による、より強固な支配体制へと移行しようとしています。

NVIDIAの新戦略「AIファクトリー」は、自社のGPUだけでなく、競合のカスタムチップさえもNVLink Fusionで接続し、巨大なエコシステムを形成する。これは、全ての技術を自らの銀河系に引き込み、中心で支配するプラットフォーマーとしての野望の現れだ。1年ごとに更新されるロードマップがその勢いを加速させる。

AIの世界に君臨している帝国、NVIDIA。その力の源泉は、世界中の開発者を繋ぎ止める「CUDA(クーダ)」という名の強力な鎖でした。一度この鎖に繋がれれば、他のプラットフォームへの乗り換えは困難を極める。

競合他社はこれを「CUDAの壁」と呼び、その圧倒的な支配力に震えてきました。ある調査では、AI開発者の80%以上がCUDAを主要な開発環境として利用しているとされ、既存のコード資産や長年のノウハウを捨てて他のプラットフォームに移行するコストは、プロジェクトによっては数百万ドル規模に達するとも言われています。まさに、技術的な優位性だけでなく、経済的な合理性もが競合の行く手を阻んでいるのです。

しかし、永遠に続く帝国はありません。MicrosoftやGoogleといった、NVIDIAの最大顧客でもあった巨大な”藩国”が、自らAIチップを開発し、「NVIDIA包囲網」を形成し始めたのです。帝国の支配に、影が差し始めたのでしょうか?

しかしここで終わる帝国ではありません。2025年、NVIDIAは誰もが予想しなかった一手を打ちます。これまでの「恐怖」による支配から、「魅力」による支配へと、その戦略を180度転換したのです。

それが、「AIファクトリー」構想です。

これは、「NVIDIAのシステムに接続できる規格さえ使えば、どんな会社のチップでも歓迎する」という、まるで開かれた銀河連邦のような構想です。

これまで敵と見なしてきたはずの競合チップでさえ、自らの銀河系に組み込む。敵を排除するのではなく、敵さえも呑み込み、自らが宇宙の中心(ハブ)となることで、より強固で、より巨大な支配圏を築こうという、底知れぬ野望の現れです。

【技術的視点】NVIDIAの最新ロードマップと新戦略

上記の物語的解釈は、NVIDIAが2025年5月の国際会議「Computex(コンピューテックス)」で発表した実際の戦略に基づいています。

1. 驚異の1年周期ロードマップ

NVIDIAは、Computex 2025の基調講演で「主要チップを毎年更新する」ロードマップを発表しました(※正式な製品仕様や発売時期は変更される可能性があります)。公表されたロードマップでは2024年 Blackwell(ブラックウェル)、2026年 Rubin(ルービン)へと続き、さらにJensen Huang CEOは”次々世代”のGPUを「Feynman(ファインマン)」というコードネームで紹介しましたが、こちらの仕様や投入時期はあくまで計画段階です[出典]。

2. 「AIファクトリー」戦略の核心

この戦略の核心は、NVIDIAが2025年に発表した「NVLink Fusion(エヌブイリンク・フュージョン)(旧 NVLink-C2C)」という超高速インターコネクト技術をAI Factory構想の物理レイヤとして標準化した点にあります。これにより、顧客は自社開発のカスタムチップとNVIDIA製GPUを一つのシステム内でシームレスに連携させることが可能になります。

🎯 Key Takeaways(お持ち帰りポイント)

- 【経営層への示唆】

NVIDIAの戦略転換は、自社がAIインフラの「プラットフォーマー」であり続けるという強い意志の表れ。単一ベンダーへの依存リスクは残るが、カスタムチップとNVIDIA製品を組み合わせるハイブリッド戦略の検討が可能になった。 - 【開発・技術者への示唆】

NVLink Fusionが導入されたことで、NVIDIA GPUと外部ASIC/CPUをメモリ一貫性を保ったままダイレクト接続できるようになった。既存のCUDAソフトウェア資産を活かしつつ、画像処理・通信・符号化などに特化したチップレットを同じNVLink Fabricに組み合わせることで、ワークロード単位で“性能とTCOを同時に最適化”できる設計オプションが現実化している。

反逆者たちの同盟:NVIDIAに対抗する3つの戦略

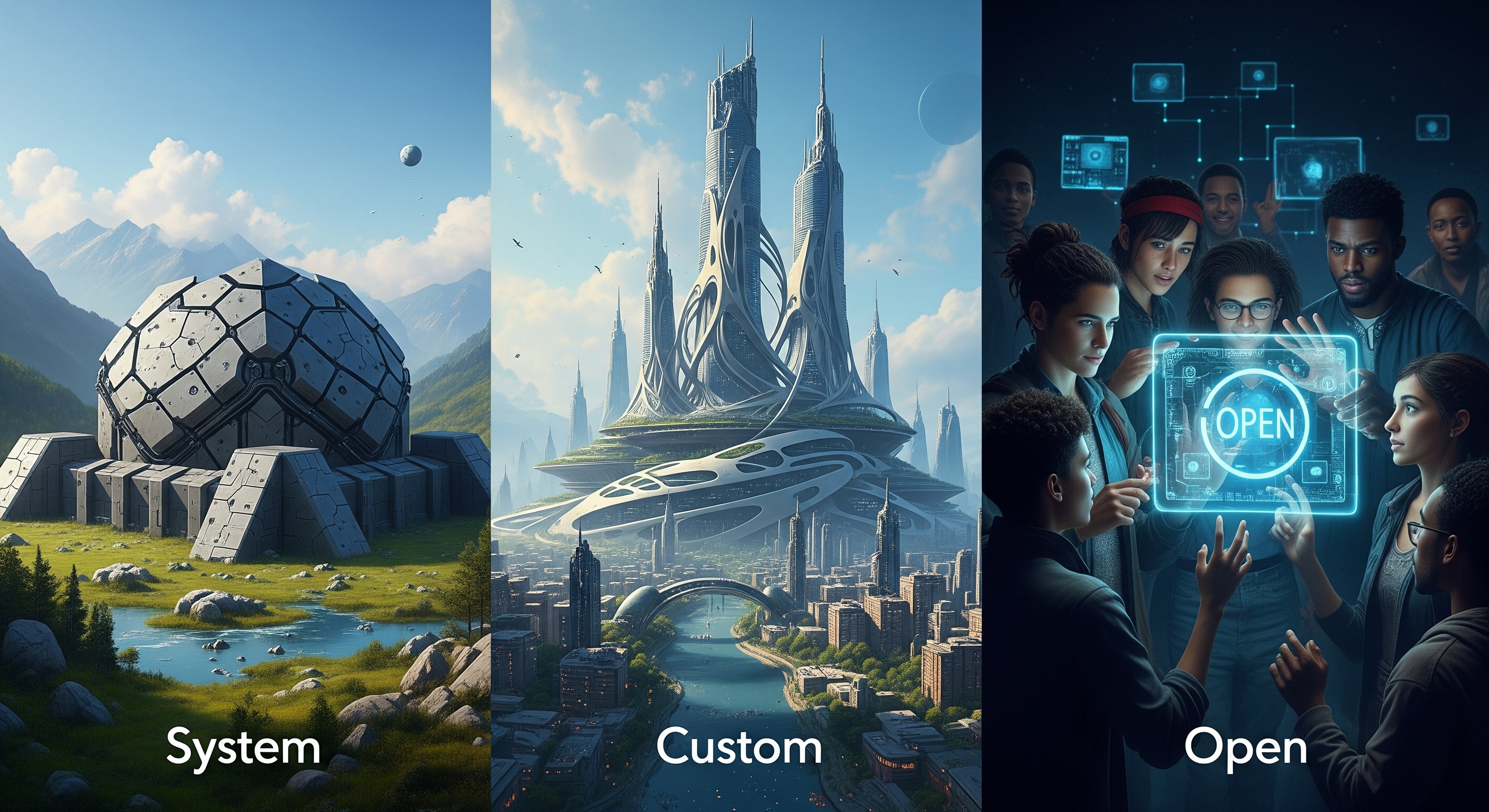

◆ セクション要約:NVIDIAの壮大な構想に対し、競合各社は三者三様の対抗策を打ち出しています。完成品で勝負する「一国一城」戦略、自給自足を目指す「独立国家」戦略、そして自由を掲げる「オープンソース」同盟です。

NVIDIA包囲網を形成する「反逆者」たちの戦略は三つに大別される。左から、Intelなどが進めるシステム全体を提供する「一国一城」戦略。中央は、Googleなどクラウド大手の「独立国家」戦略。そして右が、AMDが率いる「オープンソース」同盟。それぞれの哲学が次世代の覇権を争う。

対抗戦略1:

「一国一城」戦略 – 禅的なシンプルさを誇る要塞国家

「NVIDIAの銀河系が、無限の選択肢と複雑な規格争いを意味するなら、我々は禅的なまでのシンプルさを提供する」 IntelとCerebras(セレブラス)が選んだのは、究極の完成品で勝負する「一国一城」戦略です。これは、複雑な同盟政治や日進月歩の技術連携に疲れた者たちにとっての、秩序と静寂に満ちた「要塞国家」とも言えます。

彼らの主張は明快です。「我々の城に来なさい。そうすれば、武器も兵士も食料も、すべてが完璧に調和した状態で手に入る」と。チップ単体ではなく、AIの計算に必要なすべてが完璧にチューニングされた「システム」を売ることで、NVIDIAの複雑さとの差別化を図ります。

【技術的視点】IntelとCerebrasのシステム戦略

Intel:

CPUの王者Intelは、AIチップ「Gaudi 3(ガウディ3)」の市場投入で苦戦。その反省から、チップ単体で提供予定だった「Falcon Shores(ファルコンショアーズ)」の市販計画を2025年1月に撤回。代わって、2026年発売予定の「Jaguar Shores(ジャガーショアーズ)」を、システム全体を最適化したラックスケールAIシステムとして位置付け直しました[出典]。

Cerebras:

スタートアップのCerebrasは、世界最大のAIチップ「WSE-3」を搭載したAIスーパーコンピュータ「CS-3」を完成品の形で提供。2025年7月、同社リリースによれば「CS-3が複数の推論ベンチマークでNVIDIA Blackwellを上回る」と発表。 また、2025年6月には米オクラホマ州で300台超のCS-3を稼働予定と発表しています(顧客名は非公表)[出典]。

対抗戦略2:

「独立国家」戦略 – 帝国への上納金を断ち切る者たち

NVIDIA銀河連邦の最大の顧客でありながら、最大の脅威でもあるのが、Google、Amazon、Metaという巨大クラウド大陸です。彼らはNVIDIAから大量のGPUを購入することで帝国の繁栄を支える一方、その高額な「上納金」から逃れるべく、水面下で着々と「独立」の準備を進めてきました。

彼らの戦略は、自社のサービス(検索、Eコマース、SNS)という独自の生態系に100%最適化された、門外不出の「秘伝の魔導エンジン」を作り上げること。それはNVIDIAの汎用エンジンよりも遥かに効率が良く、低コスト。彼らは独自の物理法則が支配する大陸を築き上げ、NVIDIAの支配が及ばない経済圏を確立しようとしているのです。

【技術的視点】クラウド大手各社の独自チップ開発

Google:

業界関係者向けセッションで「Ironwood(アイアンウッド)」というコードネームが言及されたものの、Googleからの公式発表はなく、TPU v7との関連性も未確認です。報道ベースでは、Googleは「最大4倍の電力効率」と説明していますが、これは特定のモデルにおける理論値であり、実際には2〜4倍程度の幅があると見られています[出典]。

Amazon:

AWSの資料(2025年7月)によると、学習用チップ「Trainium(トライニウム)」ベースのUltraClusterは、理論上最大1.6M Trainiumチップ規模まで水平拡張可能です。ただし、AWSは実運用規模を公表しておらず、業界では数万チップ規模からと推定されています(注:この推定値は公式な数字ではありません)。

Meta:

Facebook等の推薦アルゴリズムに特化した「MTIA(エムティーアイエー)」の開発を継続。自社サービスに最適化することで、運用コストの削減を目指しています。

【かみ砕きポイント】1.6MTrainiumチップ規模とは?

この「理論上の規模」は、レゴブロックで例えると分かりやすいです。Trainiumチップを搭載したサーバー1台をレゴブロック1個だと考えてください。AWSのUltraClusterという仕組みは、これらのブロックを最大で160万個まで繋ぎ合わせ、一つの巨大な城(=AIスーパーコンピュータ)を構築できる「設計」になっている、という意味です。これはアーキテクチャ上の理論的な上限値であり、AWSが実際にその規模のクラスターを常に運用しているわけではありません。

対抗戦略3:

「オープンソース」同盟 – ゲリラ戦で共和国を築く

帝国の公用語が「CUDA」であるならば、我々は自由市民の共通語「ROCm(ロックエム)」で話そう。帝国の支配を良しとしない者たちが、もう一つの勢力を形成しています。特定の企業による支配を拒み、誰もが自由に技術を使える「オープンソース」の旗の下に集う、民主主義的な同盟です。

この反乱軍を率いるAMDは、正面からの艦隊決戦を挑むのではなく、ゲリラ戦で各地に「共和国」を建国しようとしています。具体的には、ROCmの互換性レイヤー開発を通じてCUDAで書かれたコードの移行障壁を下げたり、Microsoft Azureといった大口顧客との協業で「特定用途での最適解」という実績を積み上げたりすることで、帝国の足元を少しずつ切り崩す戦略です。この草の根運動に、Qualcommや多くのソフトウェア企業が賛同し始めており、彼らの戦いは、AIの未来を独裁者の手から解放するための、イデオロギー闘争の側面を色濃くしています。

【技術的視点】CUDA 対 ROCm:思想と戦略の違い

NVIDIAのCUDAとAMDが主導するROCmの最大の違いは、その根底にある思想とビジネスモデルにあります。以下の表は、両者の特徴を比較したものです。

| 比較項目 | NVIDIA CUDA | AMD ROCm |

|---|---|---|

| 開発元・ライセンス | NVIDIA・プロプライエタリ | AMD主導・オープンソース |

| 対応ハードウェア | NVIDIA製 GPU のみ | 主にAMD製 GPU(他社製も視野) |

| エコシステムの成熟度 | 非常に高い(20年以上の歴史) | 発展途上(近年急速に進化) |

| 強み | 圧倒的な性能・安定性、豊富なライブラリ群 | オープンな柔軟性、コスト効率、脱ベンダーロックイン |

| 課題 | ベンダーロックイン、エコシステム全体のコスト高 | CUDA比でツールや知見が少ない、最適化の難易度 |

🎯 Key Takeaways(お持ち帰りポイント)

- 【経営層への示唆】AIインフラの選択肢は「NVIDIA一択」から多様化の時代へ。自社のAI戦略(コスト、性能、開発の自由度)に応じて、Intelのシステム、クラウド独自のチップ、AMDのオープンな環境などを評価・検討する必要がある。

- 【開発・技術者への示唆】CUDA以外のスキル(ROCmなど)の価値が相対的に高まる可能性がある。特定のクラウドサービスに最適化されたモデル開発や、オープンソースプラットフォーム上でのパフォーマンスチューニングが新たな専門領域となりうる。

| チップ | 用途 | 年代 | 主な特徴 | 主な情報源 |

|---|---|---|---|---|

| NVIDIA Blackwell | 汎用 (学習/推論) | 2024-2025 | HBM3Eメモリ搭載。AIファクトリー構想の中核。 | GTC 2024 |

| NVIDIA Rubin | 次世代汎用 | 2026-2027 | HBM4搭載予定、新CPU「Vera」を統合。(2026年市場投入予定) | Computex 2025 |

| Google Ironwood | 推論特化 | 2025 | 電力性能比向上。自社サービス向け。(公式スペック未公開) | Google Cloud Next ’25 |

| AMD MI350/400 | オープン汎用 | 2025-2026 | ROCmソフトウェアエコシステムを武器にCUDAに対抗。 | Computex 2025 |

| Intel Jaguar Shores | システム提供 | 2026 | チップ単体ではなく、ラックスケールでのシステム提供に転換。 | ISC 2025 / Tom’s Hardware |

2026年、AIの覇権を握るのは誰か

◆ セクション要約:AI世界の覇権の行方は、もはやチップ性能だけでは決まりません。ソフトウェア、システム、エコシステムの3つの戦場に加え、HBM4メモリという「補給線」の問題が、各社の戦略に大きな影響を与えようとしています。

次世代AIチップの性能を左右する最重要部品、HBM(広帯域メモリ)。このメモリの安定供給なくして、AIの進化はあり得ない。SK HynixとSamsungによる熾烈な開発競争と供給能力が、2026年以降の覇権争いにおける最大のボトルネック、すなわち「補給線」となりつつある。

【技術的視点】覇権の行方を左右する戦場と補給線

1. 勝敗を分ける3つの戦場

- ソフトウェアの戦場: 熟成された独裁言語「CUDA」の牙城はあまりに高い。しかし、自由を求める「ROCm」同盟がどれだけ開発者の心を掴めるか。

- システムの戦場: 柔軟だが複雑なNVIDIAの「銀河系」か、シンプルだが融通の利かないIntelの「城」か。ユーザーが「手軽さ」と「カスタマイズ性」のどちらを重視するかで、戦況は変わります。

- エコシステムの戦場: すべてを飲み込むNVIDIAの「連邦」、自給自足のクラウド「独立国家」、緩やかに連携する「オープン同盟」。どの経済圏が最も多くの富と才能を集めることができるのか。

2. 技術トレンド:HBM4メモリという名の補給線

この戦争の行方を左右する、もう一つの重要な要素が「補給」です。AIチップの性能を爆発的に高めるには、「HBM(エイチビーエム)」(High-Bandwidth Memory)という超高性能なメモリが不可欠です。

業界アナリストの予測では、SK Hynixが2026年後半にHBM4の量産を開始する可能性が指摘されていますが、公式発表はありません。一方、TrendForceの報道(2025年7月22日)では、Samsungも2026年下期にHBM4量産開始を目指すと報じられていますが、公式仕様は未開示で現時点の焦点はHBM3E量産です[出典]。 このメモリメーカー間の開発競争と供給能力が、各チップメーカーのロードマップを左右する新たな変数となっています。

🎯 Key Takeaways(お持ち帰りポイント)

- 【経営層への示唆】

今後のAI投資は、チップ性能だけでなく、それを支えるメモリ(HBM)の供給動向も注視する必要がある。特定メーカーの供給遅延が、自社の導入計画に影響を及ぼすリスクを考慮すべき。 - 【開発・技術者への示唆】

メモリ帯域幅はAIモデルの性能を直接左右する。次世代モデルの設計においては、HBM4のような最新メモリの特性を最大限に活かすアーキテクチャの検討が重要になる。

用語集

CUDA(クーダ)

NVIDIAが開発した、自社製GPU上で汎用計算を行うためのソフトウェア開発・実行環境。AI開発における事実上の標準となっている。

NVLink(エヌブイリンク)

NVIDIAが開発した、GPU間やGPU-CPU間を高速に接続するためのインターコネクト技術。AIファクトリー構想の中核をなす。

ROCm(ロックエム)

AMDが主導する、オープンソースのHPC・AI向けソフトウェアプラットフォーム。NVIDIAのCUDAに対抗する存在として開発が進む。

HBM(エイチビーエム)

High-Bandwidth Memoryの略。複数のメモリチップを垂直に積層することで、AIチップが必要とする超広帯域なデータ転送を実現するメモリ。

TPU(ティーピーユー)

Tensor Processing Unitの略。Googleが自社のAIワークロード(特に推論)に最適化して開発したカスタムAIチップ(ASIC)。

ASIC(エイシック)

Application Specific Integrated Circuitの略。特定用途向けに設計・製造された集積回路。TPUやTrainiumなどが該当する。

よくある質問(FAQ)

Q. NVIDIAがNVLink Fusionで他社CPU/ASICを直結できるようにしたのは、CUDAの壁を壊す方向転換ですか?

A. いいえ。CUDAは依然クローズド基盤で、NVLink Fusionは“ハードウェア層の選択的オープン化”に過ぎません。ハイパースケーラーの独自ASIC需要、CXLなど競合規格への流出リスク、画像処理や通信向けチップレットを同一ファブリックに載せて総TCOを下げつつGPU需要を維持する――この三つを狙った戦略的アップデートです。

要するにCUDAコードを書き換えずに用途特化シリコンを増設でき、NVIDIAはプラットフォーム支配力を保ったままシステム全体の性能/コスト曲線を押し上げる。従って“壁を壊す”というより“壁を広げる”施策と言えます。

Q. AMDの「ROCm」はNVIDIAの「CUDA」に対抗できるのでしょうか?

A. 現状では難しいといわざるを得ません。その理由は以下の3つです。

① ライセンス・知財の壁――CUDA のヘッダー/ランタイム実装や PTX 生成手順は著作権・特許で守られており、単純コピーは法的リスクが高い。

② バイナリ互換性の欠如――CUDAで書かれたプログラムはNVIDIA専用の機械語に変換されるため、AMD GPUでは直接実行できません。AMDのHIPツールで翻訳・最適化し直す必要があり、この作業に時間とコストがかかります。

③ エコシステムの厚み――cuDNN・TensorRT など 15 年熟成の最適化ライブラリと膨大な CUDA 資産が性能と開発体験を支える。

ROCm はオープンソースとコスト優位で特定用途の“有力な代替”になりつつあるものの、現時点で全面的な対抗は難しいのが実情です。

Q. HBM4メモリの供給状況は、AI業界全体にどのような影響を与えますか?

A. 2026年以降に登場する次世代AIチップの性能やリリース時期に影響を与える可能性があります。特に最先端のHBM4を搭載予定のNVIDIA「Rubin」などが影響を受けるかもしれません。一方で、HBM4の供給でリードするメモリメーカーと強く連携するチップメーカーが、競争上有利になる可能性も出てきました。

まとめ

2025年からのAIチップ市場は、NVIDIAが「AIファクトリー」構想でエコシステム全体の支配を狙うのに対し、競合各社が「システム単位での提供」「自社サービスへの特化」「オープンソース」という三者三様の戦略で挑む、壮大な覇権争いの時代に突入しました。この戦いは、単なる技術競争に留まらず、AI世界の未来の秩序、いわば”憲法”を誰が作るのかを巡る争いです。ソフトウェア、システム、エコシステム、そしてメモリ供給という複数の戦場の動向が、今後の覇権の行方を左右するでしょう。

更新履歴

- 最新情報に基づき、ストーリー性を強化して全面改訂

- 初版公開

主な参考サイト

- AnandTech – NVIDIA Unveils Rubin Platform for 2026

- Tom’s Hardware – Intel Pivots and Discloses New Details of Jaguar Shores

- TrendForce – HBM Generation To See Full Transition by 2026

合わせて読みたい

- NVIDIA NVLink Fusion発表|AIチップ市場の新展開

- NVIDIAの独占は続くのか?AIチップの未来を徹底解説

- AIインフラ市場2025最新|NVIDIA独占に挑む各社戦略

- 〖即日速報〗NVIDIA GTC台北いよいよ開幕

- AI最前線!NVIDIA CEO講演解説

- GTC 2025でも注目!NVIDIAが量子コンピューティングで描く未来

- AIが金を掘る時代へ:NVIDIA GTC 2025が示したトークン採掘の未来

以上