最終更新:

初学者用LLM技術:NVLinkを理解するために【2025】

この記事を読むとAIが賢くなる「学習」と、その知識を使って答える「推論」の違いから、巨大な計算を可能にする並列化戦略、そしてそれを物理的に可能にするNVLink/NVSwitchの役割までが、一気通貫でわかります。

序章:この入門記事のねらい

要約:本記事は本編「AIデータセンターネットワーク三層アーキテクチャ」を読む前に、推論/学習の違いと並列化、NVLink/NVSwitchの要点を物語として掴むための導入です。

我々が日常的に使うAIチャット。その滑らかな応答の裏側では、一体何が起きているのでしょうか?この記事では、AIが賢くなる「学習」と、その知識を使って答える「推論」の違いから、巨大な計算を可能にする並列化戦略、そしてその戦略を物理的に可能にするNVLinkというハードウェアの役割までを、一気通貫で解説します。専門的な内容を、分かりやすいたとえ話を交えながら、一つの物語として解き明かしていきます。

AIの二つの顔:教科書を「読んで答える推論」と「執筆する学習」

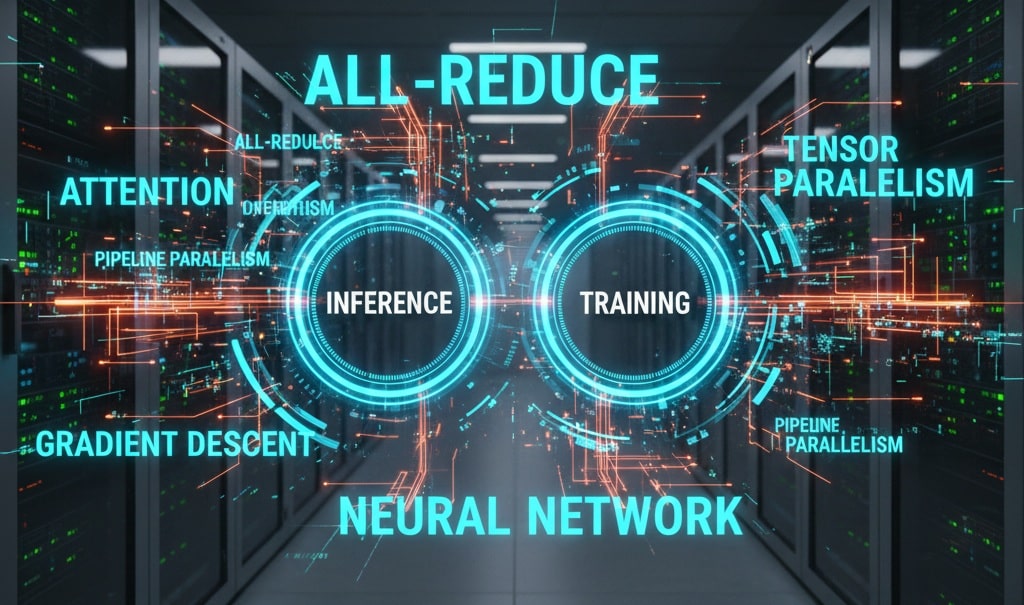

要約:AIの計算は「推論」と「学習」に分かれ、前者は順伝播中心で軽く、後者は逆伝播と更新を含むため重い処理になります。

AIの計算は、大きく「推論」と「学習」の二つに分かれます。これは、分厚い教科書を「読んで質問に答える」作業と、その教科書自体をゼロから「執筆・編集する」作業の違いに似ています。

推論 (Inference) 📖

完成した教科書を使って、質問に答える作業です。計算は「順伝播」のみで、学習に比べて負荷もメモリ使用量も格段に少なくて済みます。

学習 (Training) ✏️

膨大な資料(データ)を元に、間違いを修正しながら新しい知識を書き込んでいく、教科書の執筆作業そのものです。内部では、予測と答え合わせ、そして「なぜ間違えたのか」を逆探知して修正する「逆伝播」という膨大な計算が行われます。

この記事では、まず「学習」の核心サイクルと、それをスケールさせる技術について詳しく見ていきましょう。

学習の核心サイクル:「秘伝のソース」はいかにして完成するか

要約:順伝播→損失→逆伝播→更新の4ステップを何百万回も回し、誤差が最小化するようレシピ(パラメータ)を洗練します。

AIの学習とは、「データ(食材)にパラメータ(レシピ)を掛け合わせた結果(調理したソース)を、勾配降下法で誤差(味の違い)が正解(理想の味)と最小になるよう訓練する」というサイクルです。このサイクルを「秘伝のソース」開発に例えて詳しく見ていきましょう。

順伝播 (Forward Propagation) – とりあえず作ってみる

シェフは、現在のレシピ(パラメータ)の分量通りに、渡された食材(データ)を混ぜ合わせ、ソースを作ってみます。

損失計算 (Loss Calculation) – 味覚センサーで採点

完成したソースを精密な味覚センサー(損失関数)で分析し、「理想の味」とどれだけ違うかを「誤差」として点数化します。

逆伝播 (Backpropagation) – 味の違いの原因を分析

味覚センサーは、単に点数をつけるだけではありません。「スパイスAが1g増えるごとに、理想の味から2点遠ざかる」といった、各材料の分量(パラメータ)が最終的な誤差にどれだけ影響したかを示す詳細な分析レポートを出力します。このレポートが「勾配」です。

パラメータ更新 (Parameter Update) – レシピを微調整

シェフは、このレポート(勾配)を元に、レシピに書かれた全ての材料の分量を、ほんの少しだけ良い方向に微調整します。

この4ステップを、異なる食材(データ)で何百万回と繰り返すことで、レシピは徐々に洗練され、究極の「秘伝のソース」が完成するのです。

巨大さとの戦い:3つの並列化戦略

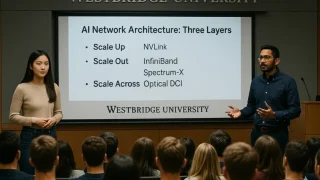

要約:一人のGPUで扱えない巨大さに対し、パイプライン・テンソル・データ並列で多GPUが役割分担します。

現代のLLMというレシピは、材料が何千億種類もあり、調理工程も複雑すぎるため、一人のシェフ(一つのGPU)では扱いきれません。そこで、巨大な厨房でたくさんのシェフ(GPU)が協力する「並列化」が必要になります。

この章で使う「たとえ話」の役割分担

- シェフ = GPU (計算を実行する働き手)

- 厨房 = サーバー (シェフたちが働く場所)

- レシピ = AIモデルのパラメータ (共有する知識)

- 食材 = 学習データ (処理する対象)

パイプライン並列:ソース作りの「工程」を分担

ソース作りは、「トマトを洗う」→「煮込む」→「スパイスを加える」という工程に分かれています。

この各工程を別のシェフが担当し, 洗い終わったトマトの小分け(マイクロバッチ)を次々とリレー形式で渡していきます。

これにより、全てのシェフ(GPU)が常に働き続け、厨房全体の稼働率を最大化します。

テンソル並列:一つの「複雑な工程」を共同作業

「スパイスを加える」という工程が、あまりに複雑で巨大なスパイスラック(モデルの層)を使うため、一人のシェフでは担当できないとします。

そこで、二人のシェフが、一つの寸胴鍋(マイクロバッチ)に対して、同時にスパイスを投入します(シェフ1はA〜M、シェフ2はN〜Zを担当)。

この時、味のバランスを取るために、二人は常に「今これだけ入れたよ」と情報を交換(中間活性の受け渡し)する必要があります。

データ並列とAll-Reduce:「全厨房」でのレシピ改善会議

レストランには、この厨房が複数あり、それぞれが同じレシピでソースを作っているとします(データ並列)。

各厨房は、それぞれ異なるトマト(異なるデータ)を使ってソースを作り、改善レポート(勾配)を受け取ります。

しかし、各厨房がバラバラにレシピを更新すると、味が統一されません。そこで、全厨房の代表シェフが集まり、全体会議(All-Reduce)を開きます。各厨房のレポート(勾配)を持ち寄り、平均的な改善案を計算し(Reduce)、その最終決定を全厨房に持ち帰って、全員が自分のレシピを全く同じように更新する(All)のです。

通信という生命線:NVLinkとNVSwitchの役割

要約:並列化は猛烈な通信を前提とし、NVLinkは直通トンネル、NVSwitchは同時会議の交換機として機能します。

これらの並列戦略はすべて、シェフ(GPU)間の猛烈なコミュニケーションを前提としています。

NVLink = シェフ専用の超高速な直通トンネル

通常のコンピュータ部品が使うPCIeという「共用の廊下」は、AI学習の膨大な通信量には耐えられません。NVLinkは、厨房と厨房を直接つなぐ「専用の地下トンネル」です。これにより、「テンソル並列」での細かい情報交換や、「パイプライン並列」でのマイクロバッチの受け渡しが劇的に高速化されます。

NVSwitch = 全員が同時に話せる魔法の交換機

72人のシェフ全員が一斉に会議(All-Reduce)を開きたい場合、トンネルだけでは対応できません。NVSwitchは、そのための「魔法の電話交換機」です。どのシェフも、他のどのシェフとも、瞬時に、同時に、専用線で繋がります。これにより、「All-Reduce」での意見集約が瞬時に完了するのです。

まとめ:計算と通信、AIを支える両輪

要約:学習は巨大な反復で、計算と通信の両輪が揃って初めてAIファクトリーは真価を発揮します。

AIの学習とは、膨大なパラメータを持つレシピを、データという食材を使って、誤差という味覚を頼りに、勾配という分析レポートを元に、少しずつ改善していく壮大な物語です。そして、その巨大な物語を現実の時間で終わらせるために、パイプライン、テンソル、データ並列といった分業戦略が生まれました。

しかし、これらの戦略はすべて、GPU間の超高速な「通信」がなければ成り立ちません。NVLinkとNVSwitchは、単なる高速道路ではなく、AIという巨大な知性が生まれるための、不可欠な神経系そのものなのです。計算能力と通信能力、この両輪が揃って初めて、AIファクトリーはその真価を発揮するのです。

専門用語まとめ

- 推論(Inference)

- 完成した教科書を使って質問に答える作業。計算は順伝播のみで、学習に比べて負荷もメモリ使用量も少ない。

- 学習(Training)

- 膨大な資料を元に、誤差を減らすようパラメータを更新して知識を書き込む作業。損失計算・逆伝播・更新を含む。

- All-Reduce

- 各計算ノードが得た勾配を集約(Reduce)し、結果を全体に配布(All)する同期操作。学習で味の統一を保つために不可欠。

- NVLink

- GPU間の専用高速直結リンク。テンソル並列やパイプライン並列での中間データ交換を高速化する。

- NVSwitch

- 多数GPUの同時接続を可能にする交換機。全員が同時に話せる会議(集団通信)を可能にする。

よくある質問(FAQ)

Q1. 推論はなぜ軽いのですか?

A1. 推論は完成した教科書を使って質問に答える作業で、計算は「順伝播」のみだからです。学習に比べて負荷もメモリ使用量も格段に少なくて済みます。

Q2. 学習はなぜ重いのですか?

A2. 学習は予測と答え合わせ、さらに逆伝播で原因分析を行い、パラメータを更新する一連の膨大な計算を含むためです。

Q3. NVLinkとNVSwitchは何のために必要ですか?

A3. NVLinkは厨房と厨房を直接つなぐ「専用の地下トンネル」、NVSwitchは全員が同時に話せる「魔法の電話交換機」として、並列学習の猛烈な通信を支えます。

主な参考サイト

- NVIDIA Official:NVLink

- NVIDIA Official:NVLink(NVLink & NVLink Switch)

- NVIDIA Developer:NCCL User Guide

- PyTorch Tutorials(Distributed)

- Open MPI Papers & Docs

合わせて読みたい

- NVLink vs Broadcom論争の真相|AIネットワークの力学を読み解く

- AIネットワーク三層|NVLink・IB・Ethernet/Spectrum-X【2025】

- NVIDIA発・AIファクトリー横断「スケールアクロス」最前線2025

- AIネットワーク三層|NVLink・IB・Ethernet/Spectrum-X【2025】

- NVIDIA×Qualcomm:NVLink FusionとAIデータセンター

- AIファクトリーとトークン採掘:NVIDIA GTC 2025

- AIチップ覇権戦争2025: NVIDIAの銀河系戦略に挑む反逆者たち

- 2025年上半期 総まとめ:AI社会実装を決定づけた4大トレンド

更新履歴

- 初版公開