【2025年最新】ディープフェイク対策:あなたの会社が40億円を失う前に

この記事を読むとディープフェイクがもたらす経営リスクの本質がわかり、自社を詐欺や法的責任から守るためのAIガバナンス戦略を具体的に実行できるようになります。

- 要点1:偽物を探す後追い型の対策は限界であり、C2PA等を活用して「本物であること」を積極的に証明する体制へ移行することが不可欠。

- 要点2:責任の所在を曖昧にせず、RACIチャートや「停止権(キルスイッチ)」を用いて、有事の際に誰が何をすべきかを明確に定義する必要がある。

- 要点3:一度導入すれば終わりではなく、AIレッドチーミング等を通じて、自社の防御体制が本当に機能するかを継続的に検証するプロセスが重要。

プロローグ:40億円がAIに盗まれた日

2024年1月、国際的エンジニアリング企業Arup社の香港オフィス。一人の財務担当者が、緊急のビデオ会議に招集されました。画面に映し出されたのは、英国本社にいるはずの最高財務責任者(CFO)と、見慣れた同僚たちの顔でした。議題は、極秘の買収案件。議論は滞りなく進み、担当者はCFOの指示通り、総額2,550万米ドル(約40億円)を複数の口座へ送金しました。

数週間後、会社全体を震撼させる事実が発覚します。そのビデオ会議で、人間だったのは被害者である担当者ただ一人。CFOも、他の出席者も、すべてがAIによってリアルタイムに生成されたディープフェイクだったのである。

この事件は、AIが突きつける脅威が、もはやSF映画の脚本や政治的プロパガンダの領域を遥かに超え、企業の中枢を直接攻撃する精密誘導兵器へと進化した冷徹な現実を物語っています。我々がビジネスの基盤としてきた「見る」「聞く」という認知の前提は、根底から覆されました。

これまで常識だった「信頼し、しかる後に検証する(Trust but Verify)」という牧歌的なパラダイムは、40億円の授業料とともに完全に崩壊しました。2025年以降、私たちが生きる世界の新たな常識は、ただ一つ。

「決して信頼せず、常に検証する(Never Trust, Always Verify)」です。

本稿は、抽象的な倫理談義ではありません。この認知の前提が崩れた世界で、いかにして事業の前提である「信頼」を再設計し、競争優位を築くか。そのための技術、規制、組織運営を統合した、実践的な戦略の青写真を描き出すものです。

第1章 新たな戦場:企業を襲うAIリスクの三つの戦線

要約:ディープフェイク詐欺、AIによる差別、著作権問題という、企業が直面する3つのAIリスクの最前線を解説。これらは事業継続を脅かす現実の脅威です。

要約:ディープフェイク詐欺、AIによる差別、著作権問題という、企業が直面する3つのAIリスクの最前線を解説。これらは事業継続を脅かす現実の脅威です。

検証ポイント:Arup社の40億円事件に加え、北米のディープフェイク詐欺は1年で1740%増加。Workday訴訟ではAIベンダーの法的責任が問われています。

AIがもたらすリスクは、未来の懸念ではない。すでに損益計算書に直接的なダメージを与える「現在」の脅威であり、その戦線は主に三つに分類される。

戦線1:アイデンティティの兵器化 ― ディープフェイク詐欺の常態化

Arup社の事件は氷山の一角だ。北米ではディープフェイク詐欺が2022年から2023年にかけて1,740%増加し、被害額は四半期で2億ドルを超える。もはや国家レベルの組織犯罪だけのものではない。わずか30秒の音声データで声紋を複製し、無料のオープンソースソフトで精巧なビデオディープフェイクを生成できる「攻撃の民主化」が起きている。

攻撃は極めて巧妙だ。フェラーリ社CEOを狙った詐欺未遂では、南イタリア特有のアクセントまで完璧に再現された。これらの攻撃が狙うのは、技術的脆弱性以上に、業務プロセスの脆弱性である。特に、ビデオ会議やメールといった単一の通信経路(in-band)のみに依存した高額な資金移動や契約承認のプロセスは、格好の標的となっている。問題は「偽物を見破れるか」ではない。「偽物が存在することを前提とした業務プロセスを構築できているか」なのだ。

戦線2:差別の委任 ― アルゴリズム・バイアスと法的責任の拡大

AIによる差別は、倫理的懸念から具体的な法的・財務的リスクへと移行した。その象徴が、Mobley v. Workday訴訟である。2024年から2025年にかけて下された一連の画期的な司法判断は、AI採用ツールが差別的な結果を生んだ場合、ツールを提供したベンダー自身が、雇用主の「代理人」として法的責任を負う可能性があると認めた。

この判決は、AIに関するリスクが自社だけで完結しないサプライチェーン・リスクであることを明確にした。HRテックのベンダー、クラウド事業者、データ提供者に至るまで、AIのサプライチェーンに関わるすべての主体が、差別という結果に対する責任を問われうる。もはや「AIベンダーの仕様だから」という言い訳は通用しない。企業は、導入するAIシステムのバイアスを自ら監査し、ベンダーとの契約に損害賠償条項を盛り込むことが不可欠な自衛策となっている。

戦線3:創造の流砂 ― 知的財産権と著作権の大いなる不確実性

生成AIの学習データが著作権を侵害しているとする訴訟は、世界中で頻発しているが、2025年時点でも司法の判断は定まっていない。ある裁判では著作権侵害とされ、別の裁判では「変容的利用」としてフェアユース(公正な利用)が認められるなど、判例は揺れ動いている。

この法的な不確実性は、事業運営における「時限爆弾」である。今日、適法とされたAIモデルが、明日の判例変更によって巨額の損害賠償請求に繋がる可能性がある。この流砂のような状況で企業が唯一立てる杭、それが「来歴(Provenance)」の徹底管理である。学習に用いたデータの出所、利用したAIモデルのバージョン、生成されたコンテンツに至るまで、AIのライフサイクル全般を追跡・記録し、将来の監査や訴訟に備えて完全な透明性と説明責任を確保すること。これが事業継続の生命線となる。

👨🏫 AI専門家が解説:かみ砕きポイント

これまでのAI問題は「使う側の責任」とされがちでしたが、Workday訴訟以降はAIを「作る側・提供する側」も責任を問われる流れが明確になりました。これは、自社だけでなく、利用するAIサービス全体の法的リスク管理が必須になったことを意味します。

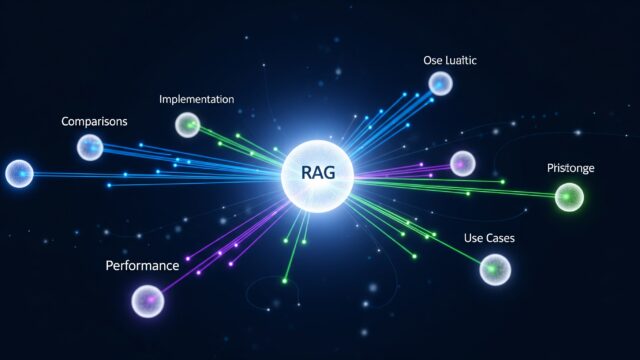

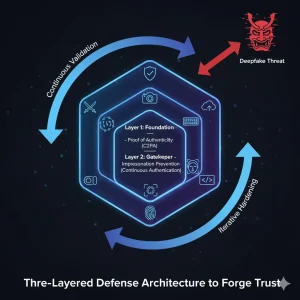

第2章 反撃のアーキテクチャ:信頼を構築する三層防御

要約:偽物を探す検知から「本物を証明する」思想へ転換。C2PAによる真正性証明、継続的認証によるなりすまし防止、AIレッドチーミングによる脆弱性発見の三層で対抗します。

要約:偽物を探す検知から「本物を証明する」思想へ転換。C2PAによる真正性証明、継続的認証によるなりすまし防止、AIレッドチーミングによる脆弱性発見の三層で対抗します。

検証ポイント:Google、Meta、Microsoft等が加盟する国際標準「C2PA」が防御技術の核。コンテンツの「デジタル出生証明書」として機能します。

脅威が進化する一方、防御技術も新たな標準を確立しつつある。その思想的転換は、「偽物を検知する」という後追いの発想から、「本物を証明する」という能動的なアプローチへのシフトである。偽物は無限に生まれるが、「本物の出所」を暗号技術で証明する基盤は、より強固な信頼を築く。

第一層〈土台〉:真正性の証明 ― C2PAによる「デジタル出生証明書」

防御技術の根幹をなす最も重要な進展が、国際標準C2PA(Coalition for Content Provenance and Authenticity)の普及である。C2PAとは、画像や動画などのデジタルコンテンツが「いつ、どこで、誰によって、どのように」作成・編集されたかという来歴情報を、改ざん不可能な形で暗号化して埋め込む技術仕様だ。いわば、コンテンツの「デジタル出生証明書」である。

Google、Meta、OpenAI、Microsoft、TikTokといったプラットフォーム企業から、ソニー、BBCといったハードウェア・メディア企業までが採用を進め、2025年中にはISO国際標準となる見込みだ。自社が発信するプレスリリース、製品画像、役員メッセージ動画に標準でC2PA署名を付与することは、自社の正規コンテンツに「認証マーク」を与えることに等しい。これにより、署名のない偽情報との差別化が明確になり、ブランド価値を守る強固な土台となる。

第二層〈門番〉:なりすましの阻止 ― 継続的認証とLiveness検知

「ログインIDとパスワード」という一度きりの認証は、もはや過去の遺物だ。防御の最前線は、セッション中の本人性を常に検証し続ける継続的認証(Continuous Authentication)へと移行している。これは、ビデオ会議中やシステム操作中に、タイピングのリズム、マウスの動き、あるいはウェブカメラ映像からユーザーの顔を断続的に照合し、「セッションの途中で乗っ取られていないか」を監視する技術である。

さらに、本人確認の瞬間に「画面に表示された数字を読み上げてください」といった予測不能な課題(チャレンジ)を提示し、その応答(レスポンス)を分析するLiveness検知を組み合わせることで、録画映像によるなりすましを効果的に防ぐことができる。

第三層〈スパーリングパートナー〉:脆弱性の発見 ― AIレッドチーミング

受動的な防御だけでは不十分だ。自社のAIシステム(不正検知モデル、チャットボットなど)に対し、専門家が擬似的な攻撃を仕掛ける「AIレッドチーミング」は、未知の脆弱性を発見するための不可欠なプロセスである。これは、NIST(米国国立標準技術研究所)のAIリスク管理フレームワークでも推奨される公式なセキュリティプラクティスであり、自社の防御が机上の空論でないことを証明する唯一の方法だ。定期的なレッドチーミングは、AI時代の新たな「防災訓練」と位置づけるべきである。

👨🏫 AI専門家が解説:かみ砕きポイント

C2PAとは、写真や動画に「これはいつ、どこで、誰が作った本物です」という改ざん不可能なデジタル証明書を付ける技術です。ハンバーガーの産地証明書のように、コンテンツの出所と履歴を保証します。これにより、証明書のないコンテンツを「怪しい」と判断しやすくなります。

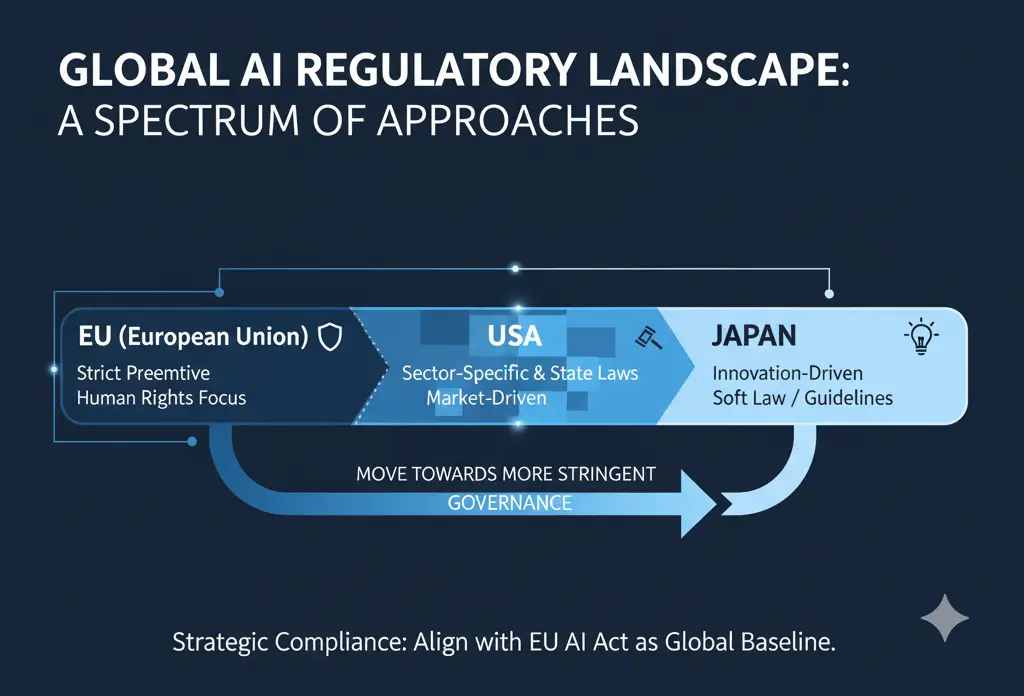

第3章 グローバル・ルールブックの航海術

要約:EU、米国、日本のAI規制には明確な思想的差異が存在します。グローバル企業は、最も厳格なEUの「EU AI法」を基準としたコンプライアンス体制を構築することが合理的です。

要約:EU、米国、日本のAI規制には明確な思想的差異が存在します。グローバル企業は、最も厳格なEUの「EU AI法」を基準としたコンプライアンス体制を構築することが合理的です。

比較条件:3つの主要経済圏(EU, 米国, 日本)におけるAI規制の基本理念、規制手法、罰則の有無を比較し、企業の戦略的対応を考察します。

グローバルに事業を展開する企業にとって、各国の規制動向を理解し、整合性のあるコンプライアンス体制を築くことは事業継続の生命線だ。2025年現在、主要国のAI規制は明確な思想的差異を示している。

| 特徴 | 欧州連合 (EU) | 米国 | 日本 |

|---|---|---|---|

| 基本理念 | 予防原則、基本的人権の保護 | イノベーション主導、市場原理 (連邦の緩和+州の厳格化) |

イノベーション促進、国際競争力強化 |

| 主要法規制 | EU AI法 | 連邦法はなし、NIST AI RMF(自主基準) 州法(カリフォルニア州AI透明性法など) |

AI推進法、AI事業者ガイドライン |

| 規制手法 | リスクベースの厳格な事前義務 (禁止、高、限定、最小) |

セクター別監督と州法のパッチワーク | ソフトロー中心、企業の自主ガバナンス尊重 |

| 罰則 | 重罰:最大3,500万ユーロ または全世界売上高の7% |

州により異なるが、民事罰などが存在 | AI推進法自体に罰則なし (権利侵害は既存法で対応) |

| 判定根拠 | EUは人権保護を最優先し事前規制を敷く一方、米国は市場原理を重視、日本は国際競争力確保のため企業の自主性を尊重する思想的差異が明確。 | ||

この複雑な規制の海を航海するための羅針盤は明確である。それは、最も厳格なEU AI法をグローバルなコンプライアンスのベースラインとすることだ。「高リスクAI」に分類されるシステム(採用、与信評価など)については、EUの厳格な要件(データ品質、人的監督、サイバーセキュリティ)を満たす体制を構築すれば、他の地域の規制にも概ね対応可能となる。地域ごとに異なるルールブックを場当たり的に適用するより、最も高い基準に統一する方が、長期的には遥かに効率的かつ安全である。

👨🏫 AI専門家が解説:かみ砕きポイント

簡単に言えば、EUは「危ないAIは売る前に許可を取ってね(事前規制)」、米国は「問題が起きたら業界ごと・州ごとに裁くよ(事後規制)」、日本は「まずやってみよう、ルールは後から(自主規制)」というスタンスです。グローバルにビジネスをするなら、一番厳しいEUのルールに合わせておくのが無難です。

第4章 信頼の司令塔:責任を設計する組織ガバナンス

要約:AIガバナンスとは理念ではなく、具体的な「責任の設計図」です。RACIチャートで責任者を定め、究極の安全装置として「停止権」を組織に与えることが実効性の鍵です。

検証ポイント:責任の所在を明確化するフレームワーク「RACIチャート」と、AIシステムの強制停止権限「キルスイッチ」が、実効性のあるガバナンスの二大要素です。

AIガバナンスは、理念や文書の作成で終わるものではない。それは、平時と有事において「誰が、何を、いつまでに判断し、実行するのか」を定めた、具体的な責任の設計図である。

責任の地図:RACIチャート

この設計図として極めて有効なのが、RACIチャートである。これは、AI利用に関する各タスク(例:リスク分類、モデル評価、インシデント対応)ごとに、実行責任者(Responsible)、説明責任者(Accountable)、協業先(Consulted)、報告先(Informed)を明確に割り当てるフレームワークだ。これにより、事業部門、データサイエンス部門、法務、セキュリティといった部署間の役割分担が可視化され、迅速な意思決定が可能になる。特に重要な原則は、各タスクの最終的な説明責任者(A)は必ず一人に限定すること。これにより、責任の所在が曖昧になることを防ぐ。

究極の安全装置:停止権(キルスイッチ)

実効性のあるガバナンスを担保する上で、最も重要な規程の一つが、「停止権(キルスイッチ)」である。これは、AIシステムが予期せぬ挙動を示したり、重大なリスクをもたらしたりした場合に、リスク管理部門やSafety部門が、事業部門の意向に関わらず、その稼働を強制的に停止させられる権限を明記することである。「止められない安全対策」は、単なる形式に過ぎない。

👨🏫 AI専門家が解説:かみ砕きポイント

RACIチャートとは「この仕事、誰がやるの?誰が責任者なの?」を一覧表にすることです。例えば「AIのリスク評価」は、実行担当=開発部、説明責任者=リスク管理部長、のように役割を決めることで、問題発生時にたらい回しになるのを防ぎます。

Key Takeaways(90日アクションプラン)

- Phase 1 (〜30日)|現状把握とリスク評価:社内で利用中の全AIツールをリスト化する「用途棚卸し」を実施し、リスクを分類・特定する。

- Phase 2 (〜60日)|防御策の導入とパイロット:高リスク領域で「二経路確認」を義務化し、公式コンテンツへのC2PA署名付与を試験導入する。

- Phase 3 (〜90日)|体制の正式化と定常運用:RACIチャートを完成させて規程に明記し、最初のAIレッドチーム演習を実施する。

まとめ

ディープフェイクによる40億円の詐欺事件は、AI時代の警鐘です。我々が取るべき道は、恐怖でも礼賛でもなく、信頼を意図的に「設計」することにあります。AI倫理とガバナンスとは、イノベーションの足かせではなく、持続的成長を可能にする「信頼のアーキテクチャ」です。本稿で提示した、①プロアクティブな真正性証明、②検証可能なアカウンタビリティ、③継続的な妥当性検証の三位一体の戦略を構築し、「安全にしか使えない状態」を作り出すことこそ、今後10年の企業の存続を左右する最重要の経営課題です。

専門用語まとめ

- ディープフェイク(Deepfake)

- AI、特に深層学習(ディープラーニング)を用いて、実在の人物の顔や声を極めて精巧に模倣・合成した映像や音声のこと。詐欺や偽情報の拡散に悪用されるリスクが高い。

- C2PA (Content Provenance and Authenticity)

- デジタルコンテンツの出所と来歴(いつ誰がどのように作成・編集したか)を改ざん不可能な形で記録・検証するための国際技術標準。コンテンツの信頼性を担保する基盤となる。

- AIレッドチーミング (AI Red Teaming)

- 自社のAIシステムに対し、専門家が擬似的な攻撃を仕掛けることで、未知の脆弱性や倫理的なリスクを事前に発見・評価するセキュリティ検証手法。AIの安全性を高める上で不可欠。

- RACIチャート (RACI Chart)

- プロジェクトや業務における各タスクの役割分担を明確化するフレームワーク。「実行責任者(R)」「説明責任者(A)」「協業先(C)」「報告先(I)」を定義し、責任の所在を可視化する。

よくある質問(FAQ)

Q1. このような厳格なガバナンスは、大企業でなければ導入は難しいのでは?

A1. いいえ、企業の規模に関わらず原則は共通です。中小企業であっても、例えば「高額な送金には必ず電話で二重確認する」「AIによる採用候補者の一次選考結果は必ず人間が再レビューする」といった、最もリスクの高い業務領域に絞って実践的なルールを導入することから始められます。完璧を目指すより、リスクベースで着手することが重要です。

Q2. 海外のAI規制(EU AI法など)は、日本国内のビジネスにしか展開していない企業にも関係ありますか?

A2. 直接的な罰則対象にはなりにくいですが、無関係ではありません。将来的に海外のクラウドサービス(AIプラットフォーム)を利用する場合、そのサービスがEU AI法等に準拠している必要があり、間接的に影響を受けます。また、グローバルなベストプラクティスとして、EUの基準は日本企業にとっても重要な参照点となります。

Q3. AIが生成したコンテンツの著作権はどう考えればよいですか?

A3. 2025年時点でも法的な判断は国や裁判によって異なり、非常に不確実性が高い状況です。企業が取りうる最も安全な策は、学習データの出所や利用モデルを記録する「来歴管理」を徹底し、著作権フリーのデータや自社データでモデルをファインチューニングすることです。これにより、将来の訴訟リスクを低減できます。

主な参考サイト

- Arup finance worker pays out $25m after video call with deepfake ‘CFO’ (Financial Times)

- C2PA – Coalition for Content Provenance and Authenticity (Official)

- The EU AI Act – European Commission

- AI Risk Management Framework | NIST

- Workday must face part of job bias lawsuit over AI screening tools (Reuters)

合わせて読みたい

- 【2025年完全ガイド】AI規制とガバナンス:EU法と米国の違い

- AIが変えるセキュリティ|ゼロトラスト・RBVM・最新脅威を徹底解説

- XAIと因果AIの実践ガイド:EU AI法対応から経営実装まで

- オープンソース講座(1):著作権(2025版)(生成AIの権利論に関連)

- 2030年AI新常態:暮らしと仕事を変える3つの自己再設計(倫理・社会設計の文脈)

更新履歴

- 初版公開

- 最新情報にアップデート、読者支援機能の強化