物理と論理の常識を覆す挑戦者たち ― 2026年、AI半導体市場を再定義する3つの新境地

前編まで、NVIDIAが築き上げた「CUDAによる密結合」の強固さと、それがもたらす「Vera Rubinへのインフラ回帰」というシナリオについて論じてきました。現在のAIコンピュートにおいて、NVIDIAの王道は絶対的に見えます。しかしシリコンバレーには、その王道が前提とする「半導体の常識」そのものを疑い、全く異なるアプローチでゲームのルールを変えようとする「異端児(Mavericks)」たちが存在します。

そして2025年末〜2026年初頭、異端児たちの運命が動きました。

本稿では、NVIDIAの包囲網を“性能勝負”ではなく、「壊し方(3つの破壊)」として整理し、前半は技術の深層(エンジニア向け)、後半は比喩で直感理解(一般向け)で解説します。さらに後半では、異端児が辿る「3つの道(吸収/昇格/独立継続)」まで踏み込みます。

重要:本記事でいう「通信(Communication)」の定義

本稿の「通信」は、一般的なネットワーク通信だけを指しません。AI計算の性能とコストを左右する広義のデータ移動(data movement)として、

①メモリアクセス(HBM↔演算器) ②チップ内(NoC) ③チップ間(NVLink等) ④ノード間(All-Reduce等)

をまとめて扱います。

※本文中の「通信ボトルネック」は、原則としてこの“データ移動ボトルネック”を意味します。

1分でわかる結論:

- 結論:NVIDIA一強に見えるAI計算機にも、“別ルールで勝つ”挑戦者がいる。

- 3派閥=3つの“壊し方”:

- ① 物理を壊す:Cerebras — チップ分割と基板配線の壁を、ウェハスケールで“物理的に”消す

- ② 設計主導権を壊す:Tenstorrent — RISC-V+モジュラーで用途別最適を“組み立てる”

- ③ 計算の前提を壊す:Etched(※Groqは2025年末にNVIDIAがアクイハイヤ+推論IP取得)— 汎用性を捨て、推論特化で低遅延・高効率を狙う

- 読むメリット:「学習/推論」「電力/遅延/開発コスト」などの制約から、どの勝ち筋が現実的かを判断できる。

- 【2026年初頭の展開】異端児が辿る3つの道:

- 吸収される道(Groq):王者に技術と人材を取り込まれ、その一部となる

- 主流に昇格する道(Cerebras):大型顧客を獲得し、ニッチから主流市場へ参入する

- 挑戦を続ける道(Tenstorrent / Etched):独立したプレイヤーとして技術と市場を磨き続ける

読者へのガイド(読み方ショートカット)

- CTO/技術選定:「0. 比較表」→「I. 技術の深層」各社の勝てる条件/導入コスト/最大リスクだけでもOK。

- 投資家:「0. 比較表」→「III. 王者の対抗策」→「結論」→「FAQ」を推奨。

- 一般読者:「II. 直感で理解する(比喩)」→「結論」→「FAQ」だけでも全体像が掴めます。

0. ひと目でわかる:異端児3派閥の比較(意思決定向け)

本稿のポイントは「誰が勝つか」を断定することではなく、“どんな条件の世界になったら、その技術が勝ち筋になるか”を掴むことです。

| 評価軸 | Cerebras(物理を壊す) | Tenstorrent(設計主導権を壊す) | Etched(計算前提を壊す) |

|---|---|---|---|

| 壊す前提 | チップ分割と基板配線(パッケージ/ボード) | 巨大モノリスGPUの中央集権(設計主導権の固定) | GPUの汎用性(Transformer推論に不要な汎用性) |

| 強み | データ移動をオンウェハに押し込み、チップ間由来の壁を物理で消す | RISC-V+モジュラー/チップレット前提で用途別最適を「組み立てる」 | Transformer処理フローをASICに焼き付け、低遅延・高効率を極限まで狙う |

| 強い用途 | 通信(データ移動)が支配する巨大モデルの学習/推論、大規模並列 | 用途が分裂するエッジ/組込み/独自SoC(自社で設計主権を握る場面) | LLM推論(特に低遅延・高スループットがSLAで要求される領域) |

| 最大リスク | 供給/運用(冷却・フォームファクタ)/適用範囲(万能ではない) | ツールチェーン成熟/採用事例/統合責任の増大(自社で背負う範囲が増える) | 柔軟性(モデル変化)/供給/エコシステム(Transformer依存が強い) |

| 現場の態度 | 「通信地獄」が見えた領域では検証価値が高い(本番採用の条件を満たすかPoCで見極め) | 自社製品設計を握る組織ほど選択肢になり得る(統合体制の有無が前提) | 推論SLAが厳しいならPoC価値大(Transformer心中を決める覚悟が必要) |

| 判定根拠 | 3派閥は「性能勝負」ではなく、(1)物理で配線の壁を消す、(2)設計主導権を分散化する、(3)ワークロード前提を固定して効率を極限化する――という “別ルール”で勝ちに行く。採用判断は「学習/推論」「遅延SLA」「電力制約」「統合責任(自社で背負えるか)」の制約条件から逆算するのが最も現実的。 |

||

(追補)最新動向(2026年2月時点)

✅ 異端児たちの運命が動いた — 2025年末〜2026年初頭の重大ニュース

- 【最重要】Cerebras:ウェハスケールCS-3と「Condor Galaxy」構想に加え、2026年1月にOpenAIと複数年の推論契約(総額100億ドル超規模と報道)を締結。OpenAIは最大750MWクラスの低遅延コンピュートを段階的に導入し、推論ワークロードの一部を本番採用していくと発表。

- Tenstorrent:日本のLSTC向けにRISC-V+チップレットIP協業が公表(公式/PR)。

- Etched:2026年1月に資金調達が報道され、推論特化ASICの独立プレイヤーとして存在感を維持(詳細は公式更新待ち)。

- NVIDIA:Rubinプラットフォーム(NVLink 6、Spectrum-X Photonics、BlueField-4等)をCES 2026で強く訴求。さらに2025年末のGroq関連ディールにより、推論特化IPと人材の取り込みも進んだ。

I. 技術の深層:エンジニア向け詳細解説

ここでは、各社が半導体設計の「どこ」を壊し(物理/設計主導権/計算前提)、どんな技術的ブレイクスルーでそれを成立させようとしているのかを、同じ評価軸で整理します。

評価軸(本稿のものさし)

- ボトルネックの定義:何が遅い/高いのか(計算か、データ移動か)

- 解決手段:物理・設計・ソフトのどれで殴るか

- 勝てるワークロード:学習/推論、バッチ、モデル形状

- 導入コスト:ソフト移植、運用、供給、統合責任

- 最大リスク:技術・市場・依存のどこが怖いか

(前提)王道の強さ:NVIDIAは何を握っているのか

異端児を理解する前に、王者が強い理由を短く確認します。NVIDIAの本質は「チップ単体の速さ」だけではありません。CUDAというソフトウェア資産、データセンター運用を含む統合プラットフォーム、そして供給能力とパートナー網によって、導入容易性と標準を握っています。

つまり異端児が勝つには、“速い”だけでなく、“導入と運用の現実”も越える必要があるという話になります。

1. 物理を壊す:「配線」の否定 — Cerebras Systemsとウェハスケール・インテグレーション

NVIDIAがNVLinkやスイッチで多数のGPUを束ね、「ラック」を最小単位に統合していくのに対し、Cerebrasの思想はさらに過激です。核心は、

NVIDIAがNVLinkやスイッチで多数のGPUを束ね、「ラック」を最小単位に統合していくのに対し、Cerebrasの思想はさらに過激です。核心は、

「チップ分割と基板配線(パッケージ/ボード)が、帯域・遅延・電力の支配的ボトルネックになる」

という問題設定にあります。

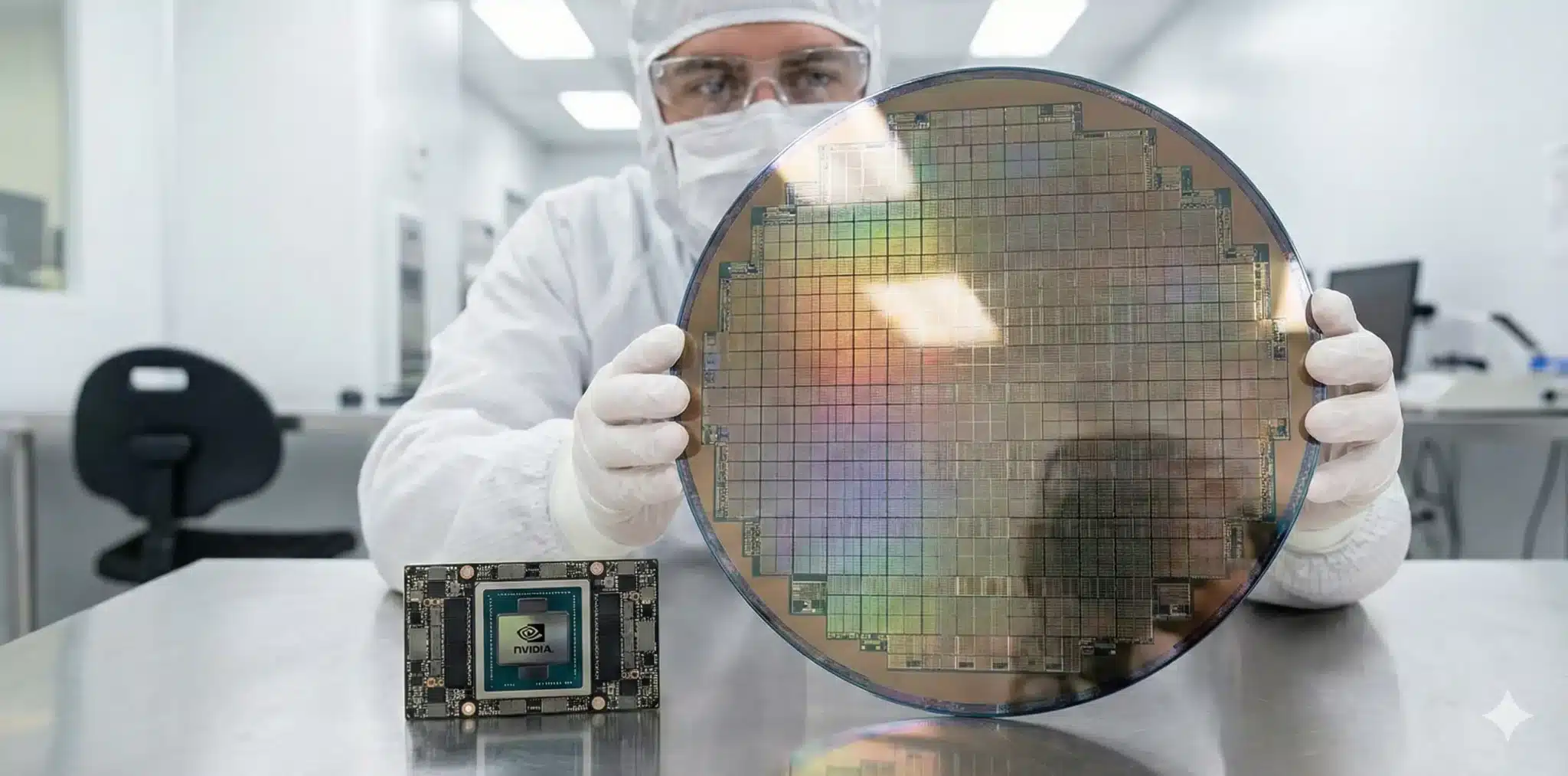

常識外れの「ウェハ丸ごと一枚」プロセッサ(WSE)

通常はウェハ上に多数のダイを作り、切り出してパッケージングし、基板上で再びつなぎます。Cerebrasはこの「切り出す」工程を否定し、ウェハを丸ごと一枚、巨大なプロセッサWafer-Scale Engine(WSE)として使います。

重要なのは、“通信が速い”というより、チップ間に出てしまうデータ移動そのものを、オンウェハに閉じ込める点です。

[Image placeholder: Cerebras WSE wafer comparison with standard GPU chip]

技術的挑戦とブレイクスルー

利点は、オンウェハのダイ間データ移動が基板配線ではなくシリコン上のインターコネクトで完結する点です。結果として、帯域と遅延のコストが“別物”になります。

一方で宿命は歩留まりです。ウェハ一枚を使う以上、欠陥を避けられません。Cerebrasは冗長性設計とソフトウェアで欠陥コアをバイパスし、製造・テスト・冷却の常識と正面衝突しながら成立させています。

勝てる条件:モデル巨大化が進み、チップ間/ノード間のデータ移動が支配的なコスト要因になった世界(巨大LLMの学習/推論の両方)。

実際にOpenAIは、この契約を通じてCerebrasのウェハスケール・システムを自社の高スループット・低遅延推論スタックの一部として組み込むと明言しており、ウェハスケールはPoC枠ではなく本番推論インフラとして位置づけられつつあります。

最大リスク:供給・運用・適用範囲(全ワークロードに万能ではない)。

今後は供給体制のスケールに加え、「OpenAIという単一の巨大重力」との距離感が焦点となります。100億ドル超の契約は、同時に“生殺与奪に近い依存”も生み得る。

Cerebrasが第二・第三の昇格パートナーを獲得していくのか、あるいはOpenAIの専属工房として純化するのか——ここが次の投資判断軸です。

2. 設計主導権を壊す:「中央集権」の否定 — Tenstorrentのモジュラー・アーキテクチャ

巨大で固定的なGPUを提供する中央集権モデルに対し、Tenstorrentが推進するのは、オープン命令セットRISC-Vと、チップレット前提の徹底したモジュラー設計です。狙いは単なる“速いチップ”ではなく、設計の主導権(自由度)をユーザー側に戻すことにあります。

「AIコンピュートの民主化」:完成品ではなく“部品”を配る

AIのワークロードは学習から推論、クラウドからエッジまで分裂しています。Tenstorrentは、AIコア、RISC-V CPU、メモリ/I/Oなどを、NoCで結ぶ“組み替え可能な部品”として捉えます。

つまり、NVIDIAが「完成された巨大な城」を提供するなら、Tenstorrentは「用途に合わせて組み替えられる高性能レゴ」を提供する思想です。

[Image placeholder: Tenstorrent modular chiplet architecture concept]

技術戦略の要点

ここで重要なのは、ボトルネックが「計算」だけでなく、統合(I/O、メモリ、ソフト、電力、コスト)に広がっている点です。モジュラー化は、用途別の最適を作れる反面、ツールチェーン、統合、検証の責任がユーザー側へ寄るというトレードオフが出ます。

勝てる条件:用途分裂が進み、専用SoC/エッジ最適が価値を持つ世界。

最大リスク:ツール成熟・採用事例・統合コスト(“自分でやる範囲”が増える)。

3. 計算の前提を壊す:「汎用性」の否定 — 推論特化ASICの挑戦と帰結

【2025年末の重大変化】Groqの帰結

Groqは2025年末の大型ディールを通じて、推論IPと中核人材の多くが王者側へ移り、「独立した対抗勢力」というより“取り込まれた異端”の象徴になりました。

以降、ここではGroqの技術を「NVIDIAに武器化された推論思想」として位置づけ、独立した推論特化ASICプレイヤーとしてはEtchedに焦点を当てます。

GPUの強みは汎用性です。しかし推論、とくにLLMの低遅延領域では、汎用性がムダとして表に出る場面があります。推論特化ASICは、汎用性を捨てることで、推論の“遅延の予測可能性”と“効率”を取りに行きます。

Groq(現:NVIDIAに統合):コンパイラが支配する「決定論的スケジューリング」

Groqの特徴は、ハードウェア側の複雑さを削ぎ落とし、データ移動と計算のタイミングをソフト(コンパイラ)が事前に“決め打ち”する発想です。

これにより、メモリアクセス競合などのジッター(予期せぬ遅延)を抑え、低遅延・予測可能性を武器にしました。

この“予見可能性”は、リアルタイム応答が求められるエージェント型AIの標準原器になり得るため、王者が欲しがった——と理解すると腑に落ちます。

Etched(独立継続):Transformer処理フローを“物理的に焼き付ける”

Etchedは一点突破です。Transformerの処理フローそのものを専用回路(ASIC)として固定化し、汎用チップでは到達しにくい効率を狙います。

ただし、モデル構造が大きく変わると賭けが外れます。ここは「世界がどれだけ長くTransformer中心で回るか」が運命を左右します。

勝てる条件:推論が支配し、SLAが厳しく、低遅延・予測可能性が価値になる世界。

最大リスク:柔軟性(モデル変化)・供給・エコシステム。加えて、NVIDIAが推論特化思想を統合したことで、推論特化領域でもNVIDIAとの直接競合が避けられなくなった。

II. 直感で理解する:アナロジーで掴む異端児たちの挑戦

ここからは比喩で理解します。NVIDIAを「王道の巨大デパート」に例えるなら、異端児たちは“別ルールの専門店”です。

1. Cerebras:都市そのものを一つの巨大な建物にする「究極の職住近接」

NVIDIAの発想は、高性能なビル(GPU)をたくさん建て、高速道路(NVLink)で結ぶ「都市づくり」です。移動は速いけれど、ビル間の移動はゼロにはなりません。

アナロジー:超巨大な平屋ワンフロア・オフィス

Cerebrasは「都市機能を仕切りのない超巨大な平屋に全部入れてしまう」発想です。部署(計算コア)と倉庫(メモリ)が同じフロアに並ぶので、外に出て道路を走る必要がない。

“通信が速い”というより、そもそも移動が外に出ないことが強みです。

2. Tenstorrent:完成品ではなく「高性能レゴブロック」を提供する

NVIDIAは完成されたスーパーカーを売るイメージです。誰でも速い。ただ「軽自動車で十分」な用途にはオーバースペックになりがちです。

アナロジー:用途別に組める高性能レゴ

Tenstorrentは「高性能なブロックの規格」を配る思想です。F1も軽自動車も、同じ規格で組み立てられる。

その代わり、組み立て(統合・検証)の責任は自分側に寄ります。

3. Etched:「何でも運べるトラック」を捨てた「専用レーシングカー」

GPUは砂利道からサーキットまで走れる“超高性能トラック”です。便利だけど、F1で勝つには荷台が重い。

アナロジー:特定コース専用のF1マシン

Etchedは「コース(Transformer)に合わせて車体を作り替えた」存在です。コースが変われば不利になりますが、そのコースでは最速を狙えます。

III. 王者の対抗策:NVIDIAは「データ移動」をどう潰しに来ているのか

異端児たちが狙うのは、突き詰めれば「データ移動の支配」です。では王者NVIDIAはどう対抗するのか。ポイントは“極端な共同最適化(codesign)”で、

チップ内・チップ間・ノード間・推論サービング

を同時に詰めに来ている点にあります。

1) スケールアップ:NVLink 6で「チップ間データ移動」を太くする

Rubin世代では、NVLink 6を核にしたラックスケール統合を強く打ち出し、GPUあたり数TB/sクラス、NVL72ラック全体で数百TB/sクラスのGPU間帯域といった指標を公式が提示しています(“チップ間(GPU-to-GPU)”のデータ移動を太くする発想)。

2) スケールアウト:Spectrum-X Photonics(CPO)で「ノード間データ移動」を詰める

大規模学習・大規模推論で支配的になりがちなノード間(集団通信)のコストに対し、NVIDIAはSpectrum-X Photonics(CPO:Co-Packaged Optics)など、“光”を前提にしたスケール設計を打ち出しています。

3) 推論“運用”の最適化:Dynamoで「推論の全体設計」を握る

Dynamoはひと言で言えば、推論サービング(配車)の司令塔です。どのモデルを、どのGPU/ノードに、どの順序で回し、どこで分割・並列化するかを“運用側”から最適化します。

推論ではGPUを速くするだけでは限界が出ます。NVIDIAはDynamoをオープンソースの推論ソフトウェアとして位置づけ、推論要求のオーケストレーションを含むAIファクトリーの生産性を上げる方向を明確にしています。

4) 異端児の「取り込み」:推論特化IPと人材をアクイハイヤする

NVIDIAの対抗策は、ハード・ネットワーク・ソフトの「面」だけではありません。推論特化のIPと人材まで取り込むことで、異端の武器を自らのAIファクトリーに組み込む戦略も取り始めています。

これは「競合を潰す」のではなく「競合を取り込む」王者の戦い方であり、異端児にとっては「勝つ」以外に「買われる」という出口が現実に存在することを意味します。

例:Groq関連のディールは、その象徴的なケースとして読めます。

結論:多様なる「異端」が切り拓く未来

NVIDIAが築くRubinという「王道の物理帝国」は強大で、当面の間、AIインフラの中心であり続けるでしょう。ですが、テクノロジーの歴史を振り返れば、「常識」は常に異端の挑戦によって更新されてきました。

NVIDIAが築くRubinという「王道の物理帝国」は強大で、当面の間、AIインフラの中心であり続けるでしょう。ですが、テクノロジーの歴史を振り返れば、「常識」は常に異端の挑戦によって更新されてきました。

もし、モデル巨大化が進み、チップ間/ノード間のデータ移動が支配的な限界に達すれば、Cerebrasのウェハスケールが最有力解になり得ます。実際に、OpenAIが100億ドル超規模と報じられる複数年契約でCerebrasを本番推論インフラとして採用し始めたことは、その未来が机上の空論ではなく、一部で現実化しつつあることを示しています。

もし、AIの利用シーンが爆発的に分裂し、用途別の最適が価値を持てば、Tenstorrentのモジュラー思想が効いてきます。

そして、推論が支配し続け、低遅延と予測可能性が勝敗を決めるなら、Etchedのような推論特化ASICが経済合理性で存在感を増すでしょう。

2025年末〜2026年初頭の展開は、異端児がたどる3つの道を示しました:

- 吸収される道(Groq):王者に技術と人材を取り込まれ、その一部となる

- 主流に昇格する道(Cerebras):大型顧客を獲得し、ニッチから主流市場へ参入する

- 挑戦を続ける道(Tenstorrent / Etched):独立したプレイヤーとして技術と市場を磨き続ける

未来は「単一の王道」では決まりません。Rubinに象徴される王道の進化と、Cerebras・Tenstorrent・Etchedといった異端の突進が衝突し、あるいは融合する中で、多様な解が生まれます。エンジニアや技術選定者、投資家は、王道の強さを理解しつつも、“別ルールで勝ちに行く動き”と、その出口戦略の多様性から目を離してはなりません。

FAQ:よくある質問

Q1. この記事でいう「通信」とはネットワークのことですか?

いいえ。ネットワークだけではなく、HBM↔演算器(メモリアクセス)、NoC(チップ内)、インターコネクト(チップ間)、All-Reduce等(ノード間)を含む広義のデータ移動を指します。

Q2. なぜAIは「計算」より「データ移動」が効くのですか?

モデルが大きくなるほど、重みや中間表現の読み出し・転送が増え、「1回のデータ転送あたりにどれだけ計算できるか(算術強度)」が下がりやすくなります。

算術強度(Arithmetic Intensity)は

![]()

ここで $W$ は演算量(FLOPs)、$Q$ はデータ移動量(Bytes)です。モデル巨大化で $Q$ が増えると $I$ が下がり、演算器が速くても「データ待ち」に支配されやすくなります。結果として、コスト(電力・時間)が支配的になりやすいのです。

Q3. CerebrasはGPUを完全に置き換えますか?

“万能の置き換え”というより、データ移動が支配的になる領域で強い選択肢です。適用範囲、供給、運用などの現実条件とセットで判断するのが安全です。

Q4. 推論特化ASICはモデルが変わったら終わりですか?

特化が強いほど、そのリスクは増えます。その代わり、モデル構造が安定している期間は、低遅延・高効率で価値を出し得ます。どこまで“変化への保険”を捨てられるかが判断軸です。

Q5. 結局、現場は何から始めるべきですか?

まずは“制約”から逆算してください。低遅延推論なら推論特化のPoC、並列が限界ならチップ間/ノード間のデータ移動を測定、用途分裂ならモジュラー設計の検討、という順が現実的です。

参考サイト / 出典

本文執筆にあたり参照した一次・準一次情報(公式発表、技術ブログ、主要報道)を列挙します。

- NVIDIA Rubin(公式発表):

NVIDIA Newsroom(Rubin Platform / 2026-01-05) /

NVIDIA公式(Rubin Platform) /

NVIDIA Developer Blog(Rubin解説) - NVIDIA Spectrum-X Photonics / CPO(技術解説):

Scaling AI Factories with Co-Packaged Optics(2025-08-18) - NVIDIA Dynamo(公式発表):

NVIDIA Newsroom(Dynamo / 2025-03-18) /

NVIDIA公式ブログ(日本語) - OpenAI × Cerebras(推論契約):

OpenAI公式(Cerebras Partnership / 2026-01-14) /

Cerebras公式(High-Speed Inference / 2026-01-14) - Cerebras(Condor Galaxy / 公式):

Condor Galaxy(Cerebras公式) /

WSE-3発表(Cerebras公式) - Tenstorrent(日本向け協業 / 公式):

Tenstorrent公式(Japan / LSTC / 2024-02-27) /

PRNewswire - Etched(動向:報道ベース):

DataCenterDynamics(2026-01-19)

※公式の更新が出たら差し替え推奨。

合わせて読みたい

本稿の理解を「インフラ設計(ネットワーク)→ 世代交代(Rubin)→ 勢力図(投資・戦略)」の順に深められる内部リンクを厳選しました。

- Vera Rubinとは?「AI劇場」を止めない次世代AIデータセンター完全ガイド

Rubinの“どこが本質的に変わるのか”を、ネットワーク主役の視点で整理。 - AIネットワーク三層|NVLink・InfiniBand・Ethernet/Spectrum-X(仕組み)

「通信=データ移動」を腹落ちさせる本編。ラック内〜ノード間まで一気に俯瞰。 - NVLink vs Broadcom論争の真相|AIネットワークの力学を読み解く

“AIネットワーク覇権”をめぐる産業力学(NVIDIA/Broadcom/Marvell等)を入門的に把握。 - 初学者用LLM技術:NVLinkを理解するために【2025】

学習/推論、並列化、NVLink/NVSwitchの役割を“物語”で掴む導入編。 - NVIDIA NVLink Fusion発表|AIチップ市場の新展開

チップだけでなく「接続(インターコネクト)」が競争軸になる理由が見える。 - AIが金を掘る時代へ:NVIDIA GTC 2025が示したトークン採掘の未来

推論中心の時代(AIファクトリー/トークン経済)を、インフラ視点で整理。 - AIインフラ戦争2025|NVIDIA×OpenAI・45兆円契約の全貌

インフラは“性能”だけでなく“資本と同盟”で動く——政治・経済戦の全体像。 - AIインフラ市場2025最新|NVIDIA独占に挑む各社戦略

AWS/Google/AMDなども含めた、より広い競争地図と勝ち筋の整理。 - AIチップ覇権戦争2025: NVIDIAの銀河系戦略に挑む反逆者たち

“反逆者”の系譜を掴む比較記事。今回の「異端児の運命」理解がさらに深まる。 - 2026年AIハードウェア展望|NVIDIA Rubinと競合5戦略

Rubin以降の勢力図を、投資・供給・用途(学習/推論)まで含めて俯瞰。

変更履歴

- 2026年2月3日: 初稿公開。

以上