「AIファクトリーの神経と交通網」──エバとレオが辿ったネットワークの地図

この記事を読むとAIデータセンターネットワークの複雑な力学が構造的にわかり、技術ニュースの裏側を正しく読み解くことができるようになります。

AIデータセンターのネットワークとは?基礎から理解

要約:カフェでの何気ない会話から、二人はAIデータセンターのネットワークを巡る複雑な力学の地図を描き始めます。

要約:カフェでの何気ない会話から、二人はAIデータセンターのネットワークを巡る複雑な力学の地図を描き始めます。

カフェの窓際。夕方のやわらかな光がテーブルの縁に落ちる。エバはノートPCを閉じ、レオは手帳を開いた。

「今日のテーマは『AI半導体ネットワーク』にしようか」とエバが切り出す。「2025年現在、102.4Tbpsを謳うBroadcomのTomahawk 6や、NVIDIAのBlackwell世代GPUといった最新技術が切り拓くAIデータセンターの新時代を、一度ストーリーで紐解いてみたいんだ」

「いいね。特に最近、“ブロードコムがNVIDIAを抜いた”っていう話、ちらほら見かけるし」とレオ。

「あったね。Broadcomの決算後のカンファレンスコールでのHock E. Tan(ホック・タン)CEOの発言が火種だったとか」

エバは肩をすくめる。「いくつかの技術解説やレポートを参考にしつつ、今日は“何が起きているのか”を一度すっきり整理したい。数字の断片じゃなくて、構造で理解したいんだ」

物語はここから、二人の問いと答えを軸に、AIデータセンターの内部地図を描き始める。

誤解の入口─28.8Tbpsという“玄関口”

要約:発端となった「28.8Tbps」という数字は、ラック内部の性能ではなく外部接続の帯域を指すもので、単位の混同も誤解を招きました。

要約:発端となった「28.8Tbps」という数字は、ラック内部の性能ではなく外部接続の帯域を指すもので、単位の混同も誤解を招きました。

噂の起点はブロードコムのカンファレンスコールで口にされた一節だった。「AIラックはNVLinkで72個のGPUをつないでいるが、外部との接続は28.8Tbps(テラビット毎秒)に過ぎない」──このフレーズだけが独り歩きした。

👨🏫 AI専門家が解説:かみ砕きポイント

Hock E. Tan CEOの実際の発言は「28.8 terabit-per-second」です。これはバイトに換算すると約3.6TB/sとなり、テラビット(Tb)とテラバイト(TB)という単位の混同が誤解の一因となりました。

レオが眉を寄せる。「それ、NVLink全体の性能って意味に聞こえちゃうよね?」

エバは首を横に振る。「違う。あれは“ラックが外部とやり取りする玄関口の速度”。本丸はラックの内部だよ。72個のGPU同士がNVLinkで直接つながって、内部では130TB/s──バイト換算なら外部の約36倍──という桁違いの規模でデータが飛び交っている。玄関の幅だけ見て“家全体が狭い”って決めつけるのと同じだ」

誤解の正体は、どの帯域の話をしているのかという“座標”の欠落だった。

ネットワークの役割の違い──NVLinkの“神経系”とBroadcomの“交通整理”

要約:NVIDIAのNVLinkがラック内のGPU間を繋ぐ「神経系」なら、BroadcomのスイッチASICはラック間のデータを捌く「交通整理」の役割を担います。

レオが尋ねる。「じゃあブロードコムは何を誇示していたの?」

エバは紙に図を描いた。「彼らの見せ場はラックの外。データセンター全体のネットワーク階層を、最新のEthernetスイッチASIC──例えばTomahawk(トマホーク) 6──で減らして、経由スイッチ数を抑える。経由が減ればレイテンシーも電力も削れる。言うなれば、NVLinkはラック内GPU間の“神経系”、Broadcomはラックの外の“交通整理”を最適化している」

👨🏫 AI専門家が解説:かみ砕きポイント

BroadcomのTomahawk 6は、2025年6月に出荷が開始された102.4Tbpsの業界最高速クラスのEthernetスイッチASICです。これにより、データセンター内のスイッチ階層を減らし、効率化を図ることが可能になります。

同じ“帯域”という言葉でも、見ている“場所”が違う。数字だけを並べて「どっちが勝った負けた」と断じるのは、地図を見ずに方角を議論するようなものだ。

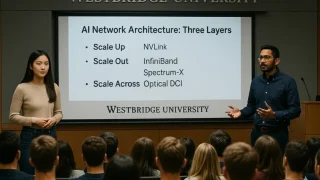

NVIDIAが描くネットワーク3段階の拡張──Scale Up / Out / Acrossとは?

要約:NVIDIAは、ラック内(Up)、ラック間(Out)、DC間(Across)という三段階の拡張戦略で、AIファクトリーの全体最適化を進めています。

要約:NVIDIAは、ラック内(Up)、ラック間(Out)、DC間(Across)という三段階の拡張戦略で、AIファクトリーの全体最適化を進めています。

レオがメモを取り始める。「NVIDIAはインフラ拡大を三段階で語るって聞いた」

エバは指を三本立てた。

第一段階:Scale Up(スケールアップ)

Blackwell世代では、第5世代NVLinkとNVSwitchにより、72GPU構成のNVL72内で最大576-wayのGPU間通信パターンをサポートし、大規模モデルの学習効率を飛躍的に高める。学習でボトルネックになりやすいGPU間通信を“ラック内で解決”する発想だね。

第二段階:Scale Out(スケールアウト)

強力化したラックを多数つないでクラスター化する。推奨は低遅延のInfiniBand(インフィニバンド)。ただし、Ethernetで積み上げてきた環境には、EthernetでIBに迫る体験を目指すSpectrum-Xも用意されている。既存資産に寄り添う“選択肢”だ。

第三段階:Scale Across(スケールアクロス)

データセンター(DC)の壁を越える。都市や国境を跨ぐ複数DCを一つのAIファクトリーのように連携させる構想で、Spectrum-XGS Ethernetで広域連携を狙う。ここまで来ると、ハード・ネットワーク・制御ソフトの総合芸術になる。

👨🏫 AI専門家が解説:かみ砕きポイント

Spectrum-XGS Ethernetは、2025年8月にNVIDIAが発表した、ギガスケールAIファクトリー向けの広域連携技術です。これにより、地理的に分散したデータセンターを一つに統合し、巨大なAI計算リソースとして活用することを目指します。

“全部入り最適化”という武器──ハードからソフトまで

要約:NVIDIAの強みはGPUだけでなく、NVLinkからCUDAまでハードとソフトを一体で最適化し、アプリケーションの総合性能を最大化する点にあります。

レオが感嘆する。「NVIDIAってGPUだけじゃないんだね」

エバが頷く。「NVLink、NIC、オフロード用のDPU、データプレーンを束ねるスイッチ……そしてそれらを高効率に動かすNCCL(GPU間通信ライブラリ)やCUDA。

ハードとソフトを一体で最適化して、アプリケーションの実効性能──スループット、通信の遅延時間を示すレイテンシー、信号の揺らぎ現象であるジッター──を磨き込む。結局のところ現場で効くのは、仕様値より総合性能なんだ」

ネットワークの見るべき“現実の指標”──数字の裏側

要約:ニュースの派手な数字に惑わされず、NCCL効率やレイテンシー、実績といった運用現場での実効性能を示す指標を見ることが重要です。

レオが枠線を引く。「現場としては、どんな指標を見ればいいの?」

エバは指を折って挙げる。

- NCCL効率:GPU間通信の実効効率

- レイテンシー/ジッター:遅延の小ささと揺らぎの少なさ

- 輻輳耐性:大流量時の詰まりにくさ

- 階層削減の実利:スイッチ段数削減がどれだけ遅延/電力を下げたか

- 実績と信頼性:どの技術が大規模導入されているかという事実

「派手な数字より、運用ログが語る現実だよ」とエバ。

三層構造とプレイヤー配置──NVIDIA/Broadcom/Marvellはどこで強いのか

要約:ラック内はNVIDIA、ラック間はNVIDIAとBroadcomが競合し、DC間はBroadcomとMarvellが強みを発揮するなど、層ごとに主要プレイヤーは異なります。

要約:ラック内はNVIDIA、ラック間はNVIDIAとBroadcomが競合し、DC間はBroadcomとMarvellが強みを発揮するなど、層ごとに主要プレイヤーは異なります。

エバはホワイトボードに三層の階段を描く。

Scale Up(ラック内)

中心はNVLink。対抗としてオープン規格のUALink(ユーエーリンク)がある。AMDやIntelなどが主導しているね。

👨🏫 AI専門家が解説:かみ砕きポイント

UALink 200G 1.0規格は2025年4月に正式化。Marvell(マーベル)は同年6月11日にコンソーシアムへの参加と対応IPを発表しており、オープンな規格の普及に向けた動きが加速しています。

Scale Out(ラック間)

NVIDIAはInfiniBandやSpectrum-Xで存在感。ただし、EthernetスイッチのASICではBroadcomのTomahawkが非常に強い。MarvellもASICを投入し、健闘。

Scale Across(DC間)

BroadcomのJericho(ジェリコ)4や、Marvellの光インターコネクトが要。NVIDIAもSpectrum系で攻めるが、広域・長距離では光技術の巧拙が効く。

👨🏫 AI専門家が解説:かみ砕きポイント

Jericho4はHBMを搭載し、約60マイル(約96km)級のDC間接続や分散AIクラスターを想定したルータASICです。

ここでエバはビジネスモデルの違いを添える。「BroadcomやMarvellは“チップ屋”。ASICはCisco(シスコ)やArista(アリスタ)といった“箱物ベンダー”に組み込まれて世に出る。一方でNVIDIAは“チップ屋”でもあり“箱物屋”でもある**。GB200のようにAIラックそのものを製品として出してくる。ここが立ち位置に大きく影響する」

まとめ

カフェでのエバとレオの対話を通じて、AIデータセンターネットワークを巡る複雑な力学が、一枚の地図のように明らかになりました。

「BroadcomがNVIDIAを越えたか?」という単純な問いは、「誰が、どの領域(内・中・外)で、どのような役割を果たしているのか」という、より構造的な理解へと変わります。

NVIDIAの垂直統合戦略、Broadcomの水平分業戦略、そしてMarvellのキーテクノロジー。それぞれの強みが絡み合い、AIファクトリーという巨大なインフラが形成されていくのです。ニュースの断片的な数字に惑わされず、その裏側にある構造と力学を読み解くことこそ、この急速に進化する時代を理解する鍵となるでしょう。

専門用語まとめ

- NVLink

- NVIDIAが開発したGPU間を高速で直接接続するインターコネクト技術。AIモデルの学習でボトルネックとなりがちなGPU間の通信を高速化し、ラック全体を単一の巨大なプロセッサのように動作させる「スケールアップ」の中核を担います。

- Tomahawk (トマホーク)

- Broadcomが開発する業界最高速クラスのEthernetスイッチASIC。データセンター内の大量のトラフィックを効率的に処理し、スイッチの階層を削減することで、遅延(レイテンシー)と消費電力の削減に貢献します。「スケールアウト」における重要技術です。

- Jericho (ジェリコ)

- Broadcomが開発するルータASIC。データセンター間(DCI)などの長距離・広帯域な通信を担う「スケールアクロス」領域で強みを発揮します。最新のJericho4はHBMを搭載し、分散AIクラスターの構築を支えます。

- Scale-Across (スケールアクロス)

- NVIDIAが提唱する拡張戦略の第三段階。地理的に離れた複数のデータセンターを高速ネットワークで接続し、あたかも単一の巨大な「AIファクトリー」として連携させる構想です。Spectrum-XGS Ethernetがこの中核技術となります。

- UALink (ユーエーリンク)

- AMD、Intel、Googleなどが主導し、Marvellも参加するオープンなアクセラレータ接続規格。NVIDIAのNVLinkに対抗し、異なるベンダーのプロセッサを高速に接続することを目指す「スケールアップ」の選択肢です。

よくある質問(FAQ)

Q1. NVLinkとEthernetの役割はどう違うのですか?

A1. NVLinkは、一つのAIラック内部でGPU同士を超高速・低遅延で接続する「神経系」の役割を担います。一方、Ethernetは、AIラック間やデータセンター全体を接続する「交通網」の役割を果たします。それぞれ得意な領域が異なり、補完し合う関係にあります。

Q2. GPUとASIC/XPUは今後どうなりますか?

A2. 競合ではなく「役割分担」が進むと考えられます。GPUは様々なタスクに対応できる「汎用性」が強みであり、ASIC/XPUは特定の処理に特化した「専門性」で高い電力効率を発揮します。両者を適材適所で組み合わせることで、AIファクトリー全体の性能が向上します。

Q3. なぜ電力と冷却が次のボトルネックになるのですか?

A3. AIチップの性能向上に伴い、消費電力と発熱量が爆発的に増加しているためです。データセンターが設置できるサーバーの数は、計算性能よりも電力供給能力や冷却能力によって上限が決まる時代になっています。今後は「電力あたり性能」が重要な指標となります。

主な参考サイト

- NVIDIA Newsroom

- Broadcom News

- Marvell Newsroom

- UALink Consortium Official Website

- ServeTheHome (STH)

合わせて読みたい

- AIが金を掘る時代へ:NVIDIA GTC 2025が示したトークン採掘の未来(入門)

- IOWNとは何か? なぜ今必要とされるのか【NTTの次世代構想】(実装)

- Oracle Cloud AI戦略:タイタンの賭けと「Stargate」が拓くAIキングメーカーへの道(最新動向)

- GTC 2025でも注目!NVIDIAが量子コンピューティングで描く未来

- 【2025最新】Palantir AIPとオントロジー完全ガイド Snowflake/Databricks連携と国内事例

更新履歴

- 初版公開